سیستمهای هوش مصنوعی معاصر به فرآیند اساسی وابسته هستند که زبان انسانی را به فرمتهای قابل خواندن توسط ماشین تبدیل میکند. این فرآیند—توکنسازی هوش مصنوعی—تعیین میکند که مدلهای زبانی چقدر مؤثر زمینه را درک کنند، اطلاعات را پردازش کنند، و پاسخها تولید کنند. با افزایش استقرار سیستمهای هوش مصنوعی توسط سازمانها برای ادغام داده، تولید محتوا، و هوش تجاری، درک توکنسازی برای بهینهسازی عملکرد، کنترل هزینهها، و اطمینان از نتایج قابل اعتماد حیاتی میشود. توکنسازی به عنوان پلی بین ارتباط انسانی و درک ماشین عمل میکند، با این حال بسیاری از متخصصان داده اهمیت استراتژیک آن را دستکم میگیرند. انتخابهای ضعیف توکنسازی میتواند هزینههای پردازش را افزایش دهد، آسیبپذیریهای امنیتی ایجاد کند، و گلوگاههای عملکردی بسازد که اثربخشی سیستم هوش مصنوعی را محدود میکند. با تسلط بر اصول توکنسازی و تکنیکهای نوظهور، میتوانید بهبودهای قابل توجهی در عملکرد سیستم هوش مصنوعی باز کنید در حالی که از تلههای پیادهسازی رایج اجتناب میکنید.

توکنسازی در هوش مصنوعی چیست و چگونه کار میکند؟

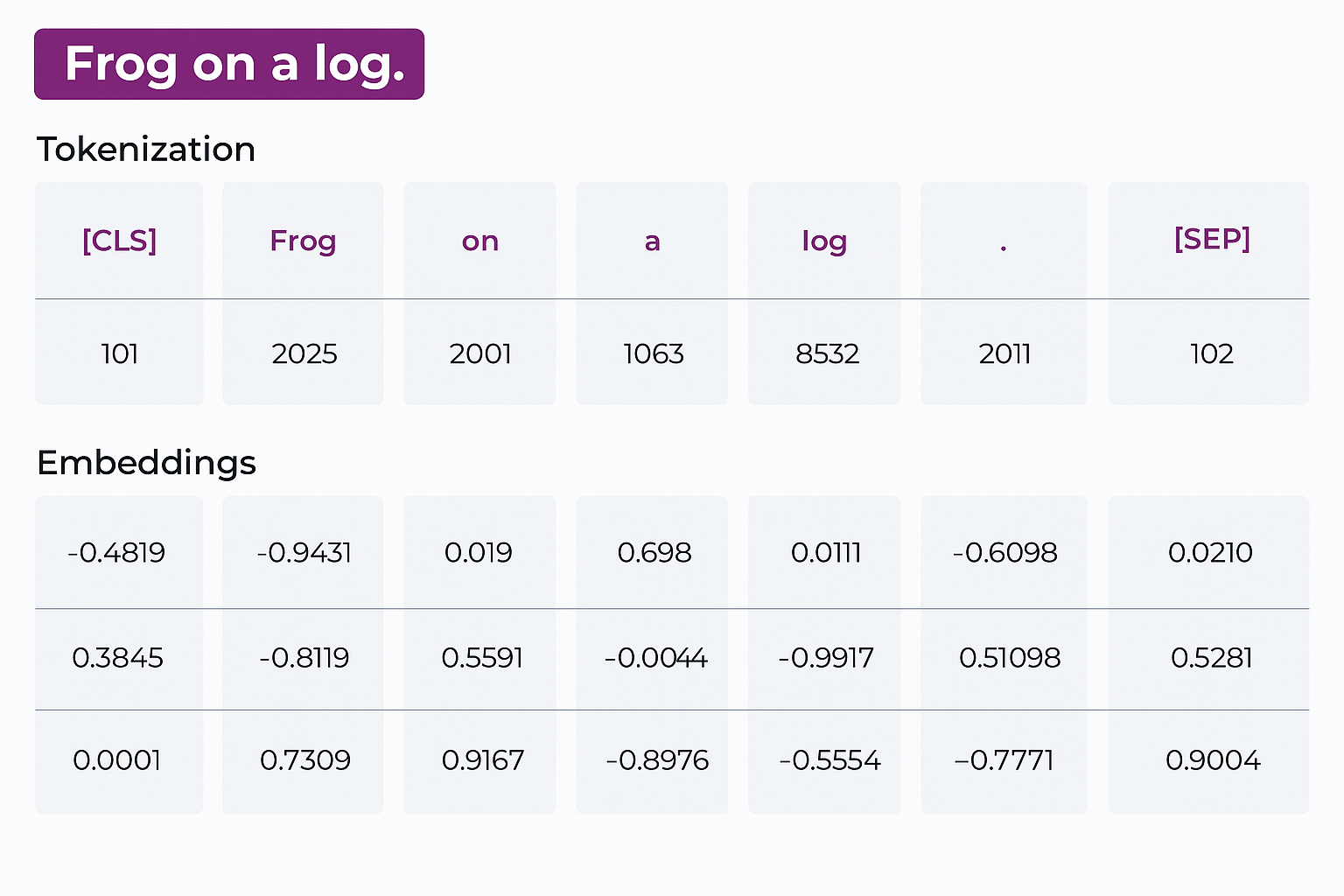

قبل از غوطهور شدن در توکنسازی در هوش مصنوعی، درک مفهوم توکنها حیاتی است. توکنهای هوش مصنوعی بلوکهای ساختمانی سیستمهای هوش مصنوعی هستند که به مدلهای زبانی، چتباتها، و دستیاران مجازی کمک میکنند متن را تولید و درک کنند. هر توکن یک واحد کوچکتر و امن است که کلمات، زیرکلمات، اعداد، کاراکترها، یا علائم نگارشی درون جملات را نمایان میکند. توکنها همیشه دقیقاً جایی که کلمات آغاز یا پایان مییابند تقسیم نمیشوند؛ ممکن است شامل فضاهای دنبالهدار یا حتی بخشهایی از کلمات باشند. طبق OpenAI، یک توکن معمولاً شامل چهار کاراکتر است، یا تقریباً ¾ یک کلمه در انگلیسی. بنابراین، ۱۰۰ توکن تقریباً معادل حدود ۷۵ کلمه است، هرچند این میتواند بسته به زبان و پیچیدگی متن متفاوت باشد. فراتر از متن، توکنها در دامنههای دیگر نیز اعمال میشوند. در بینایی کامپیوتری، یک توکن میتواند یک بخش تصویر باشد، در حالی که در پردازش صوتی ممکن است یک قطعه صدا باشد. این تطبیقپذیری اجازه میدهد هوش مصنوعی دادههای فرمتهای مختلف را تفسیر و از آنها یاد بگیرد. حال که معنای توکنهای هوش مصنوعی را به طور واضح درک کردهاید، بیایید با توکنسازی هوش مصنوعی آغاز کنیم. توکنسازی فرآیند تقسیم متن به توکنها است. قبل از توکنسازی، نیاز به نرمالسازی متن برای استانداردسازی آن به فرمت سازگار با استفاده از ابزارهای پردازش زبان طبیعی دارید. پس از پیشپردازش، متن را توکنسازی میکنید و همه توکنهای منحصربهفرد را به لیست واژگان با شاخص عددی اضافه میکنید. پس از توکنسازی، باید جاسازیها ایجاد کنید—نمایندگیهای برداری عددی توکنها. هر بردار به ضبط معنای معنایی توکن و روابط آن با توکنهای دیگر کمک میکند.

در تصویر بالا میتوانید دو توکن ویژه ببینید:

- CLS – یک توکن طبقهبندی که در ابتدای توالی ورودی اضافه میشود.

- SEP – یک توکن جداکننده که به مدل کمک میکند مرزهای بخشهای مختلف متن ورودی را درک کند.

هدف نهایی توکنسازی ایجاد واژگانی با توکنهایی است که بیشترین حس را برای مدل هوش مصنوعی دارد. برای کاوش بیشتر توکنسازی، میتوانید از ابزار توکنایزر OpenAI استفاده کنید.

انواع روشهای توکنسازی

- توکنسازی مبتنی بر فضا متن را به کلمات بر اساس فضاها تقسیم میکند—برای مثال، “I am cool” → [“I”, “am”, “cool”].

- توکنسازی مبتنی بر دیکشنری متن را به توکنها طبق دیکشنری از پیش تعریفشده تقسیم میکند. مثلاً، “Llama is an AI model” → [“Llama”, “is”, “an”, “AI”, “model”].

- توکنسازی Byte-Pair Encoding (BPE) یک توکنسازی زیرکلمه که متن ورودی را بر اساس جفتهای بایت تقسیم میکند، رایج برای زبانهایی مانند چینی. مثال: Llama是一款AI工具 → [“Ll”, “ama”, “是”, “一”, “款”, “AI”, “工”, “具”].

چگونه میتوانید از دادههای توکنسازیشده و جاسازیشده در مدلسازی هوش مصنوعی استفاده کنید؟

برای دادن معنای به توکنهای هوش مصنوعی، یک الگوریتم یادگیری عمیق یا یادگیری ماشین بر روی این دادههای توکنسازیشده و جاسازیشده آموزش داده میشود. پس از آموزش مدل، سیستمهای هوش مصنوعی یاد میگیرند توکن بعدی در توالی را پیشبینی کنند یا متن شبیه به انسانی مرتبط با زمینه تولید کنند. از طریق یادگیری تکراری و تنظیم دقیق، عملکرد مدلهای هوش مصنوعی میتواند با گذشت زمان بهبود یابد.

توکنسازی هوش مصنوعی در طول زمان چگونه تکامل یافته است؟

در مراحل اولیه، توکنسازی راه اساسی برای تجزیه متن در زبانشناسی و برنامهنویسی بود. با تکامل سیستمهای دیجیتال، برای امن کردن دادههای حساس مانند شمارههای تأمین اجتماعی، شمارههای کارت اعتباری، و دیگر اطلاعات شخصی ضروری شد. توکنسازی دادههای محرمانه را به توکن تصادفی تبدیل میکند که اگر دزدیده شود بیفایده است و تنها توسط موجودیت مجاز میتواند به جزئیات اصلی نگاشت شود.

با ظهور هوش مصنوعی، توکنسازی حتی حیاتیتر شد، به ویژه در وظایف پردازش زبان طبیعی و یادگیری ماشین. ابتدا، توکنسازی در هوش مصنوعی یک وظیفه پیشپردازش ساده تقسیم متن به کلمات بود، که مدلهای اولیه را قادر میساخت زبان را سریع پردازش و تحلیل کنند. با هوشمندتر شدن مدلهای هوش مصنوعی، توکنسازی شروع به تقسیم متن به زیرکلمات یا حتی کاراکترهای فردی کرد. توکنسازی معاصر بر تکنیکهای تقسیم زیرکلمه تأسیسشده بنا شده که چالشهای محدودیت واژگان در پردازش زبان عصبی را غلبه میکند. Byte-Pair Encoding (BPE) در معماریهای ترانسفورمر از طریق ادغام تکراری جفتهای کاراکتر بر اساس آمار فرکانس غالب باقی مانده است.

WordPiece از ادغام مبتنی بر احتمال برای بهینهسازی فشردگی واژگان استفاده میکند، در حالی که SentencePiece توکنسازی مستقل از زبان را با ورودیها به عنوان جریانهای خام امکانپذیر میسازد. مدلسازی زبان Unigram برای حفظ مورفولوژیکی برتر نسبت به BPE، به ویژه برای کلمات پیچیده و زبانهای غیرانگلیسی، برجسته شده است.

پیشرفتهای اخیر معماریهای توکنسازی تطبیقی معرفی کردهاند که توکنها را بر اساس پیچیدگی محتوا به طور پویا تخصیص میدهند. ادغام توکن سلسلهمراتبی پویا مدلها را قادر میسازد طول توالی را از طریق خوشهبندی توکن آگاه از فضا کاهش دهند، در حالی که سیستمهای تنظیم مرز زمینهای تغییرات زمان اجرا بر اساس روابط معنایی را امکانپذیر میسازند.

این نوآوریها چالش اساسی تعادل کارایی محاسباتی با حفظ معنایی را برطرف میکنند. ظهور توکنسازی چندوجهی تکامل قابل توجه دیگری را نمایان میکند. فضاهای جاسازی مشترک اکنون پردازش بینوجهی را از طریق خطوط لوله توکنسازی یکپارچه امکانپذیر میسازند، و سیستمهای هوش مصنوعی را قادر میسازند تصاویر، صوت، و متن را از طریق توالیهای توکن مشترک پردازش کنند. این تغییر معماری مدلهای زبان منجمد را قادر میسازد ورودیهای چندوجهی را بدون نیاز به خطوط لوله پردازش جداگانه برای هر نوع داده مدیریت کنند. چنین رویکردهایی مدلهای زبان بزرگ مانند GPT-4 را قادر میسازند و پیچیدگیهای زبان را ضبط کنند، و آنها را قادر میسازند پاسخهای بهتر درک و تولید کنند. این تکامل مدلهای هوش مصنوعی را دقیقتر در پیشبینیها، ترجمهها، خلاصهها، و ایجاد متن در چندین کاربرد—از چتباتها تا ایجاد محتوای خودکار—میکند.

چرا توکنها در سیستمهای هوش مصنوعی مهم هستند؟

دو عامل کلیدی برجسته میکنند چرا توکنها اهمیت دارند:

۱. محدودیتهای توکن

هر مدل زبان بزرگ حداکثر تعداد توکنی دارد که میتواند در یک ورودی پردازش کند. این محدودیتها از چند هزار توکن برای مدلهای کوچکتر تا دهها هزار برای مدلهای تجاری بزرگتر متغیر است. превыش این محدودیت میتواند باعث خطاها، سردرگمی، و پاسخهای کیفیت پایین از هوش مصنوعی شود.

۲. هزینه

ارائهدهندگان مانند OpenAI، Anthropic، Microsoft، و Alphabet معمولاً به ازای هر ۱٬۰۰۰ توکن هزینه دریافت میکنند. هرچه توکنهای بیشتری استفاده کنید، هزینه تولید پاسخها بالاتر میرود.

فراتر از این ملاحظات عملی، انتخابهای توکنسازی مستقیماً بر عملکرد و قابلیتهای مدل تأثیر میگذارد. توکنسازی ضعیف میتواند fragmentation معنایی ایجاد کند جایی که اصطلاحات خاص دامنه به بخشهای بیمعنی تقسیم میشوند. اصطلاحات مراقبتهای بهداشتی مانند “preauthorization” ممکن است به توکنهای جداگانه تقسیم شود، و درک زمینه بالینی را مختل کند. این fragmentation به ویژه زبانهای غنی مورفولوژیکی را تحت تأثیر قرار میدهد، جایی که توکنایزرها ممکن است variants کلمه را به عنوان توکنهای نامرتبط对待 کنند علیرغم ارتباطات معنایی آنها. ملاحظات امنیت توکن نیز نقش حیاتی در استقرارهای هوش مصنوعی سازمانی ایفا میکنند. حملات توکنسازی مقابلهای میتوانند از توکنسازیهای غیرکانونی برای دور زدن فیلترهای ایمنی سوءاستفاده کنند، در حالی که sanitization ورودی ناکافی میتواند منجر به نشت توکن شود جایی که دادههای حساس در خروجیهای مدل ظاهر میشود. سازمانها باید safeguards توکنسازی مناسب پیادهسازی کنند تا از آسیبپذیریهای امنیتی جلوگیری کنند در حالی که عملکرد سیستم را حفظ میکنند. کارایی انرژی عامل حیاتی دیگری است، زیرا انتخابهای توکنسازی مستقیماً هزینههای محاسباتی را تحت تأثیر قرار میدهند. پردازش زمینههای طولانیتر scaling مربعی در مکانیسمهای توجه ایجاد میکند، و مصرف انرژی را به طور قابل توجهی افزایش میدهد. بهینهسازی توکنسازی استراتژیک میتواند هزینههای پردازش را کاهش دهد در حالی که کیفیت خروجی را حفظ میکند، و آن را برای عملیات هوش مصنوعی پایدار ضروری میسازد. نکات برای مدیریت مؤثر توکنها:

- پرامپتها را مختصر و متمرکز بر یک موضوع یا سوال نگه دارید.

- مکالمات طولانی را به کوتاهترها تقسیم کنید و بلوکهای بزرگ متن را خلاصه کنید.

- از ابزار توکنایزر برای شمارش توکنها و تخمین هزینهها استفاده کنید.

- برای درخواستهای پیچیده، رویکرد گامبهگام را به جای شامل کردن همه چیز در یک پرسش در نظر بگیرید.

بهترین شیوهها برای پیادهسازی توکنسازی هوش مصنوعی چیست؟

پیادهسازی مؤثر توکنسازی هوش مصنوعی نیازمند ملاحظات سیستماتیک انتخاب الگوریتم، استراتژیهای پیشپردازش، و تکنیکهای بهینهسازی است. موفقیت توکنسازی مدرن به تطبیق رویکرد درست با مورد استفاده خاص شما در حالی که کارایی محاسباتی و دقت معنایی حفظ میشود، بستگی دارد.

استراتژی انتخاب الگوریتم

انتخاب الگوریتم آگاه از زمینه به عنوان پایه توکنسازی مؤثر عمل میکند. Byte-Pair Encoding روش قوی و کارآمد برای کاربردهای عمومی باقی مانده به دلیل عملیات ادغام مبتنی بر فرکانس که استفاده از واژگان را به طور مؤثر بهینه میکند. برای زمینههای آموزشی شامل زبانهای غنی مورفولوژیکی مانند ترکی یا فنلاندی، WordPiece مدیریت برتر مورفولوژی مشتقشده را با اولویت دادن به ادغام توکنهایی که احتمال corpus را حداکثر میکنند، ارائه میدهد. SentencePiece به عنوان راهحل ترجیحی برای محتوای چندزبانه یا کدمیکس ظاهر میشود، و whitespace را به عنوان کاراکتر native میکند در حالی که توکنسازی انعطافپذیر در اسکریپتها و زبانهای متنوع پشتیبانی میکند. پیکربندی واژگان نیازمند مقیاسگذاری استراتژیک بر اساس زمینه استقرار شما است. تحقیقات محدودههای بهینه ۳۲٬۰۰۰–۵۰٬۰۰۰ توکن برای مدلهای تکزبانه را نشان میدهد، که به حدود ۱۰۰٬۰۰۰ توکن برای پیادهسازیهای چندزبانه گسترش مییابد. پارادایم over-tokenization نشان میدهد که جداسازی واژگان ورودی و خروجی بهبودهای عملکرد سازگار بدون افزایش overhead محاسباتی ارائه میدهد.

بهینهسازی پایپلاین پیشپردازش

نرمالسازی NFKC Unicode پایه را برای پشتیبانی چندزبانه برقرار میکند، و equivalents سازگاری را مدیریت میکند در حالی که یکپارچگی معنایی حفظ میشود. پایپلاین نرمالسازی شما باید قوانین خاص زبان شامل stripping accent برای زبانهای رومی، isolation کاراکتر CJK با whitespace اطراف، و folding case قابل پیکربندی بر اساس نیازهای دامنه را پیادهسازی کند. زمینههای حقوقی و پزشکی معمولاً نیاز به folding case غیرفعال برای حفظ دقت اصطلاحات دارند. ترتیب متوالی عملیات پیشپردازش به طور حیاتی بر fidelity بازسازی تأثیر میگذارد. باید توالی نرمالسازی، پیشتوکنسازی، و توکنسازی مدل را دنبال کنید، زیرا inversions ترتیب میتواند عملکرد را به طور قابل توجهی کاهش دهد. segmentation مبتنی بر regex GPT-4 استاندارد طلایی فعلی برای پیشتوکنسازی ارائه میدهد، و isolation عددی را با حفظ کلمات ترکیبی برای بهینهسازی پردازش پاییندستی ترکیب میکند.

تکنیکهای regularization و robustness

regularization زیرکلمه robustness مدل را با تزریق نویز کنترلشده طی آموزش از طریق نمونهبرداری از segmentationهای جایگزین بهبود میبخشد. رویکرد مدل زبان unigram امتیازات احتمالی به segmentationهای کاندید اختصاص میدهد، و توزیعهای کنترلشده با دما را امکانپذیر میسازد که مدیریت اصطلاحات خارج از واژگان و سناریوهای shift دامنه را بهبود میبخشد. برای پیادهسازیهای عملی، BPE-dropout تعادل مؤثری بین پیچیدگی و عملکرد ارائه میدهد. این رویکرد به طور تصادفی ادغامها را طی آموزش با نرخهای dropout حدود ۰.۱ رد میکند، سپس به پردازش deterministic طی استنتاج بازمیگردد. این تکنیک regularization generalization مدل را بهبود میبخشد در حالی که سادگی استقرار را حفظ میکند.

ملاحظات کارایی عملیاتی

تکنیکهای بهینهسازی توکن میتوانند هزینههای پردازش را به طور قابل توجهی بدون degradation معنایی کاهش دهند. substitution acronym، کاهش بند نسبی، و elimination stopword استراتژیک میتوانند صرفهجویی توکن قابل توجهی در حالی که معنای حفظ میشود، دستیابی کنند. counters توکن تعاملی طی توسعه کمک میکنند implications هزینه واقعیزمان انتخابهای phrasing مختلف را visualize کنند. پردازش incremental برای استقرارهای تولید که بهروزرسانیهای محتوای مکرر را مدیریت میکنند حیاتی میشود. اصل locality re-tokenization بهروزرسانیهای جزئی را با برقراری نقاط همترازی مرز امکانپذیر میسازد، و پیچیدگی محاسباتی را از مربعی به لگاریتمی برای تغییرات سند کاهش میدهد. این رویکرد عملکرد را حفظ میکند در حالی که تجربیات کاربری responsive را امکانپذیر میسازد.

تکنیکهای پیشرفته توکنسازی هوش مصنوعی که باید بدانید چیست؟

توکنسازی هوش مصنوعی معاصر فراتر از پیشپردازش ثابت به سیستمهای تطبیقی پیچیده تکامل یافته که برای کارایی، حریم خصوصی، و ادغام بینوجهی بهینهسازی میکنند. درک این تکنیکهای پیشرفته شما را قادر میسازد قابلیتهای cutting-edge را بهرهبرداری کنید در حالی که چالشهای نوظهور در استقرارهای هوش مصنوعی مدرن را برطرف میکنید.

سیستمهای توکنسازی تطبیقی و پویا

ادغام توکن سلسلهمراتبی پویا breakthrough در کارایی محاسباتی برای ترانسفورمرهای بینایی نمایان میکند. این رویکرد خوشهبندی agglomerative سلسلهمراتبی را در لایههای میانی اعمال میکند، و اطلاعات بصری حیاتی را حفظ میکند در حالی که پیچیدگی محاسباتی را مربعی متناسب با شمار توکن کاهش میدهد. وظایف segmentation پزشکی speedup قابل توجه با degradation دقت حداقلی نشان میدهند، و مزایای عملی برای محیطهای محدود منابع را به نمایش میگذارند. چارچوبهای morphogenesis زمینهای تنظیم مرز توکن زمان اجرا بر اساس روابط معنایی را امکانپذیر میسازند. با جایگزینی segmentation ثابت با پروتکلهای گسترش توکن آموختهشده، این سیستمها expressions idiomatic و اصطلاحات دامنه را با دقت به طور قابل توجهی بالاتر در دامنههای تخصصی حفظ میکنند. رویکرد retrofitting hypernetworks پیشبینی جاسازی را ادغام میکند تا عملکرد را در چندین زبان حفظ کند در حالی که کاهش طول توالی دستیابی میکند.

یکپارچهسازی توکن چندوجهی

فضاهای جاسازی مشترک frontier بعدی در فناوری توکنسازی را نمایان میکنند. TEAL تصاویر، صوت، و متن را به توالیهای توکن مشترک discretize میکند، و مدلهای زبان منجمد را قادر میسازد ورودیهای چندوجهی را از طریق ماتریسهای جاسازی همتراز projection پردازش کنند. این معماری عملکرد state-of-the-art در معیارهای درک چندوجهی دستیابی میکند در حالی که کارایی پارامتر single-modality را حفظ میکند. implications عملی فراتر از بهبودهای عملکرد فنی گسترش مییابد. یکپارچهسازی توکن چندوجهی تیمهای توسعه را قادر میسازد کاربردهایی بسازند که انواع داده متنوع را به طور یکپارچه پردازش کنند بدون حفظ خطوط لوله پردازش جداگانه. این سادهسازی معماری پیچیدگی توسعه را کاهش میدهد در حالی که قابلیتهای عملکردی را در وظایف vision-language گسترش میدهد.

چارچوبهای توکنسازی حفظ حریم خصوصی

سیستمهای توکنسازی مبتنی بر هوش مصنوعی به طور فزایندهای حفاظت حریم خصوصی پیچیده از طریق مکانیسمهای differential privacy کاوش میکنند. رویکردهای آزمایشی مانند perturbation جاسازی زمینهای توکنهای حساس را mask میکنند در حالی که utility بالا در پردازش متن بالینی و کاربردهای داده مالی هدف قرار میدهند. در چنین تنظیمات تحقیقاتی، بودجههای حریم خصوصی میتوانند به طور پویا در موقعیتهای توکن تخصیص یابند تا tradeoff utility-security بهینه شود، و پردازش compliant اطلاعات حساس را پشتیبانی کند. توکنسازی دارایی واقعیجهان کاربردهای عملی این تکنیکهای حریم خصوصی را نشان میدهد. موتورهای valuation عصبی دادههای بازار واقعیزمان، تحلیل احساسات اجتماعی، و بررسیهای رعایت مقررات را در مدلهای قیمتگذاری پویا ادغام میکنند. این convergence عاملهای هوش مصنوعی با توکنسازی حفظ حریم خصوصی تجارت خودکار داراییهای توکنسازیشده را در حالی که رعایت مقررات در چندین jurisdiction حفظ میکند، امکانپذیر میسازد.

تکنیکهای بهینهسازی عملکرد

تکنیکهای فشردهسازی معنایی مانند MrT5 طول توالی سطح بایت را از طریق gates حذف آموختهشده در لایههای encoder میانی کاهش میدهند. با حفظ تنها توکنهای زمینهای حیاتی پس از پردازش اولیه، این معماری speedup قابل توجه در پردازش چندزبانه دستیابی میکند در حالی که عملکرد را از طریق ادغام اطلاعات implicit حفظ میکند. این تکنیک به طور مؤثر نویز سطح کاراکتر و variance بینزبانی را بدون نیاز به segmentation زیرکلمه مدیریت میکند. پارادایمهای پردازش بدون توکن رویکرد جایگزین کامل ارائه میدهند. MambaByte توالیهای بایت خام را از طریق مدلهای فضای حالت selective پردازش میکند که به طور خطی با طول توالی مقیاس مییابند، و پردازش سطح بایت را محاسباتی feasible میسازد. این معماری عملکرد رقابتی با ترانسفورمرهای زیرکلمه نشان میدهد در حالی که در robustness نویز برتر است، و متن را با swaps کاراکتر، capitalization تصادفی، و anomalies spacing که توکنایزرهای conventional را مختل میکنند، دقیق پردازش میکند. این تکنیکهای پیشرفته به طور جمعی tension اساسی بین tractability محاسباتی و fidelity نمایندگی که طراحی سیستم هوش مصنوعی مدرن را تعریف میکند، برطرف میکنند. پیادهسازی نیازمند ملاحظات دقیق محدودیتهای استقرار، نیازهای عملکرد، و تعهدات حریم خصوصی است، اما مزایای بالقوه شامل سودهای کارایی قابل توجه، robustness بهبودیافته، و حفاظت حریم خصوصی تقویتشده است.

نتیجه گیری

توکنسازی از تکنیک پردازش متن ساده به ابزار قدرتمند در زمینههای متنوع مانند امنیت سایبری و هوش مصنوعی تکامل یافته است. به عنوان فرآیند پایه عمل میکند که سیستمهای هوش مصنوعی را قادر میسازد متن شبیه به انسانی درک و تولید کنند. با تجزیه داده به توکنهای قابل مدیریت، هوش مصنوعی میتواند اطلاعات را مؤثرتر پردازش کند. با ادامه پیشرفت هوش مصنوعی، درک و بهینهسازی توکنسازی برای ساخت کاربردهای هوش مصنوعی دقیقتر و کارآمدتر ضروری باقی خواهد ماند.

سوالات متداول

مثالی از توکنسازی چیست؟

توکنسازی جمله “Advancements in AI make your interactions with technology more intuitive.” نتیجه میدهد در: [“Advancements”, “in”, “AI”, “make”, “your”, “interactions”, “with”, “technology”, “more”, “intuitive”, “.”]

مثالی از یک توکن در هوش مصنوعی چیست؟

در جمله “AI is evolving rapidly,” توکنها “AI”, “is”, “evolving”, و “rapidly” هستند.