تحلیل اکتشافی داده (EDA) به عنوان پایه حیاتی برای تصمیمگیری مبتنی بر داده عمل میکند و به متخصصان اجازه میدهد الگوها را کشف کنند، ناهنجاریها را تشخیص دهند، و فرضیهها را قبل از غوطهور شدن در مدلسازیهای پیچیده فرموله کنند. با رشد حجم و پیچیدگی مجموعه دادهها، EDA از خلاصههای آماری ساده به فرآیندهای پیشرفته افزایشیافته با هوش مصنوعی تکامل یافته است که خودکارسازی را با تخصص انسانی ترکیب میکند تا بینشهای سریعتر و دقیقتری ارائه دهد.

این راهنمای جامع روششناسیها، ابزارها، و بهترین شیوههای EDA مدرن را که چالشهای تحلیلی امروز را حل میکنند، بررسی میکند. شما خواهید آموخت که چگونه از چارچوبهای خودکار، تکنیکهای مبتنی بر هوش مصنوعی، و روشهای تجسم پیشرفته برای تبدیل دادههای خام به هوش عملیاتی در حالی که دقت تحلیلی و قابلیت تکرارپذیری را حفظ میکنید، بهره ببرید.

تحلیل اکتشافی داده چیست؟

درک عمیق دادههای خود قبل از انجام هر تحلیلی برای پروژههای علم داده موفق ضروری است. شما نیاز به دانستن الگوها، متغیرها، و نحوه روابط بین آن متغیرها، و غیره دارید. تحلیل اکتشافی داده (EDA) فرآیند سیستماتیک است که دادههای شما را بررسی، خلاصه، تجسم، و درک میکند تا نتیجهگیریهای مبتنی بر داده تولید کند و تحقیقات بیشتر را هدایت کند.

خلاصهسازی داده

EDA خلاصهسازی جامع داده را با استفاده از آمار توصیفی ممکن میسازد که به درک انحراف، تمایل مرکزی، و توزیع مقادیر در سراسر مجموعه داده شما کمک میکند. این گام پایهای ویژگیهای اساسی دادههای شما را آشکار میکند، از جمله معیارهای تمایل مرکزی، تنوع، و شکل توزیعها.

تجسم داده

با پیادهسازی EDA، میتوانید از تکنیکهای تجسم متنوع مانند هیستوگرامها، نمودارهای خطی، نمودارهای پراکندگی، و تجسمهای تعاملی پیشرفته برای کاوش الگوها، روابط، و روندها در مجموعه داده استفاده کنید. EDA مدرن تجسمهای پویا را که به طور خودکار به ویژگیهای داده سازگار میشوند، شامل میشود، با سیستمهای آگاه به زمینه که انواع نمودار بهینه را بر اساس ویژگیهای آماری متغیرها پیشنهاد میدهند.

پاکسازی داده

پاکسازی داده برای هدایت بینشهای معنادار و اطمینان از دقت حیاتی است. EDA به شما کمک میکند دادههای خود را با شناسایی خطاها، ناسازگاریها، تکراریها، و مقادیر گمشده پاکسازی کنید در حالی که چارچوبهایی برای حل سیستماتیک این مسائل کیفیت ارائه میدهد. رویکردهای معاصر ابزارهای ارزیابی کیفیت خودکار را ادغام میکنند که مسائل بالقوه را علامتگذاری میکنند و استراتژیهای remediation را بر اساس ویژگیهای توزیع داده پیشنهاد میدهند.

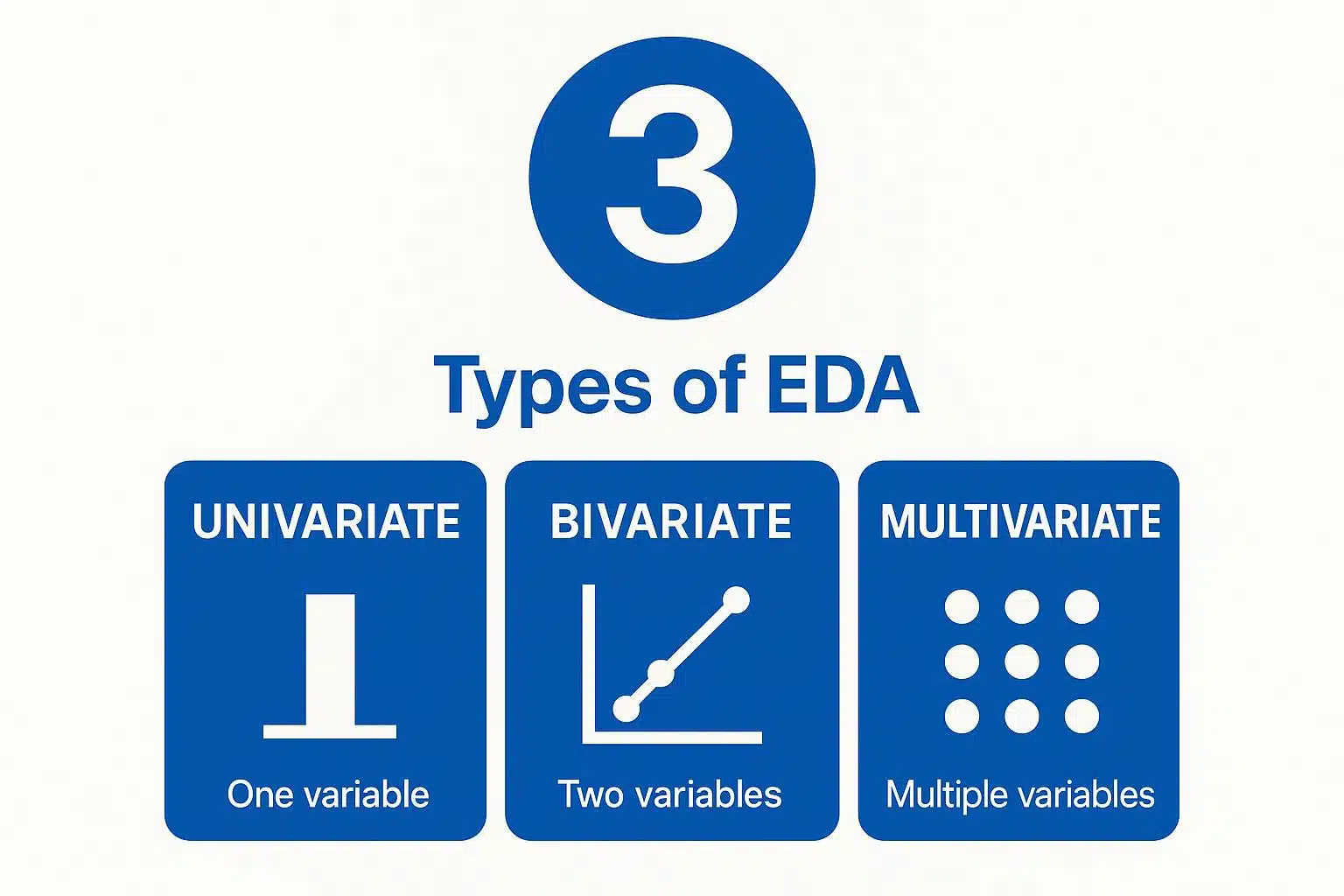

انواع تحلیل اکتشافی داده چیست؟

درک تکنیکهای تحلیل اکتشافی داده به تحلیل داده کارآمد و تصمیمگیریهای معنادار کمک میکند. در زیر سه نوع اصلی که پایه کاوش سیستماتیک داده را تشکیل میدهند، آورده شده است.

- تحلیل اکتشافی داده تکمتغیره

نوعی تحلیل که در آن یک متغیر را در هر زمان مطالعه میکنید تا توزیع، تمایل مرکزی، و تنوع آن را درک کنید. برای مثال، تمرکز بر فروش محصول برای درک اینکه کدام محصول بهتر عمل میکند، نیاز به بررسی ارقام فروش به طور مستقل از عوامل دیگر دارد.- روشهای گرافیکی: هیستوگرامها، جعبهچرخها، نمودارهای چگالی، ویولنها، نمودارهای Q-Q

- روشهای غیرگرافیکی: میانگین، میانه، مد، معیارهای پراکندگی، صدکها، کجی، کشیدگی

- تحلیل اکتشافی داده دومتغیره

تحلیل دومتغیره بر مطالعه روابط بین دو متغیر تمرکز دارد تا همبستگی، علیت، و الگوهای تعامل را درک کند. برای مثال، کاوش رابطه بین سن مشتری و ترجیحات دستهبندی محصول بینشهای مهم بخشبندی بازار را آشکار میکند.- روشهای گرافیکی: نمودارهای پراکندگی، نمودارهای خطی، نمودارهای حبابی، ماتریسهای همبستگی، نمودارهای توزیع مشترک

- روشهای غیرگرافیکی: ضرایب همبستگی، تحلیل رگرسیون، آزمونهای کای-دو، محاسبات کوواریانس

- تحلیل اکتشافی داده چندمتغیره

تحلیل چندمتغیره به تحلیل و درک روابط پیچیده بین سه یا چند متغیر همزمان کمک میکند. برای مثال، کاوش رابطه بین قد، وزن، سن، و نتایج سلامتی یک شخص نیاز به تکنیکهای تحلیلی پیچیده برای شناسایی الگوهای معنادار دارد.- روشهای گرافیکی: ماتریسهای نمودار پراکندگی، نقشههای حرارتی، نمودارهای مختصات موازی، تجسمهای کاهش بعد

- روشهای غیرگرافیکی: رگرسیون چندگانه، تحلیل عاملی، تحلیل خوشه، تحلیل مؤلفههای اصلی

متدولوژیهای تحلیل اکتشافی داده هدایتشده با هوش مصنوعی چیست؟

EDA مدرن فراتر از رویکردهای آماری سنتی تکامل یافته است تا تکنیکهای هوش مصنوعی و یادگیری ماشین را در خود جای دهد که کشف الگو و تولید بینش را خودکار میکنند. این متدولوژیهای مبتنی بر هوش مصنوعی، تحلیل واکنشی را به استخراج هوشمندانهی پیشدستانه تبدیل میکنند.

کشف الگوهای خودکار

سیستمهای EDA تقویتشده با هوش مصنوعی اکنون از الگوریتمهای یادگیری بدونناظر برای شناسایی خودکار خوشهها، ناهنجاریها، و روابط ویژگیها بدون دخالت انسانی استفاده میکنند. الگوریتمهای یادگیری ماشین مانند جنگلهای ایزوله (isolation forests) امکان شناسایی خودکار ناهنجاریها را فراهم میکنند، در حالی که تحلیل توپولوژیک دادهها مانیفولدهای غیرخطی در رفتار مشتریان را آشکار میکند که ماتریسهای همبستگی سنتی از آن غافل میشوند. این سیستمها مدلهای پیشبینی جایگذاری مقادیر گمشده را ادغام میکنند که نهتنها شکافها را پر میکنند، بلکه توزیع عدمقطعیت را کمیسازی میکنند و پایههای آماری قویتری برای تحلیلهای بعدی فراهم میسازند.

پردازش پرسوجوی زبان طبیعی

پلتفرمهای مدرن EDA مدلهای زبانی بزرگ را ادغام کردهاند تا اکتشاف داده را بهصورت محاورهای ممکن کنند. اکنون میتوانید پرسوجوهای تحلیلی را به زبان طبیعی مانند «الگوهای خرید فصلی مشتریان ارزشمند را نشان بده» مطرح کنید، بهجای آنکه کوئریهای فنی پیچیده بسازید. این سیستمها درخواستهای محاورهای را به کد اجرایی تبدیل میکنند در حالی که شفافیت کامل برای بازتولیدپذیری حفظ میشود. پیادهسازیهای پیشرفته، روایتهای تحلیلی جامع تولید میکنند که نهتنها نشان میدهند چه الگوهایی وجود دارند، بلکه توضیح میدهند چرا این الگوها از نظر زمینهای اهمیت دارند؛ شکاف میان خروجیهای آماری و هوش تجاری را پر میکنند.

تولید بینشهای پیشبینیکننده

ابزارهای EDA مبتنی بر هوش مصنوعی، خلاصههای فرضیهای تولید میکنند که روابط معنادار آماری را بهطور خودکار آشکار میسازند و آنها را بر اساس قدرت پیشبینی و ارتباط با کسبوکار رتبهبندی میکنند. این سیستمها متریکهای «شگفتی بیزین» (Bayesian surprise) را ادغام میکنند تا الگوهای غیرمنتظره را اولویتبندی کنند. مهندسی ویژگی خودکار اکنون عبارات تعاملی بین ویژگیها، بسطهای چندجملهای، و تبدیلات دامنهمحور را بر اساس ویژگیهای داده و اهداف تحلیل تولید میکند، در حالی که نظارت انسانی از طریق نقاط کنترل اعتبارسنجی حفظ میشود؛ نقاطی که در آن پیشنهادهای خودکار تحت آزمونهای آماری قرار میگیرند.

اکتشاف آگاه از زمینه

پیادهسازیهای پیشرفته تاریخچهی مکالمه را نگه میدارند تا پرسوجوهای پیدرپی بتوانند از زمینهی تحلیلهای پیشین بهرهمند شوند. پلتفرمهای مدرن درختهای فرضیه تولید میکنند که مسیرهای تحلیلی چندگانه را بر اساس یافتههای اولیه پیشنهاد میدهند و چارچوبهای اکتشاف پویا ایجاد میکنند، نه گزارشهای ایستا. این تغییر، گذر از اسکریپتهای تحلیل از پیش تعیینشده به اکتشاف تطبیقی است؛ جایی که هر یافته مسیر تحقیقات بعدی را بهطور پویا شکل میدهد.

چگونه میتوانید تحلیل اکتشافی داده انجام دهید؟

EDA مدرن از یک فرآیند نظاممند هشتمرحلهای پیروی میکند که سختگیری آماری سنتی را با تکنیکهای خودکار معاصر ترکیب میکند تا درک جامع داده تضمین شود.

جمعآوری دادهها – دادههای مرتبط را از منابع متنوع گردآوری کنید، در حالی که کیفیت و کاملبودن آنها را با اعتبارسنجی خودکار شِما در برابر قراردادهای دادهای خاص دامنه تضمین میکنید.

بازرسی متغیرهای داده – متغیرهای حیاتی، انواع داده، مقادیر گمشده و توزیعهای اولیه را با استفاده از ابزارهای پروفایلینگ مجهز به هوش مصنوعی شناسایی کنید که مسائل بالقوهی کیفی را برجسته میسازند.

پاکسازی دادهها – خطاها، ناسازگاریها و تکرارها را اصلاح کنید، در حالی که یکپارچگی داده را از طریق ردیابی نظاممند تبدیلات و مستندسازی توجیههای آماری حفظ میکنید.

شناسایی الگوها و همبستگیها – مجموعهدادهها را با استفاده از ابزارهای متنوع تجسم دادهها مصورسازی کنید، همراه با انتخاب خودکار نمودار بر اساس ویژگیهای متغیرها.

اجرای آمار توصیفی – مقیاسهای گرایش مرکزی، تغییرپذیری، و ویژگیهای توزیع را محاسبه کنید، همراه با تولید فرضیههای خودکار برای اعتبارسنجی تحلیلگر.

انجام تحلیل پیشرفته – تکنیکهای چندمتغیره و رویکردهای یادگیری ماشین را به کار بگیرید تا بینشهای عمیقتر به دست آورید، از جمله روشهای تخصصی برای دادههای زمانی، مکانی و غیرساختاریافته.

تفسیر دادهها – بینشها را در زمینهی کسبوکار مناسب با استفاده از تولید روایت یاریشده توسط هوش مصنوعی استخراج کنید که الگوهای آماری را در قالب اصطلاحات تجاری توضیح میدهد.

مستندسازی و گزارشدهی – گامها، تکنیکها و یافتهها را برای ذینفعان ثبت کنید، از طریق دفترچههای بازتولیدپذیر همراه با وابستگیهای کنترلشده با نسخه و گزارشهای جامع عملیات.

ابزارها و چارچوبهای خودکار EDA چیستند؟

تکامل EDA بهطور قابلتوجهی با ابزارهای خودکار شتاب گرفته است که تلاش دستی را کاهش میدهند در حالی که سختگیری تحلیلی را حفظ میکنند. پیادهسازیهای معاصر روشهای آماری سنتی را با معماریهای بومیابر و رابطهای زبان طبیعی ترکیب میکنند.

کتابخانههای خودکار مبتنی بر پایتون

کتابخانههایی مانند ydata-profiling نمایندهی آخرین فناوری در تولید خودکار گزارش هستند که فراتر از آمار پایهای رفته و قابلیتهایی مانند تجزیهی سریهای زمانی، تحلیل متن و مقایسهی مجموعهدادهها را در یک خروجی HTML واحد ارائه میدهند.D-Tale بهعنوان محیط اکتشاف تعاملی پیشرو مطرح شده است که قابلیتهای تبدیل داده مبتنی بر GUI را همراه با تولید کد بلادرنگ ارائه میدهد.AutoViz انتخاب نمودارهای تجسم خودکار را ارائه میدهد که بر اساس ویژگیهای آماری متغیرها تنظیم شده و نمودارهایی با کیفیت انتشار و حاشیهنویسیهای زمینهای تولید میکند.

پلتفرمهای اکتشاف تقویتشده با هوش مصنوعی

پلتفرمهای ابری EDA به زیرساخت ضروری برای تحلیلهای سازمانی تبدیل شدهاند و محاسبات مقیاسپذیر، محیطهای همکاری و قابلیتهای یکپارچهی هوش مصنوعی را ارائه میدهند. این پلتفرمها ادغام کاتالوگ داده را شامل میشوند، جایی که یافتههای EDA بهطور خودکار مخازن متادیتا را پر میکنند و دانش سازمانی ایجاد میکنند که تحلیلهای آینده را تسریع مینماید. پیادهسازیهای پیشرو محیطهای همکاری بلادرنگ را ارائه میدهند، جایی که اعضای تیم میتوانند بهطور همزمان ابعاد مختلف یک مجموعهداده را بررسی کنند در حالی که روایت تحلیلی یکپارچه حفظ میشود.

راهکارهای خودکار در سطح سازمانی

پلتفرمهای مدرن پروفایلینگ خودکار داده را همراه با تولید بینش یاریشده توسط هوش مصنوعی ادغام کردهاند که به تحلیلگران تجاری اجازه میدهد اکتشاف پیشرفته را از طریق پرسوجوهای محاورهای انجام دهند. این سیستمها ردیابی خودکار فرضیات را حفظ میکنند، جایی که ادعاهای دانش دامنه در قالبهای قابلخواندن توسط ماشین ثبت میشوند و در طول چرخهی تحلیل در برابر توزیعهای داده اعتبارسنجی میشوند.

ادغام با جریانهای کاری ML

چارچوبهای مدرن با خطوط یادگیری ماشین (ML pipelines) یکپارچه شدهاند و بهطور خودکار رتبهبندی اهمیت ویژگیها، تحلیل همبستگی، و گزارشهای کیفیت داده تولید میکنند که توسعهی مدل را مطلع میسازند. چارچوبهای اجرایی مانند Kedro و Prefect برای مدیریت جریانهای کاری اکتشافی سازگار شدهاند و مدیریت وابستگی و رسیدگی به خطا را که معمولاً برای خطوط تولیدی رزرو شده بود، ارائه میدهند و بهشکل قابلتوجهی قابلیت اطمینان تحلیل را افزایش میدهند.

ابزارهای سنتی تحلیل اکتشافی داده کدامند؟

-

Python – شامل NumPy، Pandas، Scikit-learn، Seaborn، Plotly برای محاسبات آماری جامع و تجسم داده

-

R – اکوسیستمی غنی برای پاکسازی، تبدیل و اکتشاف آماری همراه با بستههای تخصصی برای تحلیلهای دامنهمحور

-

MATLAB – محیطی قدرتمند برای محاسبات عددی و تجسم داده با جعبهابزارهای تخصصی برای کاربردهای مهندسی

-

Jupyter Notebooks – اسناد تعاملی و قابلاشتراک که کد، تجسمها و متن توضیحی را ترکیب میکنند همراه با افزونههایی برای بازتولید خودکار

چه چارچوبهای اخلاقی باید تحلیل اکتشافی داده را هدایت کنند؟

عملیات EDA معاصر نیازمند ادغام نظاممند ملاحظات اخلاقی در طول کل جریان کاری اکتشاف است؛ زیرا رویکردهای سنتی اغلب اخلاق را به مراحل پس از تحلیل موکول میکردند، زمانی که الگوهای سوگیری از قبل تثبیت شده بودند.

پروتکلهای حفاظت داده زمینهمحور

ناشناسسازی پویا باید هنگام بازرسی داده بر اساس معناشناسی فیلد و الزامات قانونی فعال شود. کدهای پستی بهعنوان ناحیه نمایش داده شوند، حقوق بهصورت چارک، و کدهای پزشکی بهعنوان پرچمهای طبقهای بدون مقادیر جزئی برای جلوگیری از بازشناسایی افراد. پیادهسازیهای مدرن برچسبگذاری معنایی را هنگام ورود داده ادغام میکنند، همراه با قوانین تجمیع از پیش پیکربندیشده برای هر کلاس داده و موتورهای تبدیل لحظهای که در حالی که سودمندی تحلیلی را حفظ میکنند، اطلاعات حساس را محافظت مینمایند.

سیستمهای خودکار شناسایی سوگیری

امتیازدهی سوگیری همراه با آمارهای توصیفی استاندارد از طریق ابزارهای خودکار ارزیابی انصاف محاسبه میشود که معیارهای برابری جمعیتی برای ویژگیهای حفاظتشده، امتیازهای واگرایی توزیعی میان زیرگروهها و شبیهسازهای انصاف خلافواقعی را دربر میگیرند. این سیستمها نابرابریهای بالقوه را پیش از توسعهی مدل علامتگذاری میکنند و امکان اصلاح پیشدستانه را فراهم میآورند. پلتفرمهای پیشرفته بودجههای سوگیری حفظ میکنند که نابرابریهای طبقات حفاظتشده را بهصورت کمی در طول مراحل اکتشاف داده ردیابی میکنند.

درختهای تصمیم اخلاقی و نقاط کنترل اعتبارسنجی

نقاط کنترل ساختاریافتهی جریان کاری از طریق چارچوبهای اعتبارسنجی نظاممند، از نادیدهگیری اخلاقی جلوگیری میکنند. رویکردهای رویهای اطمینان میدهند که ملاحظات اخلاقی پیش از بینشهای تحلیلی مورد بررسی قرار گیرند؛ از طریق دروازههای بازبینی اجباری هنگامی که ویژگیهای حفاظتشده شناسایی میشوند، نابرابری نتایج از مقادیر آستانه فراتر میرود، یا ترکیب دادههای حساس نیازمند پروتکلهای پردازش ویژه است.

تکنیکهای اکتشاف حفظکنندهی حریم خصوصی

مکانیسمهای حریم خصوصی افتراقی (Differential Privacy) امکان تحلیل آماری را فراهم میکنند در حالی که بازسازی دادههای فردی را از طریق تزریق نویز کالیبرهشده و مدیریت بودجهی حریم خصوصی جلوگیری میکنند. پلتفرمهای مدرن هزینهی تجمعی حریم خصوصی را در طول جلسات اکتشاف ردیابی میکنند در حالی که سودمندی تحلیلی را از طریق بهینهسازی تطبیقی پرسوجو و استراتژیهای نمونهبرداری هوشمندانه که بینشهای سطح جمعیت را حفظ میکنند، حفظ مینمایند.

چگونه میتوانید بازتولیدپذیری را در فرآیندهای تکرارشوندهی EDA تضمین کنید؟

بازتولیدپذیری در EDA نیازمند ثبت نظاممند تکامل اکتشاف است، زیرا کنترل نسخهی سنتی تنها بر مصنوعات نهایی تمرکز دارد، نه مسیرهای تحلیلی که منجر به تولید بینشها میشوند.

سیستمهای مستندسازی آگاه از منشأ (Provenance-Aware Documentation Systems)

ردیابی جامع اکتشاف نیازمند مستندسازی سهلایه است: دفترچههای محاسباتی خام همراه با رکوردهای زمانی اجرای کد، تعاریف جریانکاری پارامتری برای تبدیلات حیاتی، و شجرهنامهی تحلیلهای مقایسهای که مسیرهای تحلیلی متفاوت بین اعضای تیم را پرچمگذاری میکند. پیادهسازیهای مدرن بهطور خودکار «تاریخچهی اکتشاف» تولید میکنند که کد، تجسمها و بینشهای روایی را در دفترچههای بازتولیدپذیر همراه با وابستگیهای نسخهدار در هم میآمیزند.

محیطهای اکتشافی کانتینریشده (Containerized Exploration Environments)

کانتینریسازی سبک امکان بازآفرینی دقیق محیط را از طریق فریزکردن وابستگیها و حفظ وضعیت محاسباتی فراهم میکند. هنگامی که با افزونههای checkpoint برای Jupyter، ردیابی مصنوعات MLflow و سیستمهای نسخهبندی داده ترکیب شود، تحلیلگران به «مجموعههای پژوهشی قابلاجرا» دست مییابند که در آن نقاط تحلیل خاص، تجسمهای میانی را حتی پس از ماهها بهطور مطمئن بازتولید میکنند. این چارچوبها مشکل «روی دستگاه من کار میکند» را از طریق مصنوعات پژوهشی تغییرناپذیر از بین میبرند.

مدیریت و بازیابی خودکار وضعیت (Automated State Management and Recovery)

مستندسازی افشای پیشرونده جایگزین گزارشهای تکپارچه میشود از طریق ویجتهای اکتشاف تعاملی که وضعیت پارامترها و پیشرفت تحلیلی را حفظ میکنند. پلتفرمهای مدرن «اسپرینتهای اکتشافی» را پیادهسازی میکنند که در آن دانشمندان داده، متخصصان دامنه و ذینفعان کسبوکار بهطور مشترک در محیطهای تعاملی دادهها را مرور میکنند؛ همراه با رونوشتهای خودکار تحلیل که نتیجهگیریها و مسیرهای اکتشافی (حتی فرضیههای ردشده) را مستند میکنند.

سنتز دانش میانتحلیل (Cross-Analysis Knowledge Synthesis)

سازمانهای پیشرفته پایگاههای دانش EDA را حفظ میکنند که مصنوعات اکتشاف را بر اساس اثرانگشت مجموعهداده نمایهسازی میکنند و جستجوی معنایی در تصاویر تجسم و بینشهای روایی را ممکن میسازند. این سیستمها مقایسهی خودکار میانتحلیل را ادغام میکنند، جایی که پلتفرمها تناقضها یا تأییدها را میان مصنوعات EDA شناسایی میکنند و فراتر از اکتشافهای فردی، از طریق پالایش نظاممند متدولوژی، درک سازمانی ایجاد میکنند.

چالشهای تحلیل اکتشافی داده کدامند؟

یکپارچهسازی و ادغام دادهها

هماهنگسازی مدلهای دادهای ناسازگار از منابع مختلف آمادهسازی EDA را پیچیده میکند و نیازمند نگاشت شِمای پیشرفته و قابلیتهای تبدیل است که در حالی که زمینهی تحلیلی را حفظ میکنند، کشف الگوهای میانسیستمی را ممکن میسازند.

کیفیت و قابلیتاعتماد داده

ناسازگاریها، مقادیر گمشده، دادههای پرت و خطاهای اندازهگیری میتوانند در صورت عدم رسیدگی نظاممند منجر به نتایج نادرست شوند. این مسئله نیازمند چارچوبهای ارزیابی کیفیت جامع و رویههای اعتبارسنجی آماری است.

محدودیتهای مقیاسپذیری و کارایی

مجموعهدادههای حجیم روشهای سنتی EDA را تحت فشار قرار میدهند و مانع تحلیل بلادرنگ میشوند و نیازمند چارچوبهای محاسبات توزیعشده هستند که در حین پردازش اطلاعات در مقیاس ترابایت، پاسخگویی تعاملی را حفظ کنند.

نگرانیهای امنیت و حریم خصوصی

دادههای حساس خطر دسترسی غیرمجاز و نقضهای انطباقی را معرفی میکنند، بنابراین چارچوبهای پیشرفتهی حکمرانی لازم است که در حالی که از حریم خصوصی افراد محافظت میکنند و الزامات قانونی را برآورده میسازند، امکان اکتشاف را نیز فراهم آورند.

ذهنیت و سوگیری شناختی

تفاوتهای تفسیر انسانی میتواند سوگیری تأییدی و بیشبرازش الگوها را معرفی کند. این امر نیازمند مکانیزمهای اعتبارسنجی نظاممند و فرآیندهای بازبینی گروهی است که عینیت تحلیلی را حفظ کنند.

یکنواختی و نسخهبندی دادهها

حفظ بازتولیدپذیری در حالی که مجموعهدادهها تکامل مییابند، نیازمند سیستمهای پیشرفتهی کنترل نسخه است که هم تکامل داده و هم پیشرفت تحلیلی را در طول جریانهای کاری اکتشاف ردیابی کنند.

پیچیدگی دادههای با ابعاد بالا

نفرین ابعاد (curse of dimensionality) نیازمند الگوریتمها و تکنیکهای ریاضی تخصصی است که بتوانند الگوهای معنادار را در فضاهای ویژگی پیچیده شناسایی کنند، در حالی که از همبستگیهای کاذب جلوگیری مینمایند.

رسیدگی به این چالشها مستلزم اتخاذ بهترین شیوهها برای ادغام روان داده و مدیریت نظاممند کیفیت داده از طریق چارچوبهای جامع حکمرانی است.

نتیجهگیری

تحلیل اکتشافی دادههای مدرن از خلاصهسازیهای آماری ساده به فرآیندهای پیشرفتهی تقویتشده با هوش مصنوعی تکامل یافته است که بینشهای سریعتر و دقیقتر ارائه میدهند. با بهرهگیری از چارچوبهای خودکار، روشهای تجسم پیشرفته و حکمرانی اخلاقی، سازمانها میتوانند دادههای خام را به هوش عملیاتی تبدیل کنند، در حالی که سختگیری تحلیلی حفظ میشود.

پرسشهای متداول (FAQ)

چرا تحلیل اکتشافی داده (EDA) پیش از ساخت مدلها اهمیت دارد؟

EDA به شما کمک میکند مجموعهدادهی خود را پیش از اعمال هر مدل پیشبینی یا آماری بهطور عمیق درک کنید. با آشکارسازی روندها، ناهنجاریها، روابط و مسائل بالقوهی کیفیت داده در مراحل ابتدایی، EDA اطمینان میدهد که مدلسازی بر اساس دادهی پاک، مرتبط و قابلتفسیر انجام میشود—که در نهایت دقت را بهبود میبخشد، سوگیری را کاهش میدهد و در بلندمدت زمان صرفهجویی میکند.

آیا ابزارهای خودکار EDA میتوانند جایگزین تحلیل دستی شوند؟

ابزارهای خودکار میتوانند فرآیند EDA را بهطور قابلتوجهی تسریع کنند، از طریق تولید تجسمها، خلاصهها و هشدارها دربارهی مسائل داده. با این حال، آنها جایگزین کامل تخصص انسانی نیستند. بهترین حالت زمانی است که بهعنوان همکار عمل کنند—به متخصصان داده کمک کنند سریعاً بینشها را کشف کنند، در حالی که تفسیر زمینهای ظریف و قضاوت دامنهمحور همچنان توسط انسان انجام شود.

چگونه بین سرعت و بازتولیدپذیری در EDA تعادل برقرار میکنید؟

کلید کار استفاده از ابزارهایی است که هر گام را ثبت میکنند—از پاکسازی داده تا تولید تجسم—در حالی که از کنترل نسخه و ردیابی محیط پشتیبانی میکنند. پلتفرمهای مدرن EDA و محیطهای دفترچهای (مانند Jupyter همراه با کانتینرها) به تحلیلگران اجازه میدهند سریع کار کنند، در حالی که مستندسازی کامل حفظ شود و اطمینان حاصل گردد که یافتهها میتوانند بازتولید، اعتبارسنجی و بعدها پالایش شوند.

چه ریسکهای اخلاقی در طول EDA به وجود میآید و چگونه میتوان به آنها رسیدگی کرد؟

EDA میتواند بهطور ناخواسته اطلاعات حساس را افشا کند یا سوگیریها را تقویت نماید اگر تدابیر اخلاقی در نظر گرفته نشود. برای کاهش این خطر، از ابزارهایی استفاده کنید که ناشناسسازی داده، بررسی انصاف و نقاط بازبینی اجباری برای ویژگیهای حفاظتشده را ادغام میکنند. ادغام اخلاق در هر گام از فرآیند EDA—نه فقط پس از مدلسازی—به حفظ اعتماد و انطباق کمک میکند.