کسبوکارها برای تصمیمگیری مؤثر به بینشهای دادهمحور وابسته هستند، بنابراین انتخاب چارچوب یا پلتفرم مناسب برای مدیریت داده حیاتی است. در میان محبوبترین گزینهها، شبکه داده، پارچه داده و دریاچههای داده قرار دارند.

درک تفاوتهای کلیدی بین این گزینهها به شما کمک میکند تا محیط داده خود را بهینه کنید و آن را با الزامات عملیاتی و اهداف خود همتراز سازید. این مقاله شبکه داده در مقابل پارچه داده در مقابل دریاچه داده را مقایسه میکند و مزایا و معایب هر کدام را مشخص مینماید.

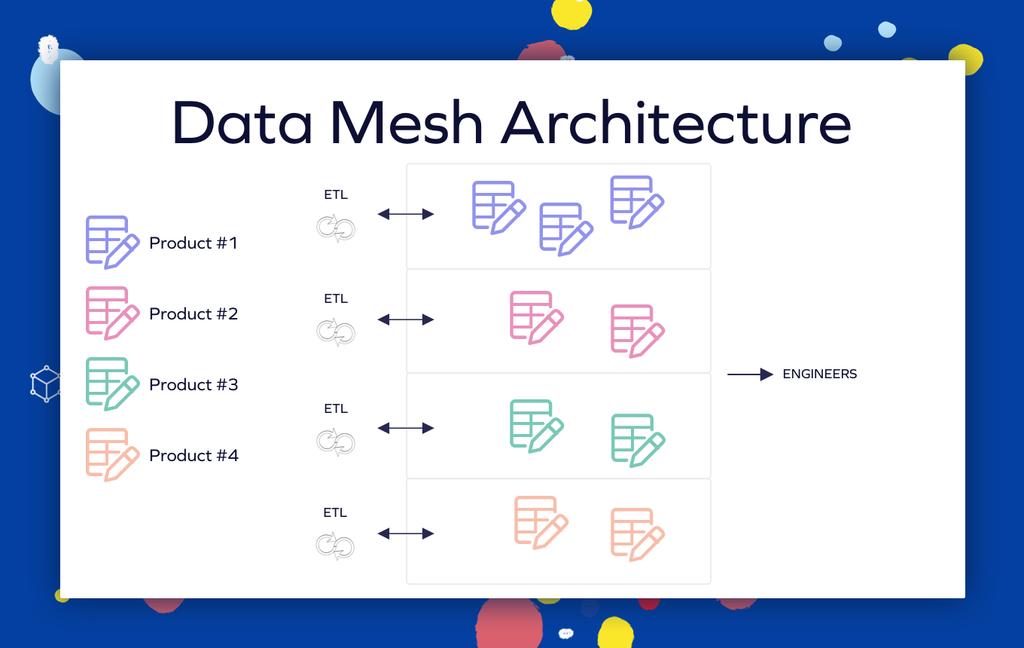

شبکه داده (Data Mesh) چیست؟

شبکه داده یک چارچوب معماری است که مالکیت داده را به حوزههای کسبوکاری مانند بازاریابی، فروش و مالی غیرمتمرکز میکند. اصل اصلی، مدل داده توزیعشده است که در آن هر حوزه داده خود را مدیریت میکند به جای تکیه بر مخزن متمرکز. این رویکرد داده را به عنوان محصول در نظر میگیرد و مالکیت و مسئولیتپذیری بهبودیافته را تضمین میکند و منجر به مقیاسپذیری، نوآوری و همکاری بهتر میشود.

مزایای شبکه داده

مالکیت حوزهمحور:

شبکه داده به تیمها اجازه میدهد چرخه حیات داده خود را مدیریت کنند و مدیریت داده را با نیازهای کسبوکاری همتراز سازند و چابکی را بهبود بخشند.

مقیاسپذیری بالا:

معماری توزیعشده بهتر از گزینههای متمرکز با حجمهای رو به رشد داده کنار میآید.

موارد استفاده مبتنی بر هوش مصنوعی:

شبکه داده از یادگیری ماشین و هوش مصنوعی مقیاسپذیر با فراهم کردن مجموعه دادههای دقیق و حوزهمحور بهینهشده برای آموزش و کاربردهای تصمیمگیری زمان واقعی پشتیبانی میکند.

معایب شبکه داده تلاشبر:

پیادهسازی شبکه داده نیازمند تغییر سازمانی قابل توجه و برنامهریزی است.

چالشهای مهاجرت داده:

انتقال داده از دریاچهها یا انبارهای یکپارچه به شبکه داده نیازمند آمادگی فنی و لجستیکی و رویکرد بینکارکردی برای مدلسازی حوزه است.

پیچیدگی هماهنگی:

تنها درصد کمی از سازمانها به بلوغ لازم برای غیرمتمرکزسازی موفق دست مییابند و چالشهای قابلیت همکاری به دلیل مرزهای حوزه همپوشان ادامه دارد.

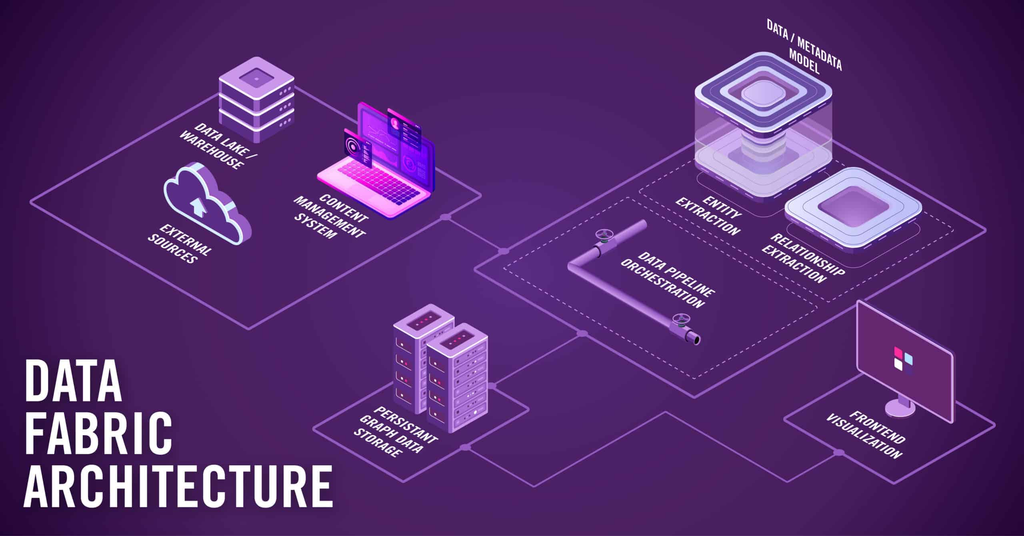

فابریک داده چیست؟

فابریک داده یک معماری داده متمرکز است که پیچیدگیهای عملیات داده را از طریق لایه یکپارچگی یکپارچه پنهان میسازد. آن داده را در زمان واقعی در سراسر برنامهها و سیستمها متصل و مدیریت میکند و چالشهایی مانند پیچیدگی زیرساخت و سیلوهای داده را برطرف مینماید. یکپارچگی، پاکسازی، غنیسازی و حاکمیت خودکار تضمین میکند که داده برای هوش مصنوعی، یادگیری ماشین و تحلیل آماده است.

مزایای پارچه داده تحلیل زمان واقعی:

بهروزرسانیهای مداوم داده از بینشهای زمان واقعی و بهینهسازی عملکرد پشتیبانی میکند.

ردیابی داده:

ردیابی داده داخلی منشأ، تحول و حرکت را پیگیری میکند و قابلیت اطمینان را تضمین کرده و به تصمیمگیری کمک میکند.

یکپارچگی هوش مصنوعی/یادگیری ماشین:

تشخیص ساختار خودکار، تصحیح ناهنجاری و تحلیلهای پیشبینیکننده عملیات را سادهسازی میکنند در حالی که نیاز به مداخله دستی را کاهش میدهند.

هماهنگی چندابری:

رابطهای برنامهنویسی متمرکز دادههای محلی، ابری و لبه را یکپارچه میکنند و محیطهای هیبریدی را سادهسازی کرده و پیچیدگی زیرساخت را کاهش میدهند.

معایب فابریک داده پیچیدگی:

پیادهسازی و مدیریت فابریک داده نیازمند تخصص فنی بالا است و میتواند هزینههای اولیه بالاتری داشته باشد. شکافهای یکپارچگی ابزار: در برخی موارد، فابریک داده ممکن است با تمام پلتفرمهای موجود به طور بیدرز یکپارچه نشود و کارایی را کاهش دهد. سربار حاکمیت: در حالی که کنترل متمرکز ارائه میدهد، معماریهای فابریک میتوانند گلوگاههایی ایجاد کنند هنگام تعادل حاکمیت مرکزی با الزامات خودمختاری حوزه.

دریاچه داده چیست؟

دریاچه داده یک مخزن متمرکز است که برای ذخیره مقادیر عظیمی از دادههای ساختیافته، نیمهساختیافته و بدون ساختار در فرمت خام خود از سیستمهای تراکنشی تا رسانههای اجتماعی و برنامههای شخص ثالث طراحی شده است. دریاچههای داده مدرن در حال تکامل به معماریهای خانه دریاچه هستند که قابلیتهای داده ساختیافته و بدون ساختار را با ویژگیهای کنترل تراکنش و تکامل ساختار ترکیب میکنند.

مزایای دریاچه داده مقیاسپذیری بالا:

دریاچههای داده از ذخیرهسازی توزیعشده بهره میبرند و با حجمهای رو به رشد به طور کارآمد مقیاس میپذیرند.

پشتیبانی چندزبانه:

آنها از آر، پایتون، اسکیوال، اسکالا و بیشتر پشتیبانی میکنند و به تحلیلگران اجازه میدهند از ابزارهای ترجیحی خود استفاده کنند.

مدیریت اطلاعات توصیفی یکپارچه:

دریاچههای پیشرفته لایههای حاکمیت و امنیت ارائه میدهند که فهرستبندی را در سراسر دادههای خام و پردازششده متمرکز میکنند.

فرمتهای جدول باز: فناوریهایی مانند آپاچی آیسبرگ و دلتا لیک قابلیت همکاری مستقل از فروشنده و قابلیتهای تحلیل زمان واقعی را امکانپذیر میسازند.

معایب دریاچه داده پیچیدگی:

مدیریت فرمتهای داده متنوع نیازمند حاکمیت قوی برای نگه داشتن داده سازمانیافته و قابل استفاده است.

هزینه بالا:

ذخیرهسازی، مدیریت و تحلیل در مقیاس میتواند گران شود. ریسک باتلاق داده: بدون مدیریت اطلاعات توصیفی مناسب و چارچوبهای حاکمیت، دریاچهها میتوانند به مخازن غیرقابل مدیریت تبدیل شوند که تحلیل را محدود میکنند به جای امکانپذیر ساختن آن.

معماریهای شبکه داده، فابریک داده و دریاچه داده چگونه متفاوت هستند؟

شبکه داده مالکیت داده را بر اساس حوزه غیرمتمرکز میکند، فابریک داده لایه یکپارچه برای دسترسی یکپارچه به داده فراهم میکند و دریاچه داده دادههای خام و بدون ساختار را در مقیاس برای تحلیلهای متنوع ذخیره میکند.

| ویژگیها | شبکه داده | فابریک داده | دریاچه داده |

|---|---|---|---|

| تمرکز | حوزهمحور، غیرمتمرکز | دسترسی و یکپارچگی یکپارچه | ذخیرهسازی داده خام |

| ذخیرهسازی داده | توزیعشده | متمرکز | متمرکز |

| هزینههای عملیاتی | پایینتر (غیرمتمرکز) | پایینتر (خودکار) | بالاتر (ذخیرهسازی و مدیریت) |

| پیچیدگی | بالا (توزیع) | بالا (یکپارچگی) | پایین (متمرکز) |

| مثالها | نکستدیتا، کی۲ویو، دنودو | تلند، آیبیام، اسایپی هوش داده | اسنوفلیک، گوگل کلاد، آمازون اس۳ |

شبکه داده

چهار اصل راهنما:

- معماری توزیعشده حوزهمحور

- داده به عنوان محصول

- زیرساخت داده خودخدمتی

- حاکمیت داده فدرال

رویکرد شبکه داده بر لولهکاریهای حوزهمحور تأکید دارد که در آن هر حوزه کسبوکاری داده را جذب، پردازش و به عنوان محصولات داده مستقل منتشر میکند. برای مثال، تیم تجارت الکترونیک ممکن است رویدادهای سفارش را از طریق مجموعه دادهای مدیریتشده با اطلاعات توصیفی جامع توصیفکننده ساختار، توافقنامههای سطح خدمات و راهنماهای استفاده ارائه کند.

پلتفرمهای خودخدمتی ابزارهای زیرساختی متمرکز مانند فهرستهای داده و قابلیتهای نظارت ارائه میدهند و به تیمهای حوزه اجازه میدهند بر منطق حوزهمحور تمرکز کنند به جای مدیریت زیرساخت.

فابریک داده

ویژگیهای کلیدی:

- دسترسی یکپارچه به داده

- یکپارچگی و هماهنگی بیدرز

- امنیت، حاکمیت و رعایت

- مقیاسپذیری و انعطافپذیری

- بینشهای زمان واقعی و پشتیبانی چندابری

معماریهای فابریک داده لایههای داده یکپارچه ایجاد میکنند که اطلاعات را از دریاچهها، انبارها، پایگاههای داده و ابزارهای نرمافزار به عنوان خدمات از طریق رابطهای برنامهنویسی، جذب تغییرات داده و فناوریهای مجازیسازی یکپارچه میکنند. مثال عملی ایجاد دیدگاه ۳۶۰ درجه مشتری است که دادههای فروش از سیلزفورس، گزارشهای تراکنش از دریاچه داده و احساسات رسانههای اجتماعی از طریق رابطهای برنامهنویسی را ترکیب میکند.

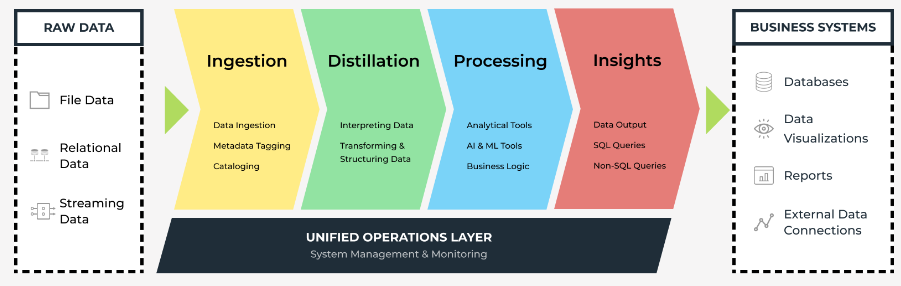

دریاچه داده

لایهها:

- جذب

- تقطیر

- پردازش

- بینشها

- عملیات یکپارچه

دریاچه داده مدرن معماریهای دریاچه داده مدرن لایههای جذب-ذخیرهسازی-مصرف را پیادهسازی میکنند که با ابزارهای دستهای و جریانی از منابع متنوع داده را جمعآوری میکنند. سیستمهای ذخیرهسازی شیءگرا داده خام را جهانی نگه میدارند، در حالی که موتورهای پردازش مانند اسپارک و موتورهای اسکیوال مانند پرستو و ترینو تحلیل ساختار-در-خواندن را امکانپذیر میسازند.

الگوهای دسترسی به داده در این معماریها چگونه متفاوت هستند؟

شبکه داده:

هر حوزه داده خود را کنترل میکند در حالی که دیگران از طریق استانداردهای قابل همکاری یا رابطهای برنامهنویسی اشتراکی به اطلاعات دسترسی دارند. این رویکرد تضمین میکند که داده با عملیات کسبوکاری در زمینه همتراز باقی بماند در حالی که همکاری برونحوزهای را از طریق رابطهای استاندارد امکانپذیر میسازد. تیمهای حوزه مسئولیت کامل کیفیت داده، دسترسیپذیری و پشتیبانی مصرفکننده را بر عهده میگیرند و مسئولیتپذیری همتراز با مالکیت کسبوکاری ایجاد میکنند.

فابریک داده:

دروازههای رابط برنامهنویسی یکپارچه یا لایههای دسترسی مرکزی دیدگاه یکپارچه واحد در سراسر تمام منابع و سیستمهای داده ارائه میدهند. کاربران با رابط سازگار تعامل میکنند صرفنظر از مکان یا فرمت داده زیربنایی، در حالی که فابریک هدایت، تحول و اجرای امنیت را مدیریت میکند. این پنهانسازی پیچیدگی را برای مصرفکنندگان داده کاهش میدهد در حالی که حاکمیت و کنترلهای امنیتی متمرکز را حفظ میکند.

دریاچه داده:

رابطهای مدیریت مرکزی، اغلب فهرستمحور، دسترسی به مخازن داده ترکیبی را از طریق کشف اطلاعات توصیفیمحور و قابلیتهای پرسوجو فراهم میکنند. کاربران معمولاً از طریق موتورهای اسکیوال، پلتفرمهای تحلیلی یا دسترسی مستقیم رابط برنامهنویسی با دریاچه تعامل میکنند، با ساختار که در زمان پرسوجو اعمال میشود نه در زمان جذب. این رویکرد انعطافپذیری را برای تحلیلهای اکتشافی به حداکثر میرساند در حالی که نیازمند درک ساختارها و ویژگیهای کیفیت داده از سوی کاربران است.

چالشهای فعلی در یکپارچگی داده مدرن چیست؟

یکپارچگی داده مدرن با چالشهای متعدد مواجه است که معماریهای سنتی به طور مؤثر نمیتوانند آنها را برطرف کنند:

پردازش زمان واقعی و شکستهای جریانی بسیاری از سازمانها هنوز به پردازش دستهای برای یکپارچگی داده وابسته هستند و شکافهایی در قابلیتهای تصمیمگیری زمان واقعی ایجاد میکنند.

لولهکاریهای داده جریانی اغلب به دلیل تغییرات ساختار، تکرارهای داده یا جمعآوری ناقص داده شکست میخورند.

ابزارهای استخراج-تحول-بارگذاری سنتی با جریانهای رویداد و دادههای اینترنت اشیاء زمانحساس مشکل دارند و منجر به بینشهای قدیمی میشوند که مزیت رقابتی را محدود میکنند.

سازمانها میتوانند این چالشها را با پذیرش معماریهای رویدادمحور با استفاده از پلتفرمهایی مانند آپاچی کافکا برای جذب داده با تأخیر کم برطرف کنند. ترکیب اینها با ابزارهای جذب تغییرات داده بهروزرسانیهای افزایشی داده زمان واقعی را امکانپذیر میسازد، در حالی که چارچوبهای محاسباتی حافظهای پردازش زمان واقعی در مقیاس بزرگ را برای داشبوردهای زنده و آموزش مدلهای یادگیری ماشین مدیریت میکنند.

پیچیدگی یکپارچگی لولهکاری هوش مصنوعی/یادگیری ماشین مدلهای یادگیری ماشین آموزشدیده روی ساختارهای ثابت هنگام تکامل منابع داده خراب میشوند و قابلیت تکرارپذیری و عملکرد مدل را به خطر میاندازند. شکافهای ردیابی داده در لولهکاریهای مهندسی ویژگی الزامات توضیحپذیری را مانع شده و فرآیندهای آموزش مجدد مدل را پیچیده میکنند. این چالشها به ویژه شدید میشوند هنگام مقیاسپذیری ابتکارات هوش مصنوعی در سراسر حوزهها و موارد استفاده متعدد.

راهحلها شامل جاسازی قراردادهای داده در جریانهای کاری یادگیری ماشین با استفاده از ثبتکنندههای ساختار برای اجرا فرمتهای سازگار است. لولهکاریهای مهندسی ویژگی خودکار با بررسیهای کیفیت داده یکپارچه میتوانند انحراف در ویژگیهای حیاتی را علامتگذاری کنند، در حالی که پلتفرمهایی که تأیید داده را با جریانهای کاری یادگیری ماشین ترکیب میکنند، قابلیت اطمینان و سازگاری عملکرد مدل را تضمین مینمایند.

پیچیدگی چندابری و وابستگی به فروشنده تکهتکه شدن داده در سراسر چندین ارائهدهنده ابر انبارهای عملیاتی ایجاد میکند و پیچیدگی مدیریت را افزایش میدهد. هزینههای پنهان انتقال داده بین ارائهدهندگان میتواند بودجهها را ناگهان افزایش دهد، در حالی که الزامات نوشتن اسکریپت پیچیده برای هماهنگی برونابر سربار نگهداری و بدهی فنی ایجاد میکنند.

لایههای پنهانسازی بیطرف ابر به یکپارچگی ذخیرهسازی و محاسبات در سراسر ارائهدهندگان کمک میکنند، در حالی که برنامهریزی معماری آگاه از هزینه و ابزارهای نظارت قرارگیری داده را بهینه میکنند تا از انتقالهای برونمنطقه گران اجتناب شود. این رویکرد سازمانها را قادر میسازد تا از بهترین راهحلهای موجود بهره ببرند بدون ایجاد وابستگیهای فروشنده.

شکافهای مدیریت اطلاعات توصیفی پیشرفته ابزارهای مدیریت اطلاعات توصیفی فعلی اغلب بر اطلاعات توصیفی فنی مانند ساختارها و ردیابی تمرکز دارند، اما فاقد تعاریف زمینهای هستند که معنای کسبوکاری فراهم کنند. دادههای بدون ساختار، شامل تصاویر، صوت و متنهای زبان طبیعی، اغلب فاقد برچسبهای اطلاعات توصیفی سازگار هستند و قابلیت جستجو و اثربخشی حاکمیت را محدود میکنند.

ابزارهای غنیسازی اطلاعات توصیفی مبتنی بر هوش مصنوعی میتوانند دادههای بدون ساختار را تجزیه کرده و برچسبها و روابط را به طور خودکار تولید کنند. نمودارهای دانش ساختهشده روی پایگاههای داده گراف روابط داده را نقشهبرداری میکنند و قابلیتهای جستجوی معنایی را بهبود میبخشند و زمینهای فراهم میکنند که کشف و استفاده از داده در سراسر سازمانها را بهبود میدهد.

چه عواملی باید انتخاب معماری شما را هدایت کنند؟

انتخاب بین شبکه داده، فابریک داده و دریاچه داده به چندین عامل کلیدی بستگی دارد، از جمله حجم داده، ساختار، بودجه، بلوغ سازمانی و اهداف استراتژیک.

شبکه داده

برای سازمانهایی با تیمهای حوزه بالغ که نیازمند تحلیلهای حوزهمحور زمان واقعی هستند و چابکی را بر متمرکزسازی اولویت میدهند، بهترین کارایی را دارد. عوامل موفقیت شامل مرزهای حوزه واضح، استانداردهای همکاری قوی و قابلیتهای مهندسی پلتفرم قوی برای پشتیبانی از زیرساخت خودخدمتی است.

فابریک داده

برای شرکتهایی مناسب است که نیازمند سازگاری داده یکپارچه در سراسر حوزهها هستند، به تحلیلهای برونحوزهای وابستهاند یا سیستمهای قدیمی را مدرنسازی میکنند. عوامل موفقیت شامل تیمهای داده مرکزی قوی، زیرساخت اطلاعات توصیفی موجود و فرهنگ سازمانی که همکاری بین عملیات داده متمرکز و حوزهمحور را پشتیبانی میکند.

دریاچه داده

برای سازمانهایی که ذخیرهسازی دادههای بزرگ مقرونبهصرفه را اولویت میدهند، آزمایش یادگیری ماشین را امکانپذیر میسازند یا جریانهای کاری داده جدید را آزمایش میکنند، مناسب است. عوامل موفقیت شامل قابلیتهای مدیریت اطلاعات توصیفی قوی، سواد داده در سراسر تیمهای توسعه و عملیات و چارچوبهای حاکمیت سختگیرانه برای جلوگیری از شرایط باتلاق داده است.

سوالات متداول

آیا شبکه داده فقط دادههای تحلیلی را مدیریت میکند؟

خیر. در حالی که اغلب با موارد استفاده تحلیلی مرتبط است، معماریهای شبکه داده میتوانند دادههای عملیاتی را نیز به طور مؤثر مدیریت کنند. تیمهای حوزه میتوانند هم محصولات داده تحلیلی برای هوش تجاری و هم محصولات داده عملیاتی که از برنامههای زمان واقعی و فرآیندهای کسبوکاری پشتیبانی میکنند، منتشر کنند.

آیا فابریک داده و مجازیسازی داده یکسان هستند؟

خیر. در حالی که هر دو لایههای پنهانسازی ارائه میدهند که دسترسی به داده را ساده میکنند، در معماری و قابلیتهای پردازش به طور قابل توجهی متفاوت هستند. مجازیسازی داده عمدتاً بر دسترسی به داده در زمان پرسوجو بدون جابهجایی داده تمرکز دارد، در حالی که فابریک داده قابلیتهای گستردهتری از یکپارچگی، حاکمیت و اتوماسیون را شامل میشود که ممکن است جابهجایی و تحول فیزیکی داده را شامل شود.

آیا این معماریها میتوانند با هم کار کنند؟

بله. بسیاری از سازمانها با موفقیت این رویکردها را ترکیب میکنند تا از نقاط قوت هر کدام بهره ببرند. برای مثال، دریاچه داده میتواند به عنوان پایه ذخیرهسازی برای حوزههای شبکه داده عمل کند، در حالی که ابزارهای فابریک داده قابلیتهای یکپارچگی و حاکمیت را در سراسر پیادهسازیهای شبکه فراهم میکنند. این رویکردهای ترکیبی اغلب نتایج بهتری نسبت به استراتژیهای تکمعماری ارائه میدهند.

چگونه بدانم کدام معماری برای سازمان من مناسب است؟

انتخاب به بلوغ سازمانی، قابلیتهای فنی، الزامات حاکمیت داده و اهداف کسبوکاری شما بستگی دارد. عوامل مانند ساختار تیم، پیچیدگی داده، الزامات رعایت و منابع فنی موجود را در نظر بگیرید. بسیاری از سازمانها از شروع با یک رویکرد سود میبرند و به تدریج عناصر از دیگران را هنگام تکامل قابلیتها و نیازهایشان اضافه میکنند.

معماری ابر چه نقشی در این تصمیمات ایفا میکند؟

قابلیتهای ابر به طور قابل توجهی بر انتخابهای معماری تأثیر میگذارد. استراتژیهای چندابری اغلب رویکردهای فابریک داده را برای مدیریت یکپارچه ترجیح میدهند، در حالی که سازمانهای بومی ابر ممکن است شبکه داده را با معماریهای خدمات خرد همتراز بیابند. دریاچههای داده از اقتصاد ذخیرهسازی ابر و مقیاسپذیری سود میبرند، اما حاکمیت در محیطهای ابر توزیعشده پیچیدهتر میشود.