وقتی دادههای معیوب به طور خاموش مدلهای هوش مصنوعی و تصمیمگیریهای استراتژیک شما را فاسد میکنند، شما نه تنها با نادرستیها میجنگید—شما با بیاعتمادی سازمانی مبارزه میکنید. با بسیاری از سازمانها که اعتراف میکنند کاملاً به دادههای خود برای تصمیمگیری اعتماد ندارند و کیفیت داده همچنان چالش اصلی برای بسیاری از شرکتها باقی مانده است، عواقب فراتر از ناراحتی فنی میرود. پیشپردازش ضعیف نه تنها پروژهها را به تأخیر میاندازد—بلکه بنیان نوآوری مبتنی بر داده را که کسبوکارهای مدرن برای مزیت رقابتی به آن وابسته هستند، تضعیف میکند.

این راهنما فرآیند کامل پیشپردازش داده را گام به گام توضیح میدهد و تکنیکهای بنیادی و روششناسیهای پیشرفته را پوشش میدهد که چالشهای پیچیده داده امروز را برطرف میکنند. از مدیریت مشکلات کیفیت سنتی تا پیادهسازی چارچوبهای پیشرفته برای تطبیق واقعیزمان و حاکمیت، خواهید آموخت چگونه داده خام و آشفته را به داراییهای قابل اعتماد تبدیل کنید که تحلیلهای دقیق و مدلهای یادگیری ماشین قوی را قدرت میبخشند.

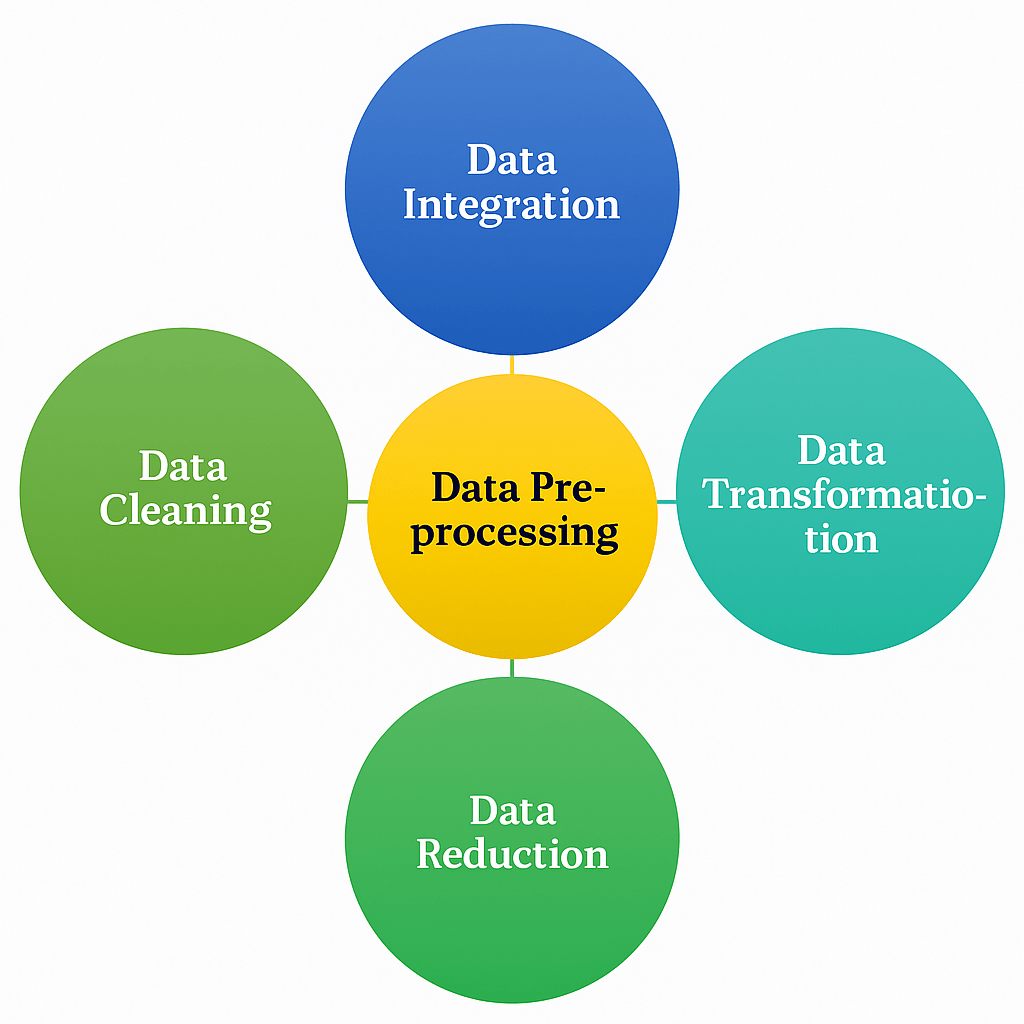

پیشپردازش داده چیست؟

پیشپردازش داده فاز بنیادی هر پایپلاین تحلیل داده یا یادگیری ماشین را نشان میدهد، جایی که داده خام تحت تحول سیستماتیک قرار میگیرد تا برای مدلسازی و تحلیل مناسب شود. این فرآیند حیاتی شامل پاکسازی، ساختاردهی و بهینهسازی داده است تا الگوریتمهای پاییندستی بتوانند الگوهای معنادار را استخراج کنند و بینشهای قابل اعتماد تولید کنند.

پیشپردازش داده مدرن فراتر از عملیات پاکسازی ساده به تکنیکهای پیچیده مانند تولید داده مصنوعی، مهندسی ویژگی خودکار و نظارت کیفیت واقعیزمان گسترش مییابد. این رویکردهای پیشرفته چالشهای معاصر مانند انطباق حریم خصوصی، نیازهای مقیاسپذیری و نیاز به تطبیق مداوم مدل در محیطهای پویا را برطرف میکنند.

فاز پیشپردازش مستقیماً بر عملکرد مدل تأثیر میگذارد، با مطالعاتی که نشان میدهند داده پیشپردازششده خوب میتواند دقت یادگیری ماشین را، گاهی به طور قابل توجهی، نسبت به مدلهای آموزشدیده روی داده خام بهبود بخشد. با این حال، درجه بهبود بسته به زمینه و مجموعه داده متفاوت است. این پیشپردازش را نه تنها یک گام مقدماتی، بلکه یک جزء استراتژیک میکند که موفقیت کل ابتکارات علم داده را تعیین میکند.

چرا پیشپردازش داده برای تحلیل مدرن حیاتی است؟

اهمیت پیشپردازش داده با ظهور تصمیمگیری خودکار و فرآیندهای کسبوکار تقویتشده با هوش مصنوعی شدت یافته است. سازمانها اکنون با پیچیدگی داده بیسابقه مواجه هستند، با اطلاعاتی که از منابع متنوع—شامل سنسورهای IoT، پلتفرمهای رسانه اجتماعی، برنامههای ابری و سیستمهای legacy—جریان مییابند، هر کدام با استانداردهای فرمتینگ و ویژگیهای کیفیت متمایز.

کیفیت داده ضعیف اثرات آبشاری در سراسر جریانهای کاری تحلیلی ایجاد میکند. وقتی گامهای پیشپردازش ناکافی باشند، مدلها به سمت بخشهای داده بیشازحد نمایندگیشده توسعه میدهند، الگوهای حیاتی در جمعیتهای کمنمونه را از دست میدهند و در سناریوهای واقعی تعمیم نمییابند. این به ویژه در صنایع تنظیمشده مانند بهداشت و درمان و مالی مشکلساز است، جایی که مدلها میتوانند منجر به نتایج تبعیضآمیز و تخلفات انطباق شوند.

مزایای کلیدی پیشپردازش داده جامع شامل موارد زیر است:

- کاهش نویز – خطاها و ناسازگاریها در مجموعه دادهها را حذف میکند، نویز را که با تشخیص الگو تداخل دارد کاهش میدهد و به الگوریتمها کمک میکند روابط واقعی را دقیقتر شناسایی کنند

- بهبود سازگاری مدل – انواع داده و فرمتهای ناهمگن را به نمایندگیهای استاندارد تبدیل میکند که الگوریتمهای یادگیری ماشین میتوانند به طور مؤثر پردازش کنند

- بهبود کارایی محاسباتی – ساختارهای داده را بهینه میکند و بعد را کاهش میدهد تا زمانهای آموزش را تسریع کند در حالی که عملکرد مدل حفظ میشود

- انطباق نظارتی – تحولات حفظ حریم خصوصی و مسیرهای audit را پیادهسازی میکند که نیازهای حاکمیت داده را در حوزههای قضایی برآورده میکند

پیشپردازش پیشرفته همچنین سازمانها را قادر میسازد تا از تولید داده مصنوعی برای افزایش مجموعه دادههای محدود استفاده کنند، چکهای کیفیت خودکار را پیادهسازی کنند که از رسیدن داده فاسد به مدلهای تولید جلوگیری میکند و ردیابی lineage را ایجاد کند که قابلیت تکرار و دیباگ را در سراسر چرخه حیات ML پشتیبانی میکند.

گامهای ضروری در پیشپردازش داده چیست؟

پیشپردازش داده مدرن هم گامهای بنیادی سنتی و هم تکنیکهای پیشرفته را در بر میگیرد که از اتوماسیون و بهینهسازی یادگیری ماشین بهره میبرند. این روشها به طور جمعی کیفیت داده، پیچیدگی یکپارچهسازی و نیازهای مقیاسپذیری را در محیطهای تحلیلی معاصر برطرف میکنند.

۱. یکپارچهسازی داده

یکپارچهسازی داده از الحاق ساده به تکنیکهای fusion پیچیده تکامل یافته است که روابط معنایی را در منابع ناهمگن حفظ میکند. رویکردهای یکپارچهسازی معاصر باید انواع داده چندمداله را مدیریت کنند، تعارضات schema را حل کنند و lineage داده را در طول فرآیند ترکیب حفظ کنند.

جریانهای کاری یکپارچهسازی مدرن معمولاً شامل پلتفرمهای بومی ابری هستند که streaming واقعیزمان را در کنار پردازش دستهای پشتیبانی میکنند و سازمانها را قادر میسازند داده را از سیستمهای عملیاتی، APIهای خارجی و آرشیوهای تاریخی یکپارچه کنند. این رویکرد ترکیبی پوشش جامع را تضمین میکند در حالی که تأخیر را برای تحلیلهای حساس به زمان به حداقل میرساند.

- پیوند رکورد – از الگوریتمهای تطبیق پیشرفته استفاده میکند که شباهت رشته، مدلسازی احتمالی و طبقهبندهای یادگیری ماشین را ترکیب میکند تا رکوردهایی را که به همان موجودیت در مجموعه دادهها اشاره دارند با دقت بالا شناسایی کند

- Fusion داده – اطلاعات را از چندین منبع با استفاده از استراتژیهای حل تعارض، وزندهی مبتنی بر کیفیت و تطبیق معنایی یکپارچه میکند تا مجموعه دادههای جامع و معتبر ایجاد کند

- هارمونیزاسیون schema – به طور خودکار ساختارهای داده ناهمگون را از طریق نگاشت معنایی و قوانین تحول همراستا میکند که معنا را حفظ میکند در حالی که پردازش یکپارچه را امکانپذیر میسازد

۲. تحول داده

تحول داده به اتوماسیون هوشمند و پردازش آگاه از زمینه تکامل یافته است که با ویژگیهای مجموعه داده و نیازهای مدل پاییندستی تطبیق مییابد. جریانهای کاری تحول مدرن از یادگیری ماشین برای بهینهسازی تصمیمات پیشپردازش استفاده میکنند و تضمین میکنند تحولات سیگنال پیشبینی را تقویت کنند نه تخریب.

رویکردهای پاکسازی معاصر از مدلهای یادگیری عمیق برای imputation پیچیده، روشهای ensemble برای تشخیص outlier و ارزیابی کیفیت خودکار که اثربخشی تحول را به طور مداوم نظارت میکند استفاده میکنند. این تکنیکها به طور قابل توجهی از روشهای مبتنی بر قانون سنتی، به ویژه برای مجموعه دادههای پیچیده با مشکلات کیفیت ظریف، بهتر عمل میکنند.

پاکسازی پیشرفته چندین حوزه کلیدی را در بر میگیرد:

- تشخیص outlier هوشمند – رویکردهای آماری مانند جنگلهای ایزوله را با قوانین خاص دامنه و تشخیصدهندههای ناهنجاری یادگیری ماشین ترکیب میکند تا outlierهای واقعی را از خطاهای ورود داده تمایز دهد

- Imputation مقدار گمشده آگاه از زمینه – از مدلهای مبتنی بر transformer و تکنیکهای چندمتغیره مانند MICE استفاده میکند که روابط ویژگی را بهرهبرداری میکنند نه جایگزینی آماری ساده

- حذف duplicate خودکار – از الگوریتمهای تطبیق fuzzy و خوشهبندی رکورد برای شناسایی near-duplicateها استفاده میکند که رویکردهای مبتنی بر hash ساده از دست میدهند

تکنیکهای تحول مدرن این بنیانها را گسترش میدهند:

- مقیاسبندی ویژگی تطبیقی – استراتژیهای نرمالسازی متفاوت را به زیرمجموعههای ویژگی بر اساس ویژگیهای توزیع اعمال میکند، سیگنال مهم را حفظ میکند در حالی که سازگاری الگوریتم را تضمین میکند

- رمزگذاری دستهای معنایی – از روابط هدف و ساختارهای سلسلهمراتبی در متغیرهای دستهای برای ایجاد رمزگذاریهایی که الگوهای معنادار را ضبط میکنند نه تخصیصهای دلخواه استفاده میکند

- گسستهسازی آگاه از توزیع – به طور خودکار استراتژیهای binning بهینه را برای متغیرهای پیوسته با استفاده از کاهش entropy و اندازهگیریهای gain اطلاعات تعیین میکند

۳. کاهش داده

استراتژیهای کاهش داده اکنون تکنیکهای یادگیری ماشین پیچیده را در بر میگیرند که اطلاعات پیشبینی را حفظ میکنند در حالی که نیازهای محاسباتی را به طور چشمگیری کاهش میدهند. رویکردهای کاهش مدرن برای کارایی ذخیره و عملکرد مدل بهینهسازی میشوند و تضمین میکنند کاهش بعد نتایج تحلیلی را تقویت کند نه تخریب.

روشهای کاهش معاصر مهندسی ویژگی خودکار را با کاهش بعد سنتی یکپارچه میکنند و رویکردهای ترکیبی ایجاد میکنند که ویژگیهای پیشبینی جدید تولید میکنند در حالی که اطلاعات redundant را حذف میکنند. این استراتژی دوگانه چگالی اطلاعات را در مجموعه داده نهایی به حداکثر میرساند.

- کاهش بعد هوشمند – تحلیل مؤلفههای اصلی را با شبکههای عصبی autoencoder و تکنیکهای یادگیری manifold ترکیب میکند تا روابط غیرخطی را ضبط کند در حالی که فضای ویژگی را کاهش میدهد

- انتخاب ویژگی خودکار – از روشهای ensemble، حذف ویژگی بازگشتی و اندازهگیریهای اطلاعات متقابل برای شناسایی زیرمجموعههای ویژگی بهینه بر اساس مشارکت پیشبینی نه اندازهگیریهای همبستگی ساده استفاده میکند

- نمونهبرداری تطبیقی – از استراتژیهای نمونهبرداری stratified و مبتنی بر اهمیت استفاده میکند که ویژگیهای مجموعه داده را حفظ میکند در حالی که اندازه را کاهش میدهد—به ویژه برای مجموعه دادههای بزرگمقیاس که پردازش کامل از نظر محاسباتی ممنوع است

چارچوبهای کاهش پیشرفته اکنون بهینهسازی iterative را پشتیبانی میکنند جایی که انتخاب ویژگی و آموزش مدل به طور مشترک رخ میدهد و تضمین میکند تصمیمات کاهش عملکرد مدل نهایی را تقویت کند نه صرفاً به حداقل رساندن اندازه مجموعه داده.

ردیابی منشأ و lineage داده چگونه کیفیت پیشپردازش را تقویت میکند؟

منشأ داده و ردیابی lineage به اجزای ضروری جریانهای کاری پیشپردازش مدرن تبدیل شدهاند و شفافیت و پاسخگویی را ارائه میدهند که چارچوبهای نظارتی روزافزون مطالبه میکنند. این قابلیتها تاریخچه تحول کامل مجموعه دادهها را مستند میکنند و سازمانها را قادر میسازند اصالت داده را تأیید کنند، خطاهای پردازش را دیباگ کنند و انطباق با نیازهای حاکمیت را حفظ کنند.

سیستمهای منشأ metadata در مورد منشأ داده، گامهای تحول و نقاط چک کیفیت را در سراسر پایپلاین پیشپردازش ضبط میکنند. این مستندسازی وقتی مدلها رفتار غیرمنتظره نشان میدهند یا وقتی auditorها نیاز به شواهد روشهای مدیریت داده دارند بسیار ارزشمند است. چارچوبهای منشأ پیشرفته به طور خودکار مسیرهای audit تولید میکنند بدون نیاز به مستندسازی دستی، سربار انطباق را کاهش میدهند در حالی که قابلیت اطمینان فرآیند را بهبود میبخشند.

ردیابی lineage مدرن فراتر از مستندسازی جریان کاری ساده به قابلیتهای تحلیل تأثیر گسترش مییابد. وقتی داده منبع تغییر میکند یا منطق پیشپردازش نیاز به بهروزرسانی دارد، سیستمهای lineage میتوانند به طور خودکار تمام آرتیفکتهای پاییندستی را که نیاز به بازتولید دارند شناسایی کنند. این نگاشت وابستگی ناسازگاریها را جلوگیری میکند و تضمین میکند مجموعه دادههای آموزش مدل با سیستمهای منبع همگام بمانند.

رویکردهای پیادهسازی از پایگاههای داده گراف و پلتفرمهای مدیریت metadata استفاده میکنند که روابط بین مجموعه دادهها، گامهای تحول و آرتیفکتهای خروجی را ضبط میکنند. این سیستمها هم استخراج metadata خودکار از چارچوبهای پردازش و هم یادداشت دستی برای زمینه کسبوکار را که سیستمهای خودکار نمیتوانند ضبط کنند پشتیبانی میکنند.

مزایای کلیدی شامل تحلیل علت ریشه سریع وقتی مشکلات کیفیت داده ظاهر میشوند، گزارشدهی انطباق خودکار که بار نظارتی را کاهش میدهد و تضمینهای قابلیت تکرار که استقرار مدل قابل اعتماد را در محیطها امکانپذیر میکند. سازمانهایی که ردیابی lineage جامع پیادهسازی میکنند زمانهای دیباگ به طور قابل توجهی سریعتر و اعتماد ذینفعان به طور چشمگیر بهبودیافته در خروجیهای تحلیلی گزارش میدهند.

نظارت بر drift چه نقشی در پیشپردازش داده واقعیزمان ایفا میکند؟

نظارت بر drift داده به عنوان یک قابلیت حیاتی برای حفظ اثربخشی پیشپردازش در محیطهای تولید ظاهر شده است جایی که ویژگیهای داده به طور مداوم تکامل مییابند. برخلاف سناریوهای پردازش دستهای سنتی، پیشپردازش واقعیزمان باید بدون مداخله انسانی به توزیعهای در حال تغییر، الگوهای نوظهور و زمینههای کسبوکار در حال تغییر تطبیق یابد.

سیستمهای تشخیص drift به طور مداوم جریانهای داده ورودی را با توزیعهای پایه ایجادشده در طول طراحی پیشپردازش اولیه مقایسه میکنند. وقتی اندازهگیریهای آماری مانند تستهای Kolmogorov-Smirnov یا واگرایی Jensen-Shannon تغییرات توزیع قابل توجه را نشان میدهند، سیستمهای خودکار میتوانند بهروزرسانی پارامترهای پیشپردازش، بازآموزی مدل یا جریانهای کاری هشدار کیفیت را برای حفظ اثربخشی سیستم فعال کنند.

چارچوبهای نظارت پیشرفته انواع مختلف drift را برای پاسخهای مناسب تمایز میدهند. drift covariate توزیعهای ویژگی را تحت تأثیر قرار میدهد و ممکن است نیاز به تنظیمات پارامتر مقیاسبندی داشته باشد، در حالی که drift مفهومی رابطه بین ویژگیها و متغیرهای هدف را تغییر میدهد و ممکن است نیاز به بازنگری کامل پایپلاین پیشپردازش داشته باشد. drift برچسب تغییرات در توزیعهای متغیر هدف را نشان میدهد که ممکن است نیاز به تغییرات استراتژی نمونهبرداری داشته باشد.

قابلیتهای تطبیق واقعیزمان سیستمهای پیشپردازش را قادر میسازند پارامترها را به طور پویا بر اساس الگوهای drift مشاهدهشده تنظیم کنند. برای مثال، پارامترهای نرمالسازی میتوانند به طور افزایشی با استفاده از آمار streaming بهروزرسانی شوند، در حالی که استراتژیهای imputation میتوانند وقتی الگوهای مقدار گمشده تغییر میکنند اصلاح شوند. این رویکردهای تطبیقی اثربخشی پیشپردازش را بدون نیاز به بازتولید کامل پایپلاین حفظ میکنند.

پیادهسازی معمولاً شامل استقرار عوامل نظارت سبک در کنار سیستمهای پیشپردازش تولید، با آستانههای هشدار قابل پیکربندی است که حساسیت را در برابر نرخهای هشدار کاذب متعادل میکند. پلتفرمهای بومی ابری اکنون خدمات تشخیص drift مدیریتشده ارائه میدهند که به طور یکپارچه با جریانهای کاری پیشپردازش موجود یکپارچه میشوند، پیچیدگی عملیاتی را کاهش میدهند در حالی که پوشش جامع را تضمین میکنند.

سازمانهایی که از نظارت drift خودکار استفاده میکنند زمانهای پاسخ سریعتر به تخریب کیفیت داده و قابلیت اطمینان مدل به طور قابل توجهی بهبودیافته در محیطهای کسبوکار پویا گزارش میدهند. قابلیتهای تشخیص و تطبیق proactive از تخریب عملکرد قبل از تأثیر بر نتایج کسبوکار جلوگیری میکند و drift را از یک مشکل واکنشی به یک ملاحظه عملیاتی مدیریتشده تبدیل میکند.

نتیجهگیری

پیشپردازش داده به عنوان بنیان تحلیلهای قابل اعتماد و سیستمهای یادگیری ماشین قوی عمل میکند و مستقیماً کیفیت و قابلیت اعتماد بینشهای پاییندستی را تعیین میکند. با پیادهسازی جریانهای کاری پیشپردازش جامع که تکنیکهای سنتی را با رویکردهای مدرن—مانند نظارت کیفیت خودکار، تولید داده مصنوعی و قابلیتهای تطبیق واقعیزمان—ترکیب میکنند، سازمانها میتوانند داده خام را به داراییهای استراتژیک تبدیل کنند که مزیت رقابتی را هدایت میکنند.

تکامل از عملیات پاکسازی پایه به سیستمهای پیشپردازش هوشمند و خودکار بازتاب پیچیدگی رو به رشد محیطهای داده مدرن و اهمیت فزاینده تصمیمگیری مبتنی بر داده است. همانطور که سازمانها قابلیتهای تحلیلی خود را گسترش میدهند و با نیازهای نظارتی فزاینده مواجه میشوند، سرمایهگذاری در زیرساخت پیشپردازش پیچیده برای حفظ هم کارایی عملیاتی و هم استانداردهای انطباق ضروری میشود.

موفقیت در پیشپردازش داده معاصر نیاز به پذیرش هم اصول بنیادی و هم فناوریهای نوظهور دارد و تضمین میکند جریانهای کاری تحول داده شما میتوانند با نیازهای کسبوکار در حال تحول تطبیق یابند در حالی که قابلیت اطمینان و شفافیت مورد تقاضای ذینفعان را حفظ کنند.

سؤالات متداول

شایعترین چالشهای پیشپردازش داده چیست؟

شایعترین چالشهای پیشپردازش داده شامل مدیریت مقادیر گمشده، تشخیص و اصلاح outlierها، مدیریت فرمتهای داده ناسازگار در چندین منبع، مدیریت رکوردهای duplicate، و تضمین کیفیت داده در مقیاس است. سازمانهای مدرن همچنین با نیازهای پیشپردازش واقعیزمان، حفظ lineage داده، و پیادهسازی تحولات حفظ حریم خصوصی برای برآورده کردن استانداردهای انطباق نظارتی چالشهایی مواجه هستند.

پیشپردازش داده معمولاً چقدر طول میکشد؟

پیشپردازش داده معمولاً ۶۰-۸۰٪ از زمان کل صرفشده در پروژههای علم داده را مصرف میکند. مدت زمان به طور قابل توجهی بر اساس پیچیدگی داده، تنوع منبع، و نیازهای کیفیت متفاوت است. مجموعه دادههای ساده با مشکلات کیفیت حداقل ممکن است تنها ساعتها یا روزها پیشپردازش نیاز داشته باشند، در حالی که مجموعه دادههای سازمانی پیچیده با چندین منبع، مشکلات کیفیت، و نیازهای حاکمیت سخت میتوانند هفتهها یا ماهها برای پیشپردازش مناسب نیاز داشته باشند.

بهترین ابزارها برای پیشپردازش داده چیست؟

بهترین ابزارهای پیشپردازش داده به نیازهای خاص و محیط فنی شما بستگی دارد. گزینههای محبوب شامل کتابخانههای پایتون مانند pandas، scikit-learn، و PyAirbyte برای پیشپردازش برنامهریزیشده، پلتفرمهای بومی ابری مانند Airbyte برای یکپارچهسازی و تحول داده خودکار، و راهحلهای سازمانی که رابطهای بصری را در کنار قابلیتهای اتوماسیون پیشرفته ارائه میدهند. سازمانهای مدرن اغلب از رویکردهای ترکیبی استفاده میکنند که چندین ابزار را برای برطرف کردن نیازهای پیشپردازش متفاوت ترکیب میکنند.

چگونه میدانید پیشپردازش داده شما مؤثر است؟

پیشپردازش داده مؤثر را میتوان از طریق چندین شاخص کلیدی اندازهگیری کرد: متریکهای عملکرد مدل بهبودیافته، زمان آموزش کاهشیافته، مشکلات کیفیت داده کاهشیافته در فرآیندهای پاییندستی، و قابلیت تکرار بهبودیافته در محیطهای مختلف. پیادهسازی نظارت کیفیت خودکار، تشخیص drift، و چارچوبهای تست جامع به اعتبارسنجی اثربخشی پیشپردازش کمک میکند و نتایج مداوم را در طول زمان تضمین میکند.

تفاوت بین پاکسازی داده و پیشپردازش داده چیست؟

پاکسازی داده به طور خاص بر شناسایی و اصلاح خطاها، ناسازگاریها، و مشکلات کیفیت در مجموعه دادهها تمرکز دارد، مانند حذف duplicateها، اصلاح خطاهای فرمتینگ، و مدیریت مقادیر گمشده. پیشپردازش داده یک مفهوم گستردهتر است که پاکسازی داده را به همراه فعالیتهای تحول، یکپارچهسازی، کاهش، و بهینهسازی که داده را برای اهداف تحلیلی یا یادگیری ماشین خاص آماده میکند در بر میگیرد.

آیا پیشپردازش داده باید خودکار شود؟ پیشپردازش داده باید جایی که ممکن است اتوماسیون را در بر بگیرد تا ثبات را بهبود بخشد، تلاش دستی.

پیشپردازش مبتنی بر ابر چگونه با راهحلهای on-premises مقایسه میشود؟

پیشپردازش مبتنی بر ابر مزایایی در مقیاسپذیری، بهروزرسانیهای خودکار، و سربار مدیریت زیرساخت کاهشیافته ارائه میدهد، در حالی که راهحلهای on-premises کنترل بیشتر بر حاکمیت داده و امنیت ارائه میدهند. رویکردهای ترکیبی مدرن، مانند آنهایی که توسط پلتفرمهایی مانند Airbyte ارائه میشوند، کارایی بومی ابری را با گزینههای استقرار انعطافپذیر ترکیب میکنند که نیازهای ابری و on-premises را بر اساس نیازهای سازمانی خاص و نیازهای انطباق پشتیبانی میکنند.