راهنمای عملی یکپارچهسازی CUDA

نکات کلیدی

در حالی که Java برای CUDA طراحی نشده است، اما یکپارچهسازی این دو کاملاً امکانپذیر است. انجام این کار میتواند برای برخی بارهای کاری، افزایش عملکردی بین ده تا صد برابر ایجاد کند.

JNI یک پل تمیز و قابلاستفاده مجدد بین Java و کد بومی CUDA فراهم میکند تا وظایف محاسباتی سنگین مانند رمزنگاری، تحلیل داده و استنتاج به GPU منتقل شوند.

انتخاب میان همزمانی، چندنخی و موازیسازی واقعی حیاتی است. CUDA امکان مقیاسپذیری فراتر از محدودیتهای مبتنی بر نخ در Java را فراهم میکند.

شتابدهی GPU اکنون میتواند با استفاده از گردشکارهای کانتینری و الگوهای JNI ایمن از نظر حافظه، بهصورت ایمن در سیستمهای سازمانی مستقر شود.

محاسبات GPU محدود به هوش مصنوعی نیستند؛ چالشهای روزمره بکاند مانند پردازش امن دادهها نیز میتوانند از اجرای موازی در مقیاس بالا بهره ببرند.

مقدمه

در دنیای نرمافزارهای سازمانی، Java به دلیل قابلیت اطمینان، قابلیت حمل و اکوسیستم غنی خود همچنان یک انتخاب غالب است.

با این حال، زمانی که صحبت از محاسبات با کارایی بالا (HPC) یا عملیات دادهمحور سنگین به میان میآید، محیط اجرایی مدیریتشده Java و سربار جمعآوری زباله (Garbage Collection) چالشهایی را در پاسخگویی به نیازهای تأخیر کم و توان عملیاتی بالای برنامههای مدرن ایجاد میکند؛ بهویژه در کاربردهایی مانند تحلیل بلادرنگ، پایپلاینهای عظیم لاگ یا محاسبات عمیق.

در همین حال، واحدهای پردازش گرافیکی (GPU) که در ابتدا برای رندر تصاویر طراحی شده بودند، به شتابدهندههایی عملی برای محاسبات موازی تبدیل شدهاند.

فناوریهایی مانند CUDA به توسعهدهندگان اجازه میدهند از تمام توان GPUها استفاده کنند و شتاب قابلتوجهی در وظایف محاسباتی سنگین به دست آورند.

اما یک نکته وجود دارد: CUDA در درجه اول برای C و C++ طراحی شده است، مسیری که توسعهدهندگان Java بهندرت به آن وارد میشوند، آن هم به دلیل چالشهای یکپارچهسازی. این مقاله دقیقاً برای پر کردن همین شکاف نوشته شده است.

در این مقاله بررسی میکنیم:

-

شتابدهی در سطح GPU برای برنامههای Java چه معنایی دارد

-

تفاوت مدلهای همزمانی و اینکه چرا CUDA اهمیت دارد

-

روشهای عملی یکپارچهسازی CUDA با Java (مانند JCuda، JNI و غیره)

-

یک نمونه عملی همراه با بنچمارکهای عملکرد

-

بهترین رویهها برای آمادگی در سطح سازمانی

چه یک مهندس متمرکز بر عملکرد باشید و چه یک معمار Java که به دنبال روشهای مقیاسپذیری نسل بعدی است، این راهنما برای شما نوشته شده است.

درک مفاهیم پایه: چندنخی، همزمانی، موازیسازی و چندپردازشی

پیش از ورود به بحث یکپارچهسازی GPU، لازم است مدلهای مختلف اجرای برنامه که توسعهدهندگان Java معمولاً از آنها استفاده میکنند را بهوضوح درک کنیم. این مفاهیم اغلب بهجای هم به کار میروند، اما معانی متفاوتی دارند. شناخت مرزهای آنها کمک میکند درک کنیم شتابدهی مبتنی بر CUDA دقیقاً کجا میدرخشد.

چندنخی (Multithreading)

چندنخی به توانایی یک CPU (یا یک فرایند واحد) برای اجرای همزمان چند نخ در یک فضای حافظه مشترک اشاره دارد. در Java، این کار معمولاً با استفاده از کلاسهای Thread و Runnable یا سازوکارهای پیشرفتهتری مانند ExecutorService انجام میشود.

مزیت چندنخی این است که نخها سبک هستند و بهسرعت راهاندازی میشوند. با این حال، محدودیتهایی وجود دارد، زیرا تمام نخها از یک heap حافظه مشترک استفاده میکنند که میتواند به مشکلاتی مانند شرایط رقابتی (race condition)، بنبست (deadlock) و رقابت بین نخها منجر شود.

همزمانی (Concurrency)

همزمانی به مدیریت چند وظیفه به شکلی اشاره دارد که به آنها اجازه میدهد در طول زمان پیشرفت کنند؛ چه بهصورت درهمتنیده روی یک هسته و چه بهصورت موازی روی چند هسته.

به همزمانی میتوان بهعنوان زمانبندی اجرای وظایف نگاه کرد، نه انجام همه چیز بهصورت همزمان. Java با بستههایی مانند java.util.concurrent پشتیبانی قدرتمندی از همزمانی ارائه میدهد.

موازیسازی (Parallelism)

موازیسازی به اجرای واقعی و همزمان چند وظیفه اشاره دارد، در تضاد با همزمانی که ممکن است شامل اجرای نوبتی باشد. موازیسازی واقعی نیازمند پشتیبانی سختافزاری مانند چند هسته CPU یا واحدهای اجرایی متعدد است.

در حالی که بسیاری از توسعهدهندگان نخها را با افزایش عملکرد برابر میدانند، افزایش واقعی سرعت به میزان مؤثر بودن موازیسازی وظایف بستگی دارد. Java ابزارهایی مانند چارچوب Fork/Join را فراهم میکند، اما موازیسازی مبتنی بر CPU در نهایت به تعداد هستهها و سربار تعویض زمینه محدود میشود.

چندپردازشی (Multiprocessing)

چندپردازشی شامل اجرای چند فرایند مجزا است که هرکدام فضای حافظه مخصوص به خود را دارند و میتوانند بهصورت موازی روی هستههای مختلف CPU اجرا شوند. این روش نسبت به چندنخی ایزولهتر و پایدارتر است، اما سربار بیشتری دارد.

در Java، چندپردازشی واقعی معمولاً به معنی اجرای JVMهای جداگانه یا واگذاری کار به میکروسرویسها است.

CUDA دقیقاً کجای این تصویر قرار میگیرد؟

تمام مدلهای بالا بهشدت به هستههای CPU متکی هستند که تعداد آنها معمولاً به چند ده عدد محدود میشود. در مقابل، GPUها میتوانند هزاران نخ سبک را بهصورت موازی اجرا کنند.

CUDA امکان دسترسی به این مدل اجرای دادهمحور عظیم را فراهم میکند؛ مدلی که برای وظایفی مانند عملیات ماتریسی، پردازش تصویر، تبدیل یا ماسککردن انبوه لاگها و تحلیل بلادرنگ دادهها ایدهآل است.

این نوع موازیسازی ریزدانه در سطح داده، تقریباً با چندنخی استاندارد Java قابل دستیابی نیست و دقیقاً همینجاست که CUDA ارزش واقعی خود را نشان میدهد.

CUDA و Java – چشمانداز کلی

توسعهدهندگان Java بهطور سنتی در دنیای امن و مدیریتشده JVM فعالیت میکنند؛ دنیایی دور از دغدغههای بهینهسازی در سطح سختافزار. در مقابل، CUDA در جهانی کاملاً متفاوت زندگی میکند؛ جایی که عملکرد از طریق مدیریت دقیق حافظه، اجرای هزاران نخ و بهینهسازی استفاده از GPU استخراج میشود.

پس این دو دنیا چگونه به هم میرسند؟

CUDA چیست؟

CUDA یا Compute Unified Device Architecture پلتفرم محاسبات موازی و مدل API شرکت NVIDIA است که به توسعهدهندگان اجازه میدهد نرمافزارهایی برای اجرای موازی انبوه روی GPUهای NVIDIA بنویسند. این فناوری معمولاً از طریق C یا C++ استفاده میشود، جایی که کرنلها نوشته میشوند؛ توابعی که بهصورت موازی روی GPU اجرا میشوند.

CUDA در این حوزهها میدرخشد:

-

بارهای کاری دادهمحور (مانند پردازش تصویر، شبیهسازیهای مالی، تبدیل لاگها)

-

موازیسازی ریزدانه با هزاران نخ

-

افزایش چشمگیر سرعت در عملیات محاسبهمحور

چرا Java بهصورت بومی با CUDA سازگار نیست؟

Java پشتیبانی بومی از CUDA ندارد، زیرا:

-

JVM دسترسی مستقیم به حافظه GPU یا پایپلاینهای اجرایی آن ندارد

-

بیشتر کتابخانههای Java بر اساس CPU و همزمانی مبتنی بر نخ طراحی شدهاند

-

مدیریت حافظه Java (چرخه عمر اشیا و Garbage Collection) با GPU سازگار نیست

با این حال، با ابزارها و معماری مناسب، میتوان پلی میان Java و CUDA ایجاد کرد و از شتابدهی GPU در نقاط کلیدی بهره برد.

گزینههای موجود برای یکپارچهسازی

روشهای مختلفی برای افزودن شتابدهی GPU به Java وجود دارد که هرکدام مزایا و معایب خود را دارند.

JCuda یک اتصال مستقیم Java به CUDA است که هم APIهای سطح پایین و هم抽象هایی مانند Pointer و CUfunction را ارائه میدهد. این ابزار برای نمونهسازی و آزمایش بسیار مناسب است، اما مدیریت دستی حافظه میتواند استفاده از آن را در محیطهای تولیدی محدود کند.

Java Native Interface یا JNI کنترل بیشتر و معمولاً عملکرد بهتری فراهم میکند و اجازه میدهد کرنلهای CUDA را در C++ بنویسید و آنها را در اختیار Java قرار دهید. اگرچه کدنویسی آن پرجزئیاتتر است، اما برای یکپارچهسازی در سطح سازمانی که پایداری و کنترل منابع اهمیت دارد، گزینهای ترجیحی محسوب میشود.

Java Native Access یا JNA گزینهای سادهتر و کمحجمتر نسبت به JNI است، اما همیشه عملکرد یا انعطافپذیری لازم برای بارهای کاری سبک CUDA را ارائه نمیدهد.

ابزارهای نوظهوری مانند TornadoVM، Rootbeer و Aparapi نیز وجود دارند که شتابدهی GPU را از طریق Java ممکن میکنند. این ابزارها بیشتر برای تحقیق و آزمایش مناسب هستند و معمولاً برای استفاده در مقیاس تولید توصیه نمیشوند.

الگوهای عملی یکپارچهسازی – فراخوانی CUDA از Java

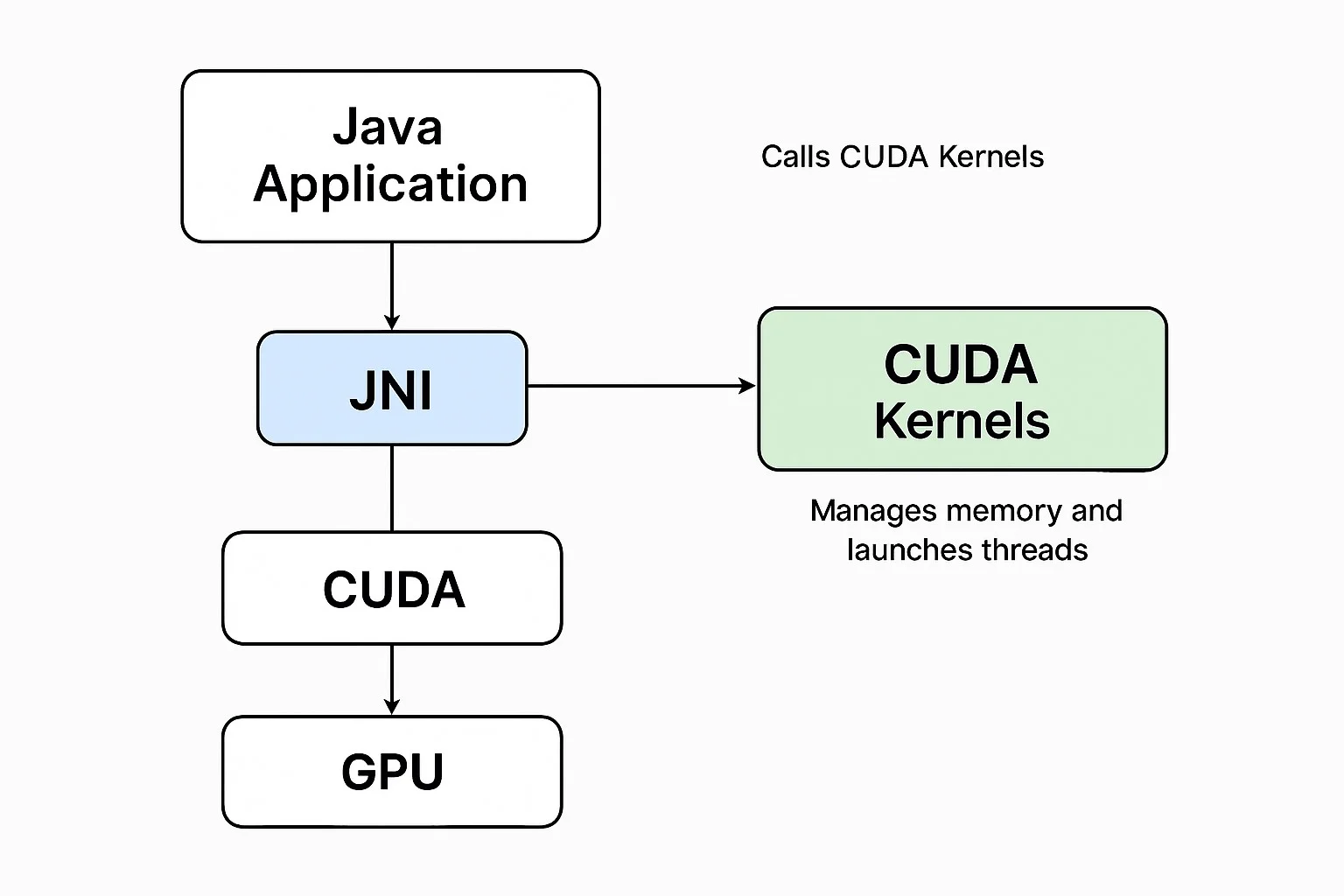

اکنون که معماری کلی را میشناسیم، بیایید ببینیم اجزای مختلف در عمل چگونه با هم کار میکنند.

برای درک بهتر تعامل Java و CUDA در زمان اجرا، اجزای کلیدی و جریان داده آنها بهصورت مفهومی در نظر گرفته میشوند.

لایه برنامه Java

این لایه همان سرویس Java استاندارد شماست؛ ممکن است یک فریمورک لاگگیری، پایپلاین تحلیلی یا هر ماژول سازمانی با توان عملیاتی بالا باشد. بهجای اتکا صرف به thread poolها یا چارچوب Fork/Join، وظایف محاسباتی سنگین از طریق فراخوانیهای بومی به GPU واگذار میشوند.

در این لایه، Java مسئول آمادهسازی دادههای ورودی، فراخوانی JNI به بکاند بومی و ادغام نتایج در جریان اصلی برنامه است. برای مثال، میتوان رمزنگاری در سطح SSH یا هشکردن امن کلیدها برای هزاران نشست کاربری در ثانیه را به GPU سپرد و CPU را برای I/O و هماهنگی آزاد گذاشت.

پل JNI

JNI بهعنوان پل ارتباطی بین Java و کد بومی C++ عمل میکند که منطق CUDA در آن قرار دارد. این لایه مسئول تعریف متدهای بومی، بارگذاری کتابخانههای اشتراکی (.so یا .dll) و انتقال حافظه بین heap جاوا و بافرهای بومی است.

مدیریت حافظه و تبدیل نوع دادهها باید با دقت انجام شود، زیرا اشتباه در این بخش میتواند به خطاهای جدی مانند segmentation fault یا نشت حافظه منجر شود. برنامهنویسی دفاعی و پاکسازی منابع در این لایه حیاتی است.

کرنلهای CUDA (C/C++)

اینجاست که جادوی موازیسازی اتفاق میافتد. کرنلهای CUDA توابعی سبک هستند که برای اجرا روی هزاران نخ GPU بهصورت همزمان طراحی شدهاند. این کرنلها در فایلهای .cu نوشته میشوند و با نحو <<<blocks, threads>>> اجرا میشوند.

هر کرنل روی بافرهای ارسالشده از لایه JNI کار میکند و عملیات موازی عظیمی مانند رمزنگاری رشتهها، هشکردن آرایههای بایت یا تبدیل ماتریسی را انجام میدهد.

اجرای GPU

پس از اجرای کرنل، CUDA زمانبندی نخها، پنهانسازی تأخیر حافظه و همگامسازی پایه را مدیریت میکند. با این حال، بهینهسازی عملکرد همچنان نیازمند بنچمارکگیری و تنظیم دقیق پیکربندی کرنل است.

توسعهدهندگان Java باید به اندازه بلاکها، تعداد نخها، کاهش انتقال حافظه و مدیریت خطا از طریق APIهایی مانند cudaGetLastError توجه ویژه داشته باشند.

بازگشت نتایج

پس از پایان پردازش، نتایج به لایه JNI بازگردانده شده و سپس در اختیار برنامه Java قرار میگیرند تا ذخیره، ارسال یا نمایش داده شوند.

خلاصه مراحل یکپارچهسازی

-

نوشتن کرنلهای CUDA

-

ایجاد لایه C/C++ برای اتصال به JNI

-

کامپایل با nvcc و تولید فایل .so یا .dll

-

تعریف متدهای بومی در Java و بارگذاری کتابخانه

-

مدیریت تمیز ورودی، خروجی و خطاها بین Java و کد بومی

مورد استفاده سازمانی – رمزنگاری انبوه داده با Java و CUDA

برای نشاندادن اثر شتابدهی GPU در محیط Java، یک سناریوی عملی سازمانی را بررسی میکنیم: رمزنگاری انبوه دادهها در مقیاس بالا.

سیستمهای بکاند بهطور مداوم با دادههای حساس مانند اطلاعات کاربری، توکنهای نشست و کلیدهای API سروکار دارند که باید با توان عملیاتی بالا رمزنگاری یا هش شوند.

روشهای سنتی مبتنی بر CPU در Java، مانند javax.crypto یا Bouncy Castle، در حجمهای بسیار بالا با محدودیت مواجه میشوند. اینجاست که موازیسازی مبتنی بر CUDA مزیت خود را نشان میدهد.

GPUها برای این نوع بار کاری بسیار مناسب هستند، زیرا منطق رمزنگاری بدون حالت، یکنواخت و کاملاً قابل موازیسازی است. در برخی سناریوها، کاهش تأخیر تا پنجاه برابر نسبت به پیادهسازی تکنخی Java مشاهده شده است.

مقایسه عملکرد

| روش | توان عملیاتی (ورودی در ثانیه) | توضیحات |

|---|---|---|

| Java + Bouncy Castle | ~۲۰٬۰۰۰ | خط پایه تکنخی |

| Java + ExecutorService | ~۸۰٬۰۰۰ | موازیسازی روی CPU هشتهستهای |

| Java + CUDA (از طریق JNI) | ~۱٫۵ میلیون | ۳٬۰۰۰ نخ CUDA |

توجه: این اعداد صرفاً برای نمایش هستند و نتایج واقعی به سختافزار و تنظیمات بستگی دارند.

بهترین رویهها و چالشها – آمادهسازی برای محیط تولید

یکپارچهسازی Java و CUDA سطح جدیدی از عملکرد را باز میکند، اما پیچیدگی هم به همراه دارد. مدیریت حافظه، ایمنی نخها، تست کد بومی، امنیت و استقرار از موارد حیاتی هستند که باید با دقت مدیریت شوند.

استفاده از کانتینرها، مدیریت دستی حافظه GPU، تست ماژولار کرنلها و همترازی نسخههای CUDA در محیط توسعه و تولید از الزامات این مسیر است.

جمعبندی نهایی

ترکیب Java و CUDA شاید رایج نباشد، اما در دستان درست، سطح کاملاً جدیدی از عملکرد را برای سیستمهای سازمانی فراهم میکند. با درک صحیح مفاهیم همزمانی و استفاده از الگوهای درست یکپارچهسازی، میتوان از محدودیتهای JVM عبور کرد و محاسباتی در سطح HPC را به سیستمهای Java اضافه نمود، بدون بازنویسی کل معماری.