مقدمه

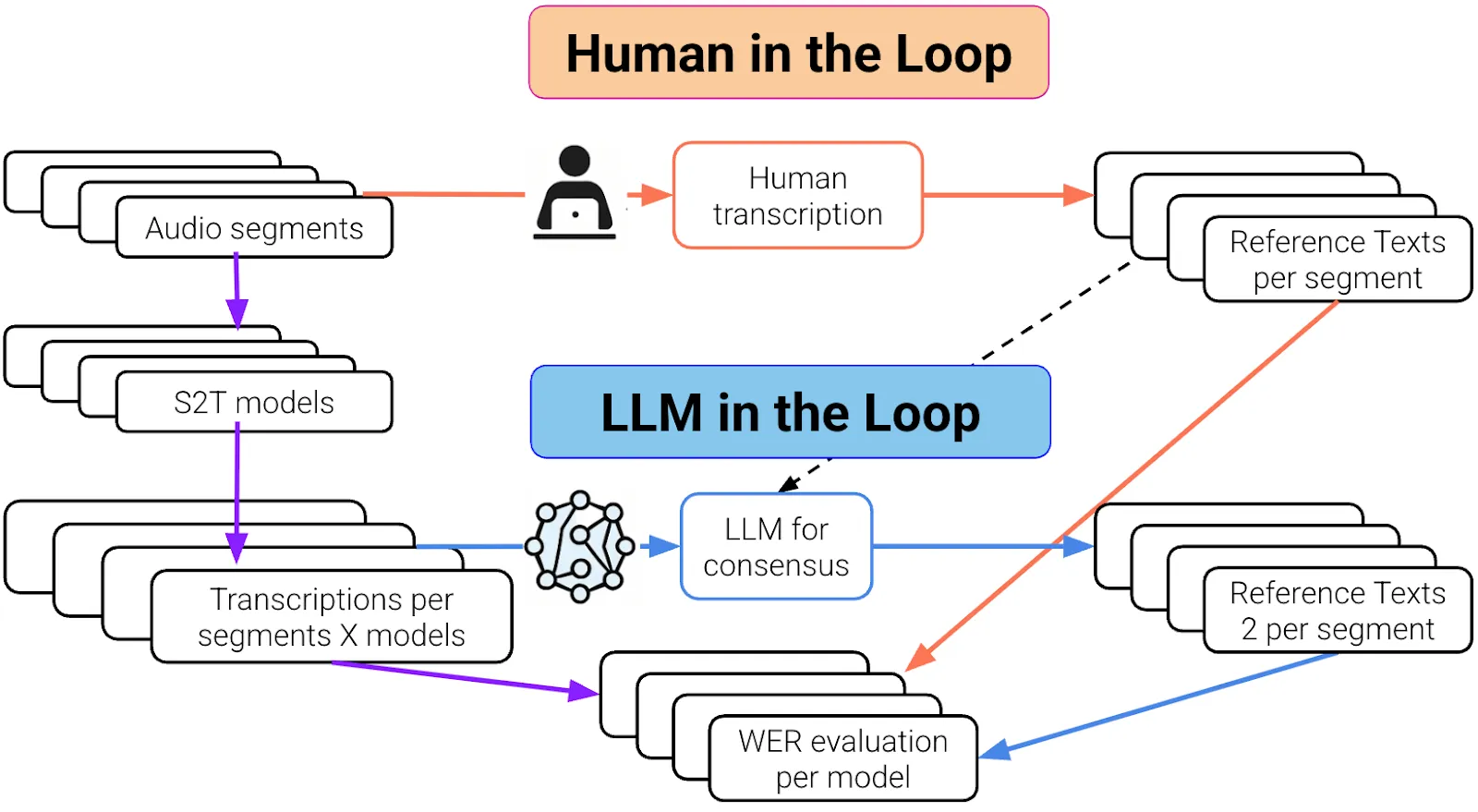

در هوش مصنوعی، ایجاد تعادل میان نظارت انسانی («انسان در حلقه») و خودکارسازی («LLM در حلقه») برای ساخت راهکارهای واقعی و قابل اتکا حیاتی است.

برای عبور از محدودیتهای بنچمارکگیری سنتی، رویکرد جدیدی توسعه داده شد که در آن از مدلهای زبانی بزرگ (LLM) برای تولید رونویسیهای مرجع باکیفیت استفاده میشود؛ این کار با پردازش خروجی چند ارائهدهنده STT انجام میگیرد. بهجای تکیه بر مراجع تولیدشده توسط انسان یا یک «حقیقت زمینی» واحد، LLM با استفاده از درک خود از زبان و زمینه در میان ورودیها، یک رونویسیِ اجماعی (consensus) را ترکیب و تولید میکند.

این مرجعِ استخراجشده از LLM امکان محاسبه مقیاسپذیر، بدونسوگیری و زمینهمحورِ نرخ خطای کلمه (WER) را برای هر ارائهدهنده فراهم میکند.

در این مطلب توضیح داده میشود این روش مبتنی بر LLM چگونه با بنچمارکگیری سنتی مقایسه میشود، با تمرکز بر موارد زیر:

-

محدودیتهای روشهای فعلی بنچمارکگیری

-

اینکه LLMها چگونه رونویسیهای مرجع را ترکیب میکنند

-

یافتههای کلیدی از آزمایشها

روش موجود: برچسبزنهای انسانی برای «حقیقت زمینی»

چند سال پیش، زمانی که مدلهای STT برای گویشهای مختلف موجود در فایلهای صوتی مرکز تماس مشتریان فاینتیون میشدند، اتکا به حاشیهنویسها و annotatorهای انسانی برای رونویسی بخشهای کوتاه صوتی بسیار زیاد بود. این رونویسیها بهعنوان «حقیقت زمینی» برای آموزش و ارزیابی مدلهای داخلی استفاده میشدند.

چالشهای برچسبگذاری انسانی

-

این فرایند زمانبر است و چرخههای توسعه را کند میکند.

-

هزینههای بالا، مقیاسدادن مؤثر را دشوار میکند.

-

بازبینهای انسانی اغلب از رونویسیهای موجود شروع میکنند و این میتواند سوگیری ذاتی در اصلاحات ایجاد کند.

-

کار از نظر ذهنی سنگین است و با گذشت زمان احتمال خطای انسانی را افزایش میدهد.

با این حال، این چالشها ارزشش را داشتند؛ مدل اختصاصی فاینتیونشده در نهایت برای کاربرد مشخصِ مورد نظر، از راهکارهای پیشروی شخص ثالث بهتر عمل کرد.

چالشهای جدید با تغییر نیازها

با تکامل نیازهای مشتریان، چالشهای تازهای در برچسبگذاری دستی ایجاد شد:

-

پشتیبانی از زبانها و گویشهای جدید نیازمند استخدام متخصصان انسانی مسلط به هر زبان مشخص بود.

-

آزمون روی کاربردهای صنعتیِ خاص، مانند رونویسی پزشکی، به انسانهایی با تخصص دامنه نیاز داشت.

-

رشد سریع مدلهای پیشرفته متنباز، گزینههای بیشتری برای ارزیابی، استقرار و فاینتیون وارد میدان کرد؛ بنابراین روشی مقیاسپذیر و سازگار برای ارزیابی دقت لازم بود، بدون اینکه هفتهها برای رونویسی دستی منتظر ماند.

در نتیجه، ورود به یک دوره جدید اتفاق افتاد: LLM در حلقه.

«LLM در حلقه» یعنی چه؟

بهجای تکیه بر انسانها برای رونویسی صوت و تولید حقیقت زمینی، اکنون از یک مدل زبانی بزرگ (LLM) برای تولید رونویسی مرجع استفاده میشود. LLM خروجی چند سامانه رونویسی را تحلیل میکند و با استدلال میان آنها، دقیقترین بازسازیِ ممکن از آنچه گفته شده را تولید میکند؛ گاهی ممکن است برای بخشی از صوت با خروجی یک مدل همراستا شود و برای بخش دیگری با خروجی مدلی دیگر.

این وضعیت شبیه داشتن یک داور هوشمند و سریع است که:

-

چندین رونویسی از یک صوت را میخواند

-

زمینه و ظرافتهای زبانی را میفهمد

-

یک «مرجع» قابل اعتماد و بدونسوگیری برای مقایسه مدلها تولید میکند

پایپلاین نرمافزاری اثبات مفهوم (POC)

برای اعتبارسنجی مفهوم، یک پیکره معروف که پیشتر بهصورت دستی برچسبگذاری شده بود پردازش شد. از آن برای تخمین دقت خط لوله مبتنی بر LLM استفاده شد و همزمان سهم واقعی تلاش برچسبگذاری دستی اولیه نیز ارزیابی گردید.

آنچه طراحی شد:

-

همان قطعههای صوتی ۵ تا ۱۵ ثانیهای با چند سامانه STT رونویسی شدند؛ شامل مدلهای داخلی، مدلهای متنباز و ارائهدهندگان شخص ثالث.

-

برای هر کلیپ، همه رونویسیها بههمراه برچسبهای انسانی اصلی جمعآوری شد. سپس LLM با این گزینهها (بدون اطلاع از منبع هر خروجی) پرامپت شد و از آن خواسته شد محتملترین و دقیقترین رونویسی را برای آن قطعه تولید کند.

-

با استفاده از این «حقیقت زمینی مصنوعی» تولیدشده توسط LLM روی حدود ~۳۰۰ نمونه، نرخ خطای کلمه (WER) برای هر سامانه STT محاسبه شد.

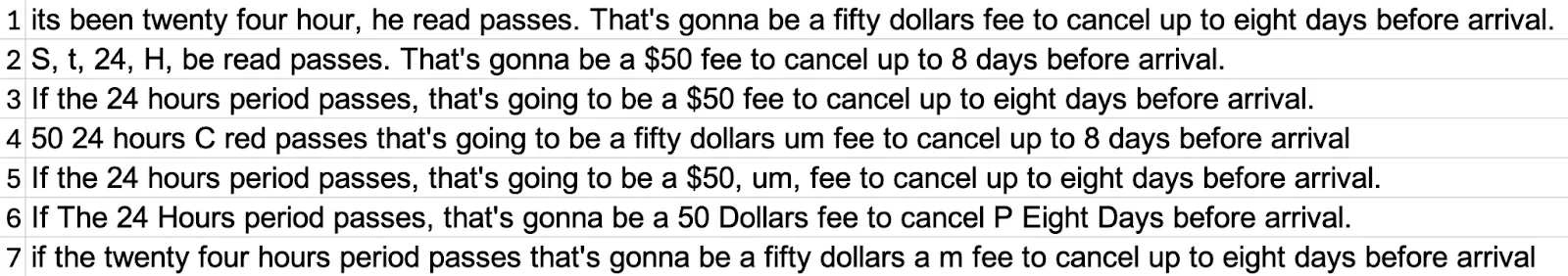

یک مثال: LLM چگونه بهترین مرجع را ترکیب میکند

فرض کنید خروجیهای زیر از ارائهدهندگان مختلف STT برای یک قطعه کوتاه صوتِ مربوط به کارشناس (agent) در دسترس است:

این رونویسیها در قالببندی، نمایش اعداد و میزان دقت متفاوتاند که بازتاب خروجی معمولِ مدلهای مختلف است.

به LLM دستور داده میشود دو رونویسی مرجع همتراز تولید کند:

مرجع الفبایی (Alphabetic): If the twenty-four-hour period passes, that’s going to be a fifty-dollar fee to cancel up to eight days before arrival.

مرجع الفبایی-عددی (Alphanumeric): If the 24-hour period passes, that’s going to be a $50 fee to cancel up to 8 days before arrival.

این رویکرد مقایسهای منصفانه (و بیطرف نسبت به قالببندی) میان انواع مختلف خروجیها ایجاد میکند: مدلهای بدون قالببندی (مانند راهکار ما) در برابر مرجع بدون قالببندی سنجیده میشوند، در حالی که مدلهای دارای توان قالببندی با مرجع قالببندیشدهای مقایسه میشوند که معنای معادل را حفظ میکند.

مدلهای ارزیابیشده و تنظیمات

مدلهای زیر آزمون شدند:

-

Vonage AI (VAI) – مدل داخلی فاینتیونشده، آموزشدیده روی دادههای برچسبگذاریشده دستی توسط همان تیم

-

Vonage AI (VAI) – نسخه قدیمیتر، بدون فاینتیون برای این کاربرد

-

رونویسیهای برچسبگذاریشده انسانیِ اصلی

-

سه مدل متنباز از OpenAI: Whisper-Large(V3)، Whisper-Medium، Whisper-Small

-

دو ارائهدهنده شخص ثالث

برای بررسی نقش مراجع انسانی، خط لوله ارزیابی مبتنی بر LLM در دو پیکربندی اجرا شد:

-

Label-In: رونویسی انسانی بهعنوان یکی از گزینههای جایگزینِ نشاندادهشده به LLM برای ترکیب مرجع لحاظ شد.

-

Label-Out: رونویسی انسانی از گزینههای نشاندادهشده به LLM حذف شد (پنهانسازی/بیاطلاعسازی).

این دو حالت با هم مقایسه شدند تا هم پایداری مرجع تولیدشده توسط LLM سنجیده شود و هم سوگیریهای احتمالی ناشی از دادههای برچسبگذاریشده انسانی بررسی گردد.

نتایج

نرخ خطای کلمه (WER)

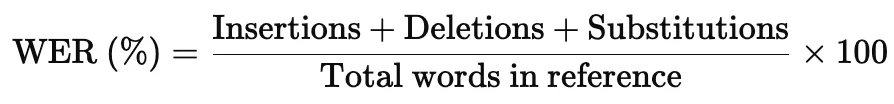

برای معیار اصلی ارزیابی از نرخ خطای کلمه (WER) استفاده شد. این یک معیار استاندارد برای کیفیت رونویسی است. WER تعداد خطاهای موجود در رونویسی را با مقایسه آن با یک مرجع اندازهگیری میکند. این خطاها در سه دسته قرار میگیرند:

-

Insertions (درج): کلمات اضافی که اضافه شدهاند

-

Deletions (حذف): کلماتی که جا افتادهاند

-

Substitutions (جایگزینی): کلمات نادرست بهجای کلمات درست

WER با فرمول زیر محاسبه میشود:

فرمول محاسبه نرخ خطای کلمه (WER) در بنچمارک تبدیل گفتار به متن: مجموع درجها، حذفها و جایگزینیها تقسیم بر کل کلمات مرجع، ضربدر ۱۰۰.

WER کمتر یعنی رونویسی دقیقتر است.

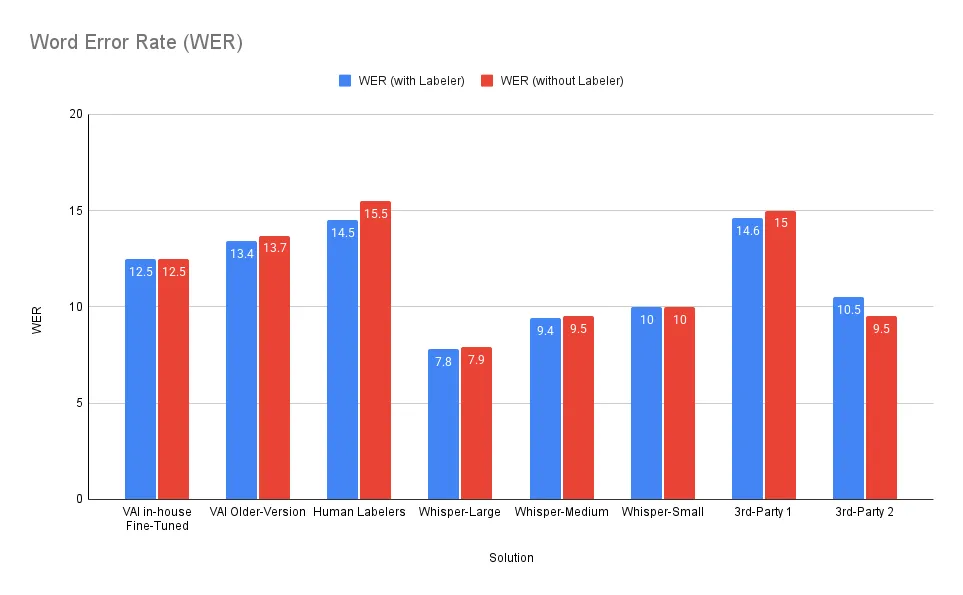

مقایسه نرخ خطای کلمه (WER) میان مدلهای تبدیل گفتار به متن، که نتایج را با مراجع برچسبگذاریشده انسانی (آبی) در برابر مراجع تولیدشده توسط LLM (قرمز) نشان میدهد.

WERها در هر دو تنظیم تقریباً یکسان بودند، که پایداری مراجع تولیدشده توسط LLM را نشان میدهد.

یافتههای کلیدی

-

رتبهبندی و مقادیر WER در هر دو حالت label-in و label-out برای اغلب مدلها پایدار بود.

-

«3rd-Party 2» هنگام حذف برچسب انسانی بهبود قابل توجهی نشان داد (WER 10.5 → ۹.۵)، که میتواند نشاندهنده همراستایی بهتر با خروجیهای تولیدشده توسط LLM نسبت به حاشیهنویسیهای انسانی باشد.

-

رونویسیهای برچسبگذاریشده انسانی تحت این ارزیابی WER بالاتری نسبت به تقریباً همه مدلهای خودکار داشتند. این موضوع قابل انتظار بود، چون پیکره توسط افراد غیر بومیِ انگلیسی رونویسی شده بود و ابزار حاشیهنویسی هم محافظت در برابر تایپو نداشت.

-

مدل فاینتیونشده VAI که بر اساس برچسبهای انسانی همان تیم آموزش دیده بود، همچنان از نسخه فاینتیوننشده بهتر عمل کرد (WER 13.7 → ۱۲.۵)، که ارزش این دادهها را با وجود نقصها نشان میدهد.

نتیجهگیری

این نتایج نشان میدهد که رونویسیهای مرجع تولیدشده توسط LLM برای بنچمارکگیری سامانههای STT قابل اعتماد، سازگار و مقیاسپذیر هستند. WERها و رتبهبندیهای تقریباً یکسان در ارزیابیها (با داده انسانی یا بدون آن) استحکام این خط لوله را برجسته میکند.

در حالی که برخی مدلها ممکن است با توکنسازی یا سبک قالببندی LLM همراستایی بیشتری داشته باشند (همانطور که در «3rd-Party 2» دیده شد)، در مجموع مراجع مشتقشده از LLM یک روش ارزیابی منصفانه و قابل بازتولید ارائه میدهند.

نکته مهم این است که با وجود اینکه مراجع برچسبگذاریشده انسانی نرخ خطای بالاتری نشان دادند، همچنان برای آموزش مدل ارزشمند هستند. فاینتیون روی این دادهها عملکرد مدل را بهشکل معناداری بهبود داد و نقش دادههای برچسبگذاریشده را در توسعه مدل تأیید کرد، حتی وقتی ارزیابی بتواند خودکار شود.

جمعبندی نهایی

-

LLMها میتوانند رونویسیهای مرجع قابل اتکا تولید کنند و از بنچمارکگیری مقیاسپذیر و پُرتوان پشتیبانی نمایند.

-

مراجع برچسبگذاریشده انسانی دیگر برای ارزیابی ضروری نیستند، اما برای آموزش همچنان مزیت دارند.

-

این روش بنچمارکگیری منصفانه را روی مدلها، زبانها و دامنههای جدید سرعت میدهد و نیاز به رونویسی دستی را حذف میکند.

اگر هدف ساخت عامل هوش مصنوعی اختصاصی و بنچمارک کردن راهکارهای مختلف باشد، میتوان یک عامل در AI Studio ساخت و آن را با راهکارهای شخص ثالث مختلف مانند Deepgram ترکیب کرد تا مشخص شود کدام گزینه بهتر عمل میکند.