یک تغییر پارادایم در استدلال هوش مصنوعی (A Paradigm Shift in AI Reasoning)

نکات کلیدی

- مدلهای مفهومی بزرگ (LCMها) نمایانگر یک تغییر از پیشبینی واژه به استدلال ساختارمند هستند و با کاهش مسائلی مثل اطلاعات غلط یا توهم (hallucination)، هوش مصنوعی را قابلاعتمادتر میکنند.

- LCMها از دانش ساختارمند مثل گرافهای علّی و آنتولوژیها استفاده میکنند تا روابط بین مفاهیم را درک کنند و تصمیمگیری را بهبود دهند.

- LCMها مسیرهای استدلال شفاف ارائه میدهند و تصمیمهای AI را در همه پیادهسازیها شفافتر و قابلاعتمادتر میکنند.

- LCMها با معماریهای مدلِ پایه و مبتنی بر دیفیوشن (Diffusion-based) تغذیه میشوند که پیشبینیها را پالایش میکنند تا عدمقطعیت را مؤثرتر از رویکردهای سنتی AI مدیریت کنند.

- ترکیب استدلال LCM با روانی زبانی LLM میتواند به AI امکان دهد سناریوهای پیچیده را تحلیل کند و بینشها را مؤثر منتقل کند.

مقدمه

مدلهای مفهومی بزرگ (LCMها) یک تغییر بزرگ در پردازش زبان طبیعی (NLP) ایجاد میکنند، چون بهجای صرفاً پیشبینی واژهها، روی استدلال ساختارمند و فهم واقعی تمرکز دارند. برخلاف مدلهای زبانی بزرگ (LLMها) که گاهی در کارهایی که نیاز به استدلال جدی دارند اطلاعات گمراهکننده یا ناسازگار تولید میکنند، LCMها به دانش ساختارمند (مثل آنتولوژیها و گرافهای علّی) متکی هستند و رفتار و شیوه فکر تحلیلگران خبره را تقلید میکنند. این رویکرد کمک میکند AI روابط بین مفاهیم را بفهمد، استدلال خود را توضیح دهد، و تصمیمهای قابلاعتمادتر بگیرد. LCMها با رفع نقصهای AI فعلی، امکانهای تازهای برای تصمیمگیری دقیق، کشف علمی، و کاربردهای صنعتی باز میکنند.

این مقاله که ریشه در یک پیادهسازی واقعی از پشتیبانی مشتری پیشرفته دارد، هدفش این است که به رهبران فنی کمک کند بفهمند LCMها چگونه میتوانند در محیطهای سازمانی مستقر و یکپارچه شوند.

درک LLMها در برابر LCMها

LLMها مدلهای هوش مصنوعی هستند که روی حجم عظیمی از دادههای متنی آموزش دیدهاند و به آنها امکان میدهد متن شبیه انسان را درک و تولید کنند. با یادگیری الگوها و ساختارهای زبان، LLMها میتوانند بر اساس این اطلاعات پیشبینیهایی انجام دهند تا به پرسشها پاسخ دهند، محتوا تولید کنند، یا از داده/محتوای ارائهشده بینش استخراج کنند.

در مقابل، مدلهای مفهومی بزرگ (LCMها) برای درک و استدلال روی مفاهیم ساختارمند آموزش میبینند. LCMها بهجای پیشبینی صرفِ واژه بعدی، ایدهها و روابط سطحبالا را ثبت میکنند. این کار به LCMها امکان میدهد استدلال دقیقتر، تصمیمگیری پیچیدهتر، و حل مسئله ساختارمند را در طیف متنوعی از وظایف انجام دهند.

مشکل مدلهای فعلی

در چند سال گذشته، مدلهای زبانی بزرگ (LLMها) بهطور چشمگیری AI را متحول کردهاند. از جمله اینکه به ماشینها امکان دادهاند متن و تعاملات شبیه انسان تولید کنند. با این حال، LLMها اغلب فاقد فهم واقعی هستند؛ آنها «توهم» دارند، یعنی پاسخهای نادرست ارائه میکنند. دلیلش این است که LLMها بهشدت به الگوهای آماری و احتمال تکیه میکنند، که بهویژه وقتی کار نیازمند علیت و زمینه (context) باشد، عدماطمینان ایجاد میکند. برای مثال، یک AI پزشکی ممکن است با اطمینان عوارض جانبی دارویی را توضیح دهد که اصلاً وجود ندارد، یا یک چتبات حقوقی ممکن است رویه قضایی را اشتباه تفسیر کند چون به الگوهای آماری متکی است، نه استدلال واقعی.

نبود درک علّی

یکی از محدودیتهای کلیدی مدلهای فعلی AI، درک علّی است. اگر بپرسید: «اگر میزان بارندگی کاهش پیدا کند، قیمت گندم چگونه تغییر میکند؟» یک LLM ممکن است به روندهای گذشته اشاره کند، اما عوامل حیاتیِ منطقهمحور مثل حاصلخیزی خاک، سیاستهای کشاورزی منطقهای، یا زنجیرههای تأمین جهانی را از قلم بیندازد. این اتفاق میافتد چون LLMها نمیتوانند مفاهیم و روابط بین آنها را درک کنند؛ آنها واژهها را بر اساس الگوها پیشبینی میکنند، نه بر اساس استدلال ساختارمند.

مثال: اتوماسیون پشتیبانی مشتری

بیایید یک مثال از اتوماسیون پشتیبانی مشتری در یک سازمان را در نظر بگیریم؛ جایی که این محدودیتِ درک علّی حیاتی میشود. مشتریان مختلف ایمیلهایی برای دریافت پشتیبانی ارسال میکنند که شامل بخشهای مختلف و انواع درخواستهاست. این شامل چند درخواست در یک ایمیل یا درخواستهای پیگیری (follow-up) هم میشود. به دلیل محدودیتهای ذاتی، سیستمهای AI مبتنی بر LLM نمیتوانند همه ایمیلها را دقیق و درست دستهبندی کنند.

برای نمونه، یک ایمیل مشتری ممکن است بگوید: «صورتحساب ماهانه من دوباره اشتباه است، با وجود اینکه ماه قبل هم برای همین موضوع شکایت ثبت کرده بودم.» سیستم مبتنی بر LLM ممکن است این را یک مشکل عمومی صورتحساب دستهبندی کند و سیگنالهای علّی عمیقتر را از دست بدهد؛ مثل یک باگ حلنشده در سیستم بکاند که روی تولید صورتحساب برای حسابهای موجود اثر میگذارد. این میتواند به باز کردن یک تیکت تکراری یا مسیردهی اشتباه آن منجر شود.

LCMها چطور این را حل میکنند

مدلهای مفهومی بزرگ فراتر از کلیدواژهها میروند. چون استدلال آنها بر مفاهیم ساختارمند بنا شده، درک میکنند که «مشکل تکراری»، «ثبت تیکت قبلی»، و «عدم تطابق صورتحساب» از نظر مفهومی به هم مرتبط هستند. سپس مدل با استفاده از زمینه تاریخی، روابط علّی بین وضعیت تیکت قبلی و مشکل بکاند را شناسایی میکند. در نتیجه، LCM آن را بهعنوان «مشکل بحرانی تکرارشونده» زیرمجموعه «خطاهای سیستمی» طبقهبندی میکند و آن را بهعنوان مسئله فنی بالا میآورد. علاوه بر این، یک تیکت دیگر هم بهعنوان «اصلاح صورتحساب» زیرمجموعه «واحد حسابداری» ثبت میکند تا به نارضایتی مشتری رسیدگی کند و راهحل فوری ارائه دهد. همزمان، تیم نرمافزار مشکل فنی را رفع میکند.

پردازش توکنبهتوکن

چالش دیگر مدلهای LLM، پردازش توکنبهتوکن آنهاست. آنها خروجی را یک واژه در هر لحظه تولید میکنند، بدون اینکه ساختار کامل پاسخ را از قبل برنامهریزی کنند. این باعث میشود برای LLMها حفظ سازگاری منطقی در پاسخهای طولانی سخت شود. اغلب این موضوع به تناقض، خطای factual، یا تکرار جملات منجر میشود؛ شبیه کسی که مقاله مینویسد و هر کلمه بعدی را حدس میزند بهجای اینکه فکرش را از قبل طرحریزی کند.

در حالی که LLMها ابزارهای قدرتمندی هستند، نبود استدلال عمیق و دانش ساختارمند، قابلیت اتکای آنها را در حوزههایی مثل پزشکی، مالی و علوم محدود میکند؛ جایی که دقت و انسجام منطقی حیاتی است.

مثال: Text-to-SQL برای هوش تجاری

یک سناریوی سازمانی را در نظر بگیرید که در آن Text-to-SQL برای هوش تجاری در قالب یک چتبات در یک سازمان بزرگ پیادهسازی میشود. یک کاربر میپرسد: «کل درآمد ماهانه از مشتریان پلاتینیوم در منطقه خاورمیانه را در هشت فصل گذشته نشان بده، با حذف بازپرداختها و حسابهای آزمایشی.» چتبات مبتنی بر LLM ممکن است در این حالت یک کوئری SQL تا حدی درست تولید کند. اما یک یا چند جزء حیاتی را از دست میدهد؛ مثل معیارهای حذف (exclusion criteria)، بازه زمانی، یا joinها بین جدولهای نرمالسازیشده. دلیلش این است که LLMها کوئری SQL را بهصورت خطی، کلمهبهکلمه تولید میکنند و هر ساختار معنایی موجود را نادیده میگیرند.

LCMها چطور این را حل میکنند

با استدلال در سطح مفهومی، یک مدل مفهومی بزرگ نیت (intent) را تجزیه میکند، محدودیتها را نگاشت میکند، و یک کوئری SQL کامل و از نظر منطقی دقیق تولید میکند. این مدل محدودیت «حذف بازپرداختها و حسابهای آزمایشی» را درک میکند و نتیجه میگیرد که نیازمند join با جدولهای «نوع مشتری» و «درآمد ماهانه» است و این یعنی انسجام در منطق انتهابهانتها.

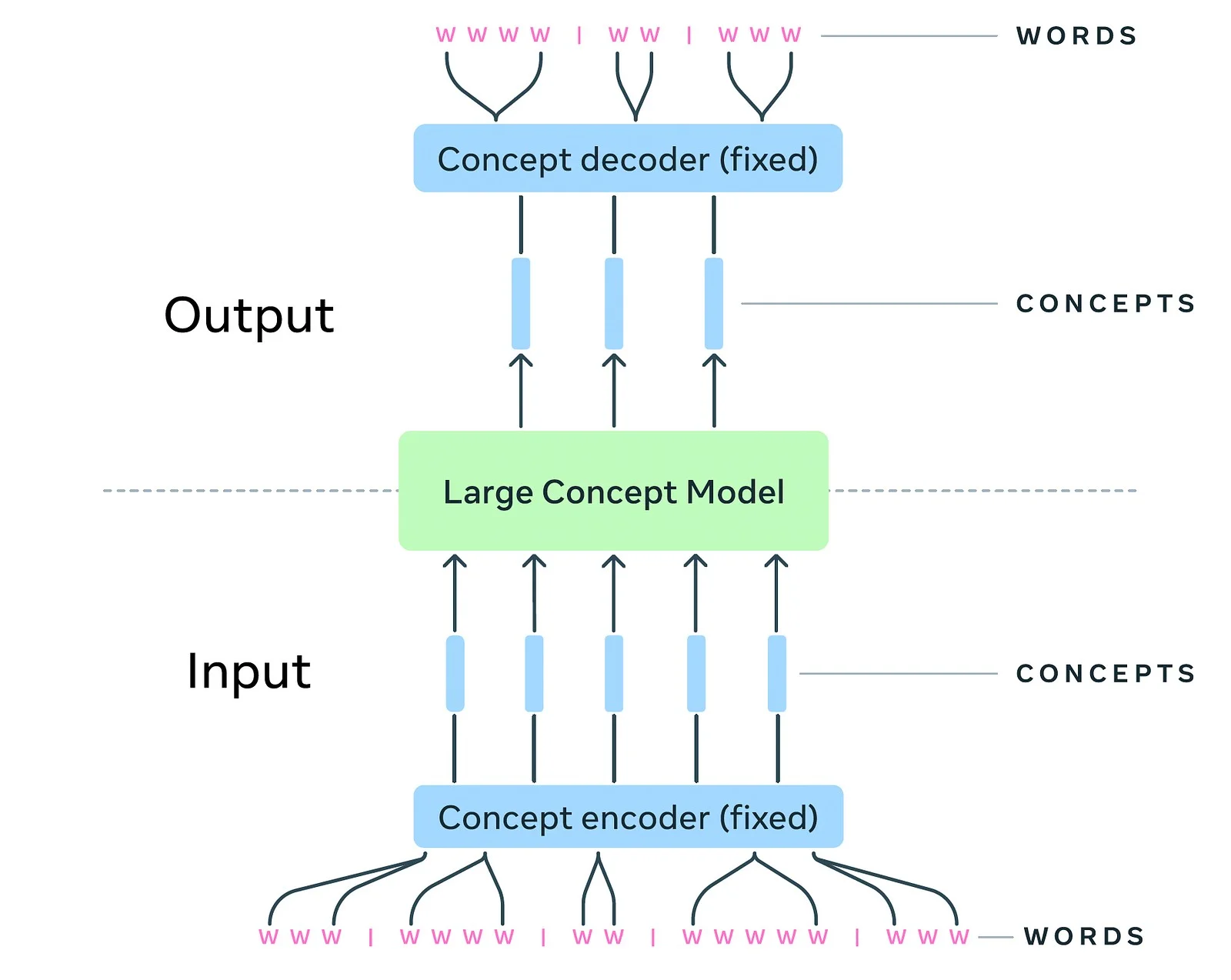

درک مدلهای مفهومی بزرگ

مدلهای مفهومی بزرگ پردازش سطح توکن را کنار میگذارند و روی استدلال سلسلهمراتبی در یک فضای embedding انتزاعی تمرکز میکنند تا مفاهیم و روابط را بفهمند؛ مشابه نحوه فکر کردن انسانها. مدلهای LCM طوری طراحی شدهاند که مستقل از زبان باشند و استدلال زیربنایی را در سطح معنایی پردازش کنند.

در حالی که یک LLM ممکن است عبارت «خشکسالی تولید گندم را کاهش میدهد» را فقط یک دنباله واژه ببیند، یک LCM آن را بهعنوان رابطه علت و معلولی تفسیر میکند و تصویر بزرگتر را میفهمد.

Knowledge-Driven Reasoning – LCMها به گرافهای دانشی متکی هستند که تعریف میکنند مفاهیم چگونه به هم مرتبطاند. برای نمونه، آنها بهطور صریح روابطی مثل «خشکسالی → اثر میگذارد → عملکرد محصول» را نمایش میدهند، نه اینکه صرفاً واژه بعدی را پیشبینی کنند.

Multimodal Understanding – برخلاف LLMها که عمدتاً روی متن تمرکز دارند، LCMها میتوانند گفتار، تصویر و حتی زبان اشاره را پردازش کنند و آنها را از طریق یک فضای مفهومی مشترک به هم وصل کنند.

Logical and Statistical Hybrid – LCMها هوش مصنوعی نمادین (قواعد و منطق) را با یادگیری ماشین ترکیب میکنند و به آنها امکان استدلال سیستماتیک میدهند. برای مثال، با داشتن «همه خشکسالیها به محصولات آسیب میزنند، و منطقه X در خشکسالی است»، یک LCM میتواند منطقی نتیجه بگیرد که «در منطقه X انتظار خسارت محصول وجود دارد».

LCMها چگونه متفاوت کار میکنند

چه LLM باشد چه LCM، هر دو با اهداف مشابهی مثل تولید متن، خلاصهسازی، پاسخگویی به سؤال، ترجمه، طبقهبندی، داده و تقویت جستوجو کار میکنند. از این منظر، تفاوت بنیادی LCMها و LLMها در نحوه برخوردشان با این وظایف است. برای مثال، در کار ترجمه زبان، LLMها بر اساس داده و زبانی که روی آن آموزش دیدهاند عمل میکنند، در حالی که LCMها از Semantic Object and Abstract Representation (SONAR) استفاده میکنند.

SONAR یک فضای embedding است که آموزش دیده یا ساختاربندی شده تا شباهت مفهومی و ساختار را ثبت کند، نه فقط الگوهای زبانی. این فضا به مدلها اجازه میدهد روی مفاهیم انتزاعی مثل عدالت، اقتصاد یا آگاهی بهتر استدلال کنند، با قرار دادن آنها در یک فضای برداری متراکم که ویژگیهای معنایی و رابطهای در آن حفظ میشود. SONAR همچنین در auto-encoding جملهها قوی است، یعنی تبدیل جملهها به بردار و برگرداندن آنها بدون از دست دادن زیاد. در نتیجه، میتواند ۲۰۰+ زبان را بدون آموزش زبانی اضافی بفهمد و ترجمه کند.

LLMها برای صحبتکردن روان عالی هستند، و LCMها در حال ظهور بهعنوان مدلهایی عالی برای دقیق فکر کردن هستند.

از منظر گستردهتر، تفاوت LLMها و LCMها اینگونه است:

مقایسه LLM و LCM

| جنبه | مدل زبانی بزرگ (LLM) | مدل مفهومی بزرگ (LCM) |

|---|---|---|

| واحد فهم | توکنها [کلمات، زیرکلمات] | مفاهیم (سطح جمله) |

| هدف آموزش | پیشبینی توکن بعدی | پیشبینی مفهوم بعدی |

| معماری | مدلهای ترنسفورمر آموزشدیده روی متن خام | شبکههای embedding مفهومی آموزشدیده روی embeddingهای جمله |

| سبک خروجی | تولید متن روان، کلمهبهکلمه | خروجی مفهومی منسجم و ساختارمند که به متن تبدیل میشود |

| نقاط قوت | نویسندگی خلاق و گفتوگوی روان | استدلال، فهم ساختارمند، وظایف منطقی چندمرحلهای |

| نقاط ضعف | توهم، استدلال سطحی، مشکل در پیچیدگی | ضعیفتر در تولید متن خلاقانه |

| نوع خطا | توهم (متن قابلباور اما غلط) | عدمتطابق مفهومی (معمولاً توهم تصادفی کمتر) |

| بهترین موارد استفاده | چتباتها، خلاصهسازی، داستانگویی، تولید کد | پشتیبانی تصمیم، Q&A ساختارمند، پروندههای رگولاتوری، استدلال |

| تشبیه کاربرد | داستانگو | برنامهریز منطقی |

رویکرد Concept-first

LCMها از رویکرد «اول-مفهوم» استفاده میکنند تا دانش را بر اساس مفاهیم سطحبالا قبل از ورود به یادگیری دادهمحور درک و ساختاربندی کنند. بهجای اتکا صرف به حجم عظیمی از دادههای بدون ساختار، این رویکرد تضمین میکند مدلها قبل از آموزش بیشتر، یک فهم پایه از اصول کلیدی، روابط و سلسلهمراتبها در یک دامنه مشخص بسازند.

این رویکرد concept-first باعث میشود LCMها در تعمیم دانش بین زبانها و زمینههای مختلف بسیار بهتر باشند. برای مثال، یک LCM که روی دادههای پزشکی انگلیسی آموزش دیده میتواند بیماریها را به زبان سواحیلی تشخیص دهد، نه از طریق ترجمه مستقیم، بلکه با تشخیص مفاهیم پزشکی جهانشمول.

با تمرکز روی معنا بهجای صرفِ الگوهای کلمهای، LCMها گام بعدی AI را نمایش میدهند: حرکت از تولید متن روان به سمت فهم و استدلال واقعی.

مدلهای مفهومی بزرگ – معماری

مدلهای مفهومی بزرگ بر پایه یک معماری هیبریدی ساخته میشوند که نمایش دانشی ساختارمند را با سازگاری شبکههای عصبی ترکیب میکند. این به آنها امکان میدهد منطقی استدلال کنند و همزمان پیچیدگی دنیای واقعی را مدیریت کنند؛ که نسبت به مدلهای صرفاً آماری AI یک پیشرفت است.

در هسته LCMها، یک فرایند ساختارمند و سلسلهمراتبی قرار دارد. متن ورودی ابتدا به جملهها شکسته میشود، و این جملهها بهعنوان واحدهای مفهومی بنیادی در نظر گرفته میشوند. سپس این جملهها از SONAR عبور داده میشوند.

اصول ساختاری LCM

پس از کدگذاری، دنباله مفاهیم توسط مدل پردازش میشود که کاملاً در فضای embedding عمل میکند. این رویکرد مستقل از زبان اجازه میدهد LCMها استدلال را مستقل از هر زبان یا فرمت ورودی انجام دهند و این آنها را فراتر از متن و گفتار سازگار میکند. سپس مفاهیم تولیدشده با استفاده از SONAR دوباره به زبان یا سایر مودالیتیها decode میشوند، و خروجی در چند زبان یا فرمت بدون اجرای مجدد مدل ممکن میشود.

دو معماری کلیدی در این فضا شکل گرفتهاند: Base-LCM که رویکرد اولیه است، و Diffusion-Based LCMs که نسخه پیشرفتهتری الهامگرفته از تکنیکهای تولید تصویر است. هر دو از این پایپلاین ساختارمند استفاده میکنند و پاسخهای AI منطقیتر و آگاهتر از زمینه تولید میکنند.

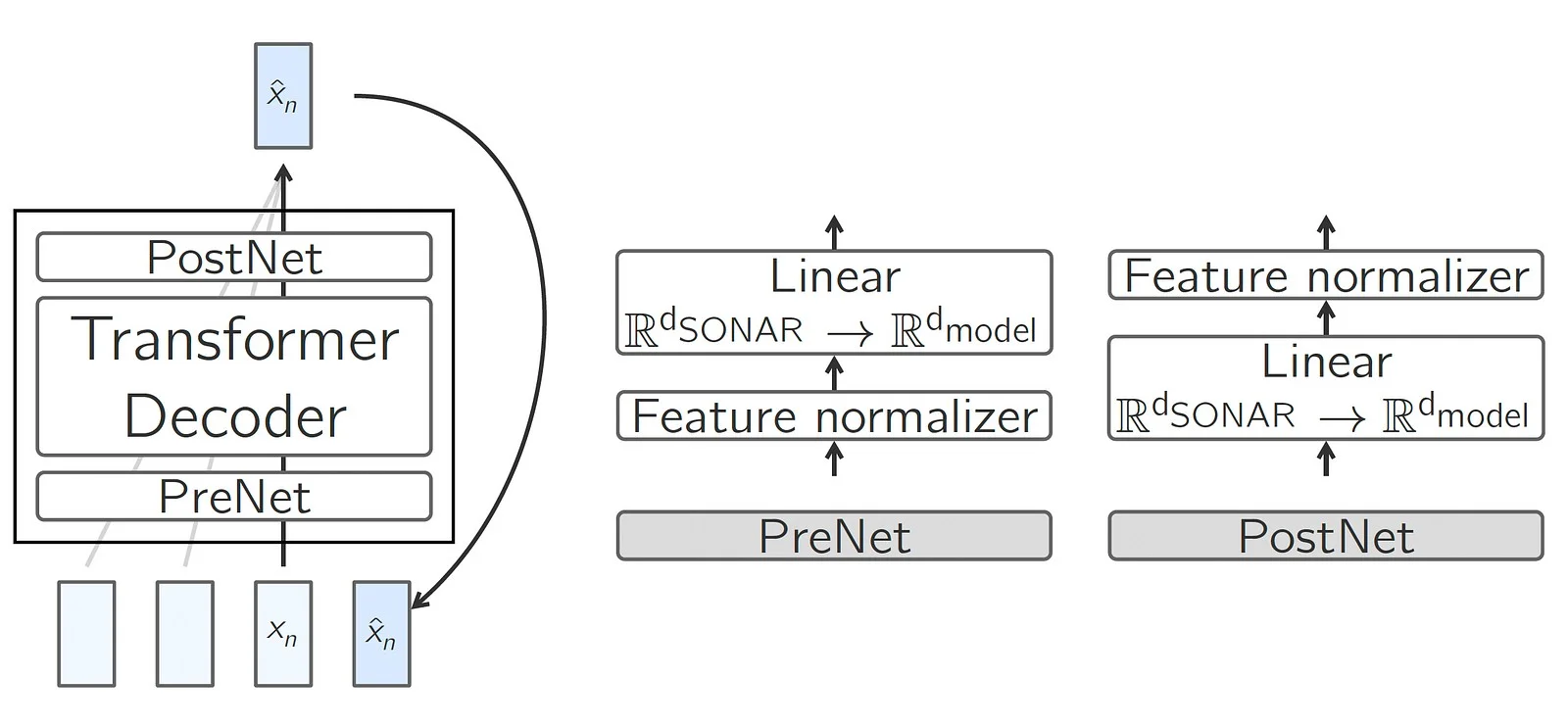

Base-LCM – اولین قدم

معماری Base-LCM اولین قدم در مدلهای مفهومی بزرگ بود. این معماری شبیه مدلهای زبانی بزرگ (LLMها) کار میکند، اما بهجای پیشبینی «کلمه بعدی»، «مفهوم بعدی» را در یک فضای مفهومی ساختارمند پیشبینی میکند.

Base-LCM چگونه کار میکند

مدل یک دنباله از مفاهیم دریافت میکند و یاد میگیرد مفهوم بعدی را پیشبینی کند. از معماری مبتنی بر ترنسفورمر همراه با لایههای اضافه استفاده میکند:

- PreNet: embeddingهای مفهومی را برای پردازش تنظیم میکند.

- Transformer Decoder: روابط بین مفاهیم را پردازش میکند.

- PostNet: خروجی را به فضای مفهومی اصلی نگاشت میکند.

تصویر معماری پایه LCM

فرایند آموزش، خطا بین مفاهیم پیشبینیشده و مفاهیم واقعی را با استفاده از تابع زیان Mean Squared Error (MSE) کمینه میکند.

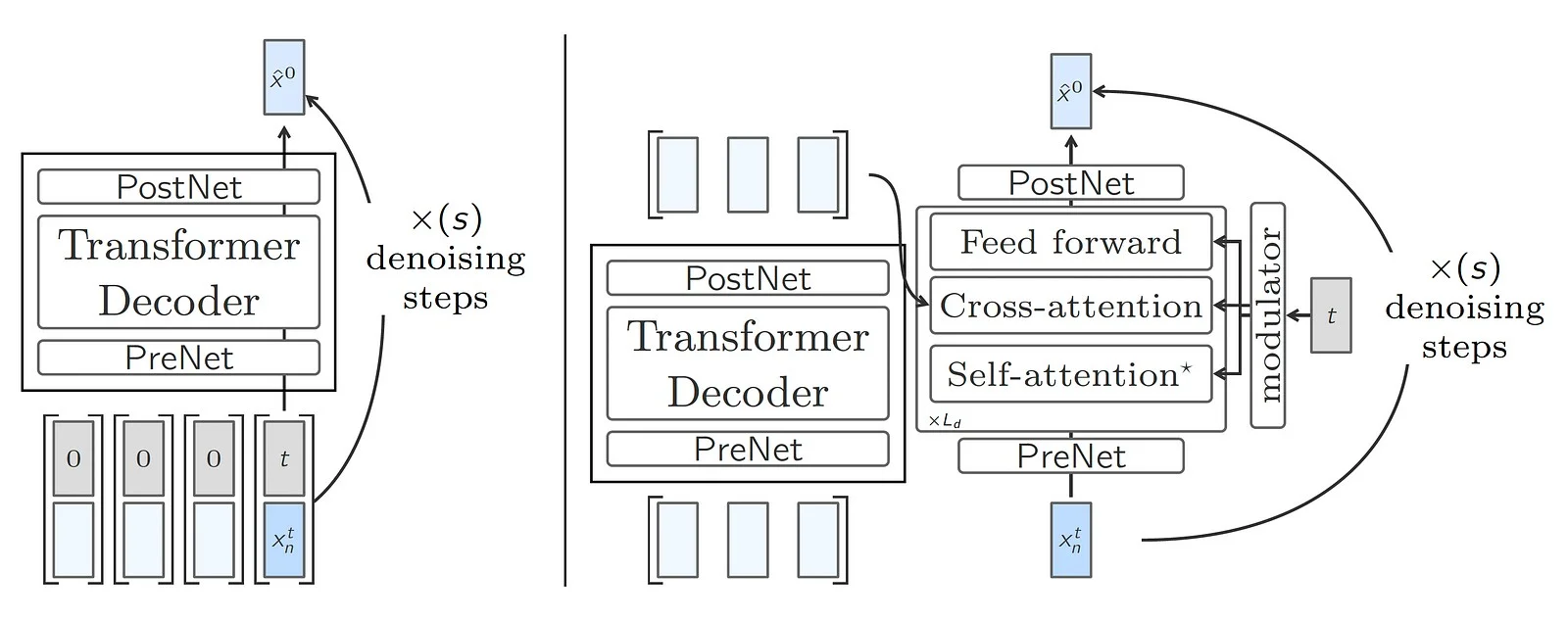

Diffusion-Based LCMs – روشی هوشمندتر برای پیشبینی مفاهیم

این معماری با الهام از مدلهای دیفیوشن در تولید تصویر، پیشبینیها را با حذف تدریجی «عدمقطعیت» یا «نویز» از مفاهیم احتمالی بعدی پالایش میکند.

Diffusion-based LCM چگونه کار میکند

تصور کنید میخواهید تصویر یک گربه را از نویز تصادفی تولید کنید؛ هر مرحله نویز را کم میکند تا تصویر واضح ظاهر شود. Diffusion-based LCMها همین ایده را برای پیشبینی مفهوم به کار میبرند و در چند مرحله آن را پالایش میکنند.

دو رویکرد برای Diffusion-based LCM وجود دارد:

- One-Tower LCM – در این رویکرد، دنبالهای از مفاهیم پردازش میشود که فقط مفهوم آخر «نویزی» (نامطمئن) است. سپس این مفهوم نویزی بهصورت تکراری پالایش میشود تا به یک پیشبینی واضح برسد. این شبیه Base-LCM است اما با اجرای چندین مرحله پالایش، پیشبینیها را بهتر میکند.

- Two-Tower LCM – در این رویکرد، کدگذاری زمینه از پالایش مفهوم جدا میشود. مدل اول مفاهیم قبلی را میفهمد، در حالی که مدل دوم مفهوم بعدی را denoise میکند. سپس با سازوکارهای cross-attention پیشبینیها دقیقتر میشوند.

تصویر معماری LCM مبتنی بر انتشار | سمت چپ – LCM یک برج | سمت راست – LCM دو برج.

مطالعات نشان میدهد مدلهای diffusion-based بهطور قابلتوجهی از Base-LCM در ROUGE-L Score (که اندازه میگیرد مدل چقدر معنا را در خلاصههای تولیدی حفظ میکند) و Coherence Score (که جریان منطقی و سازگاری پیشبینیها را ارزیابی میکند) بهتر عمل میکنند.

محدودیتهای Base-LCM و Diffusion-based LCM

مسئله اصلی در معماری Base-LCM این بود که LCM بهخاطر نحوه نمایش مفاهیم در یک فضای embedding ثابت مثل SONAR با ابهام مشکل دارد. برای جملههای ساده و کوتاه خوب عمل میکند اما با جملههای پیچیده و دارای ارتباط سست مشکل دارد. همچنین نمیتواند اعداد، لینکها یا کد را بهطور قابل اتکا مدیریت کند. مسئله دیگر این است که گاهی یک جمله واحد ممکن است چند مفهوم داشته باشد، اما مدل آنها را یک مفهوم در نظر میگیرد. در بسیاری از موارد، چند مفهوم میتوانند بهطور منطقی ادامه یک ورودی باشند، اما این مدل فقط میتواند یکی را انتخاب کند. این محدودیتها به توسعه Diffusion-Based LCMها منجر شد که چند امکان را مؤثرتر مدیریت میکنند.

Diffusion-based LCMها نسبت به Base-LCMها در مدیریت چند خروجی ممکن بهتر هستند، اما آنها هم محدودیتهایی دارند. مدلهای دیفیوشن برای دادههای پیوسته مثل تصویر یا صوت خوب کار میکنند، اما متن ساختارمند و گسسته است. این کار تولید نتایج متنی دقیق یا معنادار را برای مدلهای دیفیوشن سختتر میکند. متا تلاش میکند این را با مدلهای کوانتیزه مثل Quant-LCM حل کند، اما فضای SONAR برای کوانتیزه شدن آسان طراحی نشده است و در نتیجه خروجیها اغلب پیچیدهاند و با کمبود داده (data sparsity) مشکل دارند.

مدلهای Diffusion-based در آزمایشهای ablation متا از Quant-LCM بهتر عمل کردند؛ به همین دلیل جزئیات آن مدلها را در این مقاله وارد نکردهام. برای بهبود بیشتر، باید روش بهتری برای نمایش متن توسعه داده شود که بین ساختار و انعطافپذیری تعادل ایجاد کند.

کاربردهای واقعی LCMها

درک مفهومی، استدلال ساختارمند و توانایی فکر منطقی چندمرحلهای LCMها آنها را برای کاربردهای واقعی که نیاز به استدلال پیشرفتهتر، زمینه و مفهوم دارند مناسب میکند. در ادامه، درباره چند کاربرد واقعی LCMها بر اساس تجربههای پروژه فعلیام که روی آن کار میکنم، با جزئیات صحبت میکنیم.

تیکتینگ و حل مسئله پیشرفته در پشتیبانی مشتری

یک سازمان بزرگ جهانی که زیرساختهای پیچیدهای را در پارکهای تجاری، ساختمانهای شرکتی، دانشگاهها، نهادهای دولتی و واحدهای تولیدی مدیریت میکند، در عملیات پشتیبانی مشتری با مجموعهای خاص از چالشها مواجه است: مقیاس، تعاملات چندزبانه، پیچیدگی وظایف، درخواستهای تکراری، فوریت یا شدت، و نیازهای شخصیسازی. سیستمهای سنتی مبتنی بر LLM کم میآورند چون برای هر جغرافیا یا نوع مجموعه، به راهحلهای سفارشی نیاز دارند. اینجا LCMها با استدلال در سطح مفهومی، نه فقط پردازش کلیدواژهها، مزیت دگرگونکنندهای ارائه میدهند. LCMها درخواستهای ورودی پشتیبانی را عمیق تحلیل میکنند، بیش از ۴۵۰+ نوع کار پشتیبانی را میان ۵۰+ دپارتمان بهدرستی طبقهبندی میکنند و تیکتهای ساختارمند ایجاد میکنند.

LCMها در کنار LLMها + RAG همچنین پاسخهای خودکار هوشمند را ممکن میکنند: تأیید دریافت درخواست کاربر، ارائه راهکارهای DIY یا فرایندهای عیبیابی مرحلهبهمرحله بر اساس پایگاههای دانش، و رسیدگی خودکار به پرسشهای مبتنی بر پایگاه داده. با درک سطح مفهومی و توانایی چندزبانه، LCM به مرکز پشتیبانی جهانی کمک میکند کمکرسانی روان، آگاه از فرهنگ، و بسیار شخصیسازیشده را به زبانهای محلی ارائه دهد (۱۵+ زبان در خاورمیانه، اروپا و آسیا).

تولید کوئری SQL از زبان طبیعی

در ادامه همان اکوسیستم «تیکتینگ و حل مسئله پیشرفته» که چند کشور، تأسیسات زیرساختی و پایگاههای داده را در بر میگیرد، درباره اتوماسیون پاسخهای مبتنی بر داده صحبت کنیم که بهطور قابلتوجهی پیچیده هستند. گرچه LLMها میتوانند ترجمه ساده text-to-SQL را انجام دهند، در درک چندمرحلهای و نگاشت نیت کاربر به پایگاه داده درست، حقوق دسترسی، و کوئریهای درست از نظر زمینه مشکل دارند. LCMها این فرایند را بنیادین ارتقا میدهند چون در سطح مفهومی استدلال میکنند. آنها پیش از تولید SQL، نیت کاربر، زمینه عملیاتی و روابط schema را بهصورت سیستماتیک میفهمند.

این باعث خطاهای کمتر، دقت بالاتر، و درک عمیقتر از ظرافتهایی مثل قواعد رسیدگی به دادههای وابسته به دپارتمان یا جغرافیا میشود. با توانایی ورودی چندزبانه، LCM میتواند پرسشهای زبان طبیعی را در ۱۵+ زبان بهراحتی پردازش کند و حل خودکار پشتیبانی را در مقیاس ارائه دهد. در مقابل، بدون استدلال مفهومی، LLMها ممکن است پرسشها را بد تفسیر کنند، داده حساس را افشا کنند و یکپارچگی پایگاه داده را به خطر بیندازند؛ ریسکهایی که LCMها میتوانند از آن جلوگیری کنند.

پروندههای رگولاتوری و انطباق (Compliance)

یک کاربرد دیگر که اکنون روی آن کار میکنم، اتوماسیون پروندههای رگولاتوری و انطباق برای SEC در فضای Registered Investment Advisors است. این فضا بهشدت رگوله است و انطباق با مقررات دائماً در حال تغییر را با دقت، سازگاری و فهم زمینهای میطلبد. اتوماسیون سنتی با LLMها عموماً کم میآورد چون کارها نیازمند نگاشت مفهومی عمیق هستند؛ یعنی فهم قواعد، نگاشت آنها به داده مالی ظریف، و ساختاربندی اطلاعات مطابق schemaها و فرمتهای رگولاتوری.

LCMها برای این چالش مناسباند چون میتوانند روی چند مفهوم انطباقِ بههمپیوسته استدلال کنند، اطلاعات مالی پیچیده را دقیق طبقهبندی کنند، کاملبودن را اعتبارسنجی کنند، و خروجیهای ساختارمند همراستا با استانداردهای SEC تولید کنند. در این فضا، پروندهها و بهروزرسانیهای دورهای از نهادهای رگولاتوری نیازمند cross-reference و تحلیل اطلاعات از افشاگریهای مالی مختلف، منابع داده، ارتباطات و جزئیات عملیاتی است. LCMها هوشمندی لازم را برای خودکارسازی تولید پیشنویس پروندهها فراهم میکنند و با پردازش سریع، هم ریسک را کاهش میدهند و هم زمان را.

نقاط ضعف LCMها

در حالی که LCMها نسبت به LLMهای سنتی پیشرفتهای قابلتوجهی ارائه میدهند، چالشهای خودشان را هم دارند. این محدودیتها باید هنگام انتخاب LCM با دقت در نظر گرفته شوند. فهم این نقاط ضعف برای تصمیمگیری معماری آگاهانه ضروری است.

- LCMها نسبت به LLMها پایپلاینهای پیچیدهتری میخواهند، که آموزش و fine-tune را گران و منابعبر میکند.

- LCMها به سرمایهگذاری قابلتوجه اولیه در مهندسی مفهوم و یکپارچهسازی منابع داده نیاز دارند.

- LCMها به دیتاستهای برچسبخورده مفهومی نیاز دارند که باید برچسبگذاری شوند. در حال حاضر چنین دیتاستهایی بهصورت عمومی موجود نیستند.

- LCMها در استدلال ساختارمند بهتر هستند، اما فهم مسیرهای مفهومی داخلی آنها همچنان دشوار است و ممیزی را چالشبرانگیزتر میکند.

- لایههای مفهومی LCM حتی در زمان inference هم حافظه و محاسبه بیشتری میخواهند.

- LCMها هنوز در حال ظهور هستند و فقط تعداد کمی مدل یا دیتاست متنباز در دسترس است.

- Fine-tune کردن یک LCM اغلب نیازمند بازطراحی بخشی از فضای مفهومی یا ساختارهای روابط مفهومی است.

مقایسه رویکردهای مختلف در استدلال هوش مصنوعی

با تکامل سیستمهای مبتنی بر AI، معماریهای مختلف قابلیتها و نقاط قوت متفاوتی ارائه میدهند. LLMها، LLMها + RAG، و LCMها رویکردهای متفاوتی در استدلال و قابلیت اتکا هستند. جدول زیر مقایسه میکند و تفاوتهای کلیدی را برجسته میکند تا به انتخاب مدل درست کمک کند.

مقایسه LLM، LLM + RAG و LCM

| جنبه | LLMها | LLMها + RAG | LCMها |

|---|---|---|---|

| رویکرد اصلی | آموزشدیده روی پیکره متنی بزرگ، تولید بر اساس الگوهای زبانی آموختهشده | LLM + بازیابی سند خارجی برای پاسخدادن | استدلال ساختارمند روی مفاهیم استخراجشده و همتراز شده از داده |

| منبع دانش | داخلی – بر اساس داده حفظشده در آموزش | خارجی – در زمان پرسش بازیابی میشود | داخلی – گرافهای مفهومی و روابط با لایههای استدلال |

| ریسک توهم | بالا | کاهشیافته، اما در صورت بازیابی ضعیف ممکن است | بسیار پایین، چون خروجی ساختارمند و مبتنی بر مفهوم است |

| توانایی استدلال | محدود – صرفاً تشخیص الگو | محدود – میتواند اسناد بازیابیشده را نقل کند، فهم سطحی دارد | قوی – استدلال منطقی و علّی چندمرحلهای روی مفاهیم |

| سازگاری دامنه | نیاز به fine-tune با داده دامنهای | بازیابی بدون fine-tune یا retrain قابل تطبیق است | نیازمند مهندسی مفهومی دامنه با تطبیق کندتر اما عمیقتر |

| تفسیرپذیری | جعبه سیاه – سخت است بفهمیم چرا پاسخ تولید شد | کمی بهتر – چون میتواند به متن بازیابیشده اشاره کند | بهتر – مسیرهای مفهومی و منطق قابل تحلیل است |

| مدیریت داده بلادرنگ | ضعیف – نیازمند retrain | خوب – بازیابی زنده متن زمینهای | متوسط – بهروزرسانی دورهای مفاهیم یا اتصال به سیستمهای زنده |

| پیچیدگی آموزش | بالا | بالا برای LLM؛ متوسط برای RAG | بسیار بالا |

| هزینه inference | متوسط | بالا | بالا |

| بهترین برای | تولید متن، خلاقیت و AI مکالمهای | Q&A مبتنی بر پایگاه دانش، جستوجوی سندمحور و باتهای QA سازمانی | اتوماسیون عمیق، تصمیمگیری، استدلال چندپرشی و اقدام شخصیسازیشده |

راهاندازی مدل مفهومی بزرگ متا

بیایید سفر عملیمان را با مدل مفهومی بزرگ متا (Meta’s LCM) شروع کنیم.

کلون کردن مخزن

کد رسمی LCM را دریافت کنید

آمادهسازی محیط

برای این راهنما، من از Google Cloud Instance با ۸ vCPU، ۳۰ GB RAM و ۱ NVIDIA Tesla P4 GPU استفاده میکنم.

-

نصب ‘uv’ با استفاده از:

-

کلون کردن مخزن large concept model:

-

ساخت یک virtual environment با همه پکیجهای لازم:

-

نصب درایورهای NVIDIA:

-

نصب CUDA:

-

نصب NVIDIA utils:

-

ریبوت کردن instance

-

نصب CUDA:

-

بررسی نصب درایور NVIDIA:

-

ساخت یک دایرکتوری برای آمادهسازی داده:

-

نصب build-essentials و g++

-

Fairseq2 به libsndfile1 نیاز دارد، پس آن را نصب کنید:

-

نصب Torch با GPU با استفاده از uv:

-

نصب fairseq2 با استفاده از uv:

-

نصب Large Concept Model در محیط:

تست نصب موفق

-

ساخت یک دایرکتوری در ریشه مخزن با نام prep_data:

-

LCM یک پایپلاین نمونه پردازش ارائه میدهد که میتواند برای آمادهسازی داده آموزشی استفاده شود، و ما از همین برای تست نصب LCM استفاده میکنیم:

خروجی

حدوداً در ۲۵ دقیقه خروجی زیر را دریافت میکنید. این پایپلاین نشان میدهد چگونه یک دیتاست را از HuggingFace بگیریم و آن را با SONAR و SaT پردازش کنیم. اسکریپت نمونهای ارائه میدهد که داده را از HuggingFace میکشد و فایل داده آمادهشده با نام 0_467e0daf78e07283_0_0.parquet را با فرمت parquet در پوشه prep_data ایجاد میکند.

علاوه بر این، میتوانید GPUهای بیشتری به instance اضافه کنید و با دنبال کردن دستورالعملهای فایل README.md در repo، آموزش را اجرا کنید. در حال حاضر، متا وزنها (weights) یا مدلهای آموزشدیده را منتشر نکرده است. بنابراین باید مدل خودتان را آموزش دهید.

با این حال، آموزش یا fine-tune کردن مدلها روی سیستمهای ما ممکن نیست، چون برای مطالعه آزمایشی، متا مدلهایش را روی دیتاست Finewebedu آموزش داده است. همه مدلها با ۱.6B پارامتر برای 250k گام بهینهسازی و اندازه batch کل 229k مفهوم آموزش داده شدند، و این کار روی Research SuperCluster متا با ۳۲ GPU از نوع A100 انجام شده است.

مسیر پیش رو برای هوش مصنوعی و LCMها

آینده AI در آمیختن استدلال ساختارمند مدلهای مفهومی بزرگ با روانی زبانی مدلهای زبانی بزرگ نهفته است. این همجوشی میتواند سیستمهای AI بسازد که سناریوهای پیچیده را تحلیل کنند و بینشهایشان را شفاف منتقل کنند.

یک مشاور استراتژیِ مبتنی بر AI را تصور کنید که:

- از LCMها برای شبیهسازی روندهای بازار و پیشبینی نتایج استفاده میکند.

- از LLMها برای توضیح تصمیمها در روایتهای شبیه انسان بهره میگیرد.

- بهصورت پیوسته از بازخورد دنیای واقعی یاد میگیرد و دانشش را بهروزرسانی میکند.

بنابراین، این رویکرد هیبریدی تحلیل سطحکارشناسی را برای افراد بیشتری قابل دسترس میکند، در حالی که نظارت انسانی حفظ میشود. نهادهای رگولاتوری و دولتها، مثل دولت آمریکا، همین حالا هم مسیرهای استدلال قابل ممیزی را برای سیستمهای AI پرریسک الزام میکنند تا شفافیت تضمین شود.

قابلتوضیحتر کردن AI

یکی از بزرگترین مزیتهای LCMها تواناییشان در توضیح شفاف تصمیمهاست. برخلاف مدلهای سنتی AI که به فعالسازیهای عصبی پیچیده تکیه میکنند، LCMها استدلال را طوری ساختاربندی میکنند که انسان بتواند آن را دنبال کند.

برای مثال، یک AI مبتنی بر LCM که درمان پزشکی پیشنهاد میدهد میتواند نشان دهد چگونه علائم بیمار با تشخیصها و درمانهای ممکن از طریق دانش پزشکی ساختارمند مرتبط میشوند. این شفافیت اعتماد میسازد و به پزشکان اجازه میدهد پیشنهادهای AI را راستیآزمایی و اصلاح کنند، که به نتایج بهتر منجر میشود.

همکاری انسان و AI

LCMها برای کار کردن در کنار کارشناسان انسانی طراحی شدهاند، نه جایگزین کردن آنها. با سازماندهی دانش به شکلی همراستا با تفکر انسانی، آنها شریکهای هوشمند میشوند نه جعبهسیاههای غیرقابل پیشبینی.

این میتواند صنایع را متحول کند، برای مثال:

دانشمندان میتوانند از LCMها برای آزمودن فرضیهها و کشف بینشها سریعتر استفاده کنند.

رهبران کسبوکار ممکن است برای ارزیابی راهبردهای بازار و پیشبینی ریسکها به آنها تکیه کنند.

با پل زدن بین استدلال ساختارمند و AI سازگار، LCMها وعده آیندهای را میدهند که انسانها و AI مؤثرتر کنار هم کار کنند و بینشهای عمیقتر و تصمیمگیری هوشمندانهتر را آزاد کنند.

نتیجهگیری

مدلهای مفهومی بزرگ نمایانگر یک گام بزرگ به سمت AI هستند که «استدلال میکند»، نه فقط «پیشبینی». با ساختاربندی دانش بهجای اتکا به الگوها، آنها با چالشهایی مثل اطلاعات غلط و نبود قابلیت توضیحپذیری در AI مقابله میکنند. در حالی که پذیرش آنها به همکاری نیاز دارد، از پالایش استخراج دانش تا استانداردسازی ممیزی، LCMها میتوانند حوزههایی مثل سلامت، حکمرانی و راهبرد کسبوکار را متحول کنند. آینده AI درباره جایگزین کردن قضاوت انسانی نیست، بلکه درباره تقویت آن با استدلال شفافتر و بینشهای عمیقتر است.