فراتر از چتباتها (Beyond Chatbots)

نکات کلیدی

-

مدلهای زبانی بزرگ (LLMs) متن تولید میکنند، با نمونهبرداری از یک توزیع احتمالِ تقریبزده که در طول آموزش یاد گرفتهاند. پذیرش گسترده آنها هم کاربرد عظیمشان را نشان میدهد و هم محدودیتشان را در تصمیمهای کسبوکارِ دامنهمحور فراتر از تولید متن آشکار میکند.

-

در حالی که LLMها متن منسجم تولید میکنند، درک ذاتی از قواعد کسبوکار، سیاستهای مقرراتی، و محدودیتهای عملیاتی ندارند. این موضوع باعث میشود برای فرایندهای تصمیمگیری دنیای واقعی که به بهینهسازی ساختاریافته فراتر از ترکیب زبان نیاز دارند، کافی نباشند.

-

تکنیکهایی مثل بازیابی-تقویتشده با تولید (RAG) یا فاینتیون کردن یک LLM میتوانند خروجی را تا حد مشخصی جهتدهی کنند. با این حال، آنها نمیتوانند محدودیتهای خاص کسبوکار را کُدگذاری کنند یا به اندازه یک مدل مولد دامنهمحور، راهبردهای ساختاریافته و قابل اجرا تولید کنند.

-

همانطور که مدلهای مولدِ مبتنی بر تصویر تصویر تولید میکنند نه متن، مدلهای مولد دامنهمحور میتوانند آموزش ببینند تا محدودیتهای عملیاتی را یاد بگیرند و راهبردهای بهینه کسبوکار را توسعه دهند و قابلیتهای تصمیمگیری ساختاریافتهای فراتر از خروجیهای توصیفی ارائه کنند.

-

برخلاف LLMهای همهمنظوره، مدلهای دامنهمحور به دیتاستهای بسیار کوچکتر و پارامترهای کمتر نیاز دارند و همین آنها را مقرونبهصرفه و از نظر محاسباتی شدنی میکند، در عین حال که امکان اتوماسیون و «هوش تصمیمگیری» هسته کسبوکار مبتنی بر AI را در مقیاس فراهم میکنند.

مقدمه

ظهور مدلهای زبانی بزرگ (LLMs) مانند ChatGPT با توانایی شگفتانگیزشان در تولید متن، صنایع را متحول کرده و اتوماسیون مبتنی بر متن را ممکن کرده است. با این حال، ارزش واقعی برای کسبوکار فقط به تولید متن ختم نمیشود.

گزارش اخیر Boston Consulting Group (BCG)

یک گزارش اخیر از Boston Consulting Group (BCG) نشان میدهد ۶۲٪ از ارزشی که AI در صنایع مختلف تولید میکند، از «کارکردهای اصلی کسبوکار» مثل زنجیره تامین، عملیات، و فرایندهای درآمدزا میآید. فقط ۳۸٪ از کارکردهای پشتیبانی مثل خدمات مشتری میآید. همچنین بیان میکند که از میان همه سازمانهایی که با AI کار میکنند، تنها ۲۶٪ توانستهاند فراتر از مرحله «اثبات مفهوم» (PoC) بروند. از این میان، فقط ۴٪ بهصورت پیوسته ارزش پیشرو و لبهتیز تولید میکنند.

این گزارش برجسته میکند که سازمانهای موفق ۷۰٪ از تلاش تحول AI خود را روی «افراد و فرایندها» سرمایهگذاری میکنند، در حالی که فقط ۲۰٪ روی فناوری و ۱۰٪ روی الگوریتمها سرمایهگذاری میشود. این تمرکز راهبردی به آنها اجازه میدهد ابتکارهای AI را نزدیک به فرایندهای اصلی کسبوکار همراستا کنند و در کنار بهبود بهرهوری، مسیرهای جدید درآمدی ایجاد کنند. در حالی که LLMها تعاملات خدمات مشتری و تولید محتوا را بهطور معنیداری بهبود دادهاند، آنها ذاتاً توانایی درک محدودیتهای دامنهمحور و قواعد کسبوکار را ندارند، و این یک مانع روشن برای «جاسازی عمیق AI در تصمیمگیری عملیاتی» ایجاد میکند.

حتی رویکردهای پیشرفته مثل Agentic AI

حتی رویکردهای پیشرفته مثل Agentic AI که روی LLMها ساخته میشوند، عمدتاً از طریق پرامپتدهی زنجیرهفکر مبتنی بر متن، به ارکستریشن گردشکار میرسند. با این حال، همچنان در سطح متن باقی میمانند و هیچ دانش کسبوکاری دامنهمحور را درون خود تعبیه نمیکنند.

پس چرا LLMها کافی نیستند؟

بنابراین، برای ادغام واقعی AI با فرایندهای اصلی کسبوکار، LLMها بهتنهایی کافی نیستند و صنایع (مثل لجستیک، مالی، و خدمات شهری) به AI نیاز دارند که تحت شرایط و محدودیتهای بلادرنگ، خروجی «بهینه، عملیاتی، و تصمیممحور» تولید کند نه متن توصیفی. برای مثال:

-

یک شرکت لجستیک به مدلی نیاز ندارد که توضیح دهد چطور مسیرها را بهینه کند. در عوض، با توجه به شرایط فعلی، به مدلی نیاز دارد که بتواند «برنامههای زمانبندی مسیرهای بهینهشده» تولید کند.

-

یک شرکت خدمات شهری به یک LLM نیاز ندارد که طرحهای بازگردانی شبکه را خلاصه کند. بلکه به AI نیاز دارد که بتواند «توالیهای بازگردانی قابل اجرا» را در لحظه تولید کند، با در نظر گرفتن وضعیت آبوهوا، موقعیت، دسترسبودن تیمها، استانداردهای ایمنی، و سیاستهای شرکت.

این مقاله بررسی میکند و پیشنهاد میدهد از AI مبتنی بر متن به سمت «هوش مصنوعی مولد دامنهمحور» حرکت کنیم: مدلهایی که محدودیتهای عملیاتی، پویایی دنیای واقعی، و قواعد کسبوکار را میفهمند تا «راهبردهای قابل اجرا» تولید کنند، نه فقط توصیف متنی.

چشمانداز فعلی هوش مصنوعی مولد

هوش مصنوعی مولد از زمان اولین پذیرش عمومیاش مسیر طولانیای طی کرده است؛ مسیری که با پیشرفت سریع فناوری و افزایش سرمایهگذاریهای مالی هدایت میشود. گزارش Artificial Intelligence Index Report 2024 این روند را بدون هیچ تردیدی روشن میکند. این گزارش میگوید تنها در سال ۲۰۲۳، ۱۴۹ مدل بنیادین جدید منتشر شد که بیش از دو برابر تعداد سال ۲۰۲۲ است. همچنین میگوید تعداد اعطای پتنتهای AI از ۲۰۲۱ تا ۲۰۲۲ به میزان ۶۲.۷٪ جهش کرده و تعداد پروژههای مرتبط با AI در GitHub از ۸۴۵ در سال ۲۰۱۱ به حدود ۱.۸ میلیون در سال ۲۰۲۳ رسیده است.

از منظر سرمایهگذاری مالی، تامین مالی برای Generative AI در سال ۲۰۲۳ به ۲۵.۲ میلیارد دلار جهش کرد، تقریباً ۸ برابر سال ۲۰۲۲. این ورود رو به رشد سرمایه، اعتماد رو به رشد صنعت به پتانسیل تجاری و قابلیتهای Generative AI را برجسته میکند.

با نگاه عمیقتر به این چشمانداز، از میان ۱۴۹ مدل بنیادین جدید منتشرشده در سال ۲۰۲۳، حدود ۶۵.۷٪ متنباز بودند که نشاندهنده یک تغییر معنیدار به سمت ردپای بزرگتر اوپنسورس و دموکراتیزه شدن توسعه مدلهای Generative AI است. با این حال، بالاترین عملکردها، مانند GPT-4 از OpenAI و Gemini Ultra از گوگل، که نمایانگر جدیدترین وضعیت پیشرو هستند، همچنان اختصاصی و بسته باقی ماندند، یعنی سیستمهای مبتنی بر صنعت و کلوز-سورس، و Gemini Ultra در معیار Massive Multitasking Language Understanding (MMLU) به نقاط عطف عملکرد در سطح انسان دست یافت.

این وضعیت هم بلوغ سریع Generative AI را نشان میدهد و هم نفوذ رو به رشد آن را در صنعت، چون دسترسپذیرتر و پیشرفتهتر میشود. با این حال، همین گزارش Artificial Intelligence Index Report 2024 همچنین اشاره میکند که هزینه محاسباتی آموزش مدلهای frontier بهشدت افزایش یافته است. برای مثال، هزینه آموزش GPT-4 به ۷۸ میلیون دلار رسید، در حالی که هزینه Gemini Ultra به رقم بیسابقه ۱۹۱ میلیون دلار رسید.

در نتیجه، بیشتر بازیگران صنعتی محدود میشوند به استخراج ارزش از «ارکستریشن» روی مدلهای عمومی LLM و مدلهای تصویر که توسط چند بازیگر AI با توان و منابع لازم برای مقیاس بزرگ آموزش داده شدهاند. نه اینکه این الگو ارزش کمتری داشته باشد، اما این مدلهای عمومی عمدتاً در تولید متن/تصویر و وظایف استدلال عمومی عالی هستند و در حوزه مدلهای مولد دامنهمحور که از پایه برای تولید تصمیمهای کسبوکار ساختاریافته، عملیاتی و بهینه در زمان واقعی طراحی میشوند، یک شکاف باقی میگذارند.

LLMها در برابر مدلهای مولد دامنهمحور

پس تفاوت LLMها و مدلهای مولد دامنهمحور چیست؟

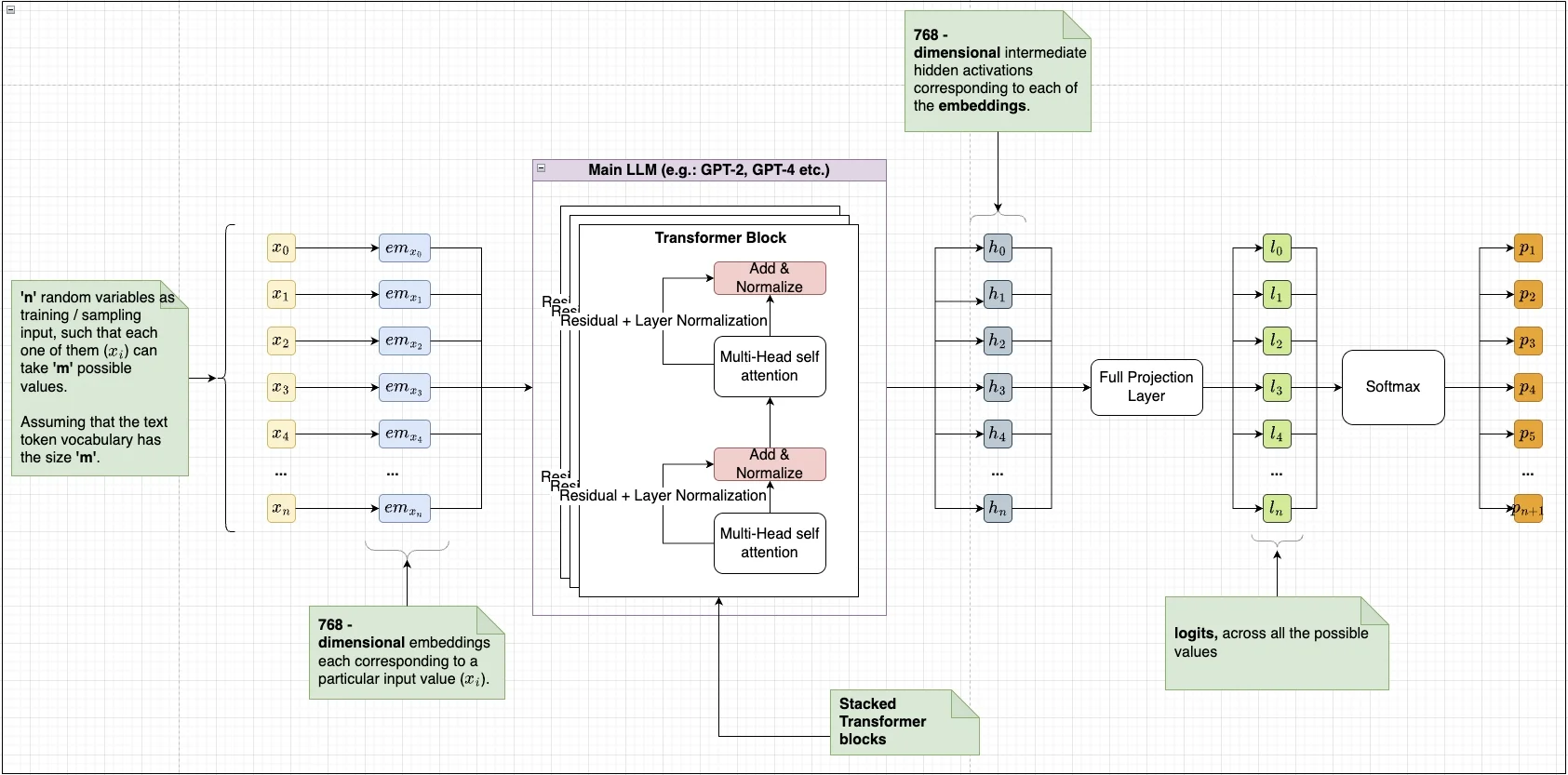

LLMهایی مثل GPT-4 مدلهای خودرگرسیو هستند که بر پایه معماری Transformer ساخته شدهاند، که نخستینبار توسط Vaswani و همکاران (۲۰۱۷) توصیف شد، و خروجی را با پیشبینی پیاپی توکن(های) بعدی بر اساس زمینه قبلی تولید میکنند. Transformerها به مکانیزمهای self-attention تکیه دارند که به مدل اجازه میدهد هنگام تولید متن، واژههای مختلف را نسبت به هم وزندهی کند. در طول آموزش، یک LLM حجم عظیمی از داده متنی را پردازش میکند تا یک توزیع احتمال تقریبزده یاد بگیرد (نمایانگر فضایی که داده آموزشی مشاهدهشده میتواند با بیشترین احتمال از آن نمونهبرداری شده باشد).

پس از آموزش، مدل متن را با نمونهبرداری پیاپی از این توزیع یادگرفتهشده و بر اساس متن ورودی ارائهشده تولید میکند. به همین دلیل است که LLMها در وظایف مرتبط با زبان طبیعی مثل ترجمه، تعاملات مکالمهای، خلاصهسازی و غیره فوقالعاده مؤثرند. با این حال، این نوع خروجی فقط بازتاب الگوهای آماری یادگرفتهشده از داده متنی است و فاقد درک صریح از قواعد یا روابط دامنهمحور است. معماری زیر بر اساس اصول Vaswani و همکاران (۲۰۱۷) و Radford و همکاران (۲۰۱۹) است.

در مقابل، مدلهای مولد دامنهمحور میتوانند طوری طراحی شوند که بهطور صریح از داده عملیاتی ساختاریافته و منحصر به یک دامنه کسبوکار یاد بگیرند و قواعد و محدودیتهای دامنه را مستقیماً در فرایند تولید خود تعبیه کنند. مشابه LLMها، آنها میتوانند با اصل خودرگرسیو بههمراه برخی تکنیکهای بهینهسازی مثل GFlowNet آموزش ببینند.

با این حال، برخلاف LLMهای عمومی، آنها صرفاً متن از نظر آماری محتمل را بازتولید نمیکنند. بلکه خروجیهای قابل اجرا و تصمیممحور تولید میکنند که برای شرایط و محدودیتهای بلادرنگ کسبوکار تنظیم شدهاند. این ویژگی آنها را بهطور ویژه برای ادغام در گردشکارهای عملیاتی مناسب میکند؛ جایی که خروجی قابل اتکا، ساختاریافته و عملیاتی، نه متن توصیفی، ضروری است.

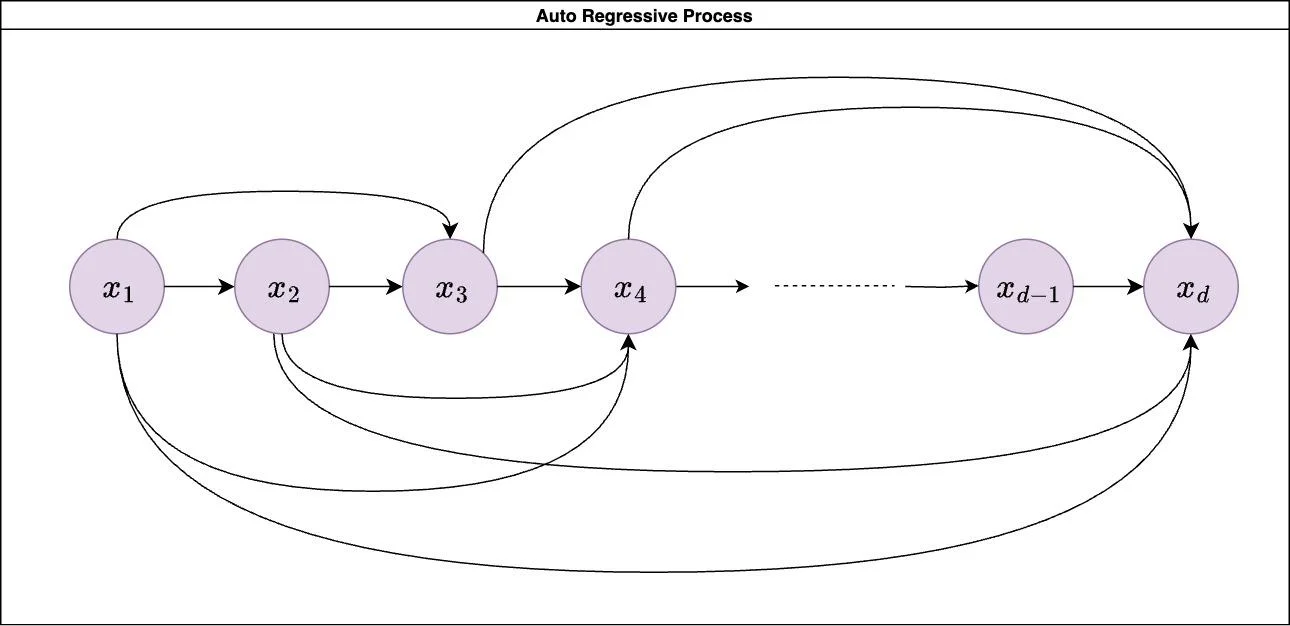

معرفی کوتاه مدلهای مولد خودرگرسیو

مدلهای مولد خودرگرسیو مدلهای احتمالاتی هستند که خروجی را بهصورت ترتیبی با نمونهبرداری از یک توزیع احتمال مشترک تولید میکنند؛ جایی که هر گام به همه رخدادهای قبلی شرطی شده است. این توزیع احتمال مشترک در طول آموزش آفلاین یاد گرفته میشود، با استفاده از توالیهای رخداد واقعی مشاهدهشده بهعنوان نقاط داده.

در طول آموزش، مدل احتمالهای شرطی را روی فضای رخداد اختصاص میدهد و پارامترهایش را طوری تنظیم میکند که رخدادهای تاریخی مشاهدهشده (نقاط داده واقعی) بیشترین احتمال را تحت توزیع یادگرفتهشده دریافت کنند. این مدلها در کاربردهایی که وابستگیهای ساختاریافته مهم هستند، بهطور گسترده استفاده میشوند؛ مثل پردازش زبان طبیعی، پیشبینی سری زمانی، و در مورد ما، تصمیمگیری راهبردی.

در خلاصه، فرایند خودرگرسیو احتمال مشترک یک توالی رخداد X را چنین برآورد میکند:

P(X)=p(x1)p(x2∣x1)p(x3∣x1,x2)…p(xd∣x1,x2,…,xd−۱)

که در آن:

X یک بردار ویژگی شامل ویژگیهای منفرد است.

x1,x2,x3,…,xd−۱,xd ویژگیهای منفردی هستند که نمایانگر رخدادهای کسبوکارند.

این یعنی مدل یاد میگیرد هر گام چگونه روی گام بعدی اثر میگذارد، و همین باعث میشود برای تولید توالیهای ساختاریافته و تصمیممحور مناسب باشد، چه داده متنی و چه غیرمتنی.

چرا فقط از LLMها استفاده نکنیم؟

LLMها مدلهای خودرگرسیویی هستند که روی پیکرههای عظیم متنی آموزش دیدهاند. این آنها را برای تولید متن قدرتمند میکند، اما ذاتاً برای مدلسازی تصمیمهای کسبوکار مناسب نیستند. یک LLM صرفاً توالیهای متنی با احتمال بالا را بر اساس داده آموزشیاش تولید میکند.

در مقابل، یک مدل خودرگرسیو دامنهمحور میتواند روی دادههای ساختاریافته تاریخی کسبوکار مثل رخدادهای زنجیره تامین یا بهینهسازیهای لجستیکی آموزش ببیند. در نتیجه، به جای تولید واژه بعدی با بیشترین احتمال در یک جمله، یک مدل دامنهمحور «تصمیم بعدی با بیشترین احتمال» را در یک فرایند کسبوکار از توزیع احتمال یادگرفتهشده خود نمونهبرداری میکند، در حالی که محدودیتهای کسبوکار و شاخصهای عملیاتی را در نظر میگیرد.

تعبیه محدودیتهای دامنه

برخلاف مدلهای خودرگرسیو عمومی، مدلهای دامنهمحور محدودیتها را مستقیماً در آموزش وارد میکنند تا توالیهای تولیدشده با سیاستهای عملیاتی، امنیتی، و مقرراتی سازگار باشند. این محدودیتها میتوانند:

-

محدودیتهای سخت (Hard Constraints): قواعد ثابت (مثل ضربالاجلهای تحویل، انطباق و مقررات).

-

محدودیتهای نرم (Soft Constraints): اهداف قابل بهینهسازی (مثل کمینه کردن هزینه، بیشینه کردن بهرهوری).

با یادگیری از توالی رخدادهای دامنهمحور ساختاریافته به جای متن عمومی، این رویکرد به کسبوکارها اجازه میدهد تصمیمگیری راهبردی را در مقیاس اتومات کنند و از ارکستریشن گردشکار مبتنی بر LLM فراتر بروند و به عملیات واقعاً تعبیهشده و AI-محور برسند.

اگر داده دنیای واقعی بهینه نباشد چه میشود؟

یک چالش کلیدی در آموزش مدلهای خودرگرسیو دامنهمحور این است که داده دنیای واقعی اغلب بهینه نیست. توزیع احتمال یادگرفتهشده بهطور طبیعی به سمت بازتولید الگوهایی میرود که در دیتاست مشاهده شدهاند. با این حال، اگر تصمیمهای تاریخی کسبوکار ناکارآمد بوده یا با محدودیتهای گذشته شکل گرفته باشند، مدل ذاتاً خروجیهای مشابه و زیربهینه تولید میکند. دقیقاً همینجاست که دلیل نیاز به رویکرد دامنهمحور روشن میشود: برای بهینهسازی همین فرایندهای زیربهینه هسته کسبوکار.

به همین دلیل، آموزش باید فرایند یادگیری خودرگرسیو را با یک حلقه بهینهسازی مبتنی بر پاداش (مثل GFlowNet) ترکیب کند. این کار تضمین میکند مدل به سمت توالیهایی هدایت میشود که اهداف مشخص کسبوکار را بیشینه میکنند، نه اینکه کورکورانه رفتارهای گذشته را کپی کند.

برای مثال:

مسیریابی لجستیک:

مسئله: داده تاریخی زنجیره تامین ممکن است برنامههای تحویل زیربهینه را نشان دهد، جایی که محمولهها بهطور مکرر به دلیل انتخاب مسیر ضعیف یا قواعد زمانبندی ثابت، به جای سازگاری با ترافیک، آبوهوا، یا شرایط ناوگان در زمان واقعی، با تاخیر مواجه شدهاند.

راهحل: ابتدا مدل از داده گذشته یاد میگیرد، سپس مسیرها را با بیشینهسازی تابع پاداش بهینه میکند تا زمان تحویل کمینه شود، هزینهها کاهش یابد، و بار ناوگان متعادل شود.

پیشبینی تقاضای خردهفروشی و تخصیص موجودی:

مسئله: به دلیل قواعد سختگیرانه تامین مجدد، تصمیمهای تاریخی موجودی ممکن است بازتابدهنده انباشت بیش از حد در مناطق کمتقاضا یا کمبود موجودی در مناطق پرتقاضا باشد.

راهحل: مدل ابتدا از داده تامین مجدد گذشته یاد میگیرد، اما توزیع احتمال خود را بر اساس عوامل پویا (فصلبودن، قیمتگذاری رقبا، و داده تردد/رفتوآمد) دوباره وزندهی میکند تا برنامههای تامین مجدد سازگار و بهینه از نظر درآمد تولید کند.

با پالایش تکرارشونده توزیع یادگرفتهشده با توالیهای بهینه، کسبوکارها میتوانند از AI توصیفی (تقلید تصمیمهای گذشته) به AI تجویزی (بهبود فعال تصمیمگیری) حرکت کنند.

حرکت از متن به کنشِ بومیِ مدل (Model-Native Action): تفاوتهای اصلی

در حالی که LLMها پذیرش AI را متحول کردهاند، اتکای آنها به توزیعهای احتمال مبتنی بر متن، ادغام آنها را در فرایندهای تصمیمگیری ساختاریافته دشوار میکند. به همین دلیل است که ۷۴٪ از سازمانها نمیتوانند فراتر از مرحله اثبات مفهوم (PoC) بروند. پذیرش AI آنها در حد تولید متن توصیفی متوقف میشود، نه تولید کنشهای کسبوکاری ساختاریافته و قابل اجرا. این به معنای انکار نقش عظیم LLMها در راهانداختن موج تحول فعلی AI نیست. با این حال، ادغام کامل و بیدردسر آنها با فرایندهای اصلی کسبوکار نسبت به Generative AI دامنهمحور دشوارتر است. بیایید این ادعا را بررسی کنیم تا تفاوتهای اصلی روشن شود.

LLMها برای تولید متن با مدلکردن احتمال آماری توالیهای کلمات از دیتاستهای عظیم آموزش میبینند. آنها ذاتاً منطق کسبوکار، محدودیتها، یا عملیات دنیای واقعی را درک نمیکنند. LLMها فقط متنی را تولید میکنند که بر اساس پیکرههای متنی قبلی از نظر آماری محتمل است. این موضوع آنها را برای فرایندهای تصمیممحور مثل لجستیک، مالی، یا بهینهسازی انرژی نامناسب میکند. این مدل صرفاً متن را از توزیع احتمال یادگرفتهشده نمونهبرداری میکند، آن هم مشروط به متن ورودی کاربر. برای سازگار کردن چنین مدلی با فرایند اصلی کسبوکار یک شرکت لجستیک (مثل محدودیتها و سیاستهای حاکم بر تصمیمهای مربوط به برنامه مسیر)، باید کارهای زیر انجام شود:

-

ارائه یک پایگاه دانش متنی به مدل (که احتمالاً بتواند آن را در حافظه ذخیره کند) شامل نقشه هابهای حملونقل، سیاستهای شرکت، قواعد خاص کشورها، و غیره.

-

استفاده از مهندسی پرامپت با system promptها برای هدایت مدل در تولید دستورالعملهای برنامه مسیر.

مدل سپس میتواند یک توصیف متنی منسجم و معنیدار از «چگونه یک برنامه مسیر اجرا شود» ارائه دهد، اما قواعد واقعی کسبوکار را نمیفهمد. نتیجه قابل اتکا، تکرارپذیر، یا قابل ادغام آسان با فرایندهای موجود کسبوکار نیست.

برخلاف LLMها، مدلهای مولد دامنهمحور مستقیماً روی تصمیمهای ساختاریافته دنیای واقعی کسبوکار آموزش میبینند. به جای تولید متن صرفاً محتمل، این مدلها یاد میگیرند محدودیتهای کسبوکار مثل قواعد لجستیک، سیاستهای انطباق، ساختار هزینه، و عوامل ریسک چگونه بر راهبردهای عملیاتی اثر میگذارند. این آموزش باعث میشود مدلها ذاتاً برای تصمیمگیری ساختاریافته و اجرای بلادرنگ مناسبتر از LLMها باشند که به مهندسی پرامپت گسترده و فیلترهای بیرونی نیاز دارند. این آموزش مستقیم مدل منجر میشود به کمینه کردن زمان ارسال، بیشینه کردن امنیت، کمینه کردن هزینه، و غیره. یک چارچوب agent روی این مدل بهصورت بیدردسر با فرایند اصلی کسبوکار شرکت ادغام میشود، چون برنامههای مسیر بهینه و قابل اجرا تولید میکند.

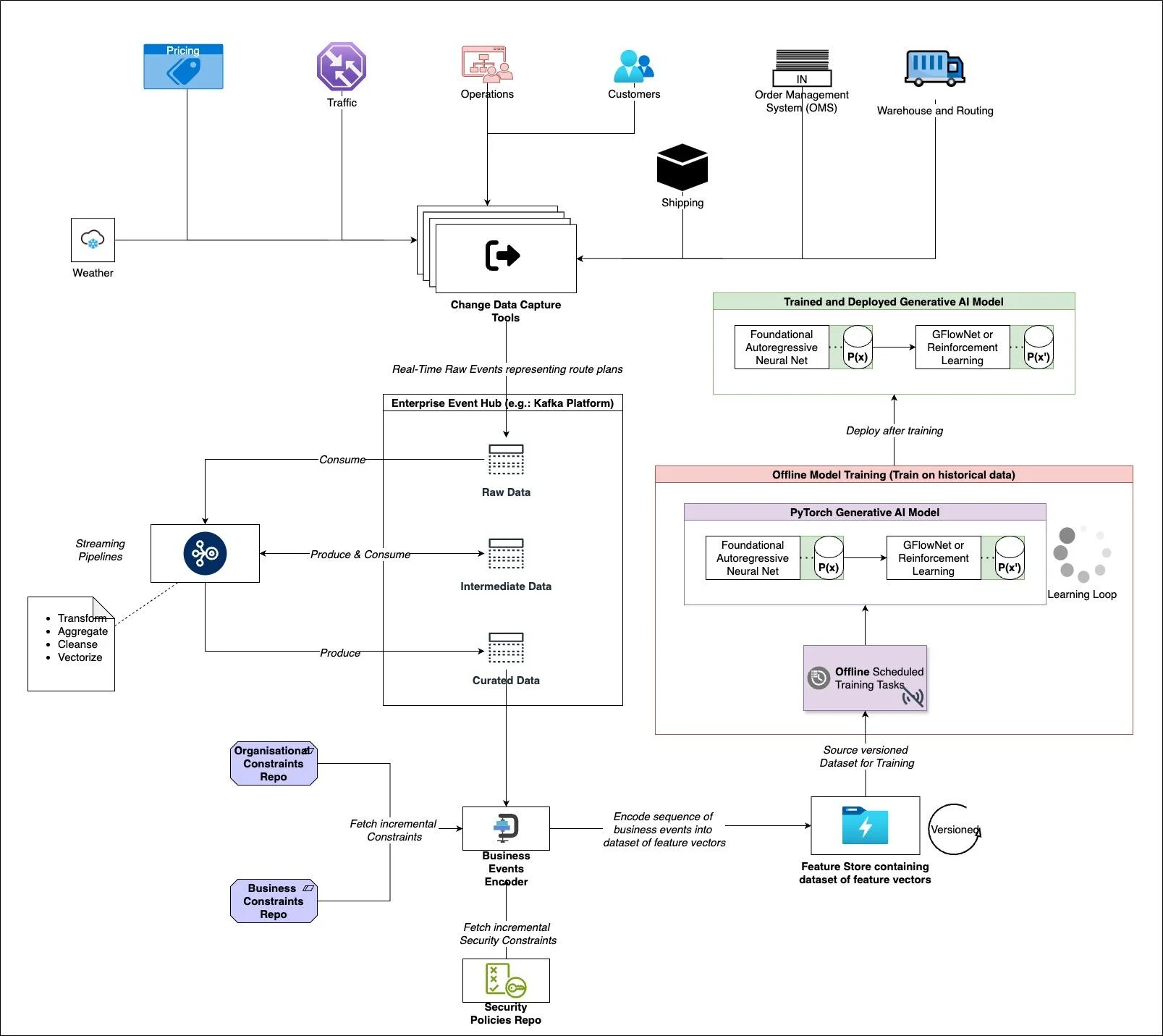

اصول کلیدی معماری

این بخش اصول اصلی معماری لازم برای ساخت و ادغام مدلهای هوش مصنوعی مولد دامنهمحور در سیستمهای سازمانی را بیان میکند. معماری از دو مولفه اصلی تشکیل میشود:

-

معماری آموزش آفلاین: یادگیری از توالیهای رخداد تاریخی ساختاریافته کسبوکار.

-

نمونهبرداری و تولید آنلاین: تولید راهبردهای تصمیمگیری بهینه در زمان واقعی.

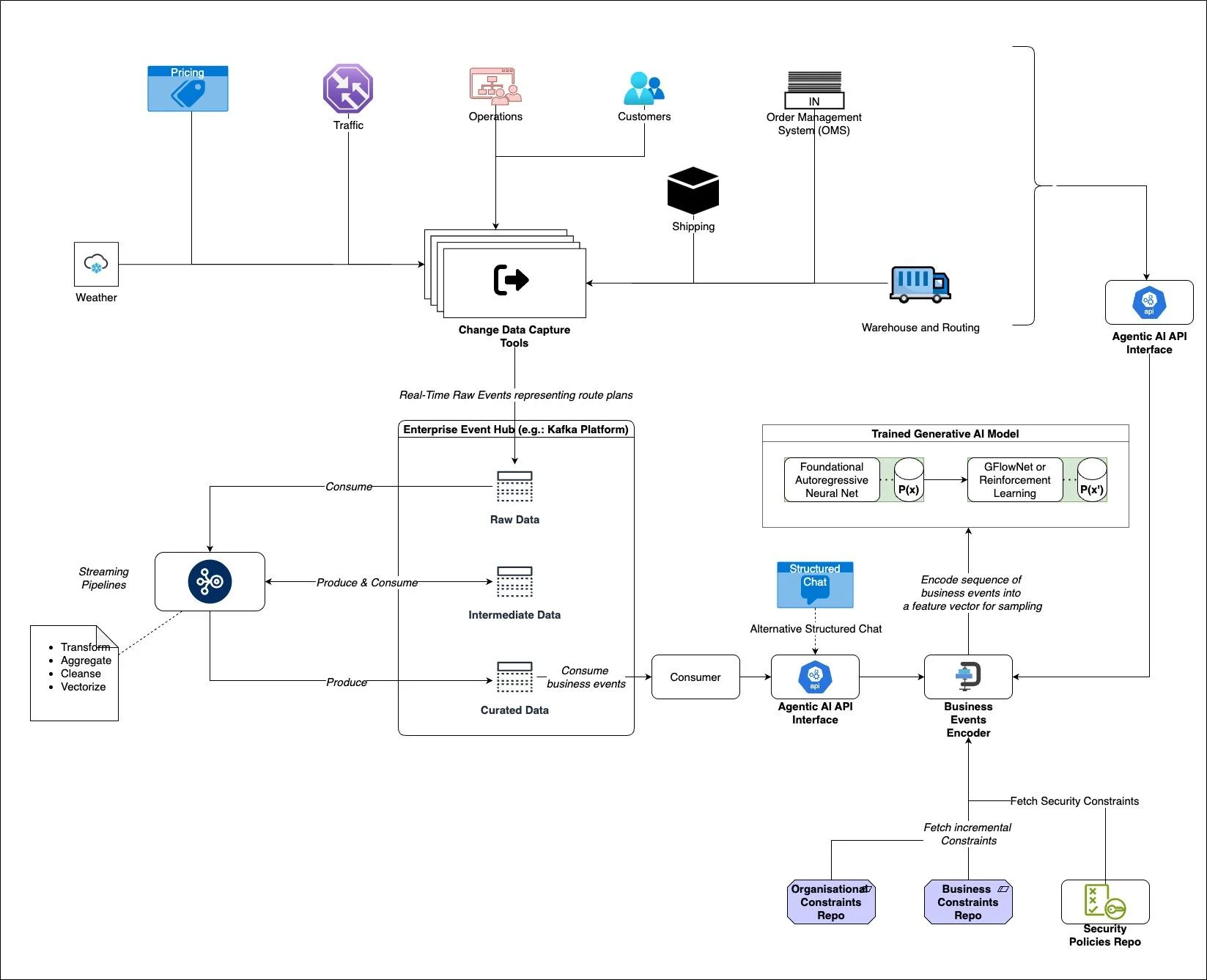

۱. آموزش آفلاین: یادگیری از داده تاریخی کسبوکار

پایپلاین آموزش آفلاین طراحی شده تا توالی رخدادهای تاریخی کسبوکار را دریافت کند و آنها را به توزیعهای احتمال یادگرفتهشده با استفاده از شبکههای عصبی خودرگرسیو و سپس بهینهسازی با GFlowNet یا یادگیری تقویتی (RL) تبدیل کند.

-

گردآوری داده سازمانی: رخدادهای کسبوکار از سیستمهای تراکنشی مختلف (مثل مدیریت سفارش، عملیات، قیمتگذاری، لجستیک و غیره) با مکانیزمهای event-driven مثل پایپلاینهای استریمینگ Kafka ثبت میشوند.

-

مهندسی ویژگی و کدگذاری: رخدادها قبل از ذخیره بهصورت دیتاست ساختاریافته، تبدیل، تجمیع، پاکسازی و برداریسازی میشوند.

-

ادغام محدودیتها: محدودیتهای کسبوکار، سیاستهای امنیتی و محدودیتهای سازمانی بهصورت پویا دریافت و در فضای ویژگی کدگذاری میشوند.

-

فرایند آموزش مدل:

-

مدلسازی احتمال خودرگرسیو: مرحله اول توزیع احتمال P(X) رخدادهای تصمیمگیری ترتیبی را با استفاده از یک Neural Autoregressive Estimator مدل میکند.

-

بهینهسازی با استفاده از GFlowNet: مرحله دوم توزیع احتمال یادگرفتهشده را به سمت یک توزیع بهینهشده P(X’) تنظیم میکند و از طریق فاینتیون مبتنی بر پاداش، راهبردهای بهینه را ترجیح میدهد.

-

پایپلاین آموزشی نسخهدار: مدل بهصورت زمانبندیشده با رخدادهای جدید کسبوکار دوباره آموزش میبیند تا بهروز بماند.

-

مدل آموزشدیده در انتهای این پایپلاین نمایانگر یک توزیع احتمال دامنهمحور یادگرفتهشده است که الگوهای تصمیم را ثبت کرده و میتواند در زمان واقعی نمونهبرداری شود.

۲. نمونهبرداری آنلاین: تولید توالیهای تصمیمگیری بهینه

بعد از آموزش، مدل در یک گردشکار سازمانی بلادرنگ مستقر میشود تا راهبردها و توالیهای تصمیمگیری بهینه را بهصورت پویا تولید کند.

-

معماری event-driven: رخدادهای زنده کسبوکار تراکنشی (مثل بهروزرسانیهای مسیر انبار، برنامهریزی مسیرهای لجستیکی، نوسانات قیمت) بهطور پیوسته وارد هاب رخداد سازمانی (پلتفرم Kafka) میشوند.

-

لایه API عاملمحور (Agentic AI): این لایه با سیستمهای بیرونی تعامل میکند، ورودیهای بلادرنگ را دریافت میکند و محدودیتهای لازم (سیاستهای امنیتی، هنجارهای مقرراتی، قواعد سفارشی کسبوکار) را واکشی میکند.

-

کدگذاری رخدادهای کسبوکار: رخدادهای ورودی به بردارهای ویژگی تبدیل میشوند و سپس برای inference استفاده میشوند.

-

اجرای مدل Generative AI:

-

نمونهبرداری خودرگرسیو: مدل خودرگرسیو پایه از P(X) نمونهبرداری میکند و یک توالی تصمیم اولیه تولید میکند.

-

پالایش مبتنی بر GFlowNet یا RL: شبکه بهینهسازی سیاست خروجیها را بیشتر اصلاح میکند تا تصمیمها با اهداف کسبوکار همراستا باشند (مثل کمینهسازی هزینه، بیشینهسازی بهرهوری).

-

-

استقرار و اجرای تصمیم: راهبرد تصمیمگیری بهینه تولیدشده به سیستمهای کسبوکار بازگردانده میشود (مثل سیستمهای مسیریابی در لجستیک، تنظیم قیمت در تجارت الکترونیک، راهبردهای بازگردانی در خدمات شهری انرژی).

چالشهای پیادهسازی

توسعه AI دامنهمحور بدون چالشهای خاص خودش نیست. این سختیها از دسترسبودن داده، پیچیدگی مدل، و محدودیتهای استقرار ناشی میشوند. بیایید هر کدام را بررسی کنیم.

-

دسترسبودن داده: بسیاری از بازیگران صنعتی در گذشته سیستمهایشان را برای جمعآوری و نگهداری داده طراحی نکردهاند، چه برسد به داده باکیفیت لازم برای ساخت بردارهای ویژگی که توالی رخدادهای کسبوکار را برای آموزش مدلهای AI نمایش دهد. وضعیت وقتی بدتر میشود که ببینیم بیشتر بازیگران صنعتی پیادهسازیهای کمتر از بهینهای از مدلهای داده «منبع حقیقت» سازمانی دارند. یعنی داده کسبوکار در سیستمهای مختلف تکهتکه است، سیلوها شکل گرفته و سیستمها مدل داده یکدیگر را نمیفهمند. برای مثال، سیستم CRM ممکن است کاملاً از ERP جدا باشد، و ERP با سیستم صورتحسابگیری همبستگی نداشته باشد و الی آخر. هرچند مدلهای AI باید بتوانند همبستگی را از داده خام این سیستمها یاد بگیرند، اما برای ساخت بردارهای ویژگی لازم برای آموزش، حداقلی از همبستگی لازم است.

-

پیچیدگی مدل: مدلهای مولد دامنهمحور باید بیش از تولید خروجیهای محتمل انجام دهند. آنها باید قواعد کسبوکار، محدودیتها، و سیاستهای خاص صنعت را بفهمند و اعمال کنند. برای مثال، برخی قواعد (مثل انطباق مقرراتی) باید بهصورت سختگیرانه اعمال شوند، در حالی که برخی دیگر (مثل بدهبستانهای کارایی-هزینه) به بهینهسازی منعطف نیاز دارند. همچنین مدل باید اهداف رقابتی را متوازن کند، مثل بهینهسازی همزمان سرعت، هزینه، و انطباق. همچنین برخلاف LLMها که متن آزاد تولید میکنند، مدلهای تولیدکننده تصمیم باید خروجیهای ساختاریافته و قابل اجرا تولید کنند که با گردشکارهای کسبوکار همراستا باشند.

-

استقرار: استقرار دشوار است چون نیاز به نسخه آفلاین برای آموزش و نسخه آنلاین برای نمونهبرداری از ورودیهای بلادرنگ تراکنشی دارد. این پیچیدگی استقرار را بالا میبرد و ترکیب تیم را هم پیچیدهتر میکند، چون حالا باید دانشمندان داده و مهندسان AI کنار تیمهای توسعه اپلیکیشن کار کنند. استقرار همچنین فشار روی فرایند استخدام سازمانی میگذارد. بسیاری از صنایع به زیرساخت IT چند دههای متکیاند که نمیتواند بهصورت بومی تصمیمگیری AI-محور را ادغام کند و استقرار باید با همین وضعیت کنار بیاید. در نهایت، چون راهبردهای عملیاتی و تصمیمگیری کسبوکار با AI درگیر میشود، باید راهی برای ممیزی و راستیآزمایی پیوسته درستی خروجیهای تولیدشده توسط AI وجود داشته باشد. این در فرایندهای نیمهخودکار با دخالت انسان بسیار چالشبرانگیز است.

چشمانداز آینده و ROI

با افزایش تمایل سازمانها به تحول AI-محور فراتر از اتوماسیون مبتنی بر متن، مدلهای مولد دامنهمحور آمادهاند تا جهش بزرگ بعدی در پذیرش AI باشند. این تغییر فقط کاهش هزینه نیست، بلکه فرصتهایی برای تحول فرایندهای اصلی کسبوکار، نوآوریهای درآمدزا، تعالی عملیاتی، و مقیاسپذیری در صنایع ارائه میکند.

-

مقیاسپذیری در دامنهها: اگرچه ما روی دامنه لجستیک و زنجیره تامین تمرکز کردیم، همین رویکرد بنیادین میتواند در صنایع زیادی اعمال شود که تصمیمگیری در آنها شامل فرایندهای ساختاریافته و ترتیبی است.

-

سلامت: بهینهسازی تخصیص منابع بیمارستان، زمانبندی بیمار، و اتوماسیون گردشکار بالینی.

-

تولید: هماهنگی زنجیره تامین مبتنی بر AI و زمانبندی تولید.

-

مالی: تقویت کشف تقلب، ارزیابی ریسک اعتباری، و راهبردهای معاملات الگوریتمی.

-

خردهفروشی: مدیریت موجودی مبتنی بر AI، پروموشنهای شخصیسازیشده، و راهبردهای قیمتگذاری پویا.

-

-

تعالی عملیاتی: برخلاف ابزارهای تحلیلی سنتی که به سیستمهای rule-based تکیه دارند، مدلهای مولد دامنهمحور میتوانند بهینهسازی پیوسته و سازگارانه را پیش ببرند. برای مثال، یک شرکت دارویی میتواند از یک مدل دامنهمحور برای بهینهسازی زمانبندی تولید دارو بر اساس دسترسبودن مواد اولیه، محدودیتهای مقرراتی، و پیشبینی تقاضای جهانی استفاده کند؛ تا زمان ورود به بازار سریعتر شود و اتلاف کمینه شود.

-

بازگشت سرمایه قوی (ROI) همراه با هزینه آموزش پایینتر: یکی از بزرگترین مزیتهای Generative AI دامنهمحور این است که به منابع محاسباتی عظیمی که برای آموزش LLMهای بزرگ مثل GPT یا Claude لازم است، نیاز ندارد. چرا این مدلها احتمالاً ROI قوی میدهند:

-

مدلهای کوچکتر و هدفمندتر: برخلاف LLMها که آموزش روی تریلیونها توکن میخواهند، مدلهای دامنهمحور میتوانند روی داده اختصاصی و صنعتمحور آموزش ببینند و نیاز محاسباتی را کاهش دهند.

-

دقت بیشتر: آموزش روی محدودیتهای کسبوکار و راهبردهای عملیاتی متمرکز است، پس رسیدن به دقت بالا شدنی است.

-

زمان رسیدن به ارزش سریعتر: چون این مدلها نیاز ندارند در چندین دامنه تعمیم داده شوند، سازمانها میتوانند سریعتر مستقرشان کنند و زودتر اثر کسبوکاری ببینند.

-

بهینهسازی مداوم: برخلاف LLMها که معمولاً بازآموزی پرهزینه میخواهند، مدلهای دامنهمحور میتوانند بهصورت افزایشی با داده جدید کسبوکار بهروزرسانی شوند و هزینهها در گذر زمان پایینتر بماند.

-

جمعبندی

تکامل سریع مدلهای زبانی بزرگ (LLMs) نقش AI در کسبوکار را بازتعریف کرده است، اما تحول واقعی AI-محور به مدلهایی نیاز دارد که فراتر از تولید متن باشند. برای آزاد کردن کامل ارزش کسبوکاری AI، سازمانها باید به سمت مدلهای AI مبتنی بر راهبرد حرکت کنند؛ مدلهایی که از داده تاریخی دامنهمحور یاد میگیرند، محدودیتها را تعبیه میکنند، و تصمیمهای بهینه و عملیاتی تولید میکنند، نه فقط توصیف متنی.

این مقاله یک نگاه جدید معرفی کرد: Agentic AI محدود به گردشکارهای متنی نیست. در حالی که LLMها میتوانند از طریق ارکستریشن مبتنی بر پرامپت اتوماسیون ایجاد کنند، مدلهای مولد دامنهمحور ادغام مستقیم با فرایندهای اصلی کسبوکار را ارائه میکنند. این مدلها بهطور ویژه برای صنایعی مناسباند که تصمیمگیری بلادرنگ، محدودیتهای عملیاتی، و تخصص دامنه نقش حیاتی دارند، مثل لجستیک، مالی، سلامت، و فراتر از آن. به عنوان رهبران AI، پژوهشگران، و تصمیمگیران کسبوکار، باید تصمیم بگیریم:

آیا AI صرفاً یک ابزار کمکی میماند که به اتوماسیون کارکردهای پشتیبانی محدود است؟

یا AI به یک موتور تصمیمگیری تکامل پیدا میکند و هوش صنعتمحور و تحول کسبوکار را پیش میبرد؟

وقت آن است که سازمانها AI را بهعنوان یک تصمیمگیر فعال بازتصور کنند، نه فقط یک دستیار مبتنی بر زبان. رهبران صنعت و پژوهشگران AI باید همکاری کنند تا آینده «هوش تصمیمگیری AI-محور» را شکل دهند؛ آیندهای که در آن بتوانیم AI را برای تحول فرایندهای اصلی کسبوکار در مقیاس به کار بگیریم.