یادگیری تقویتی با بازخورد انسانی (Reinforcement Learning From Human Feedback) چیست؟

یادگیری تقویتی با بازخورد انسانی (RLHF) یک تکنیک یادگیری ماشین (ML) است که از بازخورد انسانی برای بهینهسازی مدلهای یادگیری ماشین استفاده میکند تا خودآموزی کارآمدتری داشته باشند. تکنیکهای یادگیری تقویتی (RL) نرمافزار را برای تصمیمگیریهایی که پاداشها را به حداکثر میرسانند آموزش میدهند و نتایج آنها را دقیقتر میکنند. RLHF بازخورد انسانی را در تابع پاداش ادغام میکند تا مدل یادگیری ماشین بتواند وظایفی را انجام دهد که بیشتر با اهداف، خواستهها و نیازهای انسانی همراستا باشد. RLHF در کاربردهای مختلف هوش مصنوعی مولد (Generative AI)، از جمله مدلهای زبانی بزرگ (LLM)، استفاده میشود.

چرا RLHF مهم است؟

کاربردهای هوش مصنوعی (AI) بسیار گستردهاند، از خودروهای خودران گرفته تا پردازش زبان طبیعی (NLP)، پیشبینی بازار سهام و خدمات شخصیسازی خردهفروشی. صرفنظر از کاربرد، هدف نهایی هوش مصنوعی تقلید از پاسخها، رفتارها و تصمیمگیریهای انسانی است. مدل یادگیری ماشین باید ورودی انسانی را بهعنوان داده آموزشی کدگذاری کند تا هوش مصنوعی هنگام انجام وظایف پیچیده، بیشتر شبیه انسان عمل کند.

RLHF تکنیک خاصی است که برای آموزش سیستمهای هوش مصنوعی بهمنظور شبیهتر شدن به انسان استفاده میشود، در کنار تکنیکهای دیگری مانند یادگیری نظارتشده و بدون نظارت. ابتدا پاسخهای مدل با پاسخهای انسانی مقایسه میشوند. سپس یک انسان کیفیت پاسخهای مختلف ماشین را ارزیابی میکند و امتیازی به پاسخهایی که انسانیتر به نظر میرسند اختصاص میدهد. این امتیاز میتواند بر اساس ویژگیهای ذاتاً انسانی مانند دوستانه بودن، میزان مناسب زمینهسازی و حالت (mood) باشد.

RLHF در درک زبان طبیعی برجسته است، اما در سایر کاربردهای هوش مصنوعی مولد نیز استفاده میشود.

بهبود عملکرد هوش مصنوعی

RLHF مدل یادگیری ماشین را دقیقتر میکند. مدلها میتوانند روی دادههای انسانی از پیش تولیدشده آموزش ببینند، اما حلقههای بازخورد انسانی اضافی عملکرد مدل را بهطور قابلتوجهی نسبت به حالت اولیهاش بهبود میبخشد.

برای مثال، هنگام ترجمه متن از یک زبان به زبان دیگر، مدل ممکن است متنی تولید کند که از نظر فنی درست است اما برای خواننده غیرطبیعی به نظر میرسد. یک مترجم حرفهای میتواند ابتدا ترجمه را انجام دهد، ترجمه تولیدشده توسط ماشین با آن مقایسه شود و سپس مجموعهای از ترجمههای تولیدشده توسط ماشین برای کیفیت امتیازدهی شوند. افزودن آموزش بیشتر به مدل، آن را در تولید ترجمههای طبیعیتر بهتر میکند.

معرفی پارامترهای آموزشی پیچیده

در برخی موارد در هوش مصنوعی مولد، آموزش دقیق مدل برای پارامترهای خاصی دشوار است. برای مثال، چگونه حالت یک قطعه موسیقی را تعریف میکنید؟ ممکن است پارامترهای فنی مانند کلید و تمپو نشاندهنده حالت خاصی باشند، اما روح یک قطعه موسیقی ذهنیتر و کمتر از مجموعهای از جزئیات فنی تعریفشده است. در عوض، میتوانید راهنمایی انسانی ارائه دهید که در آن آهنگسازان قطعات با حالت خاص خلق کنند و سپس قطعات تولیدشده توسط ماشین را بر اساس سطح حالت آنها برچسبگذاری کنید. این کار به ماشین امکان میدهد این پارامترها را بسیار سریعتر یاد بگیرد.

افزایش رضایت کاربر

اگرچه یک مدل یادگیری ماشین میتواند دقیق باشد، ممکن است انسانی به نظر نرسد. RL برای هدایت مدل به سمت بهترین و جذابترین پاسخ برای کاربران انسانی مورد نیاز است.

برای مثال، اگر از یک چتبات بپرسید که وضعیت آبوهوا چگونه است، ممکن است پاسخ دهد: «دما ۳۰ درجه سانتیگراد با ابر و رطوبت بالا است» یا ممکن است بگوید: «دما در حال حاضر حدود ۳۰ درجه است. هوا ابری و مرطوب است، بنابراین ممکن است هوا سنگینتر به نظر برسد!» اگرچه هر دو پاسخ یک چیز را میگویند، پاسخ دوم طبیعیتر به نظر میرسد و زمینه بیشتری فراهم میکند.

با امتیازدهی کاربران انسانی به پاسخهای مدل که ترجیح میدهند، میتوانید از RLHF برای جمعآوری بازخورد انسانی و بهبود مدل خود برای خدمت بهتر به افراد واقعی استفاده کنید.

RLHF چگونه کار میکند؟

RLHF در چهار مرحله انجام میشود تا مدل آماده تلقی شود. در اینجا، ما از مثال یک مدل زبانی—یک چتبات پایگاه دانش داخلی شرکت—استفاده میکنیم که از RLHF برای پالایش استفاده میکند.

ما فقط یک مرور کلی از فرآیند یادگیری ارائه میدهیم. پیچیدگیهای ریاضی قابلتوجهی در آموزش مدل و پالایش سیاست آن برای RLHF وجود دارد. با این حال، فرآیندهای پیچیده در RLHF بهخوبی تعریف شدهاند و اغلب الگوریتمهای از پیش ساختهشدهای دارند که فقط به ورودیهای منحصربهفرد شما نیاز دارند.

جمعآوری داده

قبل از انجام وظایف یادگیری ماشین با مدل زبانی، مجموعهای از درخواستها و پاسخهای تولیدشده توسط انسان برای دادههای آموزشی ایجاد میشود. این مجموعه بعداً در فرآیند آموزش مدل استفاده میشود.

برای مثال، درخواستها ممکن است شامل موارد زیر باشند:

- «محل دپارتمان منابع انسانی در بوستون کجاست؟»

- «فرآیند تأیید پستهای رسانههای اجتماعی چیست؟»

- «گزارش سهماهه اول درباره فروش در مقایسه با گزارشهای سهماهه قبلی چه چیزی نشان میدهد؟»

سپس یک کارمند دانش در شرکت به این سؤالات با پاسخهای دقیق و طبیعی پاسخ میدهد.

تنظیم دقیق نظارتشده مدل زبانی

میتوانید از یک مدل پیشآموزشدیده تجاری بهعنوان مدل پایه برای RLHF استفاده کنید. میتوانید مدل را با استفاده از تکنیکهایی مانند تولید تقویتشده با بازیابی (RAG) به پایگاه دانش داخلی شرکت تنظیم دقیق کنید. هنگامی که مدل تنظیم دقیق شد، پاسخ آن به درخواستهای از پیش تعیینشده با پاسخهای انسانی جمعآوریشده در مرحله قبل مقایسه میشود. تکنیکهای ریاضی میتوانند درجه شباهت بین این دو را محاسبه کنند.

برای مثال، پاسخهای تولیدشده توسط ماشین میتوانند امتیازی بین ۰ تا ۱ دریافت کنند، که ۱ دقیقترین و ۰ کمدقتترین است. با این امتیازها، مدل اکنون سیاستی دارد که برای تشکیل پاسخهایی طراحی شده است که به پاسخهای انسانی نزدیکتر باشند. این سیاست اساس تمام تصمیمگیریهای آینده مدل را تشکیل میدهد.

ساخت یک مدل پاداش جداگانه

هسته RLHF آموزش یک مدل پاداش هوش مصنوعی جداگانه بر اساس بازخورد انسانی است و سپس استفاده از این مدل بهعنوان تابع پاداش برای بهینهسازی سیاست از طریق RL. با توجه به مجموعهای از پاسخهای متعدد از مدل که به یک درخواست یکسان پاسخ میدهند، انسانها میتوانند ترجیح خود را در مورد کیفیت هر پاسخ نشان دهند. از این ترجیحات رتبهبندی پاسخ برای ساخت مدل پاداش استفاده میشود که بهصورت خودکار تخمین میزند که یک انسان چه امتیازی به پاسخ هر درخواست میدهد.

بهینهسازی مدل زبانی با مدل مبتنی بر پاداش

سپس مدل زبانی از مدل پاداش برای پالایش خودکار سیاست خود قبل از پاسخ به درخواستها استفاده میکند. با استفاده از مدل پاداش، مدل زبانی بهصورت داخلی مجموعهای از پاسخها را ارزیابی میکند و سپس پاسخی را انتخاب میکند که به احتمال زیاد بیشترین پاداش را به دنبال داشته باشد. این به این معناست که به شیوهای بهینهتر با ترجیحات انسانی مطابقت دارد.

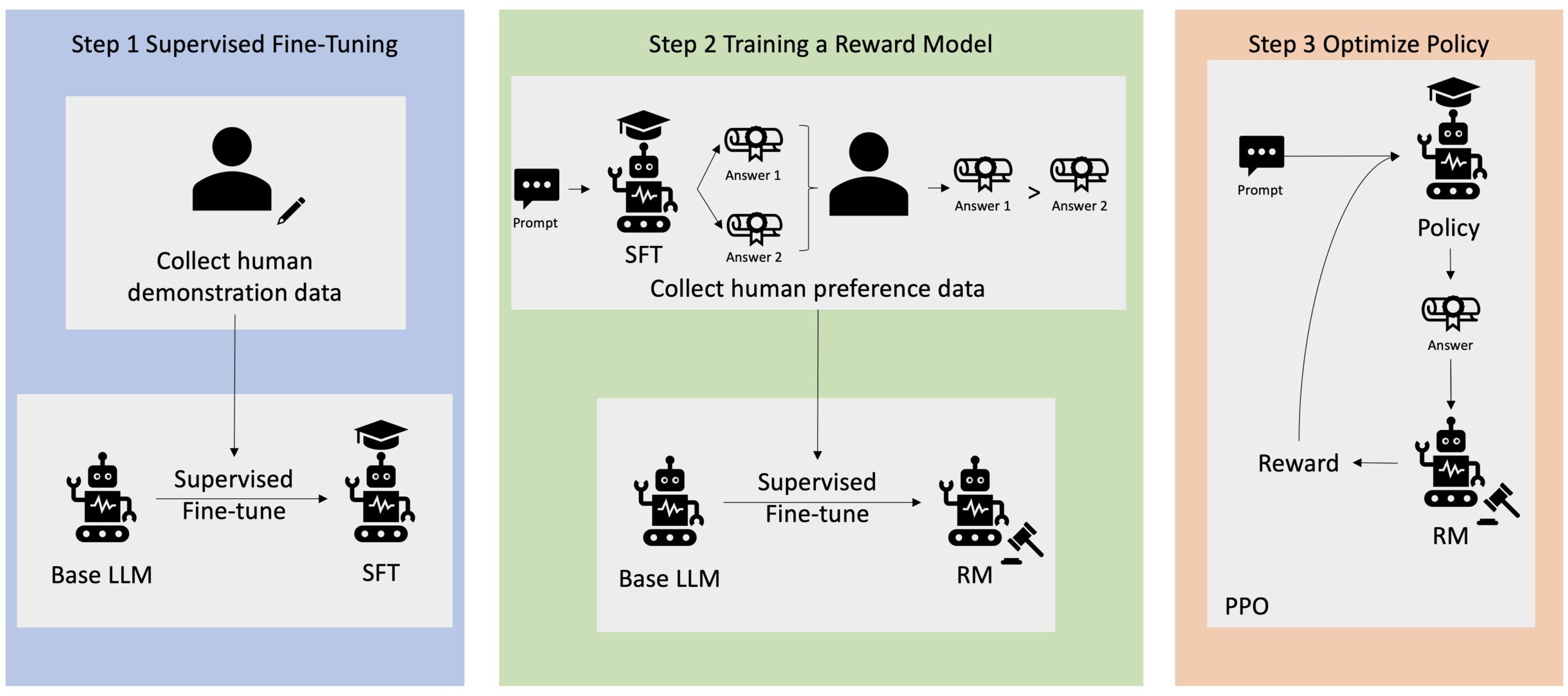

تصویر زیر یک مرور کلی از فرآیند یادگیری RLHF را نشان میدهد.

RLHF در حوزه هوش مصنوعی مولد چگونه استفاده میشود؟

RLHF بهعنوان تکنیک استاندارد صنعت برای اطمینان از تولید محتوای صادقانه، بیضرر و مفید توسط مدلهای زبانی بزرگ (LLM) شناخته میشود. با این حال، ارتباطات انسانی فرآیندی ذهنی و خلاقانه است—و مفید بودن خروجی LLM به شدت تحت تأثیر ارزشها و ترجیحات انسانی قرار دارد. هر مدل بهطور کمی متفاوت آموزش داده میشود و از پاسخدهندگان انسانی متفاوتی استفاده میکند، بنابراین خروجیها حتی بین LLMهای رقابتی نیز متفاوت است. میزان دخیل کردن ارزشهای انسانی کاملاً به سازنده بستگی دارد.

کاربردهای RLHF فراتر از مدلهای زبانی بزرگ به سایر انواع هوش مصنوعی مولد گسترش مییابد. در اینجا چند نمونه آورده شده است:

- RLHF میتواند در تولید تصاویر هوش مصنوعی استفاده شود: برای مثال، سنجش درجه واقعگرایی، فنی بودن یا حالت آثار هنری.

- در تولید موسیقی، RLHF میتواند به خلق موسیقیهایی که با حالات خاص و موسیقی متن فعالیتها مطابقت دارند کمک کند.

- RLHF میتواند در یک دستیار صوتی استفاده شود و صدا را به سمت دوستانهتر، کنجکاوتر و قابل اعتمادتر هدایت کند.