بسیاری از سازمانها داده را بهعنوان یک دارایی ارزشمند در نظر میگیرند. مدیریت و بهرهبرداری مؤثر از دادهها برای تصمیمگیری آگاهانه و رشد کسبوکار حیاتی است. این امر با ایجاد پایپلاین لوله دادهای که امکان انتقال یکپارچه دادهها بین سیستمهای مختلف در سازمان را فراهم میکنند، قابل دستیابی است.

بارگذاری داده یکی از مراحل اساسی در خط لوله داده است و نقش مهمی در انتقال دادهها از منبع به مقصد موردنظر شما ایفا میکند. این راهنمای جامع، تکنیکهای پیشرفته بارگذاری داده را بررسی میکند، از روشهای سنتی گرفته تا رویکردهای نوین که حجم عظیمی از دادهها را با کارایی بیسابقه مدیریت میکنند. شما خواهید آموخت که چگونه سازمانهای مدرن عملیات بارگذاری داده خود را از طریق انتخاب استراتژیک تکنیکها، معماریهای پردازش موازی و انتخابهای هوشمندانه فرمت فایل بهینهسازی میکنند.

بارگذاری داده چیست و چرا برای عملیات داده مدرن حیاتی است؟

بارگذاری داده شامل کپی و انتقال دادهها از یک فایل منبع، پایگاه داده یا برنامه به یک سیستم مقصد مانند انبار داده یا دریاچه داده است. این یک مرحله کلیدی در تکنیکهای پردازش داده مانند ETL (استخراج، تبدیل، بارگذاری) یا ELT (استخراج، بارگذاری، تبدیل) است و بهعنوان پایهای برای تمام فرآیندهای تحلیل و تصمیمگیری پاییندست عمل میکند.

بارگذاری داده اطمینان میدهد که دادههای شما بهراحتی در دسترس و در یک مخزن متمرکز برای همه تیمهای سازمان قابل استفاده است. این امکان را به شما میدهد تا سیستم مقصد را با اطلاعات دقیق و بهروز برای تحلیل، گزارشگیری و تصمیمگیری پر کنید. کارایی فرآیندهای بارگذاری داده شما بهطور مستقیم بر توانایی سازمان شما برای استخراج بینش از دادهها، پاسخ به تغییرات بازار و حفظ مزیتهای رقابتی از طریق استراتژیهای دادهمحور تأثیر میگذارد.

بارگذاری داده مدرن فراتر از انتقالهای انبوه ساده تکامل یافته و تکنیکهای پیچیدهای را در بر میگیرد که دادههای جریانی را مدیریت میکنند، کیفیت داده را حفظ میکنند و عملکرد را در سیستمهای توزیعشده بهینهسازی میکنند. با افزایش تصاعدی حجم دادههای تولیدشده توسط سازمانها از منابع متنوع مانند APIها، دستگاههای اینترنت اشیا (IoT)، پلتفرمهای رسانههای اجتماعی و پایگاههای داده عملیاتی پیچیدگی و اهمیت بارگذاری داده کارآمد همچنان رو به افزایش است.

مؤثرترین تکنیکهای بارگذاری داده کدامند؟

این بخش تکنیکهای مختلف بارگذاری داده را با مثالهایی بررسی میکند تا به شما در استراتژیسازی و تطبیق با نیازهای تجاری و دادهای در حال تحول کمک کند. با انتخاب دقیق روش مناسب، سازمان شما میتواند مصرف داده کارآمد و استفاده بهینه را تضمین کند، در حالی که مصرف منابع را به حداقل رسانده و تازگی داده را به حداکثر میرساند.

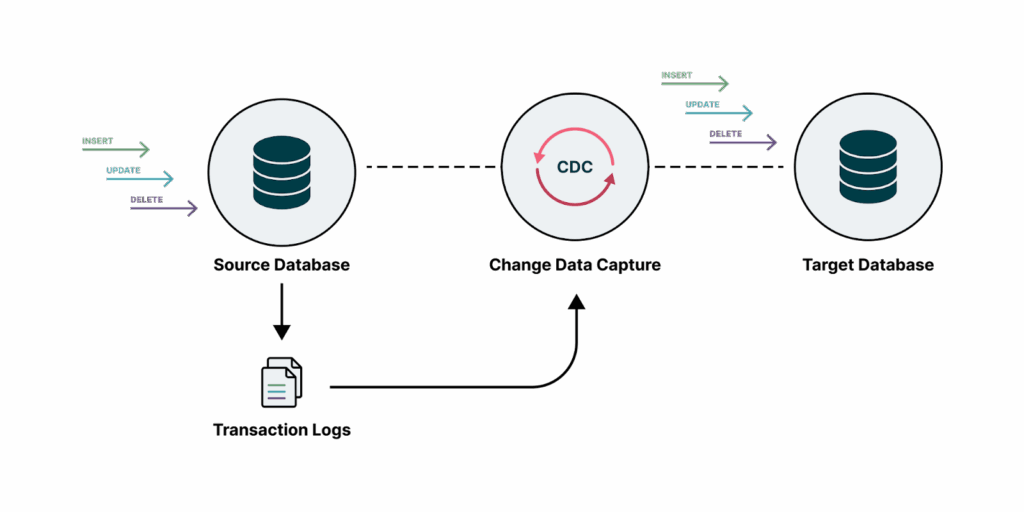

ثبت تغییرات داده (Change Data Capture – CDC)

میتوانید از ضبط تغییرات داده (CDC) هنگام کار با پایگاههای داده با حجم بالا که نیاز به بهروزرسانیهای مکرر یا همگامسازی داده در نزدیک به زمان واقعی دارند، استفاده کنید. این تکنیک به شما کمک میکند تا فقط تغییرات داده از آخرین بهروزرسانی را ضبط و انتقال دهید، که یکی از کارآمدترین رویکردها برای حفظ یکپارچگی داده در سیستمها است.

CDC به شما امکان میدهد تغییرات، درجها و حذفها را بهطور مؤثر ردیابی کنید و حجم انتقال داده و سربار پردازش را به حداقل برسانید. همچنین میتوانید آن را برای انبارهای داده و مخازن داده عملیاتی پیادهسازی کنید تا یکپارچگی و تازگی را حفظ کنید. پیادهسازیهای مدرن CDC از هر دو روش مبتنی بر لاگ (که لاگهای تراکنش پایگاه داده را میخواند) و روشهای مبتنی بر تریگر (که از تریگرهای پایگاه داده برای ردیابی تغییرات استفاده میکنند) پشتیبانی میکنند.

برای مثال، اگر یک پلتفرم تجارت الکترونیک نیاز به همگامسازی دادههای موجودی خود در چندین سیستم در نزدیک به زمان واقعی داشته باشد، میتواند از CDC استفاده کند. این رویکرد به پلتفرم کمک میکند تا فقط تغییرات انجامشده در پایگاه داده موجودی را ضبط و منتشر کند، مصرف پهنای باند شبکه را کاهش دهد و دسترسی به دادهها را در کمتر از یک ثانیه برای عملیات تجاری حیاتی فراهم کند.

روشهای بارگذاری افزایشی (Incremental Loading)

بارگذاری افزایشی به سنگ بنای حرکت داده کارآمد تبدیل شده است، بهویژه زمانی که اندازه مجموعه دادهها از رشد پهنای باند شبکه پیشی میگیرد. با انتقال تنها زیرمجموعههای داده تغییر یافته، سازمانها تأخیر استخراج را کاهش میدهند در حالی که رقابت منابع در سیستمهای منبع را به حداقل میرسانند. این روش فراتر از بهبود عملکرد ساده گسترش مییابد و موارد استفادهای را که قبلاً غیرعملی بودند، مانند تکثیر داده زیر یک دقیقه بین پایگاههای داده تراکنشی و پلتفرمهای تحلیلی، امکانپذیر میکند.

رایجترین رویکرد پیادهسازیشده از ستونهای تاریخچه تغییر (modified datetime) برای جداسازی رکوردهای جدید و بهروزرسانیشده استفاده میکند. اجرای فنی شامل ذخیرهسازی زمان آخرین استخراج موفق و سپس پرسوجو برای رکوردهایی است که از آن مقدار در اجراهای بعدی فراتر میروند. یک پلتفرم تجارت الکترونیک ممکن است از این روش برای همگامسازی ساعتی تغییرات وضعیت سفارش از سیستمهای OLTP به داشبوردهای خدمات مشتری استفاده کند، و اطمینان دهد که تیمهای پشتیبانی به اطلاعات بهروز دسترسی دارند بدون اینکه سیستمهای منبع را تحت فشار قرار دهند.

استراتژیهای افزایشی پیشرفته شامل پردازش تفاوتهای لحظهای (snapshot differential) زمانی است که متادیتای زمانی در دسترس نیست. تیمهای مهندسی داده این را با ذخیرهسازی استخراجهای قبلی و سپس اجرای عملیات مجموعه برای شناسایی تفاوتها پیادهسازی میکنند. این رویکرد برای منابع نیمهساختاریافته مانند APIهای JSON که زمانهای تغییر غیرقابلاعتماد یا غایب هستند مناسب است، اگرچه سربار محاسباتی با افزایش اندازه مجموعه داده افزایش مییابد.

کدام روشهای بارگذاری داده را باید برای کسبوکار خود انتخاب کنید؟

بسته به حجم داده و فرکانس بهروزرسانیها، بارگذاری داده میتواند شامل روشهای مختلفی از جمله بارگذاری کامل، بارگذاری افزایشی و بارگذاری دستهای باشد. رویکردی را انتخاب کنید که با استراتژی مدیریت داده سازمان شما همخوانی داشته باشد و نیازهای عملکرد را با محدودیتهای منابع متعادل کند.

- بارگذاری دستهای (Batch Loading)

انتقال حجم زیادی از داده بهصورت انبوه در فواصل زمانی برنامهریزیشده، معمولاً با استفاده از ابزارهای ETL. این روش برای سازمانهایی با نوسانات داده کم و نیازهای زمان واقعی حداقل مناسب است. بارگذاری دستهای در پردازش دادههای تاریخی، انجام تبدیلهای پیچیده یا مدیریت منابع دادهای که صادرات دورهای ارائه میدهند، برتری دارد. این روش امکان بررسیهای جامع کیفیت داده و اعتبارسنجی قبل از بارگذاری را فراهم میکند و برای سناریوهای انطباق نظارتی ایدهآل است. ابزارهایی که در بارگذاری دستهای برتری دارند شامل Airbyte، Informatica و Talend هستند. - بارگذاری جریانی یا زمان واقعی (Real-Time or Stream Loading)

بارگذاری و پردازش مداوم دادهها بهمحض تولید، و فراهم کردن دسترسی فوری به آخرین اطلاعات. این روش برای جریانهای داده با سرعت بالا و برنامههایی که نیاز به بینشهای زمان واقعی دارند، مانند تشخیص تقلب، موتورهای شخصیسازی و سیستمهای نظارت عملیاتی، ایدهآل است. بارگذاری جریانی به سازمانها امکان میدهد به رویدادها بهمحض وقوع واکنش نشان دهند و از موارد استفادهای پشتیبانی میکند که تازگی داده مستقیماً بر نتایج تجاری تأثیر میگذارد. ابزارهای پیشرو برای بارگذاری جریانی شامل Apache Kafka، Matillion و Confluent هستند. - بارگذاری افزایشی (Incremental Loading)

انتقال تنها دادههای جدید یا تغییر یافته از آخرین بارگذاری به جای کل مجموعه داده. این رویکرد نیاز به مدیریت دقیق برای ردیابی و اعمال تغییرات به ترتیب صحیح در حالی که یکپارچگی ارجاعی حفظ میشود، دارد. بارگذاری افزایشی زمان پردازش و مصرف منابع را بهطور قابلتوجهی کاهش میدهد و برای مجموعه دادههای بزرگی که بهطور مکرر تغییر میکنند ضروری است. این تکنیک بهویژه برای حفظ انبارهای داده که در آن تازهسازی کامل پرهزینه یا زمانبر است، ارزشمند است. - بارگذاری کامل-تازهسازی (Full-Refresh Loading)

جایگزینی کل مجموعه داده در سیستم مقصد با یک کپی جدید از دادهها. این روش برای بارگذاریهای اولیه، رفع مشکلات یکپارچگی داده یا انجام بازنویسیهای کامل زمانی که رویکردهای افزایشی پیچیده یا غیرقابلاعتماد میشوند، مفید است. بارگذاری کامل-تازهسازی دقت کامل را تضمین میکند اما به منابع قابلتوجهی و پنجرههای پردازش طولانی نیاز دارد. ابزارهایی مانند Airbyte، Hevo و Fivetran قابلیتهای قوی کامل-تازهسازی را با ویژگیهای بهینهسازی برای به حداقل رساندن زمان توقف ارائه میدهند.

چگونه تکنیکهای پردازش موازی پیشرفته میتوانند عملکرد بارگذاری داده شما را تسریع کنند؟

موازیسازی بهعنوان عامل کلیدی برای بارگذاری مجموعه دادههای میلیارد رکوردی در پنجرههای زمانی عملی ظاهر شده است. با توزیع بارهای کاری در چندین پردازنده، سیستمها مدت زمان بارگذاری را بهصورت خطی با تخصیص منابع کاهش میدهند. این مقیاسپذیری برای حفظ پنجرههای بارگذاری با وجود رشد تصاعدی دادهها ضروری است.

استراتژیهای پارتیشنبندی افقی برای عملیات بارگذاری داده عظیم

موازیسازی مؤثر با پارتیشنبندی هوشمند داده آغاز میشود، جایی که زیرمجموعههای مجزا بهصورت مستقل پردازش میشوند. پارتیشنبندی محدودهای بر روی ستونهای زمانی یا عددی امکان بارگذاری همزمان بخشهای غیرهمپوشان را فراهم میکند. یک پلتفرم تحلیل مشتری ممکن است پردازش را در بارگذاریهای شبانه بر اساس مناطق جغرافیایی توزیع کند و زمان پردازش را از ساعتها به دقیقهها از طریق توزیع استراتژیک بارگذاری داده کاهش دهد.

این تکنیک نیاز به منابع سازگار با پارتیشن دارد، جایی که پایگاههای داده رابطهای از طریق شاردینگ این را پشتیبانی میکنند، در حالی که سیستمهای NoSQL مانند Cassandra بهصورت بومی داده را پارتیشنبندی میکنند. چالشهای پیادهسازی شامل انحراف پارتیشن است که توزیع نابرابر رکوردها باعث عدم تعادل منابع میشود و از طریق الگوریتمهای توزیع مجدد پویا که توان عملیاتی کارگر را نظارت کرده و بارها را بهصورت خودکار متعادل میکنند، کاهش مییابد.

پیادهسازیهای نویسنده همزمان

اجرای بارگذاری موازی از طریق فرآیندهای چندنخی یا خوشههای توزیعشده ظاهر میشود. اولی برای سناریوهای تکماشینی مناسب است، جایی که سیستمهای پایگاه داده مانند SQL Server با پیکربندی با نخهای موازی بهبودهای عملکرد قابلتوجهی نشان میدهند. چارچوبهای توزیعشده مانند Spark مقیاس بیشتری را با تقسیم مجموعه دادهها در گرههای کارگر به دست میآورند که هر یک بهطور مستقل به سیستمهای مقصد مینویسند.

تکنیکهای بهینهسازی درج انبوه

رابطهای بارگذاری انبوه تخصصی با دور زدن سربار تراکنشی از طریق نوشتن مستقیم به فرمتهای ذخیرهسازی، عملکرد را بهبود میبخشند. ابزار BCP در SQL Server و دستور COPY در PostgreSQL بارگذاریهایی به مراتب سریعتر از دستورات INSERT معادل به دست میآورند با به حداقل رساندن سربار ثبت لاگ.

این تکنیک نیاز به مرحلهبندی فایل میانی از طریق ذخیرهسازی ابری یا SSDهای محلی دارد اما سرعت بینظیری را برای بارگذاریهای اولیه داده ارائه میدهد. انتخاب فرمت بهطور قابلتوجهی بر عملکرد تأثیر میگذارد، جایی که فرمتهای ستونی مانند Parquet امکان فشار محمولات به پایین را در طول بارگذاری فراهم میکنند و بلوکهای غیرمرتبط را قبل از مصرف کنار میگذارند. پیادهسازیهای پیشرفته بارگذاری انبوه را با پایپلاین لوله تبدیل ترکیب میکنند، جایی که فایلهای میانی به ساختارهای بهینه پیشتجمیع میشوند.

استراتژیهای بهینهسازی فرمت فایل چه تأثیری بر کارایی بارگذاری داده شما دارند؟

فرمتهای سریالسازی داده بهطور مستقیم بر کارایی بارگذاری از طریق نسبتهای فشردهسازی، قابلیتهای تکامل طرحواره و پتانسیل بهینهسازی پرسوجو تأثیر میگذارند. فرمتهای باینری مدرن نیازهای ذخیرهسازی را کاهش میدهند در حالی که پردازش پاییندست را تسریع میکنند و عامل کلیدی در بارگذاری ترابایتها به سیستمهای تحلیلی را نشان میدهند. انتخاب فرمت یک تعادل اساسی بین بهینهسازی نوشتن و بهینهسازی خواندن برای پرسوجوهای تحلیلی را نشان میدهد.

مزایای ذخیرهسازی ستونی برای فرآیندهای بارگذاری داده با حجم بالا

فرمتهای ستونمحور مانند Parquet و ORC دادهها را بهصورت عمودی به جای ردیفی بازآرایی میکنند و عملکرد تحولی را برای بارهای کاری تحلیلی ارائه میدهند. با ذخیرهسازی تمام مقادیر یک ستون بهصورت پیوسته، این فرمتها از طریق الگوهای داده مشابه فشردهسازی بهتری به دست میآورند و امکان اسکن ستونی انتخابی را در طول پرسوجوها فراهم میکنند. یک پلتفرم تحلیل رفتار مشتری ممکن است فایلهای Parquet را بارگذاری کند تا پرسوجوهای تقسیمبندی را که فقط ستونهای تاریخچه خرید را اسکن میکنند، تسریع کند.

این فرمت بهویژه برای جدولهای عریض با الگوهای دسترسی پراکنده برجسته است، جایی که بنچمارکها نشاندهنده تجمیعهای به مراتب سریعتر در مقایسه با فرمتهای ردیفی است. بهینهسازیهای بارگذاری شامل کدگذاری دیکشنری برای فیلدهای با کاردینالیتی پایین و الگوریتمهای فشردهسازی تطبیقی است که سرعت را با نسبتها متعادل میکنند. پلتفرمهای ابری مانند BigQuery بهطور خودکار دادههای مصرفشده را به داخلیهای ستونی تبدیل میکنند، اما پیشفرمتسازی در طول بارگذاری سربار تبدیل را کاهش میدهد.

پشتیبانی از تکامل طرحواره برای نیازهای بارگذاری داده پویا

پایپلاین لوله داده مدرن باید ساختارهای در حال تغییر را بدون بارگذاری مجدد دادههای تاریخی تطبیق دهند، جایی که Avro با تعاریف طرحواره تعبیهشده در هر فایل برتری دارد. فرمت خودتوصیفی طرحوارههای JSON را در کنار دادههای باینری ذخیره میکند و به مصرفکنندگان امکان میدهد فایلهای تاریخی را با استفاده از طرحوارههای معاصر تفسیر کنند. این برای پلتفرمهای انطباق که تغییرات نظارتی را ردیابی میکنند و دورههای نگهداری چندین نسخه طرحواره را در بر میگیرند، بسیار ارزشمند است.

در طول بارگذاری، عدم وجود سربار نمایهسازی Avro نوشتن را در مقایسه با Parquet تسریع میکند، اگرچه عملکرد پرسوجو به دلیل فقدان سازمان ستونی کاهش مییابد. بهترین شیوههای پیادهسازی شامل ادغام رجیستری طرحواره است که تعاریف متمرکز از انحراف نسخه در گروههای تولیدکننده و مصرفکننده جلوگیری میکند. برای نیازهای ترکیبی، فرمتهای Delta Lake انطباق ACID را بر روی فایلهای Parquet لایهبندی میکنند در حالی که از تغییرات طرحواره در محل پشتیبانی میکنند.

تکنیکهای بهینهسازی فشردهسازی

فشردهسازی داده در طول بارگذاری زمانهای انتقال شبکه و هزینههای ذخیرهسازی را کاهش میدهد اما سربار CPU را معرفی میکند. انتخاب الگوریتم این عوامل را متعادل میکند، جایی که فشردهسازی Snappy نسبتهای متوسطی با تأثیر حداقل CPU به دست میآورد، در حالی که GZIP نسبتهای بالاتری با هزینه محاسباتی ارائه میدهد. پیادهسازیهای پیشرفته از ویژگیهای ستونی بهره میبرند، جایی که Parquet الگوریتمهای متفاوتی را برای هر نوع ستون پشتیبانی میکند، از جمله کدگذاری طول اجرا برای بولینها و کدگذاری دلتا برای زمانبندیها.

خدمات بارگذاری ابری بهطور خودکار فشردهسازی را در طول نوشتنهای ذخیرهسازی شیء اعمال میکنند و تنها نیاز به مشخص کردن الگوریتم در پیکربندی دارند. برای سیستمهای تحلیلی، فرمتهای فشرده باید قابلتقسیم باقی بمانند تا پردازش موازی را در طول بارگذاری فعال کنند. الگوریتم نوظهور ZStandard بهطور فزایندهای جایگزین گزینههای قدیمیتر میشود و نسبتهای GZIP را با سرعت Snappy ارائه میدهد و تأخیر بارگذاری را کاهش میدهد در حالی که اثربخشی فشردهسازی را حفظ میکند.

ابزارها و فناوریهای پیشرو بارگذاری داده امروزی کدامند؟

در زیر ابزارهایی آورده شدهاند که بارگذاری داده به انبارهای داده یا دریاچههای داده را خودکار و ساده میکنند و بهرهوری و کیفیت داده را از طریق مجموعههای ویژگی قوی و قابلیتهای درجه سازمانی بهبود میبخشند.

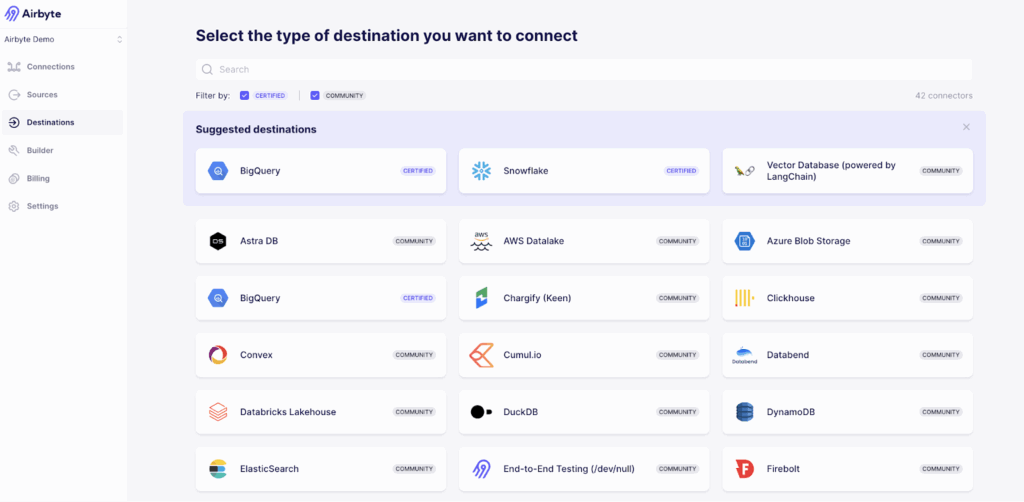

- Airbyte

Airbyte یک پلتفرم جامع یکپارچهسازی داده است که کاتالوگ بیش از ۶۰۰ کانکتور برای منابع داده ساختاریافته و بدون ساختار ارائه میدهد. این پلتفرم با پایهای متنباز و افزونههای درجه سازمانی، نحوه رویکرد سازمانها به یکپارچهسازی داده را با ارائه قابلیت انتقال، دقت و امنیت بدون قفل شدن به فروشنده تغییر میدهد.

ویژگیهای کلیدی شامل بارگذاری افزایشی، CDC، تازهسازی کامل، پردازش دستهای و مدیریت پیشرفته تغییرات طرحواره است. قابلیتهای امنیتی Airbyte شامل انطباق با ISO 27001، SOC 2، GDPR و HIPAA، با استقرارهای سازمانی که از کنترل دسترسی مبتنی بر نقش، رمزنگاری در سطح ستون و حاکمیت چندفضایی پشتیبانی میکنند. ارزش پیشنهادی منحصربهفرد این پلتفرم ترکیبی از انعطافپذیری متنباز با امنیت درجه سازمانی است و به سازمانها امکان میدهد از قفل شدن به فروشنده اجتناب کنند در حالی که به بیش از ۶۰۰ کانکتور پیشساخته و قابلیتهای یکپارچهسازی سفارشی از طریق سازنده کانکتور کمکد دسترسی دارند.

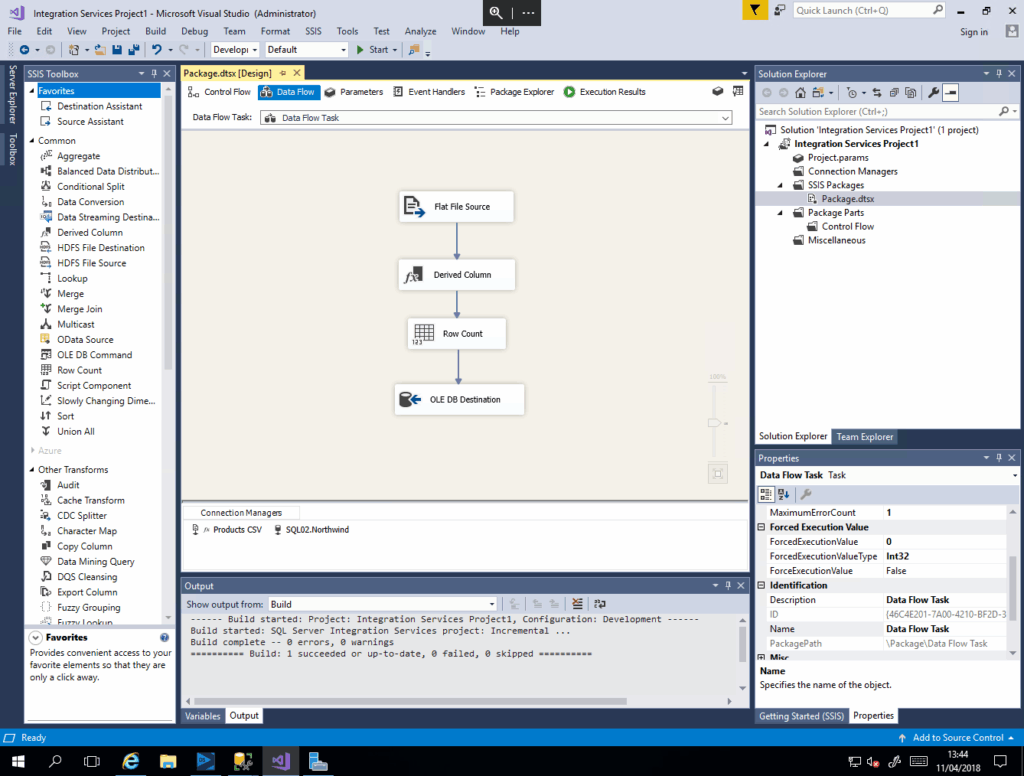

- خدمات یکپارچهسازی SQL Server (SSIS)

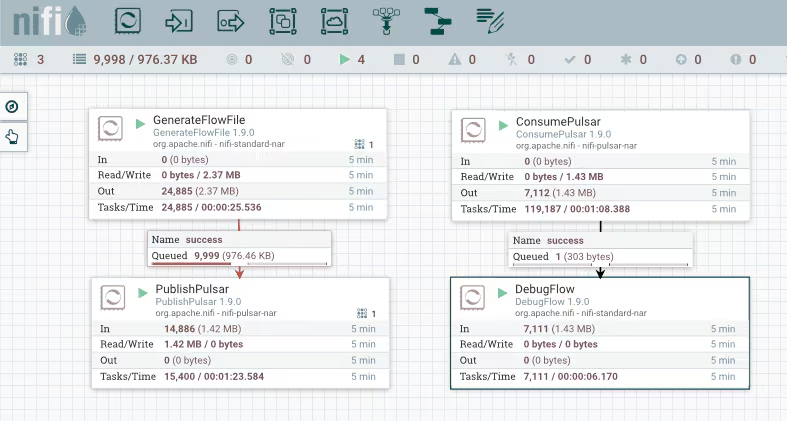

SSIS یک پلتفرم قوی برای عملیات ETL در سطح سازمانی است که رابط گرافیکی جامع، کانکتورهای متنوع، تبدیلهای داخلی و قابلیتهای پیشرفته مدیریت خطا را ارائه میدهد. این پلتفرم بهطور یکپارچه با اکوسیستم مایکروسافت ادغام میشود و ابزارهای دیباگینگ قدرتمند و قابلیتهای ثبت لاگ گستردهای را برای عملیات داده سازمانی فراهم میکند. - Apache NiFi

Apache NiFi اتوماسیون جریان داده را با یک رابط کاربری بصری کشیدن و رها کردن، ردیابی جامع اصل و نسب داده و ویژگیهای امنیتی قوی ساده میکند. این پلتفرم در مدیریت سناریوهای مسیریابی پیچیده برتری دارد و نظارت در زمان واقعی جریانهای داده را با ردیابی دقیق اصل و نسب ارائه میدهد. - Talend

Talend قابلیتهای جامع ETL، کیفیت داده، حاکمیت و یکپارچهسازی ابری را از طریق یک محیط بصری کشیدن و رها کردن ارائه میدهد. این پلتفرم قابلیتهای تبدیل گسترده و مدیریت قوی متادیتا را برای عملیات داده سازمانی فراهم میکند. - AWS Glue

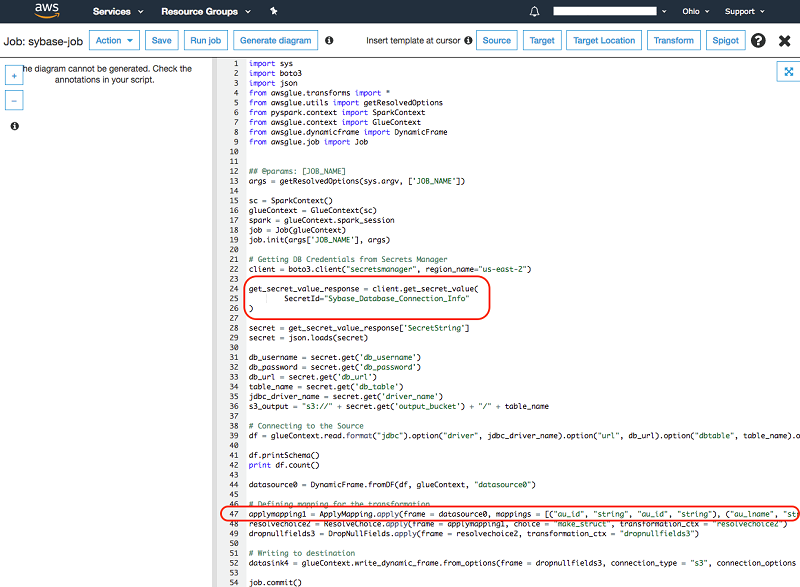

AWS Glue یک ابزار یکپارچهسازی داده بدون سرور با کشف خودکار طرحواره، تولید خودکار کد در پایتون یا اسکالا و ادغام یکپارچه با خدمات AWS است. این پلتفرم مقیاسبندی زیرساخت مدیریتشده و قابلیتهای کاتالوگ داده یکپارچه را برای عملیات داده بومی ابری فراهم میکند.

چالشهای اصلی که هنگام بارگذاری داده در مقیاس با آن مواجه خواهید شد چیست؟

بارگذاری داده در مقیاس سازمانی چالشهای پیچیدهای را معرفی میکند که نیاز به برنامهریزی استراتژیک و رویکردهای معماری قوی دارند. درک این چالشها امکان استراتژیهای کاهش پیشفعال را فراهم میکند که عملیات داده موفق را تضمین میکنند.

- مدیریت حجم زیاد دادهها – پردازش ترابایتها یا پتابایتها داده زمانبر و منابعبر است و نیاز به برنامهریزی و بهینهسازی دقیق زیرساخت دارد. سازمانها باید سرعت پردازش را با کارایی هزینه متعادل کنند در حالی که قابلیت اطمینان سیستم را تحت بارهای سنگین تضمین میکنند.

- ناسازگاریهای داده – ناسازگاریها، تکرارها یا مقادیر گمشده میتوانند تحلیلهای نادرست و خطاهای پردازش پاییندست را ایجاد کنند. این مشکلات اغلب از تغییرات سیستم منبع، تفاوتهای زمانی یا مکانیزمهای ردیابی تغییر ناقص ناشی میشوند.

- مدیریت تأخیر داده – اطمینان از دسترسی بهموقع بهویژه برای نیازهای تجاری زمان واقعی که تأخیر داده میتواند بر تصمیمگیریهای عملیاتی تأثیر بگذارد، حیاتی است. چالشهای تأخیر هنگام هماهنگی چندین منبع داده با فرکانسهای بهروزرسانی متفاوت چند برابر میشود.

- تضمین یکپارچگی داده – محافظت در برابر فساد، برش یا خطاهای تبدیل نیاز به چارچوبهای اعتبارسنجی جامع و مدیریت خطای قوی دارد. مشکلات یکپارچگی داده میتوانند در صورت تشخیص زودهنگام در کل اکوسیستمهای تحلیلی منتشر شوند.

- تضمین حفاظت داده – جلوگیری از دسترسی غیرمجاز و نقضها نیازمند رویکردهای امنیتی چندلایهای شامل رمزنگاری، کنترلهای دسترسی و ثبت لاگ حسابرسی است. انطباق نظارتی پیچیدگی را به الزامات حفاظت داده اضافه میکند.

- مدیریت تکامل طرحواره – تطبیق با ساختارهای داده در حال تغییر بدون اختلال در فرآیندهای پاییندست نیاز به معماری آیندهنگر و استراتژیهای نسخهبندی دارد. تغییرات طرحواره میتوانند پایپلاین لوله موجود را خراب کنند اگر بهدرستی مدیریت نشوند.

بهترین شیوههای ضروری بارگذاری داده برای تضمین موفقیت چیست؟

پیادهسازی بهترین شیوههای اثباتشده عملیات بارگذاری داده قابلاعتماد، کارآمد و مقیاسپذیر را تضمین میکند که نیازهای تحلیلی و عملیاتی سازمان شما را پشتیبانی میکند.

- پروفایلسازی داده و بررسیهای کیفیت – درک ویژگیهای داده، الگوها و ناهنجاریها قبل از بارگذاری برای جلوگیری از مشکلات پاییندست. پروفایلسازی جامع مشکلات کیفیت داده، الگوهای توزیع و نیازهای تبدیل بالقوه را که تصمیمگیریهای استراتژی بارگذاری را آگاه میکنند، آشکار میکند.

- مدیریت خطا و ثبت لاگ – پیادهسازی ضبط جامع استثناها و حفظ مسیرهای حسابرسی دقیق برای عیبیابی و انطباق. مدیریت خطای قوی شامل مکانیزمهای تلاش مجدد، صفهای نامه مرده و هشدارهای خودکار برای به حداقل رساندن از دست دادن داده و تأخیرهای پردازش است.

- بهینهسازی عملکرد – استفاده از فرمتهای فایل کارآمد، فشردهسازی، پردازش موازی، نمایهسازی و پارتیشنبندی برای به حداکثر رساندن توان. بهینهسازی عملکرد نیازمند متعادلسازی عوامل متعددی از جمله پهنای باند شبکه، هزینههای ذخیرهسازی، ظرفیت پردازش و محدودیتهای سیستم مقصد است.

- بارگذاری افزایشی – بارگذاری تنها دادههای تغییر یافته برای کاهش هزینهها، به حداقل رساندن پنجرههای پردازش و حفظ تازگی داده. بارگذاری افزایشی مؤثر نیازمند مکانیزمهای تشخیص تغییر قوی و ترتیببندی دقیق برای حفظ یکپارچگی ارجاعی است.

- بارگذاری موازی برای مجموعه دادههای بزرگ – توزیع بار کاری در پردازندهها یا سرورها برای دستیابی به عملکرد مقیاسپذیر. بارگذاری موازی موفق به استراتژیهای پارتیشنبندی هوشمند وابسته است که از گلوگاهها اجتناب میکنند در حالی که یکپارچگی داده را حفظ میکنند.

- بررسی ELT به جای ETL – به تعویق انداختن تبدیلها تا پس از بارگذاری برای انعطافپذیری و مزایای عملکرد. رویکردهای ELT از قدرت پردازش سیستم مقصد بهره میبرند در حالی که معماری خط لوله را ساده کرده و تأخیرهای مرتبط با تبدیل را در طول بارگذاری کاهش میدهند.

جمعبندی

بارگذاری داده یک فرآیند حیاتی است که دادهها را از منابع مختلف به یک سیستم مقصد برای تحلیل و تصمیمگیری منتقل میکند. با آشنایی با تکنیکهای مختلف از جمله ETL، ELT، CDC، معماریهای پردازش موازی و استراتژیهای بهینهسازی فرمت فایل، میتوانید رویکرد بهینه را بر اساس حجم داده، پیچیدگی و نیازهای تجاری انتخاب کنید.

تکامل به سمت پردازش داده زمان واقعی و اتوماسیون هوشمند آینده بارگذاری داده را نشان میدهد، جایی که سازمانها از تکنیکهای پیشرفته مانند روشهای بارگذاری افزایشی و فرمتهای ذخیرهسازی ستونی برای دستیابی به کارایی بیسابقه استفاده میکنند. پلتفرمهای مدرنی مانند Airbyte این تکامل را با ترکیب انعطافپذیری متنباز با قابلیتهای درجه سازمانی نمونهسازی میکنند و به سازمانها امکان میدهند عملیات بارگذاری داده عظیم را بدون قفل شدن به فروشنده مدیریت کنند.

ابزارهایی مانند Airbyte، SSIS و Talend بارگذاری داده را ساده میکنند در حالی که کیفیت و یکپارچگی داده را از طریق مدیریت خطای قوی و اقدامات امنیتی جامع تضمین میکنند. پیروی از بهترین شیوههای تثبیتشده، پیادهسازی پردازش موازی در صورت مناسب و بهرهگیری از فرمتهای فایل بهینهشده به شما کمک میکند تا ارزش داراییهای داده خود را به حداکثر برسانید و تصمیمگیریهای تجاری آگاهانهای را که مزیت رقابتی را به همراه دارند، اتخاذ کنید.