در هر پایپلاین داده، کیفیت داده از اهمیت بالایی برخوردار است و یکی از بزرگترین موانع در تضمین کیفیت داده، حذف دادههای تکراری (Deduplication) است. دادههای تکراری میتوانند مشکلات قابلتوجهی ایجاد کنند، از جمله گزارشدهی نادرست، افزایش هزینههای ذخیرهسازی و تأخیر در تصمیمگیری.

چه این مشکل ناشی از منابع داده متعدد، نقصهای سیستمی یا منطق استخراج داده نادرست باشد، مدیریت دادههای تکراری در پایپلاین ETL (استخراج، تبدیل، بارگذاری) ضروری است.

اما چگونه میتوان حذف دادههای تکراری را بهطور مؤثر انجام داد؟ فرآیند حذف رکوردهای تکراری ممکن است در نگاه اول ساده به نظر برسد، اما پر از تلههای بالقوه است، بهویژه با افزایش پیچیدگی پایپلاین داده.

در این مقاله، بهترین روشها برای مدیریت حذف دادههای تکراری در ETL را بررسی میکنیم، از علل دادههای تکراری گرفته تا کارآمدترین استراتژیها برای حذف آنها.

در پایان، شما خواهید دانست چگونه فرآیندهای حذف تکرار قوی را در پایپلاین ETL خود پیادهسازی کنید تا دادههای تمیزتر و بینشهای قابلاعتمادتری داشته باشید.

حذف دادههای تکراری در ETL چیست؟

حذف دادههای تکراری در ETL به فرآیند شناسایی و حذف رکوردهای تکراری از مجموعه دادهها در مراحل مختلف پایپلاین، چه در هنگام استخراج، تبدیل یا بارگذاری، اشاره دارد.

این فرآیند درباره اطمینان از این است که دادههای جاری در پایپلاین منحصربهفرد و دقیق هستند، که برای تجزیهوتحلیل با کیفیت بالا و تصمیمگیری حیاتی است.

در دنیای ایدهآل، دادهها کاملاً تمیز وارد میشوند، اما همه ما میدانیم که این بهندرت اتفاق میافتد. چه در حال جمعآوری داده از چندین منبع باشید یا در حال تبدیل آنها در مسیر، دادههای تکراری اغلب بهطور خزنده وارد میشوند و منجر به موارد زیر میشوند:

- افزایش ذخیرهسازی: دادههای تکراری فضای بیشتری از حد لازم اشغال میکنند و هزینهها را افزایش میدهند.

- تجزیهوتحلیل نادرست: دادههای تکراری معیارها و بینشها را تحریف میکنند و گزارشها را غیرقابلاعتماد میسازند.

- کاهش سرعت پردازش: دادههای اضافی میتوانند کل پایپلاین را کند کنند، زمان پردازش را افزایش داده و کارایی را کاهش دهند.

با پیادهسازی یک استراتژی حذف تکرار قوی، میتوانید این مشکلات را برطرف کنید، نتایج دقیقتری تضمین کنید و عملکرد کلی پایپلاین ETL خود را بهبود دهید.

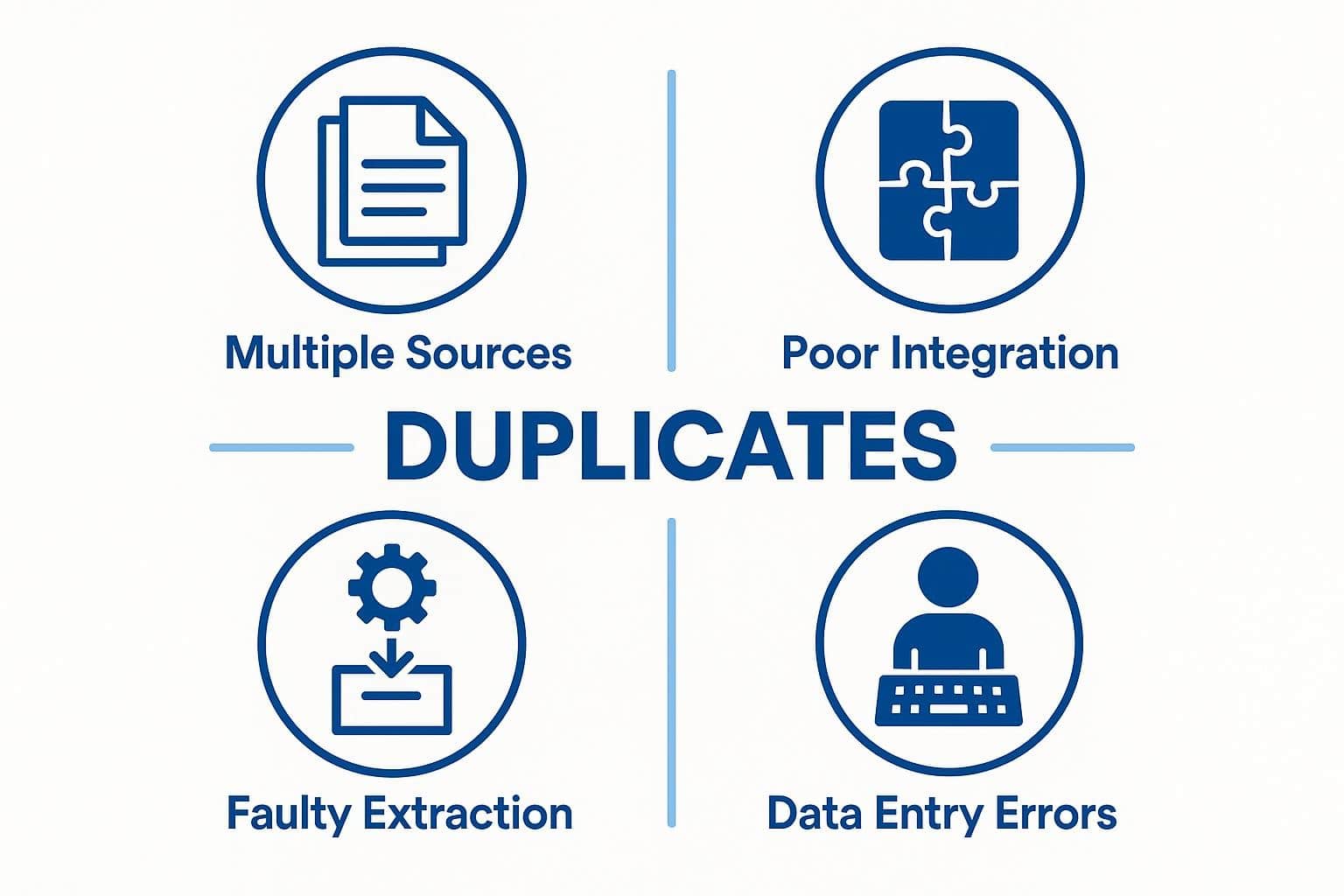

علل رایج دادههای تکراری در پایپلاین ETL

قبل از پرداختن به بهترین روشهای حذف تکرار، مهم است که بدانیم دادههای تکراری از کجا میآیند. شناسایی علت ریشهای دادههای تکراری اولین گام در ایجاد راهحل است. در ادامه برخی از علل رایج دادههای تکراری در پایپلاین ETL آورده شده است:

۱. افزونگی منابع داده

علت: چندین منبع که دادههای مشابهی ارائه میدهند. در بسیاری از موارد، دادهها از سیستمها یا منابع متعددی میآیند که حاوی رکوردهای مشابه یا حتی یکسان هستند. بهعنوان مثال، دادههای مشتری ممکن است هم در سیستم CRM و هم در پلتفرم بازاریابی وجود داشته باشد و بدون مدیریت مناسب، هر دو میتوانند وارد پایپلاین ETL شوند.

نکته: اطمینان حاصل کنید که شناسههای منحصربهفرد در منابع داده خود ردیابی میشوند و فرآیندهای یکپارچگی داده را ایجاد کنید که همپوشانیها را قبل از ورود به پایپلاین شناسایی کنند.

۲. یکپارچگی نادرست داده

علت: ادغام دادهها از منابع مختلف بدون مدیریت مناسب. هنگام ادغام دادهها از پلتفرمهای مختلف، پیوستن یا تجمیع نادرست میتواند باعث تکرار شود. این مشکل بهویژه در مواردی رایج است که مجموعه دادهها بهطور کامل همراستا نیستند و منجر به چندین رکورد برای یک موجودیت میشوند.

نکته: همیشه پیوستهای خود را در منطق تبدیل تأیید کنید و آنها را با دادههای نمونه تست کنید تا مطمئن شوید در طول یکپارچگی دادههای تکراری وارد نمیشوند.

۳. منطق استخراج داده معیوب

علت: اجرای مجدد مشاغل استخراج یا فیلتر کردن نادرست. در برخی موارد، یک فرآیند استخراج معیوب میتواند منجر به کشیده شدن دادههای یکسان بیش از یکبار شود. بهعنوان مثال، اگر مشاغل استخراج را بدون بازنشانی حالت یا فیلتر کردن صحیح رکوردهای قبلاً استخراجشده دوباره اجرا کنید، بهراحتی میتوانید با دادههای تکراری مواجه شوید.

نکته: مدیریت صحیح حالت را در مشاغل استخراج خود اطمینان دهید و در صورت امکان، استخراج افزایشی را پیادهسازی کنید که فقط رکوردهای جدید یا بهروز شده را بکشد.

۴. ورود یا بهروزرسانی دادههای ناسازگار

علت: خطای انسانی یا خرابیهای سیستمی. گاهی اوقات، خطاهای ورود داده یا اشکالات سیستمی میتوانند رکوردهای تکراری ایجاد کنند. بهعنوان مثال، یک کاربر ممکن است بهاشتباه دادههای یکسانی را چندین بار ارسال کند یا یکپارچگی ممکن است تشخیص ندهد که یک رکورد از قبل وجود دارد.

نکته: قوانین اعتبارسنجی را هم در سیستمهای منبع و هم در پایپلاین ETL پیادهسازی کنید تا ورودیهای تکراری را قبل از رسیدن به پایگاه داده شناسایی کنید.

روشهای کلیدی حذف دادههای تکراری در ETL

هنگامی که منابع دادههای تکراری را شناسایی کردید، گام بعدی پیادهسازی استراتژیهایی برای حذف آنها است.

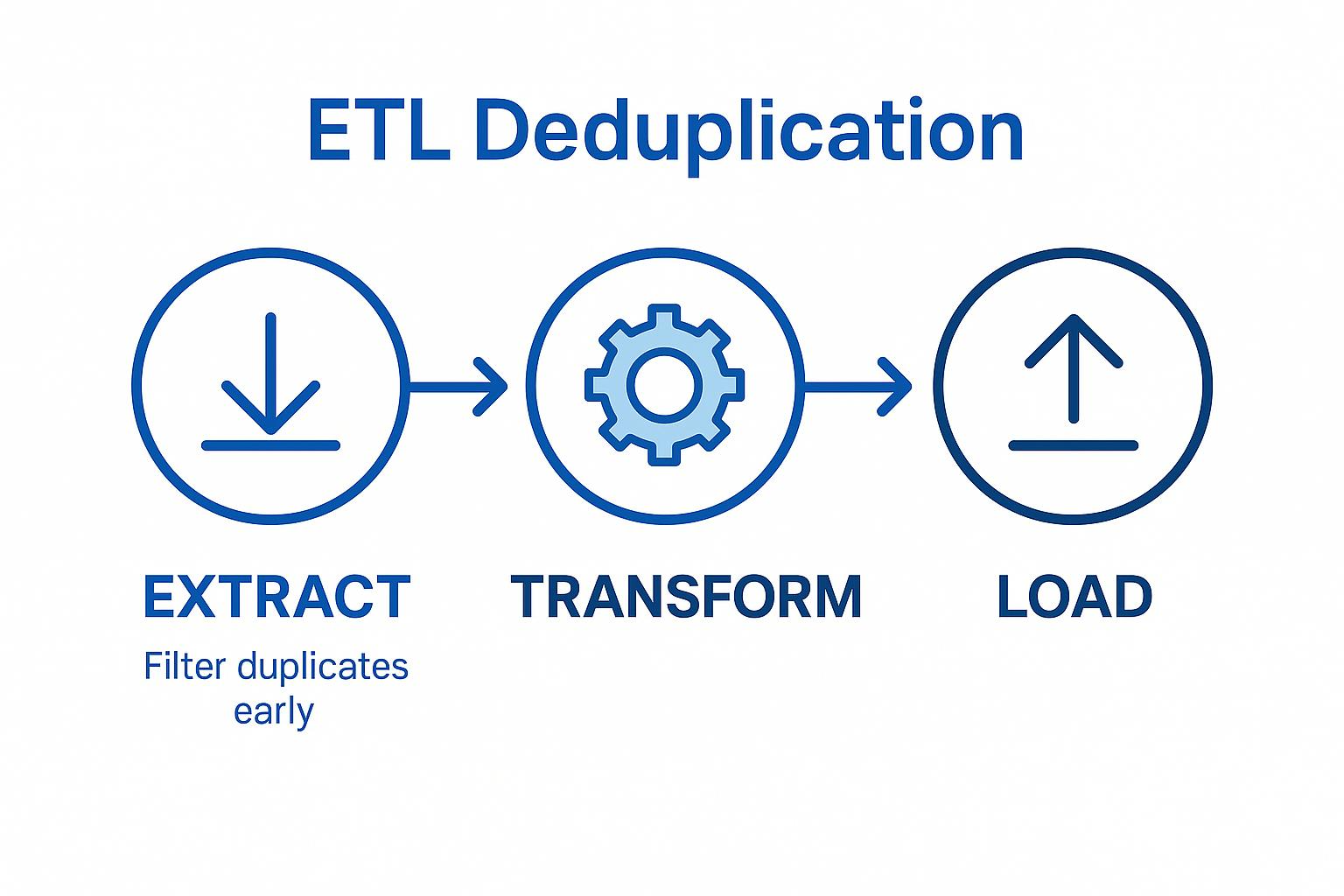

چندین روش برای مدیریت حذف دادههای تکراری در مراحل مختلف پایپلاین ETL وجود دارد: استخراج، تبدیل و بارگذاری. در ادامه، تکنیکهای مؤثر برای هر مرحله بررسی میشوند.

۱. در طول استخراج

روش: فیلتر کردن و شناسایی دادههای تکراری در منبع. بهترین زمان برای مدیریت حذف تکرار، زودترین زمان ممکن است. با فیلتر کردن دادههای تکراری در مرحله استخراج، میتوانید از ورود رکوردهای اضافی به پایپلاین جلوگیری کنید. این کار با شناسایی شناسههای منحصربهفرد در دادههای منبع یا بررسی تکرارها در منطق استخراج انجام میشود.

نحوه بررسی:

- از شناسههای منحصربهفرد (مانند شناسههای مشتری یا تراکنش) در دادههای منبع برای فیلتر کردن دادههای تکراری قبل از کشیدن دادهها استفاده کنید.

- پرسوجوهای نمونه را روی دادههای منبع اجرا کنید تا الگوهای تکراری رایج را شناسایی کنید.

نکته: در صورت امکان، از استخراج افزایشی استفاده کنید تا فقط رکوردهای جدید یا تغییر یافته کشیده شوند و شانس کشیدن دادههای تکراری کاهش یابد.

۲. در طول تبدیل

روش: حذف دادههای تکراری با استفاده از منطق تبدیل (SQL، اسکریپتها و غیره). اگر دادههای تکراری از مرحله استخراج عبور کنند، خط دفاعی بعدی مرحله تبدیل است. در این مرحله، میتوانید از پرسوجوهای SQL یا اسکریپتهای سفارشی برای شناسایی و حذف دادههای تکراری بر اساس فیلدهای منحصربهفرد استفاده کنید.

تکنیکهای رایج شامل استفاده از DISTINCT، GROUP BY یا توابع پنجرهای مانند ROW_NUMBER() برای فیلتر کردن دادههای اضافی است.

نحوه بررسی:

- از پرسوجوهای SQL مانند GROUP BY یا DISTINCT برای تجمیع و فیلتر کردن رکوردهای تکراری استفاده کنید.

- در زبانهای برنامهنویسی مانند پایتون، از کتابخانههای پردازش داده (مانند pandas) برای شناسایی دادههای تکراری بر اساس یک ستون کلیدی استفاده کنید.

نکته: از توابع هش یا پنجرهای برای شناسایی و حذف دادههای تکراری بهطور کارآمد، بهویژه در مجموعه دادههای بزرگ، استفاده کنید. این روش بهویژه برای تبدیلهای پیچیده شامل پیوستها یا تجمیعها مفید است.

۳. در طول بارگذاری

روش: جلوگیری از دادههای تکراری با استفاده از محدودیتها و اعتبارسنجی. هنگامی که دادههای شما تبدیل شده و آماده بارگذاری هستند، اطمینان از این که دادههای تکراری به مقصد نهایی راه پیدا نکنند، کلیدی است. میتوانید از کلیدهای اصلی، محدودیتهای منحصربهفرد یا عملیات upsert (درج یا بهروزرسانی) در پایگاه داده خود برای جلوگیری از درج ورودیهای تکراری در سیستم مقصد استفاده کنید.

نحوه بررسی:

- اطمینان حاصل کنید که جدول یا پایگاه داده مقصد کلیدهای اصلی یا محدودیتهای منحصربهفرد را روی فیلدهای کلیدی اعمال میکند تا از دادههای تکراری جلوگیری شود.

- از عملیات upsert برای درج رکوردهای جدید یا بهروزرسانی رکوردهای موجود بر اساس شناسههای منحصربهفرد استفاده کنید.

نکته: علاوه بر استفاده از محدودیتهای پایگاه داده، بررسیهای حذف تکرار را درست قبل از بارگذاری دادهها پیادهسازی کنید. بهعنوان مثال، از پردازش دستهای برای اعتبارسنجی اینکه آیا رکوردهای ورودی از قبل در سیستم مقصد وجود دارند یا خیر، قبل از درج آنها استفاده کنید.

۴. استفاده از ابزارهای حذف تکرار شخص ثالث

روش: استفاده از ابزارهای ETL با قابلیتهای حذف تکرار داخلی. بسیاری از ابزارهای ETL مدرن، از جمله Airbyte، ویژگیهایی را ارائه میدهند که حذف تکرار را در طول دریافت و تبدیل داده خودکار میکنند.

این ابزارها میتوانند مسائل رایج کیفیت داده، از جمله حذف تکرار، را بدون نیاز به منطق سفارشی پیچیده مدیریت کنند. بهعنوان مثال، برخی ابزارها دارای ویژگیهای ضبط تغییرات داده (CDC) هستند که میتوانند از بارگذاری مجدد دادههای قبلاً دریافتشده جلوگیری کنند.

نحوه بررسی:

- از قابلیتهای حذف تکرار داخلی ابزار استفاده کنید و اطمینان حاصل کنید که بهدرستی پیکربندی شدهاند (مانند تنظیم CDC، تعریف کلیدهای منحصربهفرد).

- جریان داده را تست کنید تا مطمئن شوید که رکوردهای تکراری در طول فرآیند شناسایی و حذف میشوند.

نکته: اگر از پلتفرم ETL مانند Airbyte استفاده میکنید، از کانکتورهای پیشساخته آن که حذف تکرار را بهطور خودکار برای برخی منابع داده مدیریت میکنند، بهره ببرید. این میتواند در زمان و تلاش شما، بهویژه با یکپارچگیهای پیچیده، صرفهجویی کند.

بهترین شیوهها برای حذف دادههای تکراری کارآمد

مدیریت مؤثر حذف تکرار در پایپلاین ETL شما نیازمند چیزی بیش از اجرای تکنیکهای درست است—این درباره ایجاد فرآیندی است که مقیاسپذیر، کارآمد و خودکار باشد.

در ادامه برخی از بهترین شیوهها برای اطمینان از این که فرآیند حذف تکرار شما تا حد امکان مؤثر باشد، آورده شده است:

۱. اطمینان از یکپارچگی دادهها در منابع

بهترین شیوه: حفظ شناسههای منحصربهفرد برای تمام رکوردها. هنگام کار با دادهها از چندین منبع، یکپارچگی کلیدی است. از شناسههای منحصربهفرد (مانند شناسههای مشتری، شناسههای تراکنش یا SKUهای محصول) در سیستمهای خود برای ردیابی قابل اعتماد رکوردها و جلوگیری از تکرار استفاده کنید. این کار شناسایی دادههای تکراری را در مراحل استخراج و تبدیل آسانتر میکند.

نکته: اطمینان حاصل کنید که هر منبع داده دارای ساختار یکسانی برای شناسههای منحصربهفرد است. اگر این امکانپذیر نیست، یک سیستم شناسه متعارف ایجاد کنید که رکوردها را از چندین سیستم به یک شناسه واحد و یکپارچه نگاشت میدهد.

۲. استفاده از بارگذاریهای افزایشی

بهترین شیوه: اجتناب از بارگذاری کامل دادهها در صورت امکان. بارگذاری کامل دادهها اغلب دادههای تکراری را دوباره وارد میکند، بهویژه هنگام کار با مجموعه دادههای بزرگ. بهجای آن، از بارگذاریهای افزایشی برای کشیدن فقط رکوردهای جدید یا بهروز شده از آخرین بارگذاری استفاده کنید. این کار شانس کشیدن دادههای تکراری را کاهش میدهد و زمان پردازش را بهینه میکند.

نکته: مکانیزمهای مبتنی بر زمانبندی یا ردیابی تغییرات را در سیستمهای منبع خود تنظیم کنید تا رکوردهای جدید یا تغییر یافته را بهراحتی شناسایی کنید و بارگذاریهای افزایشی را کارآمدتر کنید.

۳. خودکارسازی فرآیندهای حذف دادههای تکراری

بهترین شیوه: پیادهسازی حذف تکرار خودکار در پایپلاین ETL. حذف تکرار دستی مستعد خطا و زمانبر است. خودکارسازی فرآیند حذف تکرار اطمینان میدهد که هر بار که پایپلاین اجرا میشود، بهطور مداوم انجام شود. از ویژگیهای داخلی ابزارهای ETL مانند Airbyte استفاده کنید یا بررسیهای حذف تکرار برنامهریزیشده را با استفاده از اسکریپتها یا SQL تنظیم کنید.

نکته: حذف تکرار را در چندین نقطه از پایپلاین ETL خود—در طول استخراج، تبدیل و بارگذاری—خودکار کنید تا دادههای تکراری زود شناسایی شوند و به مقصد نهایی نرسند.

۴. نظارت و حسابرسی منظم دادهها برای تکرارها

بهترین شیوه: انجام حسابرسیهای منظم داده برای اطمینان از عدم ورود دادههای تکراری. حتی با فرآیندهای خودکار، نظارت و حسابرسی منظم دادهها برای اطمینان از عملکرد مؤثر سیستم حذف تکرار مهم است. این کار به شما کمک میکند تا موارد لبه یا شکافهای فرآیند حذف تکرار را قبل از تبدیل شدن به مشکلات قابلتوجه شناسایی کنید.

نکته: هشدارهای خودکار تنظیم کنید که به تیم شما اطلاع دهند هرگاه خرابی حذف تکرار رخ دهد تا بتوان آن را فوراً برطرف کرد. حسابرسیهای منظم همچنین به بهبود فرآیند حذف تکرار در طول زمان کمک میکنند.

۵. ترکیب حذف تکرار با نظارت بر کیفیت داده

بهترین شیوه: استفاده از حذف تکرار بهعنوان بخشی از استراتژی گستردهتر کیفیت داده. حذف تکرار تنها یک جنبه از تضمین دادههای با کیفیت بالا است. آن را بخشی از یک سیستم نظارت بر کیفیت داده مداوم کنید که مسائل دیگری مانند مقادیر گمشده، قالبهای نادرست و ناهنجاریها را نیز بررسی میکند. با اتخاذ رویکردی جامع به کیفیت داده، میتوانید از دادههای تکراری و سایر مشکلات یکپارچگی داده جلوگیری کنید.

نکته: ابزارهای کیفیت داده مانند Great Expectations یا Talend را در پایپلاین خود یکپارچه کنید تا بهطور خودکار مسائل مانند دادههای تکراری، ناسازگاریها و مقادیر گمشده را بررسی و رفع کنید.

ابزارها و فناوریهایی برای کمک به حذف تکرار در ETL

در حالی که روشهای دستی و اسکریپتهای سفارشی میتوانند به حذف تکرار کمک کنند، استفاده از ابزارها و فناوریهای مناسب میتواند فرآیند را ساده کرده و کارایی آن را افزایش دهد.

۱. ابزارهای ETL با قابلیتهای حذف تکرار داخلی

ابزارهایی مانند Airbyte، Talend و Informatica ویژگیهای حذف تکرار داخلی را ارائه میدهند که میتوانند فرآیند را خودکار کنند. بهعنوان مثال، Airbyte از ضبط تغییرات داده (CDC) پشتیبانی میکند که میتواند از بارگذاری مجدد دادههای قبلاً دریافتشده جلوگیری کند.

نحوه استفاده:

- از قابلیتهای حذف تکرار ابزار اطمینان حاصل کنید و آنها را بهدرستی پیکربندی کنید (مانند تنظیم کلیدهای منحصربهفرد یا CDC).

- جریان داده را تست کنید تا مطمئن شوید که دادههای تکراری بهطور مؤثر شناسایی و حذف میشوند.

نمونه:

- Airbyte: از کانکتورهای پیشساخته برای منابع دادهای مانند Salesforce یا MySQL استفاده کنید که میتوانند دادههای تکراری را بر اساس کلیدهای منحصربهفرد شناسایی کنند.

۲. چارچوبهای کیفیت داده

Great Expectations: این ابزار امکان ایجاد مجموعههای اعتبارسنجی داده را فراهم میکند که میتوانند دادههای تکراری را بر اساس معیارهای تعریفشده شناسایی کنند. این ابزار بهویژه برای مجموعه دادههای بزرگ و پیچیده که نیاز به بررسیهای آماری دارند، مفید است.

نحوه استفاده:

- انتظارات سفارشی را برای شناسایی دادههای تکراری بر اساس ستونهای کلیدی یا ترکیبی از فیلدها تعریف کنید.

- این انتظارات را در پایپلاین ETL خود ادغام کنید تا بهصورت خودکار اجرا شوند.

نمونه:

- انتظار تعریف کنید که ستون customer_id باید در تمام رکوردها منحصربهفرد باشد و در صورت شناسایی تکرارها هشدار دریافت کنید.

۳. پایگاههای داده با پشتیبانی از محدودیتهای یکتایی

پایگاههای داده مانند PostgreSQL، MySQL و Snowflake از کلیدهای اصلی و محدودیتهای منحصربهفرد پشتیبانی میکنند که میتوانند از درج دادههای تکراری در مرحله بارگذاری جلوگیری کنند.

نحوه استفاده:

- جداول مقصد را با کلیدهای اصلی یا محدودیتهای منحصربهفرد روی فیلدهای کلیدی مانند customer_id یا transaction_id پیکربندی کنید.

- از عملیات upsert برای بهروزرسانی رکوردهای موجود بهجای درج موارد تکراری استفاده کنید.

نمونه:

- در PostgreSQL، یک محدودیت منحصربهفرد روی ستون email تنظیم کنید تا از درج ایمیلهای تکراری جلوگیری شود:

sql

ALTER TABLE customers ADD CONSTRAINT unique_email UNIQUE (email);

۴. زبانهای برنامهنویسی و کتابخانهها

زبانهایی مانند Python با کتابخانههایی مانند pandas میتوانند برای شناسایی و حذف دادههای تکراری در مرحله تبدیل استفاده شوند.

نحوه استفاده:

- از تابع drop_duplicates() در pandas برای حذف رکوردهای تکراری بر اساس ستونهای کلیدی استفاده کنید.

- اسکریپتها را در پایپلاین ETL خود ادغام کنید تا بهصورت خودکار در طول تبدیل اجرا شوند.

نمونه:

- حذف دادههای تکراری بر اساس ستون customer_id با استفاده از pandas:

python

import pandas as pd

df = pd.read_csv(‘data.csv’)

df_deduped = df.drop_duplicates(subset=[‘customer_id’], keep=’first’)

۵. ابزارهای ارکستراسیون

ابزارهای ارکستراسیون مانند Apache Airflow یا Prefect میتوانند فرآیندهای حذف تکرار را بهعنوان بخشی از جریانهای کاری ETL برنامهریزی و مدیریت کنند.

نحوه استفاده:

- وظایف حذف تکرار را بهعنوان بخشی از جریانهای کاری ETL تعریف کنید.

- بررسیهای حذف تکرار را پس از هر مرحله استخراج یا تبدیل برنامهریزی کنید.

نمونه:

- در Airflow، یک وظیفه تعریف کنید که یک پرسوجوی SQL را برای شناسایی و حذف دادههای تکراری پس از تبدیل اجرا کند:

python

from airflow.operators.postgres_operator import PostgresOperator

deduplicate_task = PostgresOperator(

task_id=’deduplicate_data’,

sql=’DELETE FROM customers WHERE id NOT IN (SELECT MIN(id) FROM customers GROUP BY email);’)

نتیجهگیری

حذف دادههای تکراری در ETL برای حفظ کیفیت داده، کاهش هزینههای ذخیرهسازی و اطمینان از بینشهای دقیق ضروری است. با شناسایی علل ریشهای دادههای تکراری و پیادهسازی استراتژیهای حذف تکرار در مراحل استخراج، تبدیل و بارگذاری، میتوانید پایپلاینای تمیزتر و کارآمدتر ایجاد کنید.

بهترین شیوهها مانند حفظ شناسههای منحصربهفرد، استفاده از بارگذاریهای افزایشی، خودکارسازی حذف تکرار، نظارت منظم و ترکیب حذف تکرار با نظارت بر کیفیت داده، میتوانند فرآیند را سادهتر و مقیاسپذیرتر کنند. ابزارهایی مانند Airbyte، Great Expectations و پایگاههای داده با محدودیتهای یکتایی میتوانند این فرآیند را خودکار کرده و کارایی را افزایش دهند.

با پیادهسازی این استراتژیها و ابزارها، میتوانید اطمینان حاصل کنید که پایپلاین ETL شما دادههای منحصربهفرد و با کیفیت بالا را ارائه میدهد که تصمیمگیری دقیق و عملیات تجاری کارآمد را پشتیبانی میکند.