Snowpark در مقابل Snowflake Connector: پنج جنبه حیاتی

هنگامی که اکثر مهندسان داده گزارش میدهند که از فرسودگی شغلی رنج میبرند در حالی که تولید داده جهانی روزانه در آینده نزدیک به ۴۶۳ اگزابایت پیشبینی میشود، ابزارهایی که برای پردازش داده Snowflake انتخاب میکنید میتواند تفاوت بین موفقیت پایدار و هرجومرج عملیاتی را ایجاد کند. دو رویکرد اصلی در این منظره غالب هستند: Snowpark و Snowflake Connector. در حالی که هر دو تعاملات قدرتمند داده را در اکوسیستم ابری Snowflake امکانپذیر میکنند، فلسفههای معماری و نقاط قوت موارد استفاده آنها به طور چشمگیری متفاوت است.

برای متخصصان داده که قابلیتهای در حال گسترش Snowflake را پیمایش میکنند، انتخاب رویکرد بهینه نیازمند درک نه تنها مجموعه ویژگیها، بلکه نحوه همراستایی این ابزارها با جریانهای کاری مهندسی داده مدرن، عملیاتیسازی یادگیری ماشین و الزامات حاکمیت سازمانی است. این تحلیل جامع Snowpark و Snowflake Connector را در پنج بعد حیاتی بررسی میکند و بینشهای استراتژیک لازم برای بهینهسازی تصمیمات معماری داده شما را فراهم میکند.

Snowpark چیست و چگونه پردازش داده را دگرگون میکند؟

Snowpark نمایانگر یک تغییر پارادایم در پردازش داده ابری است و به عنوان یک موتور پردازش و تحلیل داده یکپارچه عمل میکند که مستقیماً در Snowflake Data Cloud ساخته شده است. برخلاف رویکردهای سنتی که نیاز به خوشههای محاسباتی جداگانه و جابجایی داده دارند، Snowpark محاسبات را به دادههای شما میآورد با اجرای بارهای کاری native Scala، Java و Python داخل زیرساخت الاستیک Snowflake. این معماری پیچیدگی حفظ خوشههای Spark خارجی را حذف میکند در حالی که رابط برنامهنویسی DataFrame آشنا را که مهندسان و دانشمندان داده به آن وابسته هستند، فراهم میکند.

رویکرد انقلابی این پلتفرم بر ارزیابی lazy و بهینهسازی push-down query متمرکز است. هنگامی که کد Python یا Scala را با استفاده از API DataFrame Snowpark مینویسید، سیستم به طور خودکار این عملیات را به SQL بهینهشده ترجمه میکند که در موتور query اثباتشده Snowflake اجرا میشود. این به این معناست که تحولات پیچیده داده، جریانهای کاری یادگیری ماشین و عملیات تحلیلی شما از مقیاسپذیری خودکار Snowflake، حاکمیت امنیتی و بهینهسازیهای عملکرد بدون نیاز به مدیریت زیرساخت جداگانه بهره میبرند.

مزایای معماری کلیدی Snowpark شامل:

- نحو DataFrame آشنا با ترجمه خودکار SQL برای عملکرد بهینه در موتور Snowflake

- یکپارچهسازی seamless با ویژگیهای Snowflake از جمله UDFها، پروسیجرهای ذخیرهشده و قابلیتهای ML native

- تجربه تحلیل یکپارچه که تحلیل داده اکتشافی، استقرار مدل یادگیری ماشین و پردازش جریان در زمان واقعی را پشتیبانی میکند

- عملکرد و مقیاسپذیری بهبودیافته از طریق بهینهسازی خودکار و تخصیص منابع محاسباتی الاستیک

- توابع مبتنی بر AI برای پردازش زبان طبیعی و جریانهای کاری بینایی کامپیوتری مستقیماً در DataFrameها

- یکپارچهسازی Artifact Repository که مدیریت کتابخانههای شخص ثالث برای UDFهای سفارشی و پروسیجرهای ذخیرهشده را seamless میکند

توسعههای اخیر Snowpark شامل توابع AI در پیشنمایش خصوصی است که به توسعهدهندگان اجازه میدهد تحلیل احساسات، فیلتر محتوای و تولید متن را مستقیماً در عملیات DataFrame انجام دهند. تکامل پلتفرم به سمت پشتیبانی از برنامههای کانتینریز شده از طریق Snowpark Container Services آن را به عنوان یک پلتفرم جامع برای برنامههای داده مدرن قرار میدهد.

Snowflake Connector چگونه یکپارچهسازی برنامه را امکانپذیر میکند؟

Snowflake Connector به عنوان یک API پل پیشرفته عمل میکند که کانالهای ارتباطی امن و با عملکرد بالا بین برنامههای خارجی و Snowflake Data Cloud برقرار میکند. به جای پردازش داده داخل Snowflake مانند Snowpark، Connector در دسترسی برنامهای داده برتر است و به برنامههای Python، Java و Scala اجازه میدهد queryهای SQL را اجرا کنند، دادهها را انتقال دهند و عملیات پایگاه داده را از طریق پروتکلهای استاندارد مدیریت کنند.

بهبودهای اخیر قابلیتهای Connector را فراتر از ارتباط پایگاه داده پایه گسترش داده است، از جمله معرفی OAuth 2.0 Authorization Code Flow و Client Credentials Flow برای گزینههای احراز هویت در سطح سازمانی، و مکانیزمهای token-caching برای بهینهسازی مدیریت اتصال برای برنامههای با فرکانس بالا.

قابلیتهای ضروری Snowflake Connector شامل:

- مکانیزمهای احراز هویت پیشرفته از جمله OAuth 2.0، احراز هویت چندعاملی و یکپارچهسازی SSO سازمانی

- حرکت داده بهینهشده با عملیات bulk، binding پارامتر و batching نتیجه برای انتقالهای در مقیاس بزرگ

- مدیریت اتصال امن با ویژگیهای ارتباط رمزنگاریشده، کنترل دسترسی مبتنی بر نقش و ثبت لاگ حسابرسی جامع

- جریانهای کاری توسعه سادهشده از طریق درایورهای از پیش ساخته، APIهای جامع و pooling اتصال خودکار

- دسترسی داده بهبودیافته که یکپارچهسازی برنامه در زمان واقعی و تجربیات داشبورد responsive را امکانپذیر میکند

- ویژگیهای بهینهسازی عملکرد از جمله reuse اتصال، پردازش batch و قابلیتهای اجرای query موازی

تکامل Connector به سمت پشتیبانی از عملیات جدول Iceberg و ویژگیهای امنیتی بهبودیافته، آن را به عنوان یک جزء حیاتی برای سازمانهایی قرار میدهد که نیاز به دسترسی برنامهای Snowflake در حالی که حاکمیت سختگیرانه و الزامات عملکرد را حفظ میکنند.

تفاوتهای کلیدی عملکرد بین Snowpark و Snowflake Connector چیست؟

ویژگیهای عملکرد اساساً پردازش in-database Snowpark را از رویکرد application-centric Connector متمایز میکند. مزیت معماری Snowpark در حذف جابجایی داده از طریق اجرای native داخل موتور query بهینهشده Snowflake نهفته است، در حالی که Connector در سناریوهایی که قابلیتهای پردازش خارجی و انعطافپذیری یکپارچهسازی برنامه را نیاز دارند، برتر است.

اجرای Query و سرعت پردازش داده

Snowpark مزایای عملکرد قابل توجهی برای وظایف دستکاری داده در مقیاس بزرگ نشان میدهد، با مطالعات benchmark که تا ۲۴ برابر پردازش سریعتر برای عملیات پیچیده in-database در مقایسه با رویکردهای مبتنی بر connector سنتی نشان میدهند.

این افزایش عملکرد از بهینهسازی push-down query ناشی میشود، جایی که عملیات DataFrame به SQL بهینهشده کامپایل میشوند که کاملاً داخل معماری پردازش موازی Snowflake اجرا میشود.

قدرت Connector در سناریوهای concurrency بالا که نیاز به برقراری اتصال سریع و بازیابی نتیجه دارند، ظاهر میشود. بهینهسازیهای عملکرد اخیر—از جمله fetching multi-process و pooling اتصال—هدف بهبود توانایی Connector در مدیریت درخواستهای concurrent را دارند و ممکن است از backendهای برنامه در زمان واقعی و داشبوردهای interactive پشتیبانی کنند، هرچند هیچ benchmark رسمی دقیقاً افزایش را کمی نمیکند یا suitability پاسخ زیرثانیه را مستقیماً تأیید نمیکند.

عملکرد Join Snowpark و استفاده از منابع

یکپارچهسازی tight Snowpark با موتور محاسباتی Snowflake مصرف warehouse را از طریق بهینهسازی query هوشمند و مقیاسپذیری منابع خودکار کاهش میدهد. warehouseهای بهینهشده Snowpark 16 برابر حافظه بیشتر به ازای هر node فراهم میکنند و جریانهای کاری یادگیری ماشین memory-intensive و عملیات تحلیلی پیچیده را بدون هزینههای زیرساخت خارجی امکانپذیر میکنند. قابلیتهای بهینهسازی join پلتفرم اطمینان میدهد که عملیات multi-table پیچیده به طور کارآمد داخل معماری توزیعشده Snowflake اجرا میشوند.

کارایی منابع Connector به معماری client-side و الگوهای query بستگی دارد. پردازش batch با اندازههای fetch مناسب به کاهش مصرف حافظه client هنگام مدیریت مجموعههای داده میلیارد ردیف کمک میکند، در حالی که pooling اتصال overhead احراز هویت را در برنامههای با فرکانس بالا به حداقل میرساند.

سناریوهای عملکرد واقعی

- تحلیلها و تحولات در مقیاس بزرگ از پردازش موازی native Snowpark بهره میبرند، به ویژه برای عملیات شامل joinهای پیچیده، توابع window و aggregations در مجموعههای داده عظیم.

- برنامههای interactive و داشبوردها از مدیریت اتصال بهینهشده Connector و caching نتیجه برای تجربیات کاربر responsive استفاده میکنند.

- جریانهای کاری یادگیری ماشین عملکرد برتر را از طریق مهندسی ویژگی in-database و قابلیتهای آموزش مدل Snowpark به دست میآورند و نیاز به export داده را حذف میکنند.

- ingestion داده در زمان واقعی از بهینهسازیهای bulk-upload Connector برای سناریوهای streaming با throughput بالا استفاده میکند.

استراتژیهای بهینهسازی برای هر دو ابزار شامل اندازهگیری مناسب warehouse، تحلیل الگوهای query و بهرهبرداری از clustering خودکار Snowflake و قابلیتهای materialized-view برای بهبود عملکرد کلی سیستم است.

جریانهای کاری یادگیری ماشین و AI در این رویکردها چگونه متفاوت است؟

یکپارچهسازی قابلیتهای یادگیری ماشین و AI نمایانگر یک تمایز حیاتی بین Snowpark و Snowflake Connector است، به ویژه با اولویتبندی فزاینده سازمانها برای تحلیلهای AI-driven و برنامههای generative-AI داخل پلتفرمهای دادهشان.

اکوسیستم ML native Snowpark

Snowpark ML چارچوبی جامع برای جریانهای کاری end-to-end یادگیری ماشین کاملاً داخل حریم امنیتی Snowflake فراهم میکند. API مدلسازی پلتفرم از پیشپردازش scikit-learn-compatible و مهندسی ویژگی در مقیاس پشتیبانی میکند و از warehouseهای بهینهشده Snowpark برای محاسبات توزیعشده بدون جابجایی داده استفاده میکند. استقرار مدل از طریق Snowflake Model Registry رخ میدهد که استقرار versioned مدلهای Python ML را به عنوان UDFهای native Snowflake با مدیریت وابستگی خودکار امکانپذیر میکند.

معرفی اخیر توابع AI در پیشنمایش خصوصی نحوه رویکرد دانشمندان داده به جریانهای کاری تحلیلی را دگرگون میکند. توابع moderation محتوا و بررسیهای کیفیت داده را با promptهای زبان طبیعی انجام میدهند، در حالی که قابلیتهای جدید مدلهای زبان بزرگ را مستقیماً در عملیات DataFrame یکپارچه میکنند. این قابلیتها به سازمانها اجازه میدهند تحلیل احساسات، طبقهبندی متن و تولید محتوا را بدون export دادههای حساس به خدمات AI خارجی انجام دهند.

رویکرد Snowpark به عملیاتیسازی ML یکپارچهسازی hyper-parameter tuning، cross-validation و نظارت مدل داخل چارچوب حاکمیت Snowflake را امکانپذیر میکند، هرچند tuning و validation نیاز به پیادهسازی کاربر یا چارچوبهای خارجی دارند. خطوط لوله مهندسی ویژگی در مقیاس data-warehouse اجرا میشوند و inference در زمان واقعی را از طریق UDFهای تولیدشده خودکار پشتیبانی میکنند که ویژگیهای عملکرد consistent را در بارهای کاری batch و streaming حفظ میکنند.

الگوهای یکپارچهسازی ML مبتنی بر Connector

Snowflake Connector جریانهای کاری ML را از طریق یکپارچهسازی با پلتفرمها و کتابخانههای خارجی امکانپذیر میکند و انعطافپذیری را برای سازمانهایی با سرمایهگذاریهای موجود ML-infrastructure فراهم میکند. دانشمندان داده میتوانند مجموعههای ویژگی را با استفاده از عملیات bulk بهینهشده استخراج کنند، مدلها را در محیطهای ترجیحی مانند Databricks یا SageMaker آموزش دهند و نتایج را برای scoring و یکپارچهسازی برنامه به Snowflake مستقر کنند.

الگوهای connector پیشرفته شامل خطوط لوله inference streaming-ML است که مدلهای hosted در خدمات خارجی داده را هنگام ورود به Snowflake score میکنند. یکپارچهسازی OAuth 2.0 Connector جریانهای کاری retraining مدل خودکار امن را امکانپذیر میکند که اصل و نسب داده و انطباق حسابرسی را در محیطهای hybrid-cloud حفظ میکنند.

جریانهای کاری مهندسی داده مبتنی بر AI

هر دو رویکرد از مهندسی داده بهبودیافته با AI پشتیبانی میکنند، هرچند با پیامدهای معماری متفاوت. AI Assistant Snowpark تحولات DataFrame را از توصیفات زبان طبیعی auto-generate میکند و توسعه pipeline را تسریع میکند در حالی که بهینهسازی برای موتور اجرای Snowflake را حفظ میکند. Connector یکپارچهسازی با ابزارهای تولید کد AI خارجی و پلتفرمهای کیفیت داده خودکار را امکانپذیر میکند که از LLMs برای validation schema و تشخیص ناهنجاری استفاده میکنند.

سازمانهایی که برنامههای generative-AI را پیادهسازی میکنند از قابلیتهای vector-database Snowflake و پردازش native دادههای unstructured بهره میبرند و جریانهای کاری retrieval-augmented-generation را امکانپذیر میکنند که الزامات امنیتی و حاکمیت سازمانی را حفظ میکنند. Connector این موارد استفاده را از طریق جستجوی similarity vector با عملکرد بالا و عملیات embedding bulk برای پایگاههای داده vector خارجی پشتیبانی میکند.

چه تکنیکهای بهینهسازی عملکرد و بهترین روشها باید پیادهسازی کنید؟

بهینهسازی عملکرد در پیادهسازیهای Snowpark و Snowflake Connector نیازمند درک رویکردهای معماری متمایز آنها و اعمال تکنیکهای targeted است که از نقاط قوت هر پلتفرم بهره میبرند در حالی که bottlenecks بالقوه را کاهش میدهند.

استراتژیهای بهینهسازی خاص Snowpark

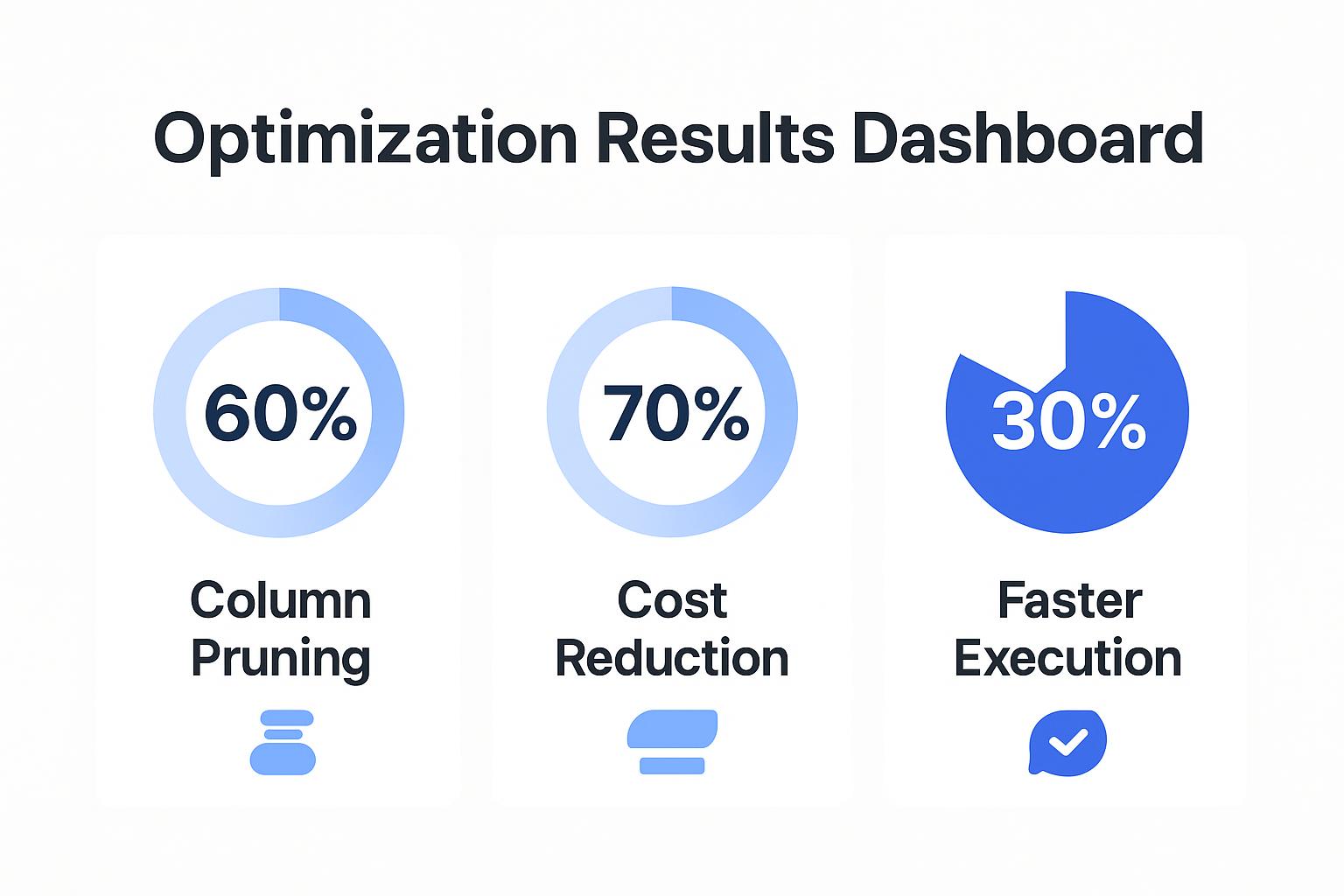

- pruning ستون از طریق انتخاب explicit فیلد اندازههای مجموعه داده intermediate را ۴۰-۶۰% نسبت به عملیات SELECT * کاهش میدهد.

- push-down predicate اطمینان میدهد که شرایط فیلتر قبل از عملیات join گران اعمال شوند و هزینههای پردازش را تا ۷۰% در تستهای benchmark کاهش دهد.

- vectorization UDF با decoratorهای @vectorized پردازش batch را امکانپذیر میکند که ۳۰% اجرای سریعتر از عملیات row-by-row به دست میآورد.

- warehouseهای بهینهشده Snowpark با تخصیص حافظه گسترشیافته برای جریانهای کاری memory-intensive، به ویژه برای مهندسی ویژگی یادگیری ماشین، ضروری است.

- بهینهسازی concurrency از طریق اندازهگیری مناسب warehouse و سیاستهای مقیاسپذیری با مدل اجرای موازی Snowpark همراستا است.

تکنیکهای بهبود عملکرد Connector

- اجرای query asynchronous با pooling اتصال هوشمند بارهای concurrent به طور قابل توجهی بالاتر از رویکردهای synchronous را مدیریت میکند.

- بهینهسازی پردازش batch از طریق fetchmany() با اندازههای batch مناسب مصرف حافظه client را کاهش میدهد در حالی که عملکرد را حفظ میکند.

- binding پارامتر و caching prepared-statement میتواند بهبودهای عملکرد قابل توجهی نسبت به تولید SQL dynamic ارائه دهد، هرچند دقیق magnitude سود ممکن است بسته به workload و محیط متفاوت باشد.

اصول بهینهسازی Cross-Platform

هر دو پلتفرم از موارد زیر بهره میبرند:

- بهینهسازی SQL هوشمند و indexing مناسب داخل Snowflake

- clustering خودکار روی ستونهای فیلترشده مکرر

- استفاده از materialized-view برای queryهای پیچیده و predictable

- سیاستهای auto-suspend/auto-resume warehouse thoughtful

- بهینهسازی شبکه از طریق caching نتیجه و تنظیمات compression

قابلیتهای عملکردی و نقاط قوت موارد استفاده چیست؟

| حوزه | Snowpark | Snowflake Connector |

| انواع داده پشتیبانیشده | Arrays، structs، maps، nested UDTها، دادههای semi-structured (JSON/XML) | انواع SQL پایه؛ تبدیل دستی برای ساختارهای پیچیده |

| سازگاری SQL | APIهای DataFrame با ترجمه خودکار SQL؛ اجرای SQL مستقیم | پشتیبانی کامل SQL با کتابخانه توابع native Snowflake |

| توابع موجود | کتابخانههای analytics غنی، ML، عملیات AI-powered، UDFهای سفارشی | توابع SQL Snowflake؛ پردازش خارجی از طریق منطق برنامه |

| قابلیتهای پیشرفته | آموزش ML in-database، تولید محتوای AI، جستجوی vector، برنامههای کانتینریز شده | حرکت داده با throughput بالا، یکپارچهسازی خارجی، اتصال در زمان واقعی |

| بهترین موارد استفاده | جریانهای کاری data-science، ML ops، تحولات پیچیده، تحلیلهای AI | ETL/ELT سنتی، یکپارچهسازی برنامه، داشبوردها |

مدلهای امنیتی و قابلیتهای حاکمیت چگونه مقایسه میشوند؟

| دسته | Snowpark | Snowflake Connector |

| احراز هویت کاربر | احراز هویت native Snowflake با MFA و SSO | OAuth 2.0، client-credentials flow، token caching |

| کنترل دسترسی | inheritance خودکار RBAC | RBAC لایه برنامه از طریق SQL و منطق سفارشی |

| رمزنگاری داده | رمزنگاری خودکار at-rest و in-transit | TLS 1.2+؛ رمزنگاری client-side اختیاری |

| امنیت پیشرفته | ثبت لاگ حسابرسی، masking داده، سیاستهای dynamic | trail حسابرسی programmatic، یکپارچهسازی ابزار خارجی |

| انطباق | SOC 2، GDPR، HIPAA built-in | انطباق از طریق منطق برنامه |

الگوهای یکپارچهسازی و سازگاری اکوسیستم که باید در نظر بگیرید چیست؟

| جنبه | Snowpark | Snowflake Connector |

| سازگاری پلتفرم | native به Snowflake؛ cloud-agnostic | پشتیبانی گسترده framework و multi-cloud |

| اکوسیستم توسعه | ابزارهای partner Snowflake، notebooks | اکوسیستم OSS و vendor بزرگ |

| اتصال خارجی | دسترسی API مستقیم محدود؛ تمرکز in-database | اتصال جامع سیستمهای خارجی |

| orchestration | Snowflake Tasks و scheduling | orchestratorهای خارجی (Airflow، Dagster و غیره) |

معماریهای hybrid اغلب هر دو ابزار را ترکیب میکنند—استفاده از ingestion مبتنی بر connector، تحولات Snowpark و delivery برنامه مبتنی بر connector—برای حداکثرسازی انعطافپذیری و عملکرد.

آینده برای توسعه Snowpark–Snowflake چیست؟

- Snowpark: بهبودهای اخیر بر یکپارچهسازیهای AI و خدمات کانتینر مقیاسپذیر تمرکز دارند، با گسترش مداوم دسترسی مدل زبان از طریق Snowflake Cortex.

- Snowflake Connector: بهبودها در reliability و یکپارچهسازی ادامه دارد، با Snowpipe که پشتیبانی streaming داده بهبودیافته را امکانپذیر میکند.

- Convergence: تجربیات dev یکپارچه که برنامهنویسی DataFrame را با اتصال برنامه و مدیریت داده hybrid-cloud seamless ادغام میکند.

مزایای خاص Snowflake

- vectorization خودکار برای موارد استفاده retrieval-augmented-generation

- پشتیبانی پیشرفته برای منابع unstructured (Google Drive، SharePoint، multimedia)

- تحولات push-down برای به حداقل رساندن هزینههای egress و warehouse

حاکمیت و امنیت

Airbyte Self-Managed Enterprise دادههای حساس را داخل زیرساخت شما نگه میدارد، hashing در سطح ستون، RBAC، ثبت لاگ حسابرسی و یکپارچهسازی SSO/OAuth 2.0 را ارائه میدهد—همراستا با posture امنیتی Snowflake.

الگوی جریان کاری مکمل

- Airbyte داده را به جداول raw Snowflake stream میکند.

- پروسیجرهای ذخیرهشده Snowpark داده را transform و enrich میکنند.

- برنامههای مبتنی بر connector بینشها را از طریق داشبوردها و گزارشهای خودکار delivery میکنند.

توصیههای نهایی

Snowpark را انتخاب کنید وقتی نیاز دارید:

- تحولات و تحلیلهای native در مقیاس بزرگ

- آموزش ML in-database و یکپارچهسازی AI

- برنامهنویسی DataFrame آشنا برای تیمهای data-science

Snowflake Connector را انتخاب کنید وقتی نیاز دارید:

- یکپارچهسازی برنامهای با برنامههای خارجی

- الگوهای دسترسی در زمان واقعی با concurrency بالا

- جریانهای احراز هویت سفارشی و معماریهای hybrid-cloud

رویکرد hybrid را برای موارد زیر اتخاذ کنید:

- pipelineهای جامع از ingestion تا تحلیل

- مجموعههای مهارت تیم متنوع و الزامات در حال تکامل

- محیطهای سازمانی که هم حاکمیت و هم انعطافپذیری را تقاضا میکنند

با ترکیب استراتژیک Snowpark، Snowflake Connector و Airbyte، سازمانها میتوانند معماریهای داده future-ready بسازند که با رشد کسبوکار و پیشرفت فناوری مقیاسپذیر باشند.

سوالات متداول

تفاوت اصلی بین Snowpark و Snowflake Connector چیست؟

Snowpark پردازش داده را native داخل Snowflake با APIهای DataFrame که به SQL بهینهشده ترجمه میشوند، اجرا میکند. Connector، از سوی دیگر، به عنوان پلی برای برنامههای خارجی عمل میکند تا Snowflake داده را به طور امن query، insert یا مدیریت کنند به صورت برنامهای.

کدام ابزار برای جریانهای کاری یادگیری ماشین بهتر است؟

Snowpark معمولاً برای ML مناسبتر است زیرا پیشپردازش، مهندسی ویژگی و حتی استقرار مدل را مستقیماً داخل Snowflake بدون جابجایی داده امکانپذیر میکند. Connector مفید است اگر pipelineهای ML شما به محیطهای خارجی مانند Databricks یا SageMaker وابسته باشند.

آیا میتوان Snowpark و Connector را با هم استفاده کرد؟

بله. بسیاری از سازمانها مدل hybrid را اتخاذ میکنند: Airbyte یا Connector ingestion و یکپارچهسازی برنامه را مدیریت میکند، در حالی که Snowpark تحولات سنگین، جریانهای کاری AI و تحلیلهای in-database را اجرا میکند.

آیا Snowpark از Python پشتیبانی میکند؟

بله. Snowpark از Scala، Java و Python پشتیبانی میکند. API DataFrame Python آن به توسعهدهندگان اجازه میدهد کد آشنا بنویسند که به طور خودکار به SQL ترجمه شده و داخل موتور محاسباتی Snowflake اجرا میشود.

امنیت بین دو چگونه متفاوت است؟

Snowpark از احراز هویت، رمزنگاری و سیاستهای RBAC built-in Snowflake به طور خودکار بهره میبرد. Connector از OAuth 2.0، SSO و token caching پشتیبانی میکند و به توسعهدهندگان کنترل بیشتری بر احراز هویت خارجی و حاکمیت در سطح برنامه میدهد.