داده برای سازمانها حیاتی است تا تحلیل دادهها و فرآیندهای تصمیمگیری پیچیده را هدایت کنند. با این حال، سازمانها با واقعیت تلخی روبرو هستند: ۶۰-۸۰٪ زمان پروژههای تحلیل داده صرف آمادهسازی داده میشود، در حالی که داده خام اغلب حاوی خطاها، ناسازگاریها، مقادیر گمشده و پیچیدگیهای ساختاری است که قابلیت اطمینان تحلیل را به شدت کاهش میدهد. رویکردهای دستی سنتی به آمادهسازی داده گلوگاه ایجاد میکنند که تیمها را از استخراج بینشهای بهموقع بازمیدارند، در حالی که رشد نمایی منابع داده شامل جریانهای بلادرنگ، اسناد بدون ساختار و حسگرهای اینترنت اشیاء نیاز به قابلیتهای پردازش پیشرفته بیشتری را تقاضا میکند.

پاکسازی داده راهحل جامعی برای مقابله با این چالشها ارائه میدهد و داده خام را از طریق فرآیندهای خودکار و ابزارهای هوشمند به فرمتهای قابل اعتماد و آماده تحلیل تبدیل میکند. پاکسازی داده مدرن از هوش مصنوعی بهره میبرد تا تلاش دستی را ۳۰-۴۰٪ کاهش دهد در حالی که کیفیت خروجی را بهبود میبخشد و سازمانها را قادر میسازد روی استخراج بینشهای ارزشمند تمرکز کنند نه مبارزه با مسائل کیفیت داده. در این راهنمای جامع، اصول پاکسازی داده، ابزارها و تکنیکهای پیشرفته، فرصتهای شغلی و نحوه سادهسازی کل فرآیند توسط پلتفرمهای مدرن را کاوش خواهیم کرد.

پاکسازی داده چیست و چرا ضروری است؟

پاکسازی داده (همچنین معروف به پالایش داده) گام حیاتی در فرآیند تحلیل داده است که مستقیماً بر کیفیت و قابلیت اطمینان بینشهای حاصل تأثیر میگذارد. این فرآیند شامل پاکسازی، تبدیل و سازماندهی داده خام به فرمت قابل دسترسی و تفسیر است. وظایف شامل شناسایی و اصلاح ناسازگاریها، پر کردن مقادیر گمشده، حذف موارد تکراری و بازسازی ساختار داده—اغلب به فرمت جدولی—برای دستکاری آسانتر در کاربردهای تحلیلی است.

چرا مهم است:

بهبود کیفیت داده – دقت، قابلیت اطمینان و یکنواختی داده را با شناسایی و اصلاح خطاها و شکافها افزایش میدهد و اطمینان میدهد بینشها از دادههای قابل اعتماد استخراج شوند. تحلیل کارآمد – داده خام را به فرمت قابل استفاده تبدیل میکند و به تحلیلگران اجازه میدهد روی استخراج بینش تمرکز کنند نه آمادهسازی داده. تصمیمگیری بهتر – داده باکیفیت و ساختارمند به تصمیمهای تجاری آگاهانهتر و مؤثرتر منجر میشود. مقیاسپذیری برای حجمهای داده مدرن – فرآیندهای پاکسازی خودکار منابع داده در حال رشد نمایی را مدیریت میکنند در حالی که استانداردهای کیفیت را در مجموعههای داده در مقیاس پتابایت حفظ میکنند.

پاکسازی داده در عمل چگونه کار میکند؟

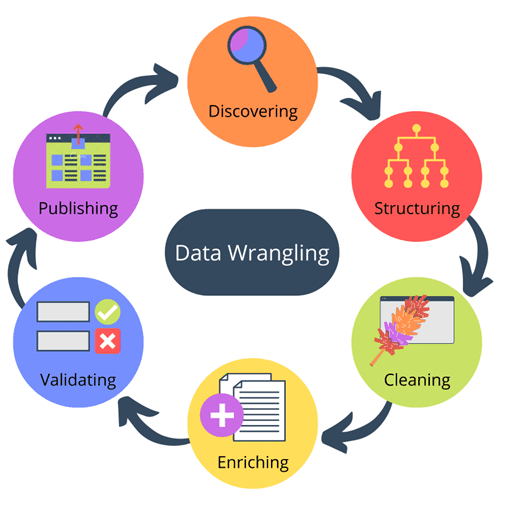

data wrangling

جمعآوری داده

داده را از رابطهای برنامهنویسی کاربردی، پایگاههای داده یا جریانهای داده جمعآوری کنید، سپس بررسی کنید تا الگوها، ناهنجاریها و مسائل بالقوه را شناسایی کنید. فرآیندهای جمعآوری مدرن از ابزارهای بررسی خودکار بهره میبرند که ساختار مجموعه داده را تحلیل میکنند و استراتژیهای تبدیل اولیه را توصیه میکنند.

ساختاردهی داده

داده را به فرمت ساختارمند (مانند چرخش، ذوب یا تبدیل) سازماندهی کنید تا با مدل تحلیل مورد نظر سازگار شود. ساختاردهی پیشرفته اکنون شامل مدیریت فرمتهای نیمهساختارمند مانند جیسان و اکسامال از طریق طرح بر اساس خواندن است که با ساختارهای داده متغیر تطبیق مییابد.

پاکسازی داده

خطاها را شناسایی و اصلاح کنید، مقادیر گمشده را مدیریت کنید و مدخلها را با استفاده از تطبیق الگو، فیلتر کردن یا بررسیهای الگوریتمی استاندارد کنید. ابزارهای پاکسازی مبتنی بر هوش مصنوعی به طور خودکار ناسازگاریها را شناسایی میکنند و استراتژیهای اصلاح آگاه از زمینه پیشنهاد میدهند.

غنیسازی داده

ارزش اضافه کنید با اضافه کردن زمینه اضافی یا ادغام با مجموعههای داده دیگر (مانند بخشبندی مشتریان بر اساس رفتار خرید). غنیسازی مدرن شامل پر کردن پیشبینیشده است که مدلهای یادگیری ماشین مقادیر گمشده را بر اساس همبستگیهای بینمجموعهای پر میکنند.

اعتبارسنجی داده

قوانین یا آزمونهای آماری اعمال کنید تا اطمینان حاصل شود داده آستانههای کیفیت را برآورده میکند و مناسب هدف است. چارچوبهای اعتبارسنجی خودکار اکنون کیفیت داده را به طور مداوم نظارت میکنند و ناهنجاریها را در سناریوهای پردازش بلادرنگ علامتگذاری میکنند.

انتشار

داده پاکشده و ساختارمند را در پایگاه داده، انبار داده یا پلتفرم تحلیل ذخیره کنید و با دادههای توصیفی مستند کنید. انتشار مدرن شامل کنترل نسخه برای مجموعههای داده و پیگیری ردیابی خودکار برای الزامات انطباق است.

مثالهای رایج پاکسازی داده چیست؟

استانداردسازی داده

واحدها (کیلوگرم → پوند)، فرمتهای ارز (همه به دلار آمریکا) یا مقادیر دستهای (نامهای استاندارد کشور) را یکپارچه کنید تا تحلیل یکپارچه امکانپذیر شود. ابزارهای استانداردسازی مدرن از یادگیری ماشین برای شناسایی الگوهای فرمت و پیشنهاد خودکار قوانین یکپارچگی استفاده میکنند.

ادغام دادههای مشتری برای تحلیل رفتار

سوابق فروش، گزارشهای وبسایت و دادههای برنامه وفاداری را با استفاده از شناسههای مشتری یا آدرسهای ایمیل ترکیب کنید تا پروفایلهای کامل بسازید. ادغام پیشرفته اکنون شامل الگوریتمهای تطبیق مبهم است که روابط را حتی وقتی شناسهها دقیقاً مطابقت ندارند، شناسایی میکند.

پردازش متن برای تحلیل احساسات

پستهای رسانههای اجتماعی یا نقدها را با حذف علائم نگارشی، نرمالسازی حروف و مدیریت اختصارات/اموجیها پاک کنید قبل از اجرای مدلهای احساسات. ابزارهای پردازش زبان طبیعی به طور خودکار الگوهای متن را شناسایی و استاندارد میکنند در حالی که معنای معنایی را حفظ میکنند.

هماهنگسازی داده حسگر اینترنت اشیاء

دادههای سری زمانی از حسگرهای تولیدی با نرخهای نمونهبرداری و واحدهای متفاوت را به فرمتهای استاندارد برای مدلهای نگهداری پیشبینی تبدیل کنید. سیستمهای پاکسازی بلادرنگ جریانهای داده مداوم را مدیریت میکنند در حالی که دقت زمانی را حفظ میکنند.

پاکسازی داده با پاکسازی داده چه تفاوتی دارد؟

| ویژگی | پاکسازی داده | پاکسازی داده |

| تعریف | کل فرآیند: جمعآوری، ساختاردهی، پاکسازی، غنیسازی، اعتبارسنجی و انتشار | زیرمجموعه پاکسازی داده متمرکز فقط روی مسائل کیفیت داده (مقادیر گمشده، موارد تکراری، اشتباهات تایپی، استانداردسازی فرمت) |

| دامنه | تحول کامل داده خام به فرمتهای آماده تحلیل | رفع مشکلات کیفیت خاص در مجموعههای داده |

پاکسازی داده رویکرد جامع است که پاکسازی داده را شامل میشود اما به تحولات ساختاری، استراتژیهای غنیسازی و فرآیندهای اعتبارسنجی گسترش مییابد که داده را برای موردهای استفاده تحلیلی خاص آماده میکند.

مؤثرترین ابزارهای پاکسازی داده چیست؟

| نوع ابزار | مورد استفاده | قابلیتهای مدرن |

| جدولهای گسترده (اکسل، گوگل شیت) | پاکسازی پایه روی مجموعههای داده کوچک، کاربران غیرفنی | مبتنی بر هوش مصنوعی پیشنهادهای داده و شناسایی الگو خودکار |

| زبانهای برنامهنویسی (پایتون، آر) | تحولات پیچیده، خودکارسازی، مجموعههای داده بزرگ | پولارز ۸-۱۲ برابر بهبود عملکرد نسبت به پانداس |

| نرمافزارهای اختصاصی (آلتریکس) | تحولات بصری، بررسی داده، همکاری | کمکی هوش مصنوعی توصیههای تحول و نظارت کیفیت خودکار |

| پلتفرمهای یکپارچه علوم داده (کنایم، رپیدماینر، دیتایکو) | آمادهسازی سرتاسری، مدلسازی، تجسم | بومی ابر با یادگیری ماشین جاسازیشده |

هوش مصنوعی چگونه فرآیندهای پاکسازی داده را تحول میدهد؟

هوش مصنوعی پاکسازی داده را با خودکارسازی وظایف تکراری و معرفی قابلیتهای پیشبینی که کیفیت داده و کارایی پردازش را افزایش میدهند، انقلابی کرده است.

شناسایی الگوی هوشمند و پاکسازی خودکار

سیستمهای مبتنی بر هوش مصنوعی اکنون ساختار مجموعه داده را با یادگیری ماشین تحلیل میکنند و ۳۷٪ ناسازگاریهای داده بیشتری نسبت به رویکردهای مبتنی بر قانون سنتی شناسایی میکنند. این سیستمها از شبکههای عصبی کانولوشنی برای شناسایی عدم تطابقهای معنایی خودکار استفاده میکنند و الگوریتمهای اصلاح خود را از طریق یادگیری تقویتی به طور مداوم بهبود میبخشند و تکرار خطا را با هر چرخه پردازش کاهش میدهند.

غنیسازی و پر کردن داده پیشبینیشده

سیستمهای هوش مصنوعی مدرن روشهای پر کردن سنتی را با همبستگی مقادیر گمشده در مجموعههای داده ناهمگن پشت سر میگذارند. مدلهای ترانسفورمر مقادیر گمشده را با دقت بالا با تحلیل الگوهای زمانی و ویژگیهای زمینهای پیشبینی میکنند، در حالی که شبکههای حافظه انجمنی مجموعههای داده را با ویژگیها از نمودارهای دانش خارجی غنی میکنند و نرخهای تکمیل را به طور قابل توجهی افزایش میدهند.

جریانهای کاری تحول خودبهینهساز

عاملهای یادگیری تقویتی عمیق دنبالههای تحول را بر اساس پروفایلهای مجموعه داده به طور پویا بهینهسازی میکنند و عملیات اضافی را کاهش میدهند و زمانهای پردازش را تسریع میکنند نسبت به جریانهای کاری ایستا. پلتفرمهای پیشرفته کد تحول را از طریق دستورهای زبان طبیعی تولید میکنند و به تحلیلگران اجازه میدهند عملیات پیچیده را با فرمانهای محاورهای اجرا کنند در حالی که نتایج تحول را قبل از اجرا پیشبینی میکنند.

سیستمهای مدرن چگونه پاکسازی داده بلادرنگ را مدیریت میکنند؟

پاکسازی داده بلادرنگ نیاز رو به رشد برای پردازش داده فوری در کاربردهای حساس به زمان مانند تشخیص تقلب، نظارت اینترنت اشیاء و معاملات مالی را برآورده میکند.

معماریهای پردازش جریان

چارچوبهای پیشرفته پردازش جریان مانند آپاچی فлинک تحولات با تأخیر میلیثانیه با معناشناسی پردازش دقیقاً یکبار امکانپذیر میسازند. این سیستمها وضعیت را در جریانهای داده برای عملیات پیچیده مانند پیگیری جلسه حفظ میکنند در حالی که تحمل خطا را از طریق نقطهبررسی خودکار فراهم میکنند و از دست رفتن داده در خطاهای سیستم را تضمین نمیکنند.

ادغام محاسبات لبه

معماریهای پاکسازی مدرن قابلیتهای پردازش را به دستگاههای لبه گسترش میدهند و حجمهای انتقال داده ابر را در کاربردهای تولیدی و اینترنت اشیاء به طور قابل توجهی کاهش میدهند. پردازشگرهای لبه اعتبارسنجی و تحول مقدماتی انجام میدهند و دادههای نامعتبر را قبل از انتقال فیلتر میکنند در حالی که غنیسازی توزیعشده را امکانپذیر میسازند که جریانهای داده خام در نقاط ثبت به فرمتهای ساختارمند پردازش میشوند.

تکامل طرح پویا برای دادههای جریانی

سیستمهای بلادرنگ به طور خودکار با تغییرات طرح در دادههای جریانی از طریق موتورهای استنتاج تطبیق مییابند که ساختارهای داده جدید را در صدها میلیثانیه شناسایی و ادغام میکنند. این قابلیتها خطاهای خط لوله را وقتی سیستمهای منبع فیلدهای جدید معرفی یا فرمتهای داده موجود را تغییر میدهند، جلوگیری میکنند و تداوم پردازش را در محیطهای تولیدی حفظ میکنند.

فرصتهای شغلی در پاکسازی داده چیست؟

- تحلیلگر داده – داده خام را برای گزارشها و بینشها با استفاده از ابزارهای تجسم و آماری مدرن تبدیل کنید.

- مهندس داده – خطوط لوله داده را طراحی و نگهداری کنید با تمرکز روی سیستمهای پاکسازی مقیاسپذیر و خودکار.

- دانشمند داده – پاکسازی را با آمار و یادگیری ماشین برای مدلهای پیشبینی ترکیب کنید و از ابزارهای آمادهسازی مبتنی بر هوش مصنوعی بهره ببرید.

- مدیر پایگاه داده – یکپارچگی داده، امنیت و عملکرد را در معماریهای داده توزیعشده تضمین کنید.

- توسعهدهنده هوش تجاری – داشبوردها و تجسمها را از داده پاک با پلتفرمهای تحلیل بومی ابر بسازید.

- نقشهای تخصصی پاکسازی داده – موقعیتهای نوظهور متمرکز روی آمادهسازی داده مبتنی بر هوش مصنوعی، بهینهسازی پردازش بلادرنگ و حاکمیت داده مبتنی بر انطباق.

- مهندس عملیات یادگیری ماشین – جریانهای کاری آمادهسازی داده را برای خطوط لوله یادگیری ماشین مدیریت کنید و کیفیت و یکنواختی در مجموعههای آموزشی را تضمین کنید.

بهترین شیوهها برای پاکسازی داده مؤثر چیست؟

- با اهداف واضح شروع کنید – اهداف تحلیل و الزامات کیفیت را قبل از شروع فرآیندهای تبدیل تعریف کنید.

- جامع مستند کنید – هر تغییر را برای تکرارپذیری و همکاری پیگیری کنید، شامل پیگیری ردیابی خودکار برای انطباق.

- به طور تکراری کار کنید – انتظار بازبینی مراحل و بهبود رویکردها بر اساس بازخورد تحلیل پاییندست را داشته باشید.

- وظایف تکراری را خودکار کنید – از اسکریپتها و ابزارهای مبتنی بر هوش مصنوعی برای صرفهجویی زمان و کاهش خطای انسانی در عملیات روزمره استفاده کنید.

- کنترل نسخه اجرا کنید – تغییرات داده و اسکریپتها را با جریانهای کاری مبتنی بر گیت و سیستمهای نسخهبندی مجموعه داده مدیریت کنید.

- ابزار مناسب انتخاب کنید – قابلیتهای ابزار را با اندازه داده، الزامات پردازش و سطح تخصص تیم تطبیق دهید.

- دروازههای کیفیت برقرار کنید – نقاط بررسی اعتبارسنجی خودکار اجرا کنید که اطمینان دهند داده آستانههای کیفیت را قبل از ادامه به تحلیل برآورده میکند.

- برای مقیاسپذیری برنامهریزی کنید – فرآیندهای پاکسازی را طراحی کنید که حجمهای داده در حال رشد و الزامات سیستمهای منبع در حال تکامل را مدیریت کنند.

پاکسازی داده با فرآیندهای استخراج، تبدیل و بارگذاری چگونه مقایسه میشود؟

| ویژگی | پاکسازی داده | استخراج، تبدیل و بارگذاری |

| تعریف | تبدیل داده خام به فرم آماده تحلیل از طریق پاکسازی، غنیسازی و اعتبارسنجی | استخراج داده، تبدیل برای یکنواختی و بارگذاری به مقصد (دریاچه/انبار داده) |

| تمرکز | کیفیت داده برای تحلیل و کاوش | ادغام داده و ذخیرهسازی مرکزی |

| انواع داده | ساختارمند، بدون ساختار، نیمهساختارمند با تجزیه پیشرفته | عمدتاً ساختارمند (ابزارهای مدرن نیمهساختارمند را مدیریت میکنند) |

| منابع داده | رابطهای برنامهنویسی کاربردی، پایگاههای داده، جریانها، اسناد، دستگاههای اینترنت اشیاء | پایگاههای داده رابطهای، بدون رابطه، فایلهای تخت، برنامههای ابری |

| هدف تبدیل | نرمالسازی، استانداردسازی، رمزگذاری برای تحلیل خاص | سازگار کردن داده منبع با طرحهای مقصد |

| مقیاسپذیری | متوسط تا بالا با ابزارهای بومی ابر | بالا (طراحیشده برای حجمهای مقیاس سازمانی) |

| کاربران | تحلیلگران، کاربران تجاری، دانشمندان داده | مهندسان داده، توسعهدهندگان استخراج، تبدیل و بارگذاری، تیمهای پلتفرم |

| سهولت استفاده | انعطافپذیر و کاربرپسند با رابطهای بصری | فرآیندمحور با مداخله دستی حداقلی |

| مورد استفاده | تحلیل کاوشی، آمادهسازی یادگیری ماشین، آمار | انبارداری داده، ادغام سازمانی، گزارشدهی |

معماریهای داده مدرن این رویکردها را ترکیب میکنند و الگوهای استخراج، بارگذاری و تبدیل تبدیلهای سبک پاکسازی را در انبارهای داده با ابزارهایی مانند دیبیتی امکانپذیر میسازند.

آینده پاکسازی داده چه خواهد بود؟

پاکسازی داده به سمت سیستمهای خودمختار و هوشمند تکامل مییابد که مداخله انسانی حداقلی نیاز دارند در حالی که استانداردهای کیفیت و حاکمیت سطح سازمانی را حفظ میکنند. ادغام مدلهای زبان بزرگ خودکارسازی بیشتر در آمادهسازی داده را وعده میدهد، در حالی که معماریهای پردازش بلادرنگ پاکسازی مداوم منابع دادههای جریانی را امکانپذیر میسازد.

سازمانهایی که در قابلیتهای پاکسازی داده مدرن سرمایهگذاری میکنند، خود را برای آزادسازی ارزش بیشتر از داراییهای داده در حال رشد نمایی موقعیت میدهند در حالی که زمان تا بینش را کاهش میدهند و استانداردهای انطباق سختگیرانه را حفظ میکنند. چه حرفهای داده جاهطلب باشید یا سازمانی که به دنبال حداکثر کردن ارزش داده است، توسعه قابلیتهای پاکسازی قوی با ابزارها و روششناسیهای پیشرفته برای مزیت رقابتی در بازارهای مبتنی بر داده ضروری باقی خواهد ماند.

سؤالات متداول

پاکسازی داده چیست؟

پاکسازی داده فرآیند پاکسازی، تبدیل و سازماندهی داده خام به فرمتهای آماده تحلیل است. شامل جمعآوری، ساختاردهی، پاکسازی، غنیسازی، اعتبارسنجی و انتشار است.

پاکسازی داده با پاکسازی داده چه تفاوتی دارد؟

پاکسازی داده زیرمجموعهای از پاکسازی داده است که فقط روی رفع خطاها مانند موارد تکراری، مقادیر گمشده و فرمتهای ناسازگار تمرکز دارد. پاکسازی داده فراتر میرود با بازسازی، غنیسازی و اعتبارسنجی داده برای موردهای استفاده تحلیلی خاص.

چرا پاکسازی داده مهم است؟

بدون پاکسازی، داده خام ناسازگار و غیرقابل اعتماد باقی میماند. پاکسازی دقت را بهبود میبخشد، زمان آمادهسازی را کاهش میدهد و اطمینان میدهد تصمیمگیرندگان بتوانند به بینشهای استخراجشده از تحلیل اعتماد کنند.

مثالهای رایج پاکسازی داده چیست؟

- استانداردسازی واحدها، ارزها یا مقادیر دستهای

- ادغام دادههای مشتری در سیستمهای متعدد

- آمادهسازی متن برای تحلیل احساسات

- هماهنگسازی داده حسگر اینترنت اشیاء برای نگهداری پیشبینی