نکات کلیدی

- «سفر در زمان» در Apache Iceberg به شما اجازه میدهد دقیقاً همان اسنپشات دادهای را پیدا کنید که بهترین نتایجتان را ساخته، بهجای اینکه مثل کارآگاهها در لاگهای پروداکشن دنبال سرنخ بگردید.

- پارتیشنبندی هوشمند میتواند زمان کوئری را از ساعتها به دقیقهها کاهش دهد، فقط با پارتیشنکردن روی همان ستونهایی که همین حالا هم دارید با آنها فیلتر میکنید.

- با «تکامل شِما»، واقعاً میتوانید فیچرهای جدید اضافه کنید بدون آن حس سنگینِ «نکنه شش ماه پایپلاین ML که خوب کار میکرد رو خراب کنم».

- تراکنشهای ACID آن شکستهای عجیبِ آموزش را حذف میکنند که وقتی رخ میدهند که یک نفر دیگر همزمان دارد روی جدول شما مینویسد.

- مسیر متنباز، قابلیت اطمینان در حد سازمانی را بدون برچسب قیمت سازمانی یا قفلشدن به فروشنده میدهد؛ تازه میتوانید چیزها را هم شخصیسازی کنید وقتی تیم ML شما (طبق معمول) یک نیاز خاص دارد که هیچکس از قبل حدس نزده بود.

اگر کمی هم در پروداکشن سامانههای ML ساخته باشید، دردش را میشناسید. مدلتان در محیط توسعه میترکاند، همه تستهای آفلاین را پاس میکند، بعد در پروداکشن یکجوری افت میکند که انگار دارد عمداً خرابکاری میکند. آشناست؟

نه بار از ده بار، مشکل داده است. و نه هر مشکل دادهای: کابوس بازتولیدپذیری که شبها دیتاآنجینیرها را بیدار نگه میدارد. داریم درباره بازسازی دیتاست آموزش ماهها بعد حرف میزنیم، پیدا کردن اینکه چرا فیچرها ناگهان فرق کردهاند، یا فهمیدن اینکه کدام نسخهی داده دقیقاً همان مدل معجزهآسا را ساخته که همه از شما میخواهند «فقط خیلی سریع دوباره بسازش».

دریاچههای دادهی سنتی؟ برای ذخیرهکردن حجم عظیمی از چیزها عالیاند، اما برای تضمینهای تراکنشی و نسخهبندی که بارهای کاری ML شدیداً لازم دارند، افتضاحاند. مثل این است که بخواهید با پتک جراحی دقیق انجام دهید.

اینجاست که Apache Iceberg وارد میشود. در کنار SparkSQL، قابلیت اطمینان شبیه دیتابیس را به دریاچه دادهی شما میآورد. سفر در زمان، تکامل شِما، و تراکنشهای ACID چیزهایی هستند که از روز اول باید بدیهی میبودند، اما somehow وسط هیاهوی «بیگدیتا در مقیاس» گم شدند.

مسئله تولیدپذیری داده در ML

مظنونهای همیشگی

بیایید صادق باشیم که در اکثر تیمهای ML واقعاً چه اتفاقی میافتد. دریفت داده بیصدا وارد میشود: توزیعهای فیچر شما با گذر زمان جابهجا میشوند، اما کسی متوجه نمیشود تا وقتی مدل شروع کند پیشبینیهایی بدهد که هیچ معنا ندارد. پایپلاینهای فیچر قرار است قطعی (deterministic) باشند، اما نیستند؛ همان پایپلاین را دوبار اجرا کنید و بهخاطر منطق تایماستمپ یا فقط ریسکاندیشنهای قدیمیِ معمولی، خروجی کمی متفاوت میشود.

بعد میرسیم به وضعیت کنترل نسخه. برای نسخهبندی کد تقریباً خوب شدهایم (هرچند درباره آن «راهحل موقت» سه ماه پیش که هنوز در پروداکشن است حرف نزنیم). اما نسخهبندی داده؟ هنوز بیشترش فرایندهای دستی، شیتهای صفحهگسترده، و دعا کردن است.

یک سناریو که بهطرز افسردهکنندهای آشناست: همتیمی شما دوشنبه فیچر انجینیرینگ را اجرا میکند، شما سهشنبه اجرا میکنید، و ناگهان دارید نتایجی میگیرید که برای دادهی منبع یکسان، نباید فرق کند. چرا؟ چون جدولهای زیربنایی بین دوشنبه و سهشنبه تغییر کردهاند، و منطق «نقطهدر-زمان» شما آنقدرها هم نقطهدر-زمان نیست که فکر میکردید.

مشکلهای واقعاً موذی در زمان آموزش مدل رخ میدهند. چند نفر به همان دیتاستها دسترسی دارند، تغییرات شِما بدون هشدار پایپلاینها را میشکند، و نوشتنهای همزمان ریسکاندیشنهایی میسازد که فیچرهای با دقت مهندسیشدهتان را خراب میکند. مثل این است که بخواهید خانه بسازید در حالی که یک نفر مدام پیِ ساختمان را عوض میکند.

چرا دریاچههای داده سنتی کم میآورند

دریاچههای داده برای دنیایی طراحی شدند که تحلیل یعنی اجرای گزارشهای بچ و شاید چند کار ETL. تاکید روی مقیاسپذیری ذخیرهسازی بود، نه یکپارچگی تراکنشی. این رویکرد وقتی بزرگترین نگرانیتان تولید گزارشهای فصلی بود، جواب میداد.

اما ML فرق دارد. تکرارشونده است، آزمایشی است، و به سازگاریای نیاز دارد که تحلیل سنتی هیچوقت لازم نداشت. وقتی کار آموزش مدل شما دادهی نیمهنوشته را میخواند (چون یک نفر دیگر همان جدول را بهروزرسانی میکند)، شما فقط یک گزارش اشتباه نمیگیرید؛ شما مدلی میگیرید که از دادهی آشغال یاد گرفته و قرار است پیشبینی آشغال بدهد.

انعطافپذیری شِما روی کاغذ خوب است، اما در عمل اغلب «آشوب شِما» تولید میکند. بدون کنترلهای درست برای تکامل، دانشمندان دادهی خوشنیت ناخواسته وقتی آن «فقط یک فیچر دیگر» را به یک جدول موجود اضافه میکنند، سامانههای پاییندستی را میشکنند. موفق باشید بفهمید چی شکست و کی.

وضع متادیتا از این هم بدتر است. دریاچههای دادهی سنتی فایلها را دنبال میکنند، نه دیتاستهای منطقی را. پس وقتی لازم دارید lineage فیچر را بفهمید یا چکهای کیفیت داده پیاده کنید، عملاً کورکورانه حرکت میکنید.

هزینههای پنهان

زیربناهای ضعیف داده هزینههایی تولید میکنند که در هیچ ردیف بودجهای دیده نمیشوند. دانشمندان داده بیشتر وقتشان را بهجای بهتر کردن مدلها، صرف کلنجار رفتن با داده میکنند. مطالعاتی دیدهام که میگویند شصت تا هشتاد درصد زمانشان میرود برای data wrangling. این… بهینه نیست.

وقتی در پروداکشن چیزی خراب میشود، و قطعاً میشود، دیباگ کردن تبدیل میشود به حفاری باستانشناسی. مدل روی کدام نسخهی داده آموزش دیده بود؟ از آن زمان تا الان چه چیزی تغییر کرده؟ آیا یک تغییر شِما بوده که کسی مستندش نکرده؟ جواب این سوالها میتواند هفتهها طول بکشد، اگر اصلاً قابل جواب دادن باشند.

یک دقیقه هم درباره انطباق مقرراتی حرف بزنیم. به یک ممیز توضیح بدهید چرا نمیتوانید دقیقاً همان دیتاست را بازتولید کنید که برای آموزش مدلی استفاده شده که تصمیم وام میگیرد. این گفتوگو را هیچکس نمیخواهد داشته باشد.

مبانی Iceberg برای ML

سفر در زمان که واقعاً کار میکند

سفر در زمان Iceberg یک معماری مبتنی بر اسنپشات است که برای هر عملیات نوشتن، متادیتای کامل جدول را نگه میدارد. هر اسنپشات یک نمای سازگار از جدول شما را در یک نقطه زمانی مشخص نشان میدهد، شامل شِما، پارتیشنها، و همهچیز.

برای آدمهای ML، این یک تغییر بازی است. شما میتوانید حالتهای تاریخی جدول را با SQL ساده کوئری کنید.

دیگر لازم نیست حدس بزنید کدام نسخهی داده نتایج خوب تولید کرده. دیگر خبری از مکالمههای «خب هفته پیش کار میکرد» نیست. میتوانید توزیعهای فیچر را در دورههای زمانی مختلف مقایسه کنید، افت عملکرد مدل را با بررسی حالتهای تاریخی داده تحلیل کنید، و چارچوبهای A/B تست بسازید که واقعاً نتایج سازگار بدهند.

متادیتا شامل آمار در سطح فایل است، پس بهینهسازهای کوئری میتوانند درباره کارایی اسکن تصمیمهای هوشمند بگیرند. این فقط درباره درستی نیست، درباره عملکرد هم هست.

تکامل شِما بدون دردسر

یک چیزی که باید بدیهی باشد اما somehow نیست: اضافه کردن یک ستون جدید به جدول فیچر نباید به جلسهی تیمی و برنامهی مهاجرت نیاز داشته باشد. تکامل شِمای Iceberg اجازه میدهد جدولها را با نیازهای در حال تغییر وفق دهید بدون اینکه خوانندهها یا نویسندههای موجود را خراب کنید.

میتوانید ستون اضافه کنید، نامش را عوض کنید، ترتیبش را تغییر دهید، و نوع داده را ارتقا دهید، همه در حالی که سازگاری عقبرو و جلورو حفظ میشود. برای پایپلاینهای ML، دانشمندان داده میتوانند فیچرهای جدید را با خیال راحت اضافه کنند بدون هماهنگی مهاجرتهای پیچیده بین چند تیم.

سیستم هویت ستون را با شناسههای یکتای فیلد دنبال میکند، پس تغییر نام ستون کوئریهای موجود را نمیشکند. ارتقای نوع داده طبق استانداردهای SQL انجام میشود (عدد صحیح به long، float به double)، پس نگران از دست رفتن داده نیستید.

تراکنشهای ACID (بالاخره!)

پشتیبانی ACID به بارهای کاری ML اجازه میدهد روی دیتاستهای مشترک بهصورت امن کار کنند بدون خراب کردن داده یا ساختن خواندنهای ناسازگار. Iceberg از کنترل همزمانی خوشبینانه استفاده میکند: چند نویسنده میتوانند همزمان کار کنند، اما تضادها بهصورت خودکار تشخیص داده و حل میشوند.

سطوح ایزولیشن مانع میشوند خوانندهها نوشتنهای ناقص را ببینند. پس وقتی کار آموزش شما شروع میشود، تضمین میشود یک اسنپشات سازگار از داده را ببیند، حتی اگر یک نفر دیگر در لحظه دارد فیچرها را بهروزرسانی میکند.

مرزهای تراکنش با عملیاتهای منطقی همراستا میشوند، نه با نوشتن تکفایلها. میتوانید گردشکارهای پیچیدهی فیچر انجینیرینگ را که چند جدول و چند پارتیشن را دربر میگیرد پیاده کنید و همچنان تضمین سازگاری داشته باشید. دیگر خبری از «اوه، فقط نصف آپدیت من موفق شد» نیست.

ساخت پایپلاینهای فیچر تولیدپذیر

پارتیشنبندیای که واقعاً معنی دارد

بیایید درباره راهبرد پارتیشنبندی حرف بزنیم، چون اینجا جایی است که خیلی از تیمها به پای خودشان شلیک میکنند. راز پیچیده نیست: روی ابعادی پارتیشن کنید که با نحوهی واقعی کوئریکردن داده همراستا است.

بیشتر بارهای کاری ML الگوهای زمانی دارند، آموزش روی دادههای تاریخی و پیشبینی روی دادههای جدید. پس پارتیشنبندی زمانی با ستونهای تاریخ یا تاریخزمان معمولاً بهترین انتخاب است. ریزدانگی به حجم داده بستگی دارد. برای سامانههای پرحجم، پارتیشن روزانه. برای دیتاستهای کوچکتر، هفتگی یا ماهانه.

پارتیشنبندی چندبعدی میتواند خوب کار کند اگر گروهبندیهای طبیعی کسبوکاری داشته باشید. سگمنتهای مشتری، دستهبندی محصول، مناطق جغرافیایی، و چیزهایی از این جنس، با نحوهی برش دادن داده توسط مدلها همخوانی دارند.

«پارتیشنبندی پنهان» Iceberg هم خیلی خوب است چون ساختارهای پارتیشن را خودکار نگه میدارد بدون اینکه لازم باشد ستونهای پارتیشن را صریحاً در کوئریها بیاورید. SQL سادهتر بنویسید، همان مزیتهای عملکردی را بگیرید.

اما در پارتیشنبندی زیادهروی نکنید. دیدهام تیمها هزاران پارتیشن ریز میسازند با این تصور که عملکرد بهتر میشود، بعد میفهمند سربار متادیتا برنامهریزی کوئری را میکشد. پارتیشنها را با اندازه منطقی نگه دارید (در حد صدها مگابایت تا گیگابایت) و آمار پارتیشن را پایش کنید.

نسخهبندی داده برای آزمایشها

آزمایشهای بازتولیدپذیر نیاز دارند نسخههای داده بهطور محکم به آرتیفکتهای مدل وصل باشند. اینجا اسنپشاتهای Iceberg واقعاً میدرخشند. آنها پایهای برای پیادهسازی رهگیری آزمایشها فراهم میکنند که واقعاً عملکرد مدل را به حالتهای مشخص داده لینک میکند.

ادغام با MLflow یا سامانههای مشابه رهگیری، اتصالهای قابل ممیزی بین اجرای مدل و نسخههای داده ایجاد میکند. هر کار آموزش، شناسه اسنپشات دیتاستهای ورودی را ثبت میکند و شرایط آزمایش را دقیقاً بازتولید میکند.

قابلیت شاخهبندی و برچسبگذاری گردشکارهای پیشرفتهتری را ممکن میکند. شاخههای دادهی پایدار برای آموزش مدل تولید بسازید، در حالی که توسعه را روی شاخههای آزمایشی ادامه میدهید. از برچسبها برای علامتگذاری نقاط عطف مهم استفاده کنید، مثل انتشارهای فصلی فیچر، ایستگاههای انطباق مقرراتی، و غیره.

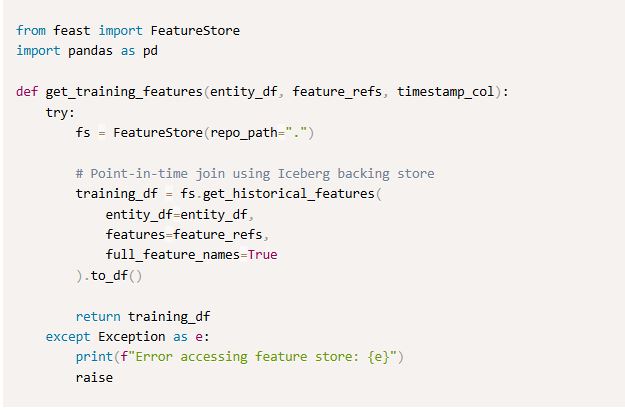

ادغام با Feature Store

پلتفرمهای مدرن ML ادغام بیدردسر بین زیرساخت داده و مدیریت آزمایش را میخواهند. جدولهای Iceberg با Feature Storeها خوب کار میکنند و از قابلیت سفر در زمان بهره میگیرند تا هم فیچرهای تاریخی برای آموزش و هم فیچرهای نقطهدر-زمان برای استنتاج را سرو کنند.

این ترکیب تعریفهای فیچر را بین آموزش و سرو یکسان نگه میدارد، در حالی که ویژگیهای عملکردی لازم برای استنتاج بلادرنگ حفظ میشود. دیگر خبری از skew بین آموزش و سرو نیست چون منطق فیچر بچ و استریمینگ شما از هم جدا شدهاند.

پیادهسازی در پروداکشن

نمونه واقعی: پیشبینی ریزش مشتری

اجازه دهید یک سامانه پیشبینی ریزش مشتری را مرور کنم که واقعاً در پروداکشن کار میکند. این سامانه روزانه میلیونها تعامل مشتری را پردازش میکند و در عین حال بازتولیدپذیری کامل را حفظ میکند.

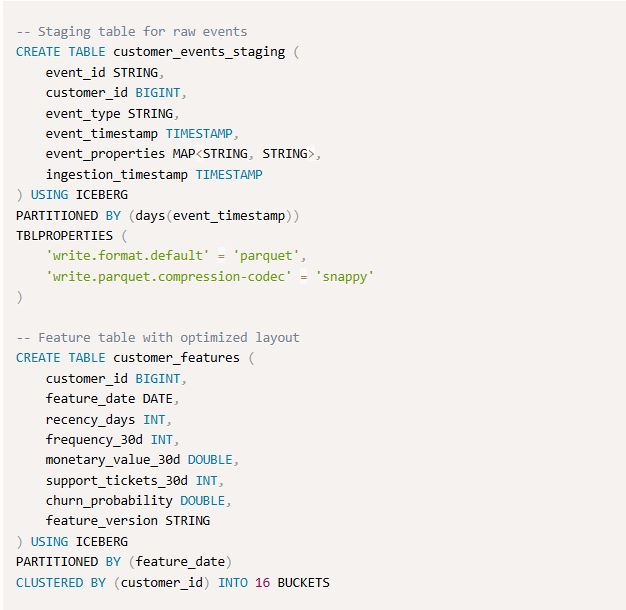

معماری داده از چندین جدول Iceberg تشکیل شده که بر اساس تازگی و الگوهای دسترسی سازماندهی شدهاند. رویدادهای خام وارد جدولهای staging میشوند، اعتبارسنجی و پاکسازی میشوند، و سپس در جدولهای فیچر که برای الگوهای دسترسی ML بهینه شدهاند تجمیع میشوند.

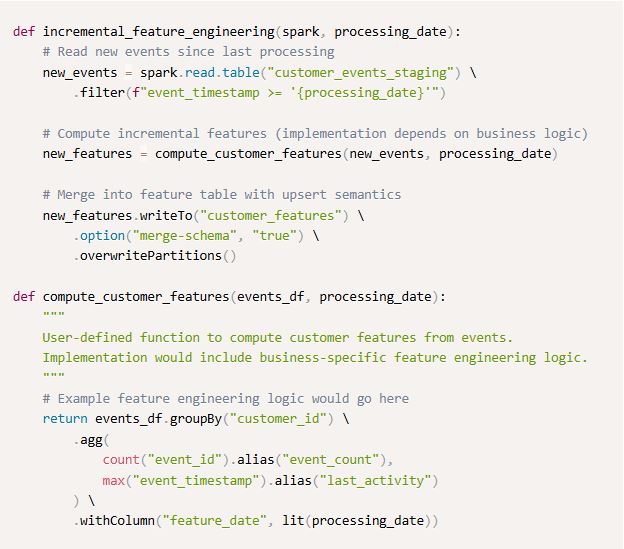

پایپلاینهای فیچر انجینیرینگ پردازش افزایشی را با قابلیتهای merge در Iceberg پیاده میکنند. این رویکرد افزایشی بازمحاسبه را کمینه میکند و در عین حال سازگاری داده را در برنامههای پردازشی مختلف حفظ میکند.

بهینهسازی عملکرد

عملکرد کوئری در Iceberg از چند تکنیک مکمل سود میبرد. اندازه فایل مهم است. بسته به الگوی دسترسی، فایلهای ۱۲۸ مگابایت تا ۱ گیگابایت را هدف بگیرید؛ فایلهای کوچکتر برای کوئریهای بسیار انتخابگر و فایلهای بزرگتر برای اسکنهای تمامجدول.

Parquet بهطور طبیعی برای بارهای کاری ML مفید است چون معمولاً فقط زیرمجموعهای از ستونها را انتخاب میکنید. انتخاب فشردهسازی به اولویتهای شما بستگی دارد. برای دادههای پرتکرار از Snappy استفاده کنید (بازکردن سریعتر) و برای دادههای آرشیوی از Gzip برای نسبت فشردهسازی بهتر.

بهینهسازی چیدمان داده با clustering یا Z-ordering میتواند عملکرد را برای الگوهای دسترسی چندبعدی بهطور چشمگیر بهتر کند. این تکنیکها دادههای مرتبط را داخل فایلها کنار هم میچینند و سربار اسکن را برای کوئریهای معمول ML کاهش میدهند.

کشکردن متادیتا عملکرد برنامهریزی کوئری را بهطور قابلتوجهی بهتر میکند، مخصوصاً برای جدولهایی با پارتیشنهای زیاد. لایه متادیتای Iceberg از کش توزیعشده (Redis) یا کش درونحافظهای در Spark executorها پشتیبانی میکند.

پایش و عملیات

سامانههای ML پروداکشن به پایشی نیاز دارند که فراتر از معیارهای سنتی زیرساخت است. متادیتای غنی Iceberg امکان رویکردهای پایشی پیچیدهای را میدهد که واقعاً کمک میکند بفهمید با دادهتان چه میگذرد.

پایش کیفیت داده از متادیتا استفاده میکند تا ناهنجاریها را در حجم، تغییرات شِما، و توزیعهای آماری تشخیص دهد. ادغام با چارچوبهایی مثل Great Expectations گردشکارهای اعتبارسنجی خودکاری میسازد که اگر آستانههای کیفیت نقض شوند میتواند پردازش را متوقف کند.

پایش عملکرد، معیارهای اجرای کوئری، کارایی اسکن فایل، و الگوهای مصرف منابع را دنبال میکند. معیارهای برنامهریزی کوئری در Iceberg بینشهایی درباره اثربخشی pruning پارتیشن و آمار اسکن در سطح فایل میدهد.

نگهداری عملیاتی را هم فراموش نکنید (مثل فشردهسازی فایلها، پاکسازی اسنپشاتهای منقضی، و بهینهسازی متادیتا). این کارها عملکرد کوئری را حفظ میکنند و هزینههای ذخیرهسازی را در طول زمان کنترل میکنند. برای اینها جابهای خودکار بگذارید، جدی میگویم، نمیخواهید دستی انجامش بدهید.

بهترینروشها و درسهای آموختهشده

انتخاب فرمت جدول

واقعاً کی باید Iceberg را بهجای گزینههای دیگر انتخاب کنید؟ همیشه واضح نیست، و متنهای تبلیغاتی هم جواب سرراست نمیدهند.

Iceberg وقتی عالی است که به تضمینهای سازگاری قوی، تکامل شِمای پیچیده، و قابلیت سفر در زمان نیاز دارید. بارهای کاری ML بهخصوص از این ویژگیها سود میبرند چون ذاتاً آزمایشی هستند و بازتولیدپذیری میخواهند.

Delta Lake قابلیتهای مشابهی میدهد با یکپارچگی محکمتر در اکوسیستم Databricks. اگر عمدتاً داخل Databricks کار میکنید یا به ویژگیهای پیشرفته مثل liquid clustering نیاز دارید، Delta شاید انتخاب بهترتان باشد.

Apache Hudi برای سناریوهای استریمینگ با ایندکسگذاری پیشرفته بهینه شده است. برای سامانههای ML با نیاز استریمینگ سنگین یا الگوهای upsert پیچیده، آن را در نظر بگیرید.

و میدانید چیست؟ گاهی جدولهای Parquet ساده کافیاند. اگر بارکاری شما ساده و فقط append-only با شِمای پایدار است، سربار عملیاتی فرمتهای جدولی ممکن است ارزشش را نداشته باشد. برای مشکلهایی که واقعاً ندارید، راهحل بیشازحد مهندسی نکنید.

دامهای رایج

بیشازحد پارتیشنکردن احتمالاً رایجترین اشتباهی است که میبینم. ساختن پارتیشنهایی با کمتر از ۱۰۰ مگابایت داده یا بیشتر از ده هزار فایل در هر پارتیشن، عملکرد برنامهریزی کوئری را خراب میکند. آمار پارتیشن را پایش کنید و راهبردها را بر اساس الگوهای واقعی استفاده تنظیم کنید، نه ایدهآلهای تئوریک.

اشتباه در تکامل شِما میتواند مصرفکنندههای پاییندستی را حتی با وجود ویژگیهای ایمنی Iceberg بشکند. اعتبارسنجی شِما را در پایپلاینهای CI/CD پیاده کنید تا تغییرات ناسازگار قبل از استقرار گرفته شوند. از قابلیت column mapping استفاده کنید تا نامهای منطقی ستون را از ذخیرهسازی فیزیکی جدا کنید. بعداً کلی دردسر کمتر خواهید داشت.

ضدالگوهای کوئری وقتی ظاهر میشوند که تیمها از قابلیتهای بهینهسازی Iceberg استفاده نمیکنند. شرطهای پارتیشن را در WHERE بیاورید تا از اسکنهای غیرضروری جلوگیری کنید. از column pruning استفاده کنید، یعنی فقط ستونهای لازم را انتخاب کنید بهجای SELECT * (بله، میدانم راحت است، اما عملکرد کوئریتان از شما تشکر میکند).

راهبردهای مهاجرت

مهاجرت از دریاچههای دادهی قدیمی نیازمند برنامهریزی دقیق است. نمیتوانید فقط یک سوییچ را بزنید و انتظار داشته باشید همهچیز کار کند. در دوره گذار، سامانههای موازی پیاده کنید تا پایپلاینهای مبتنی بر Iceberg را در برابر سامانههای موجود اعتبارسنجی کنید.

اول دیتاستهای حیاتی ML را در اولویت بگذارید، تمرکز روی جدولهایی که بیشترین بهره را از قابلیتهای Iceberg میبرند. از قابلیت import استفاده کنید تا دیتاستهای Parquet موجود را بدون بازنویسی فایلهای داده مهاجرت دهید.

مهاجرت کوئری یعنی بهروزرسانی SQL برای استفاده از ویژگیهای Iceberg در حالی که سازگاری عقبرو حفظ میشود. فیچر فلگها یا انتخاب جدول مبتنی بر پیکربندی، عرضه تدریجی را ممکن میکند.

مهاجرت پایپلاین باید مرحلهای باشد. با پردازش بچ شروع کنید قبل از رفتن سراغ گردشکارهای استریمینگ. سازگاری Iceberg با APIهای موجود Spark تغییرات کد را هنگام مهاجرت کمینه میکند.

جمعبندی

Apache Iceberg و SparkSQL یک زیربنای محکم برای ساخت سامانههای ML فراهم میکنند که واقعاً در پروداکشن قابلاتکا کار کنند. ترکیب سفر در زمان، تکامل شِما، و تراکنشهای ACID به چالشهای بنیادی مدیریت داده پاسخ میدهد که سالها زیرساخت ML را آزار دادهاند.

این سرمایهگذاری از طریق افزایش سرعت توسعه، کاهش زمان دیباگ، و افزایش اعتماد به قابلیت اطمینان سیستم خودش را پس میدهد. تیمها بهطور پیوسته گزارش میدهند بازتولیدپذیری آزمایشها بهتر شده و زمان رسیدن مدلهای جدید به پروداکشن سریعتر شده است.

اما موفقیت نیازمند تصمیمهای طراحی سنجیده درباره پارتیشنبندی، طراحی شِما، و روالهای عملیاتی است. فناوری قابلیتهای قدرتمندی میدهد، اما باید هم معماری زیرین را بفهمید و هم نیازهای خاص بارهای کاری ML را، تا واقعاً از مزیتها بهره ببرید.

با رشد پیچیدگی و حیاتیشدن سامانههای ML برای کسبوکار، زیربناهای قابلاتکای داده روزبهروز مهمتر میشوند. Iceberg یک راهحل بالغ و آمادهی پروداکشن است که به سازمانها کمک میکند سامانههای ML را با همان توقعات قابلیت اطمینانِ اپلیکیشنهای سازمانی سنتی بسازند.