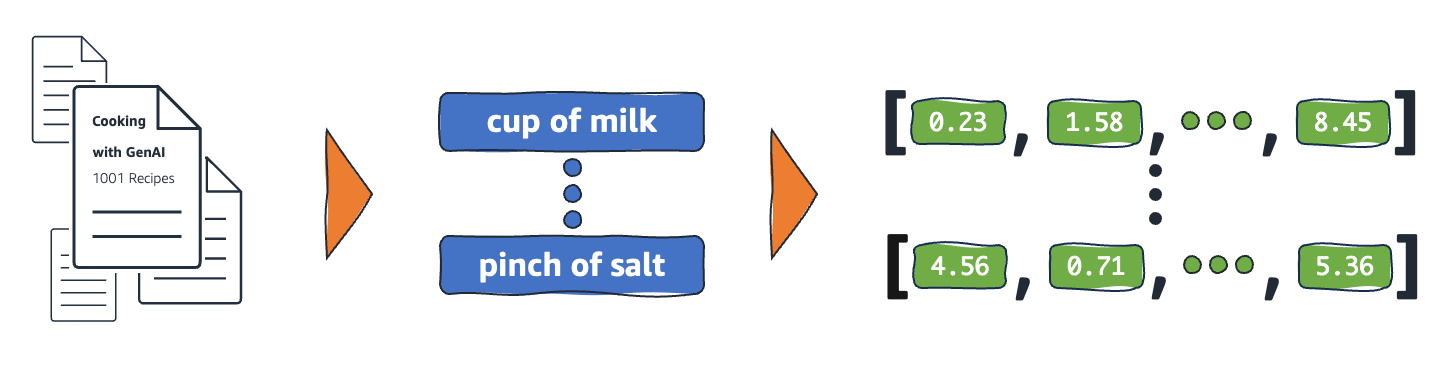

جاسازیها (Embeddings) نمایشهای عددی از اشیاء دنیای واقعی هستند که سیستمهای یادگیری ماشین (ML) و هوش مصنوعی (AI) از آنها برای درک حوزههای دانش پیچیده به شیوهای مشابه انسانها استفاده میکنند. به عنوان مثال، الگوریتمهای محاسباتی درک میکنند که تفاوت بین ۲ و ۳ برابر با ۱ است، که نشاندهنده رابطه نزدیک بین ۲ و ۳ در مقایسه با ۲ و ۱۰۰ است. با این حال، دادههای دنیای واقعی شامل روابط پیچیدهتری هستند. برای مثال، لانه پرنده و لانه شیر جفتهای مشابهی هستند، در حالی که روز و شب اصطلاحات متضادی هستند. جاسازیها اشیاء دنیای واقعی را به نمایشهای ریاضی پیچیده تبدیل میکنند که ویژگیها و روابط ذاتی بین دادههای دنیای واقعی را ثبت میکنند. کل این فرآیند خودکار است و سیستمهای هوش مصنوعی در طول آموزش جاسازیها را خودکار ایجاد کرده و از آنها برای انجام وظایف جدید استفاده میکنند.

چرا جاسازیها مهم هستند؟

جاسازیها مدلهای یادگیری عمیق را قادر میسازند تا حوزههای داده دنیای واقعی را به طور مؤثرتری درک کنند. آنها نحوه نمایش دادههای دنیای واقعی را سادهسازی میکنند در حالی که روابط معنایی و نحوی را حفظ میکنند. این امکان را به الگوریتمهای یادگیری ماشین میدهد تا انواع دادههای پیچیده را استخراج و پردازش کنند و برنامههای نوآورانه هوش مصنوعی را فعال کنند. بخشهای زیر برخی از عوامل مهم را توصیف میکنند:

کاهش ابعاد داده

دانشمندان داده از جاسازیها برای نمایش دادههای با ابعاد بالا در فضای با ابعاد پایین استفاده میکنند. در علم داده، اصطلاح بعد معمولاً به یک ویژگی یا صفت داده اشاره دارد. دادههای با ابعاد بالا در هوش مصنوعی به مجموعههای دادهای اشاره دارند که نقاط دادهای با ویژگیها یا صفات زیادی تعریف میشوند، که میتواند به معنای دهها، صدها یا حتی هزاران بعد باشد. برای مثال، یک تصویر میتواند دادهای با ابعاد بالا در نظر گرفته شود زیرا هر مقدار رنگ پیکسل یک بعد جداگانه است. وقتی با دادههای با ابعاد بالا مواجه میشوید، مدلهای یادگیری عمیق به قدرت محاسباتی و زمان بیشتری برای یادگیری، تحلیل و استنتاج دقیق نیاز دارند. جاسازیها با شناسایی اشتراکات و الگوهای بین ویژگیهای مختلف، تعداد ابعاد را کاهش میدهند. این امر به نوبه خود منابع محاسباتی و زمان موردنیاز برای پردازش دادههای خام را کاهش میدهد.

آموزش مدلهای زبانی بزرگ

جاسازیها کیفیت داده را هنگام آموزش مدلهای زبانی بزرگ (LLMs) بهبود میبخشند. برای مثال، دانشمندان داده از جاسازیها برای پاکسازی دادههای آموزشی از ناهنجاریهایی که یادگیری مدل را تحت تأثیر قرار میدهند استفاده میکنند. مهندسان یادگیری ماشین همچنین میتوانند مدلهای از پیش آموزشدیده را با افزودن جاسازیهای جدید برای یادگیری انتقال (transfer learning) بازاستفاده کنند، که نیازمند اصلاح مدل پایه با مجموعههای داده جدید است. با جاسازیها، مهندسان میتوانند یک مدل را برای مجموعههای داده سفارشی از دنیای واقعی تنظیم دقیق کنند.

ساخت برنامههای نوآورانه

جاسازیها برنامههای جدید یادگیری عمیق و هوش مصنوعی مولد (generative AI) را فعال میکنند. تکنیکهای مختلف جاسازی که در معماری شبکههای عصبی اعمال میشوند، امکان توسعه، آموزش و استقرار مدلهای هوش مصنوعی دقیق در زمینهها و برنامههای مختلف را فراهم میکنند. برای مثال:

- با جاسازیهای تصویری، مهندسان میتوانند برنامههای بینایی کامپیوتری با دقت بالا برای تشخیص اشیاء، شناسایی تصویر و سایر وظایف مرتبط با تصویر بسازند.

- با جاسازیهای کلمه، نرمافزارهای پردازش زبان طبیعی میتوانند زمینه و روابط کلمات را دقیقتر درک کنند.

- جاسازیهای گرافیکی اطلاعات مرتبط را از گرههای بههمپیوسته استخراج و دستهبندی میکنند تا از تحلیل شبکه پشتیبانی کنند. مدلهای بینایی کامپیوتری، چتباتهای هوش مصنوعی و سیستمهای توصیهگر هوش مصنوعی همگی از جاسازیها برای انجام وظایف پیچیدهای که هوش انسانی را تقلید میکنند استفاده میکنند.

بردارها در جاسازیها چیست؟

مدلهای یادگیری ماشین نمیتوانند اطلاعات را به صورت خام به طور هوشمند تفسیر کنند و به دادههای عددی به عنوان ورودی نیاز دارند. آنها از جاسازیهای شبکه عصبی برای تبدیل اطلاعات دنیای واقعی به نمایشهای عددی به نام بردارها استفاده میکنند. بردارها مقادیر عددی هستند که اطلاعات را در یک فضای چندبعدی نمایش میدهند. آنها به مدلهای یادگیری ماشین کمک میکنند تا شباهتهای بین اقلام پراکنده توزیعشده را پیدا کنند.

هر شیء که یک مدل یادگیری ماشین از آن یاد میگیرد، ویژگیها یا صفات مختلفی دارد. به عنوان یک مثال ساده، فیلمها و برنامههای تلویزیونی زیر را در نظر بگیرید. هر کدام با ژانر، نوع و سال انتشار مشخص میشوند:

- کنفرانس (ترسناک، ۲۰۲۳، فیلم)

- آپلود (کمدی، ۲۰۲۳، برنامه تلویزیونی، فصل سوم)

- داستانهایی از سرداب (ترسناک، ۱۹۸۹، برنامه تلویزیونی، فصل هفتم)

- سناریوی رویایی (ترسناک-کمدی، ۲۰۲۳، فیلم)

مدلهای یادگیری ماشین میتوانند متغیرهای عددی مانند سالها را تفسیر کنند، اما نمیتوانند متغیرهای غیرعددی مانند ژانر، نوع، قسمتها و تعداد کل فصلها را مقایسه کنند. بردارهای جاسازی دادههای غیرعددی را به مجموعهای از مقادیر رمزگذاری میکنند که مدلهای یادگیری ماشین میتوانند آنها را درک کرده و مرتبط کنند. برای مثال، نمایش فرضی زیر از برنامههای تلویزیونی ذکرشده در بالا ارائه شده است:

- کنفرانس (۱.۲، ۲۰۲۳، ۲۰.۰)

- آپلود (۲.۳، ۲۰۲۳، ۳۵.۵)

- داستانهایی از سرداب (۱.۲، ۱۹۸۹، ۳۶.۷)

- سناریوی رویایی (۱.۸، ۲۰۲۳، ۲۰.۰)

عدد اول در بردار به ژانر خاصی اشاره دارد. یک مدل یادگیری ماشین متوجه خواهد شد که کنفرانس و داستانهایی از سرداب ژانر یکسانی دارند. به همین ترتیب، مدل بر اساس عدد سوم، که نشاندهنده قالب، فصلها و قسمتها است، روابط بیشتری بین آپلود و داستانهایی از سرداب پیدا خواهد کرد. با معرفی متغیرهای بیشتر، میتوانید مدل را برای فشردهسازی اطلاعات بیشتر در یک فضای بردار کوچکتر اصلاح کنید.

جاسازیها چگونه کار میکنند؟

جاسازیها دادههای خام را به مقادیر پیوسته تبدیل میکنند که مدلهای یادگیری ماشین میتوانند آنها را تفسیر کنند. به طور سنتی، مدلهای یادگیری ماشین از کدگذاری یک-داغ (one-hot encoding) برای نگاشت متغیرهای دستهای به فرمهایی که میتوانند از آنها یاد بگیرند استفاده میکنند. روش کدگذاری هر دسته را به ردیفها و ستونها تقسیم میکند و به آنها مقادیر باینری اختصاص میدهد. دستههای محصولات و قیمت آنها را در نظر بگیرید:

| میوهها | قیمت |

| سیب | ۵.۰۰ |

| پرتقال | ۷.۰۰ |

| هویج | ۱۰.۰۰ |

نمایش این مقادیر با کدگذاری یک-داغ منجر به جدول زیر میشود:

| سیب | پرتقال | گلابی | قیمت |

| ۱ | ۰ | ۰ | ۵.۰۰ |

| ۰ | ۱ | ۰ | ۷.۰۰ |

| ۰ | ۰ | ۱ | ۱۰.۰۰ |

این جدول به صورت ریاضی به صورت بردارهای [۱,۰,۰,۵.۰۰]، [۰,۱,۰,۷.۰۰] و [۰,۰,۱,۱۰.۰۰] نمایش داده میشود. کدگذاری یک-داغ مقادیر بعدی ۰ و ۱ را گسترش میدهد بدون اینکه اطلاعاتی ارائه دهد که به مدلها کمک کند اشیاء مختلف را مرتبط کنند. برای مثال، مدل نمیتواند شباهت بین سیب و پرتقال را به عنوان میوه تشخیص دهد، و همچنین نمیتواند پرتقال و هویج را به عنوان میوه و سبزی تمایز دهد. با افزودن دستههای بیشتر به لیست، کدگذاری منجر به متغیرهای پراکنده توزیعشده با مقادیر خالی زیادی میشود که فضای حافظه عظیمی را مصرف میکنند.

جاسازیها اشیاء را به فضای با ابعاد پایین بردارسازی میکنند و شباهتهای بین اشیاء را با مقادیر عددی نمایش میدهند. جاسازیهای شبکه عصبی اطمینان میدهند که تعداد ابعاد با گسترش ویژگیهای ورودی قابل مدیریت باقی میماند. ویژگیهای ورودی خصوصیات اشیاء خاصی هستند که الگوریتم یادگیری ماشین وظیفه تحلیل آنها را دارد. کاهش ابعاد به جاسازیها اجازه میدهد اطلاعاتی را حفظ کنند که مدلهای یادگیری ماشین برای یافتن شباهتها و تفاوتها از دادههای ورودی استفاده میکنند. دانشمندان داده همچنین میتوانند جاسازیها را در یک فضای دوبعدی تجسم کنند تا روابط اشیاء توزیعشده را بهتر درک کنند.

مدلهای Embeddings چیست؟

مدلهای جاسازی الگوریتمهایی هستند که برای کپسولهسازی اطلاعات به نمایشهای متراکم در یک فضای چندبعدی آموزش دیدهاند. دانشمندان داده از مدلهای جاسازی برای توانمندسازی مدلهای یادگیری ماشین برای درک و استدلال با دادههای با ابعاد بالا استفاده میکنند. اینها مدلهای جاسازی رایج مورد استفاده در برنامههای یادگیری ماشین هستند:

تحلیل مؤلفه اصلی (PCA)

تحلیل مؤلفه اصلی (PCA) یک تکنیک کاهش ابعاد است که انواع دادههای پیچیده را به بردارهای با ابعاد پایین کاهش میدهد. این روش نقاط داده با شباهتها را پیدا کرده و آنها را به بردارهای جاسازی فشرده میکند که دادههای اصلی را منعکس میکنند. در حالی که PCA به مدلها اجازه میدهد دادههای خام را کارآمدتر پردازش کنند، ممکن است در طول پردازش اطلاعات از دست برود.

تجزیه مقدار تکین (SVD)

تجزیه مقدار تکین (SVD) یک مدل جاسازی است که یک ماتریس را به ماتریسهای تکین خود تبدیل میکند. ماتریسهای حاصل اطلاعات اصلی را حفظ میکنند در حالی که به مدلها اجازه میدهند روابط معنایی دادههایی که نمایش میدهند را بهتر درک کنند. دانشمندان داده از SVD برای فعالسازی وظایف مختلف یادگیری ماشین، از جمله فشردهسازی تصویر، طبقهبندی متن و توصیه استفاده میکنند.

Word2Vec

Word2Vec یک الگوریتم یادگیری ماشین است که برای ارتباط دادن کلمات و نمایش آنها در فضای جاسازی آموزش دیده است. دانشمندان داده مدل Word2Vec را با مجموعههای داده متنی عظیم تغذیه میکنند تا درک زبان طبیعی را فعال کنند. این مدل با در نظر گرفتن زمینه و روابط معنایی کلمات، شباهتها را پیدا میکند. دو نوع از Word2Vec وجود دارد—کیسه کلمات پیوسته (CBOW) و Skip-gram. CBOW به مدل اجازه میدهد کلمهای را از زمینه دادهشده پیشبینی کند، در حالی که Skip-gram زمینه را از یک کلمه دادهشده استخراج میکند. در حالی که Word2Vec یک تکنیک جاسازی کلمه مؤثر است، نمیتواند تفاوتهای زمینهای یک کلمه یکسان که برای معانی مختلف استفاده میشود را به دقت تمایز دهد.

BERT

BERT یک مدل زبانی مبتنی بر ترانسفورمر است که با مجموعههای داده عظیم برای درک زبانها به شیوهای مشابه انسانها آموزش دیده است. مانند Word2Vec، BERT میتواند جاسازیهای کلمه را از دادههای ورودی که با آن آموزش دیده است ایجاد کند. علاوه بر این، BERT میتواند معانی زمینهای کلمات را هنگام اعمال در عبارات مختلف تمایز دهد. برای مثال، BERT جاسازیهای متفاوتی برای “play” در “من به یک نمایش رفتم” و “من دوست دارم بازی کنم” ایجاد میکند.

جاسازیها چگونه ایجاد میشوند؟

مهندسان از شبکههای عصبی برای ایجاد جاسازیها استفاده میکنند. شبکههای عصبی شامل لایههای نورونی مخفی هستند که تصمیمات پیچیده را به صورت تکراری انجام میدهند. هنگام ایجاد جاسازیها، یکی از لایههای مخفی میآموزد که چگونه ویژگیهای ورودی را به بردارها تجزیه کند. این فرآیند قبل از لایههای پردازش ویژگی رخ میدهد. این فرآیند تحت نظارت و هدایت مهندسان با مراحل زیر انجام میشود:

- مهندسان شبکه عصبی را با برخی نمونههای بردارسازیشده که به صورت دستی آماده شدهاند تغذیه میکنند.

- شبکه عصبی از الگوهای کشفشده در نمونه یاد میگیرد و از این دانش برای پیشبینیهای دقیق از دادههای نادیده استفاده میکند.

- گاهی اوقات، مهندسان ممکن است نیاز به تنظیم دقیق مدل داشته باشند تا اطمینان حاصل کنند که ویژگیهای ورودی را در فضای بعدی مناسب توزیع میکند.

- با گذشت زمان، جاسازیها به طور مستقل عمل میکنند و به مدلهای یادگیری ماشین اجازه میدهند توصیههایی از نمایشهای بردارسازیشده تولید کنند.

- مهندسان عملکرد جاسازی را به طور مداوم نظارت کرده و با دادههای جدید تنظیم دقیق میکنند.