راهنمای جامع گامبهگام PostgreSQL Import Dump

انتقال کارآمد دادهها بین پایگاههای داده برای عملیات روان و رشد کسبوکارها حیاتی است. در میان سیستمهای مدیریت پایگاه دادههای متعدد، PostgreSQL قابلیت اطمینان، مقیاسپذیری و مجموعهای غنی از ویژگیها را ارائه میدهد که آن را به انتخاب مناسبی برای اکثر سازمانها تبدیل میکند. با این حال، مهاجرت دادهها بین پایگاههای داده—چه برای ارتقای سیستمها یا تلفیق اطلاعات—نیازمند برنامهریزی و اجرای دقیق است تا اختلالات را به حداقل برساند و یکپارچگی دادهها را تضمین کند.

محیطهای مدرن PostgreSQL نیازمند رویکردهای پیچیدهای برای مدیریت دامپ هستند که تعادل بین عملکرد، امنیت و قابلیت اطمینان را برقرار کنند. با معرفی ویژگیهایی مانند دامپ موازی، الگوریتمهای فشردهسازی بهبودیافته و قابلیتهای تکثیر منطقی پیشرفته در نسخههای اخیر PostgreSQL، سازمانها اکنون میتوانند زمانهای مهاجرت به طور قابل توجهی سریعتری را با حفظ استانداردهای امنیتی سطح سازمانی به دست آورند. درک این قابلیتهای پیشرفته برای متخصصان داده که عملیات پایگاه داده در مقیاس بزرگ را مدیریت میکنند، ضروری است، جایی که رویکردهای سنتی تکریسمانی ناکافی ثابت میشوند.

در این مقاله، شما در مورد import دامپ PostgreSQL خواهید آموخت، با تمرکز بر تسلط بر عملکرد آنها در ابزارها و سناریوهای مختلف. قبل از شروع، اطمینان حاصل کنید که نمونه PostgreSQL مقصد به درستی آماده شده است—این ممکن است شامل ایجاد پایگاه داده جدید، پیکربندی نقشها و مجوزهای لازم، و تأیید سازگاری نسخه سرور با دامپی که قصد بازگردانی آن را دارید، باشد.

Dump پایگاه داده PSQL در PostgreSQL چیست؟

PostgreSQL یک سیستم قدرتمند مدیریت پایگاه داده رابطهای متنباز است که از طیف گستردهای از انواع دادهها پشتیبانی میکند، از جمله دادههای ساختیافته، غیرساختیافته و نیمهساختیافته، که آن را به انتخابی چندمنظوره برای موارد استفاده مختلف تبدیل میکند. پایگاههای داده PostgreSQL بسیار قابل سفارشیسازی هستند، با افزونههایی که عملکردهایی مانند رمزنگاری داده، جستجوی تماممتن و بیشتر را اضافه میکنند. درک نحوه مدیریت و نگهداری پایگاههای داده PostgreSQL برای تضمین یکپارچگی و در دسترس بودن دادهها حیاتی است.

PostgreSQL Import Dump چگونه کار میکند؟

Import دامپ PostgreSQL (یا دامپ) یک فایل پشتیبان منطقی از محتویات پایگاه داده PostgreSQL است. آن شامل دستورات SQL لازم برای بازسازی schema و دادهها است، که به مهاجرت داده، بازیابی فاجعه و تکثیر پایگاه داده کمک میکند. pg_dump میتواند کل پایگاه داده را بدون مسدود کردن کاربران پشتیبانگیری کند و شامل مجوزهای دسترسی است مگر اینکه –no-acl استفاده شود.

استفاده از رابط خط فرمان برای اجرای مؤثر pg_dump و pg_restore حیاتی است. pg_dump از چندین فرمت خروجی پشتیبانی میکند—متن ساده، سفارشی، دایرکتوری و tar. فرمت سفارشی برای pg_restore مناسب است و از فشردهسازی و دامپهای موازی پشتیبانی میکند. گزینههایی مانند –exclude-table به شما اجازه میدهد جداول خاص را حذف کنید. pg_dump و pg_dumpall میتوانند پشتیبانگیریها را در سراسر پایگاههای داده در یک cluster مدیریت کنند.

نسخههای اخیر PostgreSQL (14-17) بهبودهای قابل توجهی در عملیات دامپ معرفی کردهاند. PostgreSQL 14 قابلیتهای دامپ موازی را برای دامپهای فرمت دایرکتوری اضافه کرد، در حالی که نسخه ۱۵ فشردهسازی سمت سرور با الگوریتمهای Zstandard را معرفی کرد. نسخه ۱۶ ویژگیهای تکثیر منطقی را با فیلتر ردیف گسترش داد، و PostgreSQL 17 پشتیبانی از پشتیبانگیری افزایشی و تابآوری خطای بهبودیافته در عملیات bulk را معرفی کرد. این بهبودها به طور جمعی زمانهای دامپ را ۳۰-۷۰% برای پایگاههای داده بزرگ کاهش میدهند در حالی که سازگاری و قابلیت اطمینان را حفظ میکنند.

مزایای استفاده از Import Dump

فرمت پشتیبان مستقل از پلتفرم، مهاجرت روان بین سیستمعاملها و نسخههای PostgreSQL را امکانپذیر میسازد. کنترل دقیق بر فرآیند مهاجرت اجازه سفارشیسازی داده، schema و تعاریف شیء را میدهد. ذخیرهسازی و انتقال کارآمد داده، نیازهای پهنای باند و ذخیرهسازی را به حداقل میرساند. سازگاری نقطهدر-زمان، یکپارچگی ارجاعی در سراسر جداول مرتبط و روابط کلید خارجی را تضمین میکند. قابلیتهای بازگردانی انتخابی، بازیابی هدفمند schemaها، جداول یا زیرمجموعههای داده خاص را بدون بازسازی کامل پایگاه داده امکانپذیر میسازد.

بهترین شیوهها

پشتیبانگیری قبل از صادرات: همیشه پشتیبانگیری اخیر از پایگاه داده منبع را نگه دارید.

در نظر گرفتن اندازه داده و فشردهسازی: دامپهای بزرگ را با gzip فشرده کنید یا از فشردهسازی Zstandard سمت سرور PostgreSQL 15+ برای کارایی انتقال بهینه استفاده کنید.

پرداختن به تفاوتهای schema: دستورات SQL صادرشده را با schema مقصد تطبیق دهید؛ از چندین schema و سوئیچ -n برای انتخاب schemaهای خاص استفاده کنید.

تست و مستندسازی: Import آزمایشی روی سیستم staging انجام دهید و فرآیند را مستند کنید، شامل الزامات وابستگی و بررسیهای سازگاری نسخه.

استفاده از فایلهای اسکریپت SQL: اسکریپتهای SQL ساده حداکثر سازگاری cross-DB را فراهم میکنند هرچند عملکرد بازگردانی ممکن است کندتر از فرمتهای باینری باشد.

دامپهای فقط داده: فقط داده را با –data-only صادر کنید؛ با –disable-triggers ترکیب کنید و پس از آن ANALYZE را اجرا کنید برای عملکرد پرسوجوی بهینه.

بهرهبرداری از پردازش موازی: از دامپهای فرمت دایرکتوری با پارامتر -j برای فعالسازی عملیات موازی استفاده کنید که میتواند زمان پردازش را ۵۰-۷۰% روی سیستمهای چندهستهای کاهش دهد.

در زیر سه روش مختلف—pgAdmin، psql و Airbyte—برای Import داده به PostgreSQL آورده شده است.

مراحل استفاده از pgAdmin برای PostgreSQL Import Dump چیست؟

این روش پوشش ایجاد پشتیبانگیری پایگاه داده و بازگردانی آن با pgAdmin را شامل میشود، که رابط گرافیکی کاربرپسند برای عملیات پایگاه داده فراهم میکند.

پیشنیازها دسترسی خواندنی به DB منبع و دسترسی خواندن/نوشتن به DB مقصد. مجوز ایجاد پایگاه داده جدید در صورت نیاز. pgAdmin نصبشده و به درستی با اتصالات پایگاه داده پیکربندیشده. پشتیبانگیری تازه از پایگاه داده منبع با یکپارچگی تأییدشده. اندازه پایگاه داده (گزینههای فشردهسازی)، تفاوتهای schema و سازگاری نسخه بین سیستمهای منبع و مقصد را در نظر بگیرید.

گام ۱: Exporting Data

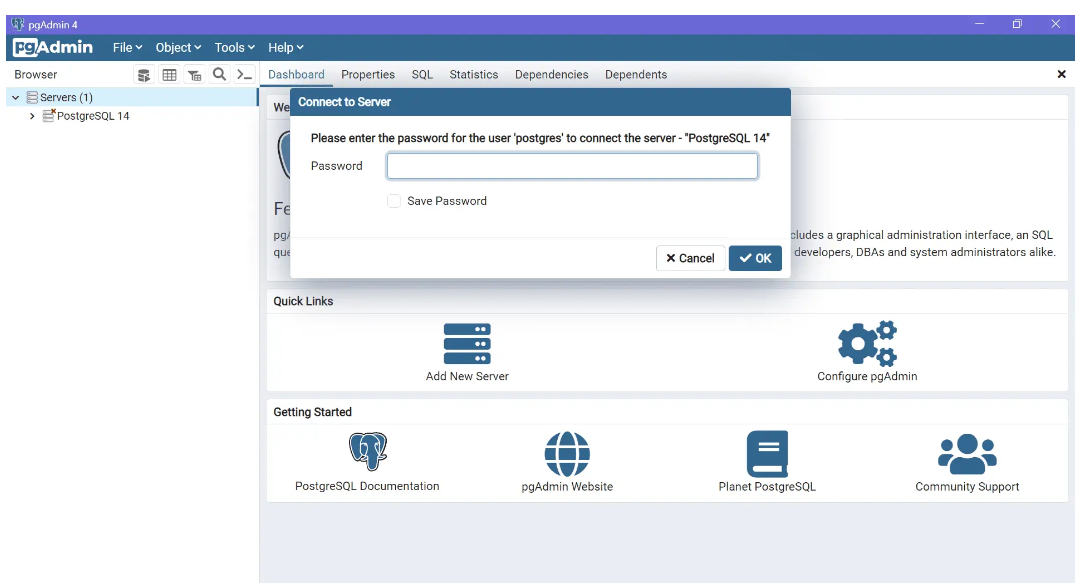

- pgAdmin را باز کنید و با اعتبارنامهها و پارامترهای اتصال مناسب به سرور منبع متصل شوید.

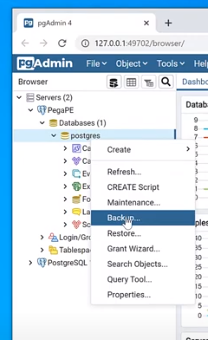

- روی پایگاه داده مورد نظر راستکلیک کنید و Backup را از منوی زمینه انتخاب کنید تا فرآیند صادرات آغاز شود.

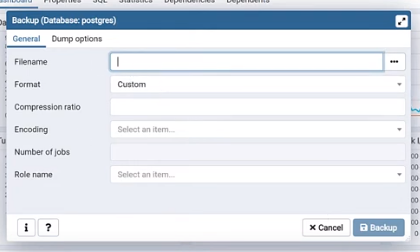

- مسیر و نام فایل خروجی را مشخص کنید، فرمت Custom یا Tar را برای انعطافپذیری بازگردانی بهینه انتخاب کنید، جداول یا schemaهای خاص را در صورت نیاز پشتیبانگیری جزئی انتخاب کنید، تنظیمات فشردهسازی را پیکربندی کنید و روی Backup کلیک کنید تا فرآیند آغاز شود.

گام ۲: Importing Data

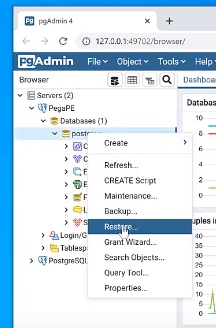

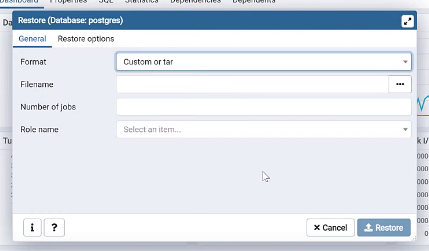

به سرور پایگاه داده مقصد بروید و روی پایگاه داده مقصد راستکلیک کنید، سپس Restore را از گزینههای موجود انتخاب کنید.

محیط پایگاه داده مقصد را آماده کنید: اگر پایگاه داده جدید ایجاد میکنید، CREATE DATABASE را در Query Tool pgAdmin با تنظیمات مناسب اجرا کنید؛ اگر دادههای موجود را بازنویسی میکنید، ابتدا جداول یا schemaهای متعارض را با دقت drop کنید و اطمینان حاصل کنید که تمام وابستگیها به درستی مدیریت شدهاند.

فرمت Custom را در دیالوگ بازگردانی انتخاب کنید، مسیر کامل به فایل دامپ را ارائه دهید، هرگونه نگاشت نقش یا گزینههای فیلتر شیء لازم را پیکربندی کنید و روی Restore کلیک کنید تا عملیات Import اجرا شود.

پس از تکمیل، بازگردانی را با بررسی تعداد جداول، یکپارچگی داده و اطمینان از بازسازی مناسب تمام ایندکسها و محدودیتها تأیید کنید. pgAdmin لاگهای دقیقی ارائه میدهد که به عیبیابی مسائل در فرآیند بازگردانی کمک میکند.

چگونه از خط فرمان psql برای PostgreSQL Import Dump استفاده کنید؟

این روش از پوسته SQL برای صادرات و Import دامپها استفاده میکند، که حداکثر کنترل و انعطافپذیری برای عملیات پایگاه داده پیشرفته فراهم میکند.

پیشنیازها

psql و pg_dump نصبشده و به درستی در PATH سیستم پیکربندیشده. آشنایی با رابطهای خط فرمان و نحو دستورات PostgreSQL. مجوزهای کافی پایگاه داده برای ایجاد پایگاههای داده، جداول و تغییر دادهها طبق نیاز. اتصال شبکه و اعتبارنامههای احراز هویت برای هر دو سیستم پایگاه داده منبع و مقصد.

گام ۱: Exporting Data

پوسته SQL (psql) یا ترمینال فرمان را باز کنید و با پارامترهای اتصال مناسب به پایگاه داده منبع متصل شوید. ۲. دستور دامپ را با پارامترهای مناسب اجرا کنید:

pg_dump -h <host> -p <port> -U <user> -d mydb -t table1 > mydump.sqlبرای عملکرد بهبودیافته با پایگاههای داده بزرگ، فرمت دایرکتوری با پردازش موازی را در نظر بگیرید:

pg_dump -h <host> -p <port> -U <user> -Fd -j 4 -f mydump_dir mydbپس از بازگردانی، ANALYZE را اجرا کنید تا آمار بهینهساز را بازتولید کند و عملکرد پرسوجوی بهینه را در تمام جداول واردشده تضمین کند.

گام ۲: Importing Data

محیط پایگاه داده مقصد را با تنظیمات مناسب ایجاد یا آماده کنید:

CREATE DATABASE testdb WITH ENCODING 'UTF8' LC_COLLATE='en_US.UTF-8' LC_CTYPE='en_US.UTF-8';دامپ را با روش مناسب بر اساس فرمت وارد کنید: برای دامپهای SQL ساده:

psql -U <user> -W -d testdb -f my_dump.sqlبرای دامپهای فرمت سفارشی با بازگردانی موازی:

pg_restore -U <user> -d testdb -j 4 --verbose mydump.backupاز -O برای بازنویسی مالکیت شیء در صورت نیاز و –no-privileges برای رد کردن بازگردانی ACL استفاده کنید زمانی که نگاشت نقش بین سیستمهای منبع و مقصد متفاوت است.

گام ۳: بررسیهای پس از Import

یکپارچگی داده را با دستورات SELECT جامع، شمارش ردیفها و پرسوجوهای اعتبارسنجی داده در سراسر جداول حیاتی تأیید کنید. مجوزها، نقشها و سیاستهای امنیتی لازم را که ممکن است در فرآیند Import به درستی منتقل نشده باشند، دوباره اعمال کنید. آمار پایگاه داده را با اجرای ANALYZE روی تمام جداول واردشده بهروزرسانی کنید تا اطمینان حاصل شود که بهینهساز پرسوجو اطلاعات فعلی دارد. اتصال و عملکرد برنامه را تست کنید تا تأیید شود که مهاجرت با موفقیت تکمیل شده است. پایگاههای داده منسوخ را تنها پس از تأیید کامل و تأیید ذینفعان drop کنید تا از از دست رفتن تصادفی داده جلوگیری شود.

استراتژیهای بهینهسازی عملکرد پیشرفته برای عملیات دامپ بزرگ PostgreSQL چیست؟

محیطهای مدرن PostgreSQL نیازمند تکنیکهای بهینهسازی پیچیده برای مدیریت کارآمد عملیات دامپ در مقیاس بزرگ هستند. این استراتژیها زمانی حیاتی میشوند که پایگاههای داده بیش از 100GB را مدیریت میکنند یا برنامههای با توان عملیاتی بالا را پشتیبانی میکنند که زمان توقف باید به حداقل برسد.

پردازش موازی و مدیریت منابع

فرمت دایرکتوری PostgreSQL عملیات دامپ موازی را امکانپذیر میسازد که زمان پردازش را به طور قابل توجهی کاهش میدهد. از pg_dump -Fd -j N استفاده کنید که N برابر ۷۵% هستههای CPU موجود است تا توان عملیاتی را بهینه کند بدون اینکه منابع سیستم را تحت فشار قرار دهد. برای بازگردانی، pg_restore -j N مزایای موازیسازی مشابهی فراهم میکند، با عملکرد بهینه معمولاً زمانی که تعداد jobها برابر تعداد هستههای CPU فیزیکی است.

منابع سیستم را در طول عملیات موازی با ابزارهایی مانند htop یا iostat نظارت کنید تا اطمینان حاصل شود که زیرسیستمهای حافظه و I/O اشباع نشدهاند. work_mem و maintenance_work_mem را به طور مناسب پیکربندی کنید—افزایش موقت این مقادیر در طول عملیات بزرگ میتواند عملکرد را بهبود بخشد، اما در سیستمهای با RAM محدود مراقب خستگی حافظه باشید.

بهینهسازی فشردهسازی و ذخیرهسازی

PostgreSQL 15+ فشردهسازی سمت سرور با استفاده از الگوریتمهای Zstandard را معرفی کرد، که نسبتهای فشردهسازی برتر نسبت به gzip سنتی را در حالی که سرعتهای استخراج سریعتری را حفظ میکند، فراهم میکند. از pg_dump -Z6 برای فشردهسازی متعادل استفاده کنید، یا pg_dump -Z0 برای غیرفعال کردن فشردهسازی زمانی که پهنای باند شبکه فراوان است و ذخیرهسازی محدود نیست.

برای پایگاههای داده بسیار بزرگ، دامپها را بر اساس الگوهای schema یا جدول با pg_dump -n ‘schema_name*’ یا pg_dump -T ‘log_*’ برای حذف دادههای غیرحیاتی تقسیم کنید. این رویکرد بازگردانی انتخابی و پردازش موازی بخشهای داده مختلف را در سراسر سیستمهای متعدد امکانپذیر میسازد.

تکنیکهای بازگردانی پیشرفته

استراتژیهای بازگردانی schema-first را با استفاده از pg_restore –schema-only به دنبال pg_restore –data-only برای بهینهسازی Import بزرگ پیادهسازی کنید. این جداسازی بهینهسازی ایجاد ایندکس و محدودیت را امکانپذیر میسازد و کنترل بهتری بر توالی بازگردانی فراهم میکند.

تریگرها و محدودیتها را در طول بارگذاری داده با pg_restore –disable-triggers و SET session_replication_role = replica غیرفعال کنید تا سربار اعتبارسنجی را دور بزنید. پس از تکمیل Import داده، محدودیتها را دوباره فعال کنید و بررسیهای یکپارچگی جامع را اجرا کنید تا سازگاری داده را تضمین کند. این رویکرد میتواند زمان Import را ۴۰-۶۰% برای پایگاههای داده با روابط محدودیت پیچیده کاهش دهد.

بهینهسازی بومی ابر

از بهینهسازیهای ارائهدهنده ابر برای عملیات دامپ PostgreSQL بهره ببرید. AWS RDS از عملیات pg_dump موازی با دسترسی هماهنگ بافر پشتیبانی میکند، در حالی که Google Cloud SQL یکپارچگی بومی با Cloud Storage برای Export/Import مستقیم دامپ فراهم میکند. Azure Database for PostgreSQL عملیات موازی فرمت دایرکتوری را با نظارت و هشدار یکپارچه ارائه میدهد.

استفاده از ذخیرهسازی ابر با سیاستهای lifecycle برای بایگانی دامپ را در نظر بگیرید—Amazon S3 Glacier Instant Retrieval یا خدمات معادل ذخیرهسازی بلندمدت مقرونبهصرفه را در حالی که دسترسی سریع برای سناریوهای بازیابی را حفظ میکند، فراهم میکند. سیاستهای نگهداری خودکار را برای مدیریت هزینههای ذخیرهسازی در حالی که الزامات رعایت را برآورده میکند، پیادهسازی کنید.

ملاحظات امنیتی ضروری و الزامات رعایت برای مدیریت دامپ PostgreSQL چیست؟

عملیات دامپ PostgreSQL سازمانی نیازمند چارچوبهای امنیتی جامع هستند که دادههای حساس را در سراسر چرخه حیات پشتیبانگیری محافظت کنند در حالی که رعایت الزامات نظارتی مانند GDPR، HIPAA و PCI DSS را تضمین میکنند.

رمزنگاری و کنترل دسترسی

رمزنگاری انتهابهانتها را برای دامپهای PostgreSQL با pg_dump –encrypt با GPG پیادهسازی کنید یا با سیستمهای مدیریت کلید ابر (KMS) برای چرخش کلید سطح سازمانی یکپارچه شوید. تمام فایلهای دامپ باید در حالت استراحت با استانداردهای رمزنگاری AES-256 رمزنگاری شوند، با کلیدها جدا از دادههای رمزنگاریشده ذخیره شوند تا از دسترسی غیرمجاز جلوگیری شود.

کنترل دسترسی مبتنی بر نقش (RBAC) را برای عملیات دامپ از طریق سیستم احراز هویت بومی PostgreSQL ترکیبشده با ارائهدهندگان هویت خارجی برقرار کنید. مجوزهای حداقلی لازم را با استفاده از نقشهای پشتیبانگیری اختصاصی که تنها میتوانند جداول مورد نیاز را بخوانند، اعطا کنید و از مجوزهای superuser که خطر امنیتی غیرضروری ایجاد میکنند، اجتناب کنید. احراز هویت چندعاملی را برای تمام کاربرانی که به سیستمهای ذخیرهسازی دامپ دسترسی دارند، پیادهسازی کنید.

ماسکینگ و ناشناسسازی داده

برای محیطهای غیرتولیدی، استراتژیهای ماسکینگ داده جامع را پیادهسازی کنید که اطلاعات حساس را محافظت کنند در حالی که کاربرد داده را حفظ میکنند. از PostgreSQL Anonymizer یا ابزارهای مشابه برای جایگزینی اطلاعات قابل شناسایی شخصی (PII) با دادههای مصنوعی واقعی اما مصنوعی که یکپارچگی ارجاعی و خواص آماری را حفظ میکند، استفاده کنید.

سیاستهای طبقهبندی داده واضح را برقرار کنید که انواع دادههای حساس ویژه در طول عملیات دامپ را شناسایی کنند. ابزارهای اسکن خودکار را پیادهسازی کنید که PII، دادههای مالی و اطلاعات بهداشتی را در schemaهای پایگاه داده تشخیص دهند و اطمینان حاصل کنند که قوانین ماسکینگ مناسب به طور مداوم در تمام فرآیندهای پشتیبانگیری اعمال میشوند.

چارچوب حسابرسی و رعایت

حسابرسی لاگینگ جامع را برای تمام عملیات دامپ با افزونه pgAudit PostgreSQL یا راهحلهای مشابه مستقر کنید. پیگیری کنید که چه کسی دامپها را آغاز کرده، عملیات چه زمانی رخ داده، کدام داده دسترسی داشته و فایلهای دامپ کجا ذخیره شدهاند. لاگهای حسابرسی را با سیستمهای مدیریت اطلاعات و رویدادهای امنیتی (SIEM) برای نظارت زمان واقعی و هشدار خودکار یکپارچه کنید.

ردپاهای حسابرسی غیرقابل تغییر را حفظ کنید که توسط کاربران اداری قابل تغییر یا حذف نباشند. تأیید یکپارچگی لاگ را از طریق هشینگ رمزنگاریشده پیادهسازی کنید و رکوردهای حسابرسی را در محیطهای جداگانه و بسیار امن ذخیره کنید. بررسیهای حسابرسی منظم باید رعایت سیاستهای سازمانی و الزامات نظارتی را تأیید کنند.

امنیت ذخیرهسازی و مدیریت نگهداری

دامپهای PostgreSQL را در محیطهای ایزوله و air-gapped ذخیره کنید که دسترسی غیرمجاز را جلوگیری کنند و در برابر حملات ransomware محافظت کنند. مکانیسمهای ذخیرهسازی Write-Once-Read-Many (WORM) یا قفل شیء را پیادهسازی کنید که دستکاری را در طول دورههای نگهداری جلوگیری کنند. از مکانهای ذخیرهسازی توزیعشده جغرافیایی برای تضمین در دسترس بودن در سناریوهای فاجعه استفاده کنید.

سیاستهای نگهداری خودکار را برقرار کنید که دامپها را پس از انقضای الزامات نظارتی یا تجاری به طور امن حذف کنند. تکنیکهای پاکسازی رمزنگاریشده را پیادهسازی کنید که داده را حتی اگر رسانه ذخیرهسازی compromised شود، غیرقابل بازیابی کنند. فرآیندهای disposal را مستند کنید تا رعایت را در طول حسابرسیهای نظارتی نشان دهند و اطمینان حاصل کنند که الزامات حق پاکسازی برای GDPR و مقررات حفظ حریم خصوصی مشابه قابل برآورده شدن است.

ویژگیها و گزینههای کلیدی دستور pg_dump چیست؟

pg_dump یک پایگاه داده PostgreSQL را به یک فایل آرشیو واحد پشتیبانگیری میکند که از فرمتهای متعدد پشتیبانی میکند: SQL ساده، سفارشی، دایرکتوری یا tar. فرمت دایرکتوری از بازگردانی موازی پشتیبانی میکند و به طور پیشفرض فشرده میشود، که آن را برای عملیات پایگاه داده بزرگ بهینه میکند. از متغیرهای محیطی مانند PGHOST، PGPORT و PGUSER برای سادهسازی پیکربندی اتصال در سراسر عملیات متعدد استفاده کنید.

نسخههای اخیر PostgreSQL قابلیتهای pg_dump را به طور قابل توجهی بهبود بخشیدهاند. نسخه ۱۴ دامپ موازی را برای فرمت دایرکتوری با گزینه -j معرفی کرد، در حالی که نسخه ۱۵ فشردهسازی سمت سرور با الگوریتمهای Zstandard را اضافه کرد. نسخه ۱۶ قابلیتهای فیلترینگ را با –exclude-table-data بهبودیافته و گزینههای خاص schema گسترش داد، و PostgreSQL 17 پشتیبانی از پشتیبانگیری افزایشی و مدیریت خطای بهبودیافته برای عملیات مقیاس بزرگ را معرفی کرد.

دستور از کنترل دقیق از طریق گزینههای متعدد پشتیبانی میکند: –schema-only برای صادرات فقط ساختار، –data-only برای دامپهای فقط داده، –exclude-table برای حذف انتخابی، و –compress برای فشردهسازی خروجی. کاربران پیشرفته میتوانند از –serializable-deferrable برای snapshotهای سازگار در عملیات طولانی و –verbose برای نظارت پیشرفت دقیق در صادرات پایگاه داده بزرگ استفاده کنند.

چگونه داده را از دامپ PostgreSQL بازگردانی کنید؟

درک فرآیند

pg_restore فایلهای دامپ ایجادشده توسط pg_dump را میخواند و اشیاء پایگاه داده را با کنترل پیچیده بر فرآیند بازگردانی بازسازی میکند. آن منحصراً از فرمتهای سفارشی و دایرکتوری پشتیبانی میکند، قابلیتهای بازگردانی انتخابی، موازیسازی از طریق گزینه -j و مرتبسازی هوشمند شیء برای مدیریت خودکار وابستگیها را فراهم میکند.

فرآیند بازگردانی شامل چندین فاز است: ایجاد schema، بارگذاری داده، بازسازی ایندکس و اعتبارسنجی محدودیت. PostgreSQL 16+ این توالی را با اجازه ایجاد ایندکس موازی و اعتبارسنجی محدودیت به تعویقافتاده بهینه میکند، که زمان کل بازگردانی را برای پایگاههای داده بزرگ به طور قابل توجهی کاهش میدهد. درک این فازها به بهینهسازی استراتژیهای بازگردانی برای موارد استفاده خاص کمک میکند.

آمادهسازی برای بازگردانی

نام پایگاه داده صحیح، اعتبارنامههای کاربر و پارامترهای اتصال را با گزینههای خط فرمان یا متغیرهای محیطی مشخص کنید. از –exclude-table برای بازگردانی انتخابی، –schema-only برای Import فقط ساختار یا –data-only برای بازگردانی فقط داده استفاده کنید. پایگاه داده مقصد را با encoding، collation و تنظیمات پیکربندی اولیه مناسب پیشاز قبل ایجاد کنید تا سازگاری تضمین شود.

یکپارچگی دامپ را با pg_restore –list برای پیشنمایش محتویات بدون اجرای بازگردانی تأیید کنید. این بررسی مقدماتی مسائل بالقوه مانند نقشهای گمشده، افزونههای ناسازگار یا تعارضهای نسخه را که میتواند منجر به شکست بازگردانی شود، شناسایی میکند. تنظیمات work_mem و maintenance_work_mem مناسب را برای بهینهسازی عملکرد بازگردانی بر اساس منابع سیستم موجود پیکربندی کنید.

اهمیت پشتیبانگیریهای منطقی

ابزارهایی مانند pg_dump و pg_dumpall پشتیبانگیریهای منطقی ایجاد میکنند که تعاریف schema، محتوای داده و مجوزهای دسترسی را در فرمت مستقل از پلتفرم ضبط میکنند. این پشتیبانگیریها برای سناریوهای بازیابی نقطهدر-زمان، مهاجرتهای cross-platform و استخراج داده انتخابی که روشهای پشتیبانگیری فیزیکی نمیتوانند فراهم کنند، ضروری باقی میمانند.

پشتیبانگیریهای منطقی مزایای منحصربهفردی از جمله استقلال نسخه، قابلیتهای بازگردانی انتخابی و فرمت SQL قابل خواندن توسط انسان برای عیبیابی ارائه میدهند. با این حال، آنها سربار پردازشی بیشتری نسبت به پشتیبانگیریهای فیزیکی نیاز دارند و اطلاعات لاگ تراکنش را شامل نمیشوند، که آنها را مکمل به جای جایگزین برای استراتژیهای پشتیبانگیری جامع که شامل هر دو مؤلفه پشتیبانگیری منطقی و فیزیکی هستند، میسازد.

بهترین نکات برای Import Dump کارآمد چیست؟

از pg_restore با پردازش موازی (گزینه -j) برای دامپهای فرمت سفارشی و دایرکتوری استفاده کنید تا عملکرد بازگردانی بهینه را روی سیستمهای چندهستهای به دست آورید. دامپهای بسیار بزرگ را به بخشهای کوچکتر بر اساس schema، الگوهای جدول یا محدودههای تاریخ تقسیم کنید تا پردازش توزیعشده را امکانپذیر سازد و نیازهای حافظه را در طول بازگردانی کاهش دهد. حالت verbose (–verbose) را همراه با نظارت پیشرفت فعال کنید تا وضعیت بازگردانی را پیگیری کنید و گلوگاههای عملکرد را در عملیات طولانی شناسایی کنید. سازگاری encoding را با تنظیم PGCLIENTENCODING مناسب و تأیید تطابق تنظیمات locale پایگاه داده منبع/مقصد برای扱ش مجموعه کاراکتر تضمین کنید. اعتبارسنجی پیشاز بازگردانی را با گزینههای pg_restore –list و –dry-run برای شناسایی مسائل بالقوه قبل از تعهد به رویههای بازگردانی کامل پیادهسازی کنید. پیکربندی پایگاه داده مقصد را با افزایش موقت maintenance_work_mem، غیرفعال کردن autovacuum و تنظیم wal_buffers برای عملکرد Import بهبودیافته بهینه کنید. از pooling اتصال و پردازش batch برای حجمهای داده بزرگ استفاده کنید تا سربار اتصال را کاهش دهید و توان عملیاتی کلی را در طول عملیات بازگردانی بهبود بخشد. عملیات بازگردانی را در پنجرههای نگهداری زمانبندی کنید تا رقابت منابع را به حداقل برسانید و اطمینان حاصل کنید که منابع سیستم کافی برای عملکرد بهینه در دسترس است.

محدودیتهای اصلی رویکردهای pgAdmin و psql چیست؟

شدت منابع برای مجموعه دادههای بزرگ میتواند سیستمهای با حافظه یا ظرفیت پردازش محدود را تحت فشار قرار دهد، به ویژه در طول عملیات تکریسمانی روی پایگاههای داده بیش از چند صد گیگابایت. محدودیتهای ضبط داده نقطهدر-زمان به معنای آن است که دامپها تنها داده را در زمان صادرات نشان میدهند، که نیازمند استراتژیهای همگامسازی اضافی برای محیطهایی است که داده در طول فرآیندهای مهاجرت تغییر میکند. مسائل سازگاری نسخه و افزونه میتواند منجر به شکست Import شود زمانی که سیستمهای منبع و مقصد نسخههای PostgreSQL متفاوت، افزونههای گمشده یا تنظیمات پیکربندی ناسازگار دارند. قابلیتهای اتوماسیون محدود نیازمند مداخله دستی برای زمانبندی، نظارت و مدیریت خطا است، که این رویکردها را برای محیطهای تولیدی که نیازمند جریانهای کاری پشتیبانگیری و بازیابی خودکار هستند، کمتر مناسب میسازد. عدم همگامسازی افزایشی به معنای آن است که هر عملیات نیازمند انتقال کامل داده است، که سربار پهنای باند شبکه و ذخیرهسازی ایجاد میکند که برای پایگاههای داده بزرگ بهروزرسانیشده مکرر ممنوعه میشود. مدیریت وابستگی دستی نیازمند این است که مدیران ایجاد نقش، نصب افزونه و پیکربندی مجوز را جدا از فرآیند بازگردانی داده اصلی扱ش کنند. با وجود این محدودیتها، pgAdmin و psql ابزارهای ارزشمندی برای موارد استفاده خاص از جمله محیطهای توسعه، مهاجرتهای یکباره و سناریوهایی که نیازمند حداکثر کنترل بر فرآیند بازگردانی هستند، باقی میمانند. درک این محدودیتها به تعیین زمانی که رویکردهای جایگزین مانند Airbyte یا ابزارهای پشتیبانگیری تخصصی راهحلهای بهتری برای الزامات سازمانی فراهم میکنند، کمک میکند.

نتیجهگیری

با انتخاب روش مناسب—pgAdmin برای عملیات کاربرپسند، psql برای حداکثر کنترل و اتوماسیون، یا Airbyte برای همگامسازی مداوم—میتوانید PostgreSQL Import Dump را روان کنید در حالی که یکپارچگی داده را محافظت کرده و زمان توقف را در طول مهاجرتها یا عملیات بازیابی به حداقل برسانید. هر رویکرد مزایای متمایزی بسته به الزامات خاص شما برای عملکرد، اتوماسیون، امنیت و پیچیدگی عملیاتی ارائه میدهد.

سوالات متداول دامپ و بازگردانی PostgreSQL

کدام فرمت دامپ را باید استفاده کنم (plain، custom، directory، tar)؟

SQL ساده قابل خواندن توسط انسان و قابل حملترین است، اما بازگردانیها تکریسمانی هستند. Custom (-Fc) یک آرشیو فشرده است که از بازگردانی انتخابی و بازگردانی موازی با pg_restore -j پشتیبانی میکند. Directory (-Fd) دامپ را به فایلهای متعدد تقسیم میکند؛ از دامپ موازی با pg_dump -Fd -j N و بازگردانی موازی پشتیبانی میکند. Tar (-Ft) یک فایل واحد مشابه custom است اما بدون تمام ویژگیهای بازگردانی انتخابی.

آیا میتوانم به صورت موازی دامپ کنم؟

شما تنها میتوانید با فرمت دایرکتوری به صورت موازی دامپ کنید: pg_dump -Fd -j 8 -f /backups/mydb_dir mydb بازگردانیها از فرمتهای custom یا directory نیز میتوانند به صورت موازی اجرا شوند: pg_restore -d mydb -j 8 /backups/mydb_dir

چگونه بازگردانی بزرگ را سرعت ببخشم؟

ابتدا schema را بازگردانی کنید، سپس داده. از -j برای موازیسازی استفاده کنید. maintenance_work_mem را موقتاً بالاتر تنظیم کنید و autovacuum را پس از بازگردانی دوباره فعال کنید. تریگرها را در طول بارگذاری با pg_restore –disable-triggers غیرفعال کنید. عملیات را در صورت امکان با pg_restore –single-transaction در یک تراکنش بپیچید.

چگونه دامپها را مؤثر فشرده کنم؟

از فشردهسازی سمت سرور استفاده کنید: pg_dump -Fc -Z6 … برای سرعت و نسبت متعادل. با فرمت دایرکتوری، هر chunk جدول فشرده میشود؛ میتوانید -Z0..9 را تنظیم کنید.

چگونه تفاوتهای نسخه بین منبع و مقصد را شناسایی کنم؟

pg_dump forward-compatible است، پس pg_dump را از نسخه مقصد (جدیدتر) علیه منبع اجرا کنید در صورت امکان. از بازگردانی به نسخه عمده قدیمیتر اجتناب کنید. همیشه بررسی کنید که افزونهها و collationها در مقصد وجود دارند.