ابزارهای ETL (استخراج، تبدیل، بارگذاری) برای مدیریت دادههای سازمانی مدرن ضروری هستند. این ابزارها به شما امکان میدهند مجموعه دادههای بزرگ را به راحتی یکپارچه کنید و نیاز به مداخله دستی گسترده را به حداقل برسانید. با این حال، برای بهینهسازی کامل فرآیند ETL، مهم است که بهترین روش برای بارگذاری دادهها از منبع به مقصد تعیین شود.

اگر میخواهید همه چیز را از ابتدا دوباره بارگذاری کنید، تازهسازی کامل گزینه مناسبی است. تازهسازی افزایشی برای زمانی که فقط نیاز به تمرکز بر دادههای جدید یا بهروزرسانیشده دارید، مناسب است.

این مقاله توضیح میدهد که تازهسازی کامل و افزایشی چگونه کار میکنند، چه زمانی باید هر رویکرد را پیادهسازی کنید و در دنیای واقعی کجا استفاده میشوند.

تفاوتهای اصلی بین استراتژیهای تازهسازی داده چیست؟

استراتژی تازهسازی داده، دادههای موجود در سیستم هدف را با آخرین دادهها از منبع بهروزرسانی یا جایگزین میکند. دو استراتژی رایج عبارتند از تازهسازی کامل و تازهسازی افزایشی:

- تازهسازی کامل (Full Refresh): کل مجموعه داده را جایگزین میکند.

- تازهسازی افزایشی (Incremental Refresh): فقط رکوردهای جدید یا تغییر یافته را بهروزرسانی میکند.

انتخاب استراتژی مناسب بر عملکرد، هزینه و نتایج کیفیت داده تأثیر میگذارد و میتواند به بهینهسازی استقرارهای با حجم داده بالا کمک کند. درک تمایز بین بارگذاری فروشگاه داده عملیاتی (ODS) در مقابل الگوهای تازهسازی در هنگام معماری خط لولههای داده مدرن حیاتی است، زیرا هر کدام نیازهای تحلیلی و عملیاتی متفاوتی را برآورده میکنند.

تازهسازی کامل در پایپلاینهای داده مدرن چگونه کار میکند؟

تازهسازی کامل تمام دادههای موجود در سیستم هدف را با آخرین دادهها از منبع دوباره بارگذاری یا جایگزین میکند. از آنجا که جدول هدف معمولاً قبل از بارگذاری خالی میشود، این گاهی اوقات بارگذاری تخریبی نامیده میشود.

چه زمانی از تازهسازی کامل استفاده کنیم

- نیاز به دقت کامل داده: زمانی که هر رکورد باید دقیقاً با منبع مطابقت داشته باشد.

- حجم دادههای کوچک: زمان پردازش و استفاده از منابع را به حداقل میرساند.

- سیستمهای منبع ساده: وابستگیهای کم، پیچیدگی و ریسک را کاهش میدهد.

- بهروزرسانیهای نادر: بارگذاریهای مجدد قابل تحمل هستند زیرا به ندرت اتفاق میافتند.

مزایا

- سازگاری داده: ناسازگاریها بین منبع و هدف را حذف میکند.

- پیادهسازی ساده: نیازی به منطق ردیابی تغییرات پیچیده نیست.

- پیگیریهای حسابرسی قابل اعتماد: زمانبندیهای واضح هر بارگذاری کامل را مشخص میکنند.

- بازیابی خطا: هدف را به حالت شناختهشده و معتبر بازنشانی میکند.

معایب

- مصرف منابع بالا: CPU، حافظه و ذخیرهسازی بیشتری مصرف میکند.

- زمان پردازش طولانی: بهویژه برای مجموعه دادههای بزرگ.

- بار شبکهای افزایشیافته: انتقال دادههای بزرگ میتواند شبکه را شلوغ کند.

چه چیزی تازهسازی افزایشی را برای مجموعه دادههای بزرگ مؤثر میکند؟

تازهسازی افزایشی فقط رکوردهایی را بارگذاری میکند که از آخرین بارگذاری جدید هستند یا بهروزرسانی شدهاند و حجم دادههای پردازششده را به طور قابلتوجهی کاهش میدهد. اکثر پیادهسازیها به منطق مبتنی بر زمان یا ضبط تغییرات داده (CDC) برای شناسایی تغییرات وابسته هستند.

چه زمانی تازهسازی افزایشی را انتخاب کنیم

- حجم دادههای بزرگ: دادههای منتقلشده در هر اجرا را به حداقل میرساند.

- بهروزرسانیهای مکرر: از بارگذاریهای غیرضروری مجدد جلوگیری میکند.

- محدودیتهای منابع: نیازهای محاسباتی و ذخیرهسازی را کاهش میدهد.

- نیازهای زمان واقعی یا نزدیک به زمان واقعی: دادههای تازهتر را سریعتر ارائه میدهد.

مزایا

- پردازش سریعتر: فقط تغییرات (دلتا) مدیریت میشوند.

- هزینههای کمتر: کاهش محاسبات، ذخیرهسازی و پهنای باند.

- بار شبکهای کاهشیافته: بارهای کوچکتر، عملکرد بهتری دارند.

معایب

- پیادهسازی پیچیده: نیاز به تشخیص تغییرات قابل اعتماد دارد.

- ناسازگاریهای احتمالی: خطاها میتوانند بخشی از مجموعه داده را تحت تأثیر قرار دهند.

- نیاز به ردیابی تغییرات: نیاز به متاداده اضافی یا ابزارهای CDC.

- مدیریت خطای پیچیده: تشخیص مشکلات میتواند دشوارتر باشد.

| جنبه | تازهسازی کامل | تازهسازی افزایشی |

| دامنه داده | کل مجموعه داده | فقط دادههای جدید/تغییر یافته |

| سرعت | کندتر | سریعتر |

| پیچیدگی | ساده | پیچیدهتر |

| فرکانس بارگذاری | هفتگی / ماهانه | تا چندین بار در روز |

| مدیریت خطا | بارگذاری مجدد از ابتدا | سختتر برای انجام مجدد گام به گام |

| تکنیکها | بدون تکنیک خاص | زمانبندیها، CDC، SCD |

| سازگاری داده | بالا | وابسته به ردیابی تغییرات |

قطعه کد پایتون:

import pandas as pd

def extract_from_csv(path):

“””Extract data from a CSV file.”””

return pd.read_csv(path)

def transform(df):

“””Transform data by rounding price to 2 decimals.”””

df[“price”] = df[“price”].round(2)

return df

def load(target_file, df):

“””Load transformed data into a target CSV file.”””

df.to_csv(target_file, index=False)

پیادهسازی تازهسازی افزایشی

- تعریف اسکیمای جدول هدف: مشابه تازهسازی کامل.

- شناسایی دلتا: تشخیص دادههای تغییر یافته از طریق زمانبندیهای آخرین بهروزرسانی و جداول کنترلی که زمان استخراج موفق آخر را ذخیره میکنند.

- مدیریت نشانگر (Watermark): ذخیره آخرین زمانبندی یا شناسه پردازششده.

- مدیریت دادههای دیررسیده: تطبیق تغییرات خارج از ترتیب با CDC، کارهای تطبیق یا بررسیهای کیفیت داده.

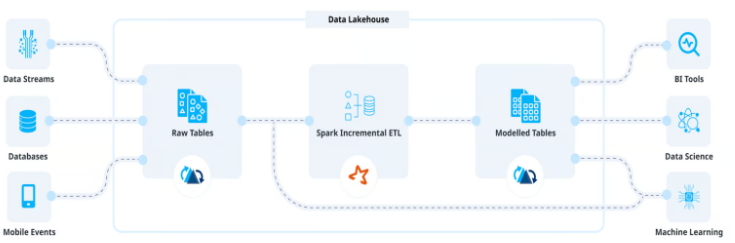

ضبط تغییرات داده (CDC) چه نقشی در استراتژیهای تازهسازی مدرن ایفا میکند؟

ضبط تغییرات داده (CDC) به عنوان یک فناوری اساسی برای فعالسازی استراتژیهای تازهسازی افزایشی پیچیده ظهور کرده است. CDC شناسایی تغییرات داده در زمان واقعی را با نظارت بر لاگهای تراکنش پایگاه داده امکانپذیر میکند و امکان ضبط درجها، بهروزرسانیها و حذفها را با حداقل تأثیر بر سیستمهای منبع فراهم میکند.

پیادهسازی CDC مبتنی بر لاگ

CDC مبتنی بر لاگ پیشرفتهترین رویکرد برای تشخیص تغییرات است. این روش لاگهای تراکنش پایگاه داده را تجزیه میکند تا تغییرات را بدون نیاز به تریگرها یا سربار پردازش اضافی در سیستمهای منبع شناسایی کند. پلتفرمهای مدرن مانند Apache Kafka با اتصالدهندههای Debezium به سازمانها امکان میدهند معماریهای مبتنی بر رویداد را بسازند که تغییرات داده به صورت جریانهای مداوم حرکت میکنند.

مزیت کلیدی CDC مبتنی بر لاگ در توانایی آن برای ضبط حذفها نهفته است، که رویکردهای افزایشی مبتنی بر زمانبندی اغلب آنها را از دست میدهند. وقتی رکوردی از سیستم منبع حذف میشود، CDC مبتنی بر لاگ میتواند این تغییر را به سیستمهای پاییندستی منتقل کند و سازگاری داده را در کل خط لوله حفظ کند.

الگوهای یکپارچگی CDC

پیادهسازی CDC نیازمند بررسی دقیق تکامل اسکیما و ترتیب پیامها است. پیادهسازیهای پیشرفته CDC از تکنیکهایی مانند ابعاد تغییر کند (SCD) برای حفظ زمینه تاریخی در حالی که نمای حالت فعلی را نگهداری میکنند، استفاده میکنند. الگوهای SCD نوع ۲، به عنوان مثال، با ایجاد رکوردهای جدید برای تغییرات به جای بازنویسی دادههای موجود، تاریخچه نسخه را حفظ میکنند.

پلتفرمهای یکپارچگی داده مدرن به طور فزایندهای از رویکردهای ترکیبی CDC پشتیبانی میکنند که جریانهای تغییرات زمان واقعی را با فرآیندهای تطبیق دورهای ترکیب میکنند. این الگو اطمینان میدهد که تغییرات از دست رفته یا قطعیهای سیستم، یکپارچگی داده را به خطر نمیاندازد در حالی که تازگی داده نزدیک به زمان واقعی را حفظ میکند.

ملاحظات فنی برای CDC

پیادهسازیهای CDC باید چندین چالش فنی را برطرف کنند، از جمله انحراف اسکیما، ترتیب پیامها و مدیریت تراکنشهای بزرگ. استقرارهای موفق معمولاً از صفهای نامه مرده (dead letter queues) برای مدیریت پیامهای ناموفق، رجیستریهای اسکیما برای مدیریت ساختارهای داده در حال تحول و پردازش idempotent برای مدیریت سناریوهای بازپخش پیام استفاده میکنند.

انتخاب بین CDC مبتنی بر تریگر و CDC مبتنی بر لاگ به عواملی از جمله محدودیتهای سیستم منبع، حجم داده و الزامات تأخیر بستگی دارد. در حالی که رویکردهای مبتنی بر تریگر پیادهسازی سادهتری ارائه میدهند، راهحلهای مبتنی بر لاگ عملکرد بهتری و تأثیر کمتری بر سیستم منبع برای محیطهای با حجم بالا فراهم میکنند.

چگونه استراتژیهای تازهسازی ترکیبی عملکرد و هزینه را بهینه میکنند؟

استراتژیهای تازهسازی ترکیبی قابلیت اطمینان تازهسازی کامل را با کارایی رویکردهای افزایشی ترکیب میکنند و راهحلهای بهینهای برای محیطهای داده پیچیده ایجاد میکنند. این استراتژیها تشخیص میدهند که انواع داده و الگوهای استفاده مختلف در یک سازمان ممکن است به رویکردهای تازهسازی متفاوتی نیاز داشته باشند.

الگوهای ذخیرهسازی و تازهسازی لایهای

پیادهسازیهای ترکیبی مدرن اغلب از معماریهای ذخیرهسازی لایهای استفاده میکنند که دادههای اخیر و پراستفاده بهروزرسانیهای افزایشی دریافت میکنند، در حالی که دادههای تاریخی تحت تازهسازیهای کامل دورهای قرار میگیرند. این رویکرد استفاده از منابع را با اعمال پردازش سنگین فقط در جایی که بیشترین ارزش را ارائه میدهد، بهینه میکند.

دادههای لایه داغ، که معمولاً ماههای اخیر را پوشش میدهد، بهروزرسانیهای افزایشی مکرر را برای پشتیبانی از تحلیلهای زمان واقعی و گزارشگیری عملیاتی دریافت میکند. دادههای لایه گرم، که دورههای زمانی میانی را پوشش میدهد، ممکن است بهروزرسانیهای افزایشی هفتگی دریافت کند تا تازگی را با مصرف منابع متعادل کند. دادههای لایه سرد، که اطلاعات تاریخی بلندمدت را نشان میدهند، تحت تازهسازیهای کامل ماهانه یا فصلی قرار میگیرند تا یکپارچگی داده را بدون استفاده بیش از حد از منابع تضمین کنند.

انتخاب دینامیک تازهسازی

استراتژیهای ترکیبی پیشرفته انتخاب تازهسازی هوشمند را بر اساس ویژگیهای داده و الگوهای استفاده پیادهسازی میکنند. مدلهای یادگیری ماشین میتوانند عواملی از جمله تغییرات حجم داده، الگوهای پرسوجو و نرخهای خطای تاریخی را تجزیه و تحلیل کنند تا استراتژیهای تازهسازی بهینه را برای مجموعه دادههای مختلف به طور خودکار تعیین کنند.

این سیستمها نرخ تغییرات داده را نظارت میکنند و به طور خودکار بین حالتهای تازهسازی کامل و افزایشی بر اساس آستانههای کارایی جابجا میشوند. هنگامی که پردازش افزایشی به دلیل حجم بالای تغییرات از تازهسازی کامل منابع بیشتری مصرف میکند، سیستم به طور خودکار برای آن مجموعه داده خاص به حالت تازهسازی کامل تغییر میکند.

چارچوبهای بهینهسازی منابع

رویکردهای ترکیبی در بهینهسازی هزینه با همراستا کردن فرکانس تازهسازی با ارزش تجاری برتری دارند. دادههای عملیاتی حیاتی بهروزرسانیهای افزایشی زمان واقعی دریافت میکنند، در حالی که مجموعه دادههای تحلیلی ممکن است از پردازش دستهای برنامهریزیشده در ساعات غیرپیک برای به حداقل رساندن هزینههای منابع استفاده کنند.

پیادهسازیهای بومی ابری از قابلیتهای مقیاسبندی خودکار برای تأمین منابع به صورت دینامیک بر اساس نیازهای تازهسازی استفاده میکنند. این رویکرد اطمینان میدهد که عملیات تازهسازی کامل منابع کافی دریافت میکنند بدون حفظ زیرساخت گرانقیمت برای پردازش افزایشی روتین.

پلتفرمهای مدرن زمانبندی آگاه از هزینه را پیادهسازی میکنند که عواملی از جمله مدلهای قیمتگذاری ارائهدهنده ابر، ردپای کربنی مرکز داده و دورههای حیاتی تجاری را هنگام بهینهسازی برنامههای تازهسازی در معماریهای ترکیبی در نظر میگیرند.

چگونه میتوانید از نمونههای پیادهسازی واقعی یاد بگیرید؟

- پردازش تراکنشهای مالی — اوبر

رانندگان اوبر ممکن است ساعتها پس از یک سفر انعام دریافت کنند و دادههای دیررسیده تولید کنند.

چالش: ETL سنتی نیاز به پردازش مجدد ماهها داده داشت.

راهحل: پردازش افزایشی Apache Hudi با Spark و Piper.

نتایج:

- کاهش ۵۰ درصدی زمان اجرای خط لوله

- بهبود ۶۰ درصدی در رعایت SLA

- حذف پردازش مداوم دادههای قدیمی

- پایپلاین تحلیل هفتگی — اسپاتیفای

هدف: بهروز نگه داشتن مجموعه داده فهرست پخش Discover Weekly.

استراتژی: تازهسازی کامل یک بار در هفته.

پشته: AWS Lambda، S3، Secrets Manager، Glue، Athena.

نتایج:

- تازهسازی هفتگی کاملاً خودکار

- دادهها همیشه در S3 برای تحلیل در دسترس هستند

- معماری بدون سرور هزینهها را پایین نگه میدارد

هنگام انتخاب استراتژی تازهسازی چه چیزی را باید در نظر بگیرید؟

استراتژیهای تازهسازی کامل و افزایشی برای انتقال دقیق دادهها از منبع به مقصد حیاتی هستند. تفاوت کلیدی در نحوه همگامسازی دادهها نهفته است: تازهسازی کامل همه چیز را دوباره بارگذاری میکند، در حالی که تازهسازی افزایشی فقط آنچه تغییر کرده است را بهروزرسانی میکند. انتخاب رویکرد مناسب برای بار کاری شما کارایی، هزینه و عملکرد را بهبود میبخشد.

پیادهسازیهای مدرن به طور فزایندهای رویکردهای ترکیبی را ترجیح میدهند که قابلیت اطمینان تازهسازی کامل را با کارایی استراتژیهای افزایشی ترکیب میکنند. هنگام طراحی استراتژی تازهسازی خود، عواملی از جمله حجم داده، فرکانس تغییرات، محدودیتهای منابع و الزامات تجاری را در نظر بگیرید.

پرسشهای متداول

چگونه حذفها را در سناریوهای تازهسازی افزایشی مدیریت کنم؟

حذفها چالش مهمی در تازهسازی افزایشی ایجاد میکنند، زیرا رویکردهای مبتنی بر زمانبندی استاندارد نمیتوانند رکوردهای حذفشده را تشخیص دهند. راهحلها شامل پیادهسازی حذفهای نرم با پرچمهای وضعیت، استفاده از ضبط تغییرات داده (CDC) برای نظارت بر لاگهای پایگاه داده برای عملیات DELETE یا ترکیب تازهسازی افزایشی با تطبیق کامل دورهای برای شناسایی حذفهای از دست رفته است.

اگر تازهسازی افزایشی در میانه راه شکست بخورد چه اتفاقی میافتد؟

تازهسازیهای افزایشی ناموفق نیازمند مدیریت خطای دقیق برای حفظ سازگاری داده هستند. بهترین روشها شامل پیادهسازی عملیات idempotent که میتوانند با خیال راحت از آخرین نقطه بررسی موفق دوباره شروع کنند، نگهداری لاگهای تراکنش برای فعال کردن قابلیت بازگرداندن، استفاده از جداول مرحلهبندی برای اعتبارسنجی داده قبل از تأیید تغییرات و پیادهسازی منطق retry خودکار با backoff نمایی برای خطاهای موقتی است.

چگونه میتوانم عملکرد تازهسازی را برای مجموعه دادههای بسیار بزرگ بهینه کنم؟

استراتژیهای بهینهسازی مجموعه دادههای بزرگ شامل پیادهسازی پردازش موازی با پارتیشنبندی داده در چندین کارگر، استفاده از فشردهسازی و فرمتهای داده کارآمد مانند Parquet، بهرهگیری از قابلیتهای مقیاسبندی خودکار بومی ابری، پیادهسازی استراتژیهای ذخیرهسازی لایهای که دادههای داغ و سرد را جدا میکنند و انتخاب برنامههای تازهسازی مناسب که نیازهای تازگی را با در دسترس بودن منابع متعادل میکنند.

چه زمانی باید از تازهسازی کامل به تازهسازی افزایشی تغییر کنم؟

به تغییر به تازهسازی افزایشی فکر کنید زمانی که زمانهای پردازش تازهسازی کامل از پنجرههای تجاری قابل قبول فراتر رود، هزینههای منابع نسبت به حجم تغییرات داده نامتناسب شود، به بهروزرسانیهای مکرر داده بیش از آنچه تازهسازی کامل اجازه میدهد نیاز داشته باشید یا محدودیتهای پهنای باند شبکه انتقال دادههای کامل را غیرعملی کند. به طور کلی، مجموعه دادههایی که از چندین گیگابایت فراتر میروند با نرخ تغییرات زیر ۲۰٪ از رویکردهای افزایشی بهره میبرند.

چگونه میتوانم کیفیت داده را با استراتژیهای تازهسازی افزایشی حفظ کنم؟

حفظ کیفیت داده در تازهسازی افزایشی نیازمند پیادهسازی بررسیهای اعتبارسنجی جامع، از جمله اعتبارسنجی اسکیما برای شناسایی تغییرات ساختاری، قوانین کیفیت داده برای شناسایی مقادیر غیرعادی، فرآیندهای تطبیق که به طور دورهای تعداد منبع و هدف را مقایسه میکنند، ردیابی خط داده برای درک انتشار تغییرات و سیستمهای نظارتی که در مورد الگوهای داده غیرعادی یا خطاهای پردازش هشدار میدهند.