نکات کلیدی

- پردازش اسناد در کاربردهای سازمانی حیاتی است. اگر دادهها درست استخراج نشوند، نتیجهاش تأخیرهای عملیاتی، افزایش چرخههای اصلاح دستی و بالا رفتن ریسک بهخاطر عدم انطباق با مقررات است.

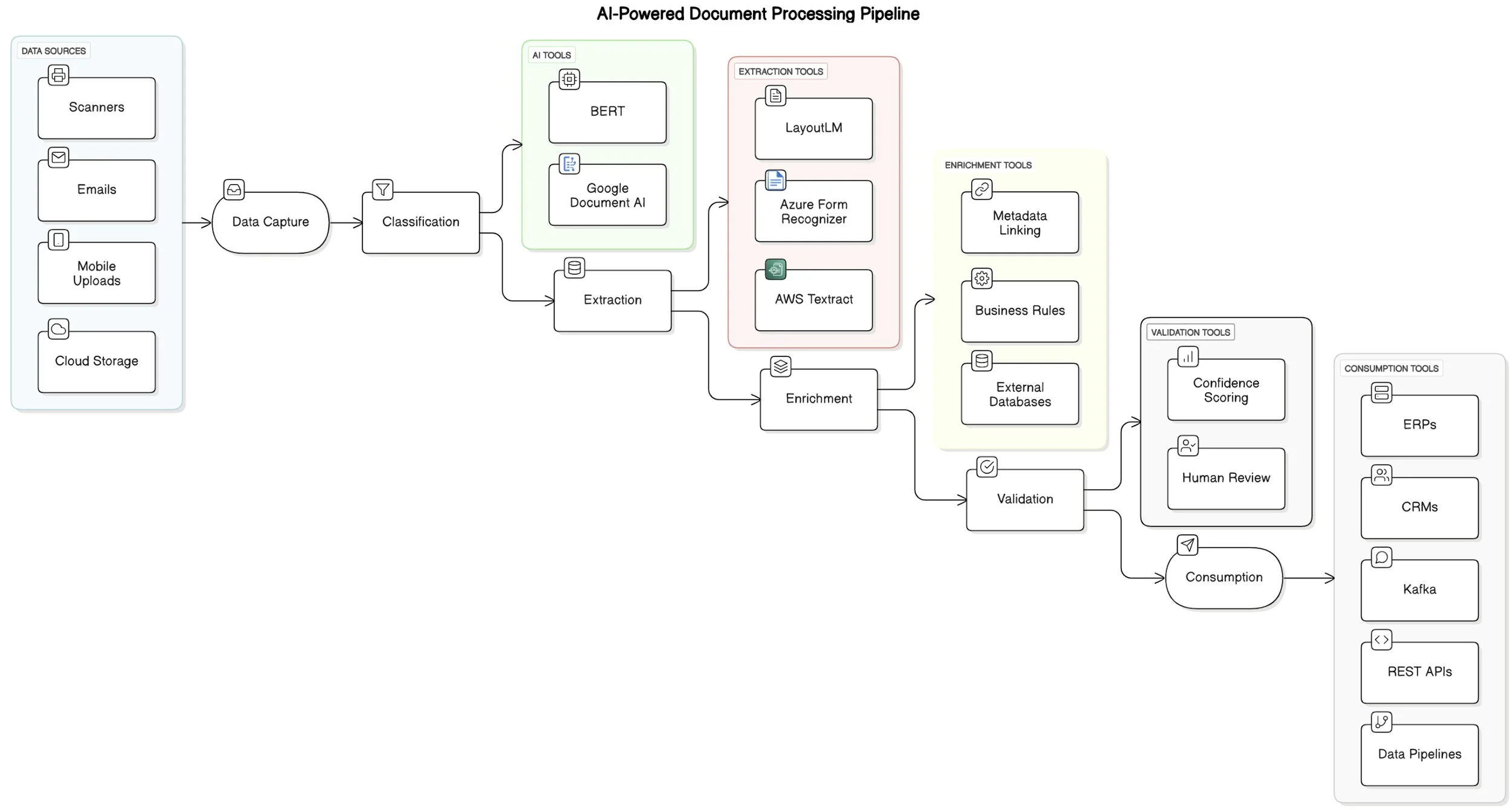

- سیستمهای مدرن «هوشمندی سند» به معماری پایپلاین (pipeline) ماژولار تکیه دارند که معمولاً شامل مراحل دریافت داده، طبقهبندی، استخراج، غنیسازی، اعتبارسنجی و مصرف (ورود به سیستمهای مقصد) است.

- فروشندگان ابری و ابزارهای متنباز طیفی از سرویسهای Document AI ارائه میدهند، از جمله Google Document AI، Azure Form Recognizer، AWS Textract و LayoutLM.

- اسناد غیرساختیافته مثل قراردادها، یادداشتهای حقوقی یا خلاصههای بالینی را میتوان با NLP و مدلهای زبانی از پیشآموزشدیده که برای دامنههای خاص (مثل حقوقی، سلامت) فاینتیون میشوند تحلیل کرد.

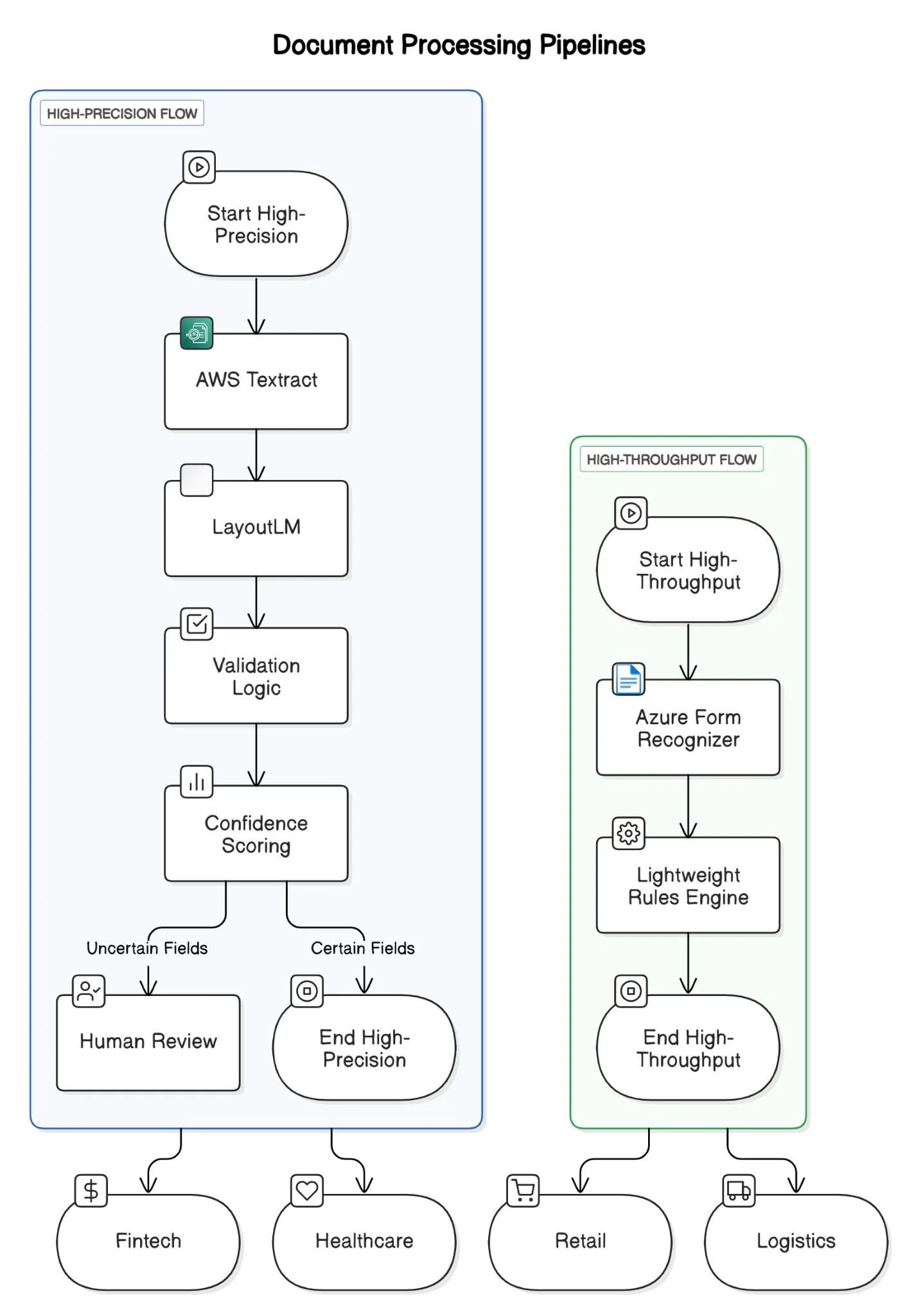

- بیشتر پایپلاین های واقعی پردازش سند از یک راهبرد «هیبریدی» سود میبرند؛ ترکیبی از سرعت و سادگی APIهای از پیشآموزشدیده با دقت و کنترل مدلهای سفارشی.

تکامل پردازش اسناد

تشخیص کاراکتر نوری (OCR) سالها ستون فقرات دیجیتالیسازی اسناد بوده است. اما نسخههای سنتی OCR با دنیای امروزِ اسناد پیچیده و متنوع، مشکل دارند. در سازمانها سندها هزار شکل دارند: قراردادهای اسکنشده، عکسها، ایمیلهایی با جدولهای داخل متن، و حتی یادداشتهای دستنویس. سیستمهایی که فقط بر تشخیص الگو و قالبهای ثابت متکیاند، با کوچکترین تفاوت از حالت ایدهآل خارج میشوند. شکنندگیشان باعث میشود وقتی ورودی کمی با انتظار فرق دارد، عملکرد سقوط کند.

این تغییر به چند نیرو وابسته است. اول، رشد نمایی انواع اسناد غیرساختیافته. کسبوکارها با همهچیز طرفاند: از ایمیلهای آزاد تا صورتحسابهای شدیداً قالببندیشده، و سیستمهای قدیمی سریع سازگار نمیشوند. دوم، فشار برای خودکارسازی گردشکارهای حجیم یعنی دخالت دستی باید حداقل شود. سوم، سرعت عملیات مدرن، دسترسی تقریباً فوری به داده ساختیافته را از دل سند میخواهد.

وقتی سیستمهای قدیمی کم میآورند، اثر دومینویی راه میافتد. استخراج نادرست داده یعنی تأخیر عملیاتی، افزایش اصلاحات دستی، و بالا رفتن ریسک بهخاطر عدم رعایت مقررات. این چالشها یک رویکرد هوشمندتر و سازگارتر میخواهد: پردازش سندی که سند را در متن و زمینه بفهمد، نه فقط از روی شکل ظاهری.

یک نمونه واقعی: بهبود گردشکار درخواست وام مسکن

یک شرکت وامدهی مسکن که روزانه هزاران درخواست وام را پردازش میکند، مثال خوبی برای درک موضوع است. درخواست وام به مجموعهای متنوع از اسناد نیاز دارد: فیش حقوقی، اظهارنامه مالیاتی، مدارک هویتی، صورتحساب بانکی، نامه اشتغال و غیره.

این سندها با فرمتهای مختلف میآیند: اسکنشده، عکسگرفتهشده، یا دانلودشده از پورتالهای مختلف. خیلیهایشان بدقالباند یا دستنویس دارند، و همین پردازش با روشهای معمول را سخت میکند.

چالش کسبوکار واضح است: بررسی دستی زمان و منابع میبلعد. هر پرونده ممکن است یک تا دو روز در مرحله راستیآزمایی بماند، مخصوصاً وقتی تیم باید درآمد را تطبیق بدهد، امضاها را مقایسه کند، یا موجودی حساب را اعتبارسنجی کند. با انتظار مشتری برای تأیید سریعتر و مقررات سختگیرانه، این تأخیر تبدیل به گلوگاه جدی میشود.

سیستمهای قدیمی مبتنی بر OCR کمک میکنند، ولی وقتی سند حتی کمی از چیدمان مورد انتظار منحرف شود، از هم میپاشند. یک تغییر کوچک در فرم یا یک اسکن تار میتواند دخالت کامل انسان را لازم کند، ساعتها به فرایند اضافه کند و احتمال خطا را بالا ببرد.

اینجاست که یک پایپلاین مدرن هوشمندی سند به کار میآید. با شکستن گردشکار به مراحل ماژولار، وامدهندهها میتوانند سندها را سریعتر و دقیقتر پردازش کنند.

پایپلاین ششمرحلهای پردازش سند

سیستمهای مدرن هوشمندی سند روی معماری ماژولار تکیه دارند؛ هر مرحله یک مسئولیت مشخص دارد. این طراحی هم مقاوم است هم انعطافپذیر، چون تیمها میتوانند با تغییر فناوری یا نیاز کسبوکار، فقط یک مرحله را ارتقا بدهند.

این مراحل عبارتاند از:

- Data Capture (دریافت داده): دریافت اسناد از منابع مختلف مثل آپلود اسکن، پیوست ایمیل، اپ موبایل و باکتهای ذخیرهسازی ابری. سرویسهایی مثل AWS S3 triggers یا Google Cloud Functions معمولاً نقطه ورود هستند.

- Classification (طبقهبندی): تعیین نوع سند: صورتحساب بانکی، پرونده پزشکی، فاکتور، فرم مالیاتی و غیره. میشود از طبقهبندهای از پیشآموزشدیده مبتنی بر ترنسفورمر (مثل BERT، RoBERTa) یا ابزارهای ابری مثل Google Document AI استفاده کرد.

- Extraction (استخراج): استخراج کلید-مقدارها، جدولها یا پاراگرافها. مدلهای آگاه به چیدمان مثل LayoutLM یا سرویسهایی مثل AWS Textract و Azure Form Recognizer اینجا رایجاند.

- Enrichment (غنیسازی): افزودن زمینه به خروجی خام با اتصال اصطلاحات به آنتولوژیها، اعمال قوانین کسبوکار یا پرسوجو از گرافهای دانش بیرونی.

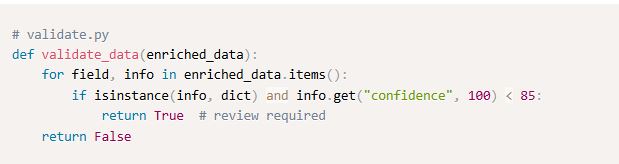

- Validation (اعتبارسنجی): سنجش کیفیت استخراج با امتیاز اطمینان (confidence) یا اعتبارسنجهای قاعدهمحور. موارد مبهم در صورت نیاز به بازبین انسانی ارجاع میشوند.

- Consumption (مصرف): ارسال خروجی ساختیافته به سیستمهای پاییندستی مثل ERP، CRM یا داشبوردهای تحلیلی از طریق API یا message queue.

مدلهای از پیشآموزشدیده: مناسبِ کار، اما نه جادویی

با اینکه فروشندگان ابری و ابزارهای متنباز سرویسهای متنوعی دارند، «یک مدل برای همه» وجود ندارد. هر گزینهای در شفافیت، امکان تنظیم، هزینه و عملکرد تریدآف دارد.

در صنعت وام مسکن، تیمها معمولاً از Textract برای استخراج اطلاعات از اسناد استاندارد مثل فیش حقوقی و صورتحساب بانکی استفاده میکنند. وقتی چیدمان تمیز و قابل پیشبینی باشد خوب جواب میدهد. اما وقتی قالببندی سخت شود، خروجیها میتواند ناسازگار یا بیشازحد جزئی شود و بهجای شفافیت، نویز تولید کند.

LayoutLM در مقابل برای ورودیهای نامنظمتر مثل فرمهای دستنویس W2 یا سندهای با چیدمان ترکیبی بهتر عمل میکند. Google Document AI درک چیدمان قوی و ادغام NLP خوبی دارد اما سفارشیسازی عمیق ندارد. Azure Form Recognizer گزینه میانی است: امکان آموزش سفارشی دارد اما به نمونههای برچسبخورده نیاز پیدا میکند. در متنبازها، LayoutLM برای ترکیب چیدمان فضایی و زبان بسیار قدرتمند است ولی GPU و مهارت مهندسی میخواهد. گزینههای سبکتر مثل Tesseract و OpenCV هنوز برای اسکنهای تمیز و کمپیچیدگی کاربرد دارند.

انتخاب ترکیبی از مدلها (ensembling) اغلب بهترین راه است. در دامنههای حساس مثل مالی یا سلامت، دقت حیاتی است؛ اینجا ممکن است LayoutLM و Textract را کنار هم بگذارید و خروجیها را با قوانین یا بازبین انسانی کراسولیدیت کنید. در مقابل، برای رسیدهای خردهفروشی که سرعت مهمتر از دقت مطلق است، Azure Form Recognizer با fallbackهای ابتکاری ممکن است کافی باشد.

رمزگشایی سرنخهای بصری در سند

بسیاری از سندها علاوه بر متن، نشانههای بصری دارند: چکباکس، جدول، امضا، مهر و لوگو. OCR سنتی معمولاً اینها را نادیده میگیرد یا اشتباه میخواند.

روشهای بینایی ماشین این شکاف را پر میکنند. مدلهای تشخیص شیء مثل YOLO و Faster R-CNN میتوانند مواردی مثل چکباکس یا لوگو را پیدا کنند. تکنیکهای segmentation به تجزیه جدولها و چیدمانهای ساختیافته کمک میکنند. OpenCV در پیشپردازش مثل حذف نویز، تصحیح کجی و افزایش کنتراست مفید است. LayoutLM هم با positional encoding در کنار مدل زبانی، زمینه سند را حفظ میکند.

ترکیب این ابزارها باعث میشود سیستم فقط «کلمات» را نخواند، بلکه «نحوه ارائه» را هم بفهمد و بداند چرا مهم است.

کار با اسناد غیرساختیافته

اسناد غیرساختیافته مثل قراردادها، یادداشتهای حقوقی یا خلاصههای بالینی فیلدهای مشخص ندارند. برای استخراج معنی باید زمینه را فهمید.

اینجا NLP نقش اصلی را بازی میکند. مدلهای زبانی از پیشآموزشدیده که برای دامنههای خاص فاینتیون میشوند میتوانند موجودیتهایی مثل اسم، تاریخ، دارو یا تعهدات را تشخیص دهند. sentence embeddingها کمک میکنند بخشهای مشابه از نظر معنا گروهبندی شوند. رویکردهای هیبریدی که نشانههای زبانی را با ویژگیهای چیدمان ترکیب میکنند، معمولاً بهترین نتیجه را میدهند.

این تکنیکها در بخشهای قانونمحور بسیار ارزشمندند، چون تغییرات ظریف در زمینه یا جملهبندی میتواند معنی سند را کاملاً عوض کند.

سرویسهای ابری: هوشمندانه انتخاب کنید

پردازش سند در مقیاس بزرگ با سرویسهای ابری آسانتر شده است: APIهای آماده برای OCR، طبقهبندی، استخراج موجودیت و حتی خلاصهسازی. سرعت نتیجه بالاست، ولی هیچ دو پلتفرمی دقیقاً یکسان نیستند. هر فروشنده روی نقطه قوت خودش تمرکز دارد، و انتخاب درست تعیین میکند سیستم production-grade شما موفق میشود یا نه.

در ادامه مقایسه سه ارائهدهنده اصلی:

AWS Textract

Textract برای سازمانهایی که در اکوسیستم AWS هستند محبوب است و در استخراج فرمها و جدولها قوی است:

-

تشخیص خودکار کلید-مقدار، جدول و چکباکس

-

ادغام طبیعی با AWS Lambda، S3، Comprehend و Step Functions

-

آگاهی چیدمان متوسط، مخصوصاً برای فرمها

اما خروجیها ممکن است طولانی و تکراری شوند و روی سندهای پیچیده یا کیفیت پایین، عملکرد نوسانی باشد. هزینه هم با حجم بالا سریع رشد میکند، مخصوصاً با AnalyzeDocument که برای جدول/فرم هزینه جدا میگیرد.

بهترین برای: گردشکارهای فرممحور مثل فاکتور، رسید، درخواست وام یا W-2 در مالی/منابع انسانی.

Google Document AI

تمرکز گوگل روی پردازندههای از پیشآموزشدیده برای انواع سند (فاکتور، مدارک هویتی، W9 و غیره) و ادغام با NLP است:

-

پارس معنایی قوی و درک زمینه زبان

-

مناسب برای سندهای نیمهساختیافته و غیرساختیافته

-

OCR دقیق، مخصوصاً چندزبانه و دستنویس

اما شفافیت و سفارشیسازی محدود است و برای سازمانهایی که کنترل دقیق میخواهند جذابیت کمتری دارد. وقتی نوع سند شناختهشده و پشتیبانیشده باشد عالی است، اما برای فرمتهای جدید انعطاف پایینتر میشود.

بهترین برای: سازمانهایی که intelligence آماده برای سندهای رایج میخواهند، بهخصوص در لجستیک، سفر و خدمات مشتری.

Azure AI Document Intelligence

(قبلاً Form Recognizer) نقطه قوتش آموزش سفارشی است:

-

امکان آموزش با داده برچسبخورده و بدون برچسب (unsupervised)

-

پشتیبانی از فیلدهای فرم، جدولها و selection marks

-

طبقهبندی سند، APIهای layout و نسخهبندی مدل

مدیریت چرخه عمر مدل در Azure قویتر است و برای تیمهای DevOps که MLOps میسازند مناسب است. اما آمادهسازی داده قابل توجه لازم دارد و به تغییرات قالب حساس است.

بهترین برای: سازمانهایی که بین انعطاف و راحتی دنبال تعادلاند، مثل سلامت، بیمه و حوزههای سنگین از نظر انطباق.

چه زمانی و چرا رویکرد هیبریدی؟

وابستگی کامل به یک ارائهدهنده ابری نقطه کور میسازد. بیشتر پایپلاینهای واقعی از راهبرد هیبریدی سود میبرند: سرعت APIهای آماده + کنترل و دقت مدلهای سفارشی.

مثلاً وامدهندههای مسکن ممکن است Textract را با مدلهای آموزشدیده سفارشی و بازبینی انسانی برای سناریوهای پرریسک (مثل راستیآزمایی درآمد افراد خوداشتغال) ترکیب کنند. این لایهبندی هم دقت را بالا میبرد هم ریسک انطباق را مدیریت میکند.

مثال ترکیب:

-

AWS Textract یا Azure Form Recognizer برای استخراج فیلدهای ساختیافته از فرمهای استاندارد

-

LayoutLM برای سندهایی که چیدمان دقیق یا معناشناسی دامنهمحور میخواهند

-

لایه اعتبارسنجی با امتیاز اطمینان و ارجاع موارد نامطمئن به بازبین انسانی یا مدل سفارشی

-

Google Document AI برای طبقهبندی معنایی، خلاصهسازی یا لینکدادن موجودیتها در سندهای طولانی

-

ابزارهای orchestration مثل Apache Airflow، Kubernetes یا Azure Logic Apps برای یکپارچهسازی و مقیاسپذیری

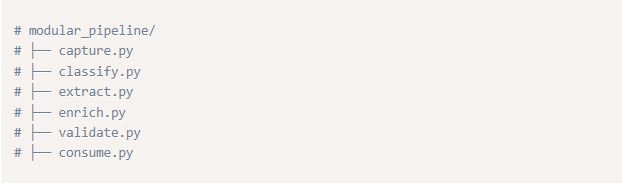

نگاشت کد به پایپلاین هوشمندی سند

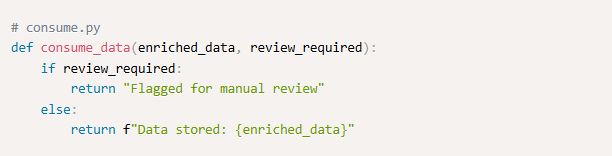

اپلیکیشن نمونه، مراحل کلیدی خط لوله ششمرحلهایِ مطرحشده در شکل ۱ را نشان میدهد:

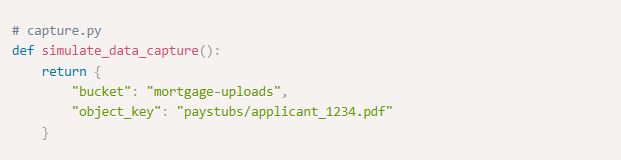

مرحله ۱: دریافت داده (Data Capture) – شبیهسازی تریگر آپلود در S3

مرحله ۲: طبقهبندی (Classification) – دستهبندی ساده بر اساس مسیر فایل

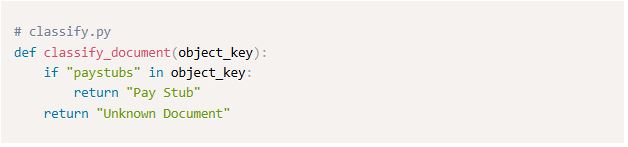

مرحله ۳: استخراج (Extraction) – خروجی شبیهسازیشده Textract

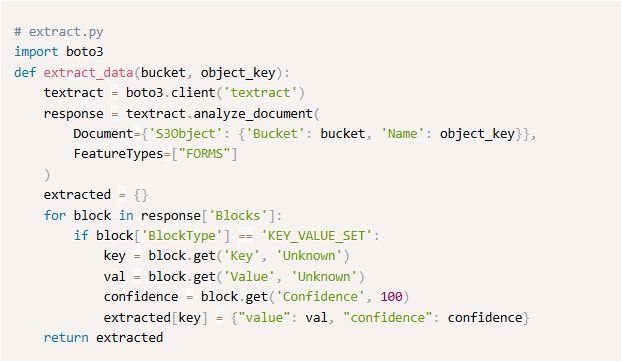

مرحله ۴: غنیسازی (Enrichment) – منطق مبتنی بر قواعد (مثلاً استنباط دوره پرداخت حقوق)

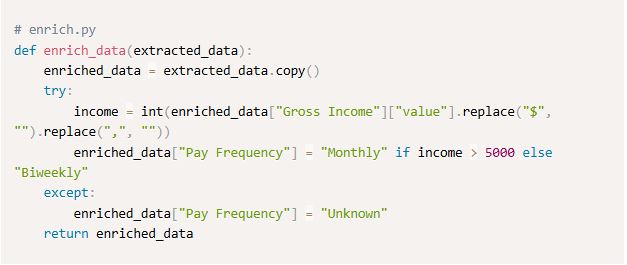

مرحله ۵: اعتبارسنجی (Validation) – امتیازدهی سطح اطمینان برای علامتگذاری جهت بازبینی

مرحله ۶: مصرف (Consumption) – یکپارچهسازی با سیستمهای پاییندستی یا تصمیم برای بازبینی دستی

مقیاسدهی معماری در دنیای واقعی

مقیاسپذیری یک گزینه لوکس نیست؛ ضرورت است. سیستم باید بارهای دستهای، ارسالهای لحظهای و همه چیز بین این دو را مدیریت کند.

مثلاً در وام مسکن، با تغییر نرخ بهره یا اعلام سیاستها، ناگهان موج درخواست میآید. اینجا معماری میکروسرویس و صفهایی مثل Kafka کمک میکنند بار جذب شود و throughput روان بماند.

یک معماری robust معمولاً اینها را دارد:

-

میکروسرویسهایی که هر مرحله پایپلاین را جدا میکنند

-

صفهای Kafka یا Pub/Sub برای ارتباط جداشده (decoupled)

-

Kubernetes برای orchestration کانتینرها و مقیاسدهی

-

Redis برای cache کردن lookupهای پرتکرار یا نتایج استنتاج

-

ذخیرهسازی object و relational برای فایلهای خام و خروجیهای ساختیافته

چالشهایی که واقعاً با آنها روبهرو میشوید

پیادهسازی در محیط واقعی چند مشکل سخت را رو میکند:

-

Security: رمزنگاری سند در مسیر انتقال و در حالت ذخیره، مخصوصاً برای PII

-

Data labeling: داده آموزشی دامنهمحور گران و زمانبر است

-

Operational cost: استنتاج OCR و NLP میتواند محاسبات سنگین داشته باشد

-

Quality assurance: ارزیابی را در سطح فیلد انجام دهید، نه فقط قبولی/رد کلی

-

Human-in-the-loop: برای استخراجهای پرریسک یا خطاپذیر هنوز حیاتی است

مطالعات موردی جاافتاده در صنعت

پلتفرم COiN (Contract Intelligence) در J.P. Morgan با هوش مصنوعی بررسی قراردادهای حقوقی پیچیده را سریع کرد و کاری معادل ۳۶۰,۰۰۰ ساعت کاری سالانه را در چند ثانیه انجام داد. مدیریت قراردادها بهخاطر این نوآوری هم سریعتر شد هم دقیقتر.

Pennymac زمان پردازش اسناد را از چند ساعت به چند دقیقه کاهش داد.

قدم بعدی در هوشمندی سند چیست؟

هوشمندی سند دارد از «صرفاً استخراج فیلد» عبور میکند و وارد عصر «فهم معنایی و یادگیری پیوسته» میشود. فناوریهای نو، سیستمها را قادر میکنند فقط سند را نخوانند، بلکه ساختار، نیت و ارتباطش را در یک زمینه مشخص بفهمند. چهار محور اصلی آینده:

مدلهای چندوجهی (Multimodal) برای فهم عمیقتر

نسل بعدی Document AI سه ورودی را با هم ترکیب میکند:

-

Text (معنا)

-

Layout (روابط فضایی)

-

Visual features (تصاویر، چکباکس، لوگو، مهر)

مدلهایی مثل LayoutLMv3 و DocFormer این حوزه را جلو میبرند و دقت را در سندهای پیچیده بالا میبرند. مثلاً فهمیدن اینکه یک چکباکس تیک خورده یا نه، یا اینکه امضا چطور به متن «لنگر» داده، فقط با متن ممکن نیست.

استدلال زمینهای و خلاصهسازی خودکار

صرف استخراج داده کافی نیست. سازمانها سیستمهایی میخواهند که روی محتوا استدلال کنند و بینش بدهند:

-

خلاصهسازی خودکار برای تبدیل سند طولانی به خلاصه تصمیمپذیر

-

درک زمینه با استفاده از متن اطراف، آنتولوژیهای دامنهمحور و الگوهای تاریخی

ارکستریشن هوشمند بر اساس اطمینان و ریسک

سیستمهای آینده مسیر پردازش را بر اساس confidence و ریسک خطا تنظیم میکنند:

-

وام مسکن: مقادیر نامطمئن یا ناسازگار به کارشناس ارجاع شود

-

خردهفروشی: برای تراکنش کمارزش، نتایج کماطمینان هم پذیرفته شود

یادگیری پیوسته Human-in-the-loop

مدلهای ثابت با تغییر قالب سند و مقررات افت میکنند. آینده مربوط به حلقههای بازخورد انسان-ماشین است:

-

ثبت اصلاحات بازبین انسانی

-

لاگ کردن edge caseها

-

استفاده از weak supervision یا RL برای بهبود

خلاصه اینکه هدف «جایگزینی انسان» نیست. هدف «تقویت انسان» است با سیستمهایی که زمینهفهم، خودبهبود و هوشمند طراحی شدهاند.

اجرای این رویکرد در سازمان شما

-

هر نوع سند کلیدی را روی پایپلاین ششمرحلهای map کنید.

-

ابزارهای ابری و متنباز را بر اساس دقت، هزینه و انطباق انتخاب کنید.

-

حلقه بازخورد برای بهبود مستمر مدل بسازید.

-

روتینگ هوشمند بر اساس آستانه اطمینان و ریسک کسبوکار را جدی بگیرید.

-

از اول روی observability، caching و orchestration برای مقیاس production سرمایهگذاری کنید.