امنیت و ریسکها در صنایع بهشدت قانونگذاریشده (Security and Risks in Highly Regulated Industries)

نکات کلیدی

- سازمانها باید توسعهٔ چارچوبهای هوش مصنوعی مسئولانه را در اولویت قرار دهند که با ارزشهای محوری همراستا باشد و انصاف، شفافیت و رویههای اخلاقی در استقرار هوش مصنوعی را تضمین کند.

- کسبوکارها باید در یک چشمانداز مقرراتی در حال تحول حرکت کنند، از جمله قوانینی مانند GDPR و قانون هوش مصنوعی اتحادیهٔ اروپا (EU AI Act)، تا از انطباق با الزامات حریم خصوصی داده و شفافیت هوش مصنوعی اطمینان حاصل کنند.

- رویههای MLOps مدیریت امن، مقیاسپذیر و کارآمد مدلهای یادگیری ماشین را در سراسر چرخهٔ عمرشان تضمین میکند و بر اعتبارسنجی داده، پایش مدل و همکاری میانوظیفهای تمرکز دارد.

- سامانههای هوش مصنوعی، بهویژه آنهایی که در محیطهای امنیتحیاتی بهکار میروند، در معرض ریسکهایی مانند سوگیری، توهم (hallucinations) و مسمومسازی داده (data poisoning) هستند. آزمونگری جامع و اقدامات امنیتی robust برای کاهش این ریسکها ضروری است.

- با پیادهسازی تکنیکهای هوش مصنوعی توضیحپذیر (XAI)، سازمانها میتوانند شفافیت را بهبود دهند، به رعایت الزامات مقرراتی کمک کنند و با روشنکردن اینکه مدلهای هوش مصنوعی چگونه تصمیم میگیرند، اعتماد ایجاد کنند.

این مقاله مفاهیم ضروری هوش مصنوعی مسئولانه و اهمیت روبهرشد آن را در صنایع مختلف برجسته میکند و بر امنیت، عملیات یادگیری ماشین (Machine Learning Operations یا MLOps) و پیامدهای آیندهٔ فناوریهای هوش مصنوعی تمرکز دارد. با ادغام هوش مصنوعی توسط سازمانها، آنها باید بر امنیت، شفافیت، دغدغههای اخلاقی و انطباق با مقررات نوظهور تمرکز کنند. این خلاصه بازتاب ارائهٔ ما در QCon London 2024 است.

هوش مصنوعی مولد و تحول صنایع

هوش مصنوعی مولد (Generative AI یا GenAI) با تقویت نوآوری و بهرهوری در حال متحولکردن صنایع است. در علم، NVIDIA از هوش مصنوعی برای پیشبینی Hurricane Lee استفاده کرد، Isomorphic Labs آن را برای پیشبینی ساختارهای پروتئینی بهکار گرفت، و Insilico نخستین داروی طراحیشده با هوش مصنوعی را توسعه داد که اکنون در کارآزماییهای FDA قرار دارد.

در مهندسی، PhysicsX از هوش مصنوعی برای طراحی صنعتی و بهینهسازی استفاده میکند. در کسبوکار، Allen & Overy, LLP، ChatGPT 4 را در گردشکارهای حقوقی ادغام کرد و کارایی پیشنویس قرارداد را بهبود داد. ابزار هوش مصنوعی McKinsey & Company با نام Lilli، آمادهسازی برای جلسات مشتری را ۲۰% سریعتر میکند، در حالی که Bain & Company دریافت که تقریباً نیمی از شرکتهای M&A از هوش مصنوعی برای فرایندهای معاملهسازی استفاده میکنند. این نمونهها نشان میدهند که هوش مصنوعی چگونه خلاقیت، دقت و سرعت را در حوزههای مختلف پیش میبرد.

صنایع بهشدت قانونگذاریشده و دادههای حساس

صنایعی مانند مالی، سلامت، داروسازی، دفاع، دولت و خدمات عمومی (utilities) برای تضمین ایمنی و حفاظت مصرفکننده بهشدت قانونگذاری شدهاند. این صنایع دادههای حساس را مدیریت میکنند، مانند اطلاعات شخصی، سوابق مالی و دادههای پزشکی، که باید مطابق قوانینی مثل HIPAA امن نگه داشته شوند.

سازمانها باید این دادهها را از طریق تکنیکهایی مانند مبهمسازی (obfuscation)، ذخیرهسازی امن و طبقهبندی ریسک چندسطحی محافظت کنند. حفظ امنیت دادهٔ robust بهویژه هنگام استفاده از این اطلاعات برای آموزش مدلهای یادگیری ماشین اهمیت زیادی دارد.

چشمانداز قانونگذاری هوش مصنوعی

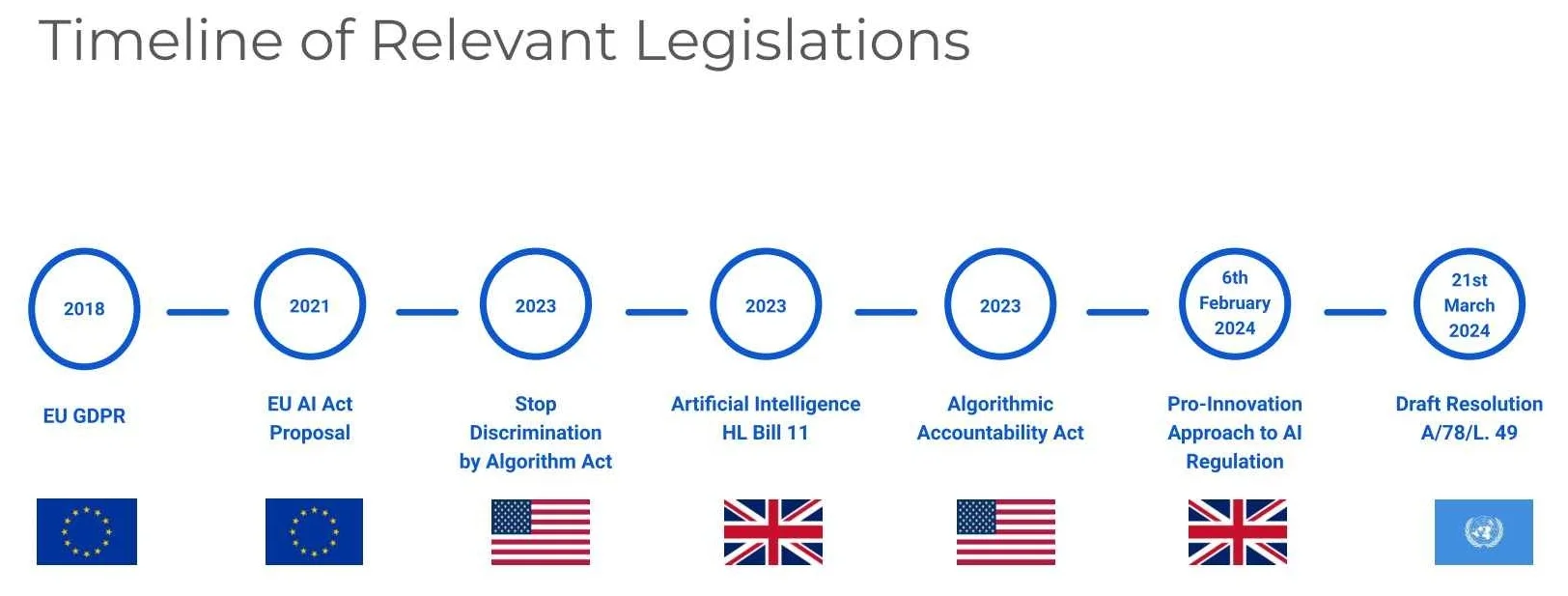

چشمانداز مقرراتی برای هوش مصنوعی و حکمرانی داده در سالهای اخیر توسعه یافته است و از معرفی مقررات عمومی حفاظت از داده (General Data Protection Regulation یا GDPR) در ۲۰۱۶-۲۰۱۷ آغاز شد. GDPR تمرکز زیادی بر حریم خصوصی داده و پاسخگویی دارد، بهویژه برای کسبوکارهایی که دادهٔ شخصی را مدیریت میکنند. نمونهٔ مهم دیگر، قانون هوش مصنوعی اتحادیهٔ اروپا (EU AI Act) است که سامانههای هوش مصنوعی را بر اساس سطح ریسک دستهبندی میکند و از توسعهدهندگان هوش مصنوعی شفافیت میطلبد.

در ۲۰۲۳، ایالات متحده قانونگذاری فدرال مانند Algorithmic Accountability Act را معرفی کرد که برای ترویج شفافیت و پاسخگویی در سامانههای هوش مصنوعی در سراسر کشور طراحی شده است. رویکرد بریتانیا کمی متفاوت است. این رویکرد بر انصاف، توضیحپذیری و مسئولیتپذیری تأکید میکند تا نوآوری را تقویت کند، در حالی که رویههای اخلاقی هوش مصنوعی حفظ میشوند. در همین حال، سازمان ملل به اثر بالقوهٔ هوش مصنوعی بر حقوق بشر پرداخته و از چارچوبهای حکمرانی دفاع کرده است که استفادهٔ اخلاقی و انسانمحور از فناوریهای هوش مصنوعی را در اولویت قرار میدهند.

با توجه به اینکه مناطق زیادی در حال معرفی یا بحث دربارهٔ مقررات هوش مصنوعی هستند، کسبوکارها باید نسبت به مسئولیتهای انطباق خود آگاه بمانند، بهخصوص وقتی در مناطق مختلف فعالیت میکنند. مشابه GDPR، ممکن است از شرکتها خواسته شود قوانینی را در کشورهایی که در آنها فعالیت دارند رعایت کنند، حتی اگر آن قوانین از کشور مبدا آنها نشأت نگرفته باشد.

چند کلمه دربارهٔ MLOps

MLOps روشی برای مدیریت چرخهٔ عمر end-to-end سامانههای یادگیری ماشین است و از اصول DevOps برای تضمین مقیاسپذیری، خودکارسازی و کارایی بهره میگیرد. این فرایند با جمعآوری و آمادهسازی داده آغاز میشود، جایی که تیمها منابع داده را شناسایی میکنند، ورود (ingestion) و ذخیرهسازی امن را تضمین میکنند، مجموعهدادهها را اعتبارسنجی و پاکسازی میکنند و با مسائلی مانند دادههای گمشده یا ناسازگار برخورد میکنند. مهندسان داده عمدتاً این مرحله را مدیریت میکنند و اطمینان میدهند داده استانداردسازی شده و آمادهٔ استفاده است.

پس از تکمیل آمادهسازی داده، مهندسان ML و دانشمندان داده ویژگیها (features) را طراحی میکنند، مدلها را انتخاب میکنند و آنها را آموزش (train)، اعتبارسنجی (validate) و ارزیابی (evaluate) میکنند. اهداف کسبوکار این گامها را هدایت میکنند و تضمین میکنند مدلها چالشهای مشخصی مثل پیشبینی ریزش مشتری (customer churn prediction) یا کشف ناهنجاری (anomaly detection) را هدف میگیرند. پس از آموزش، مدلها با استفاده از کانتینرسازی (containerization) و پایپلاینها برای استقرار مقیاسدهی میشوند و برای اپلیکیشنها قابل دسترسی میگردند.

برای رسیدن به هوش مصنوعی در سطح سازمانی (enterprise-level AI)، MLOps بهترین رویهها را از مهندسی نرمافزار وارد میکند، مانند خودکارسازی پایپلاین، اسکن امنیتی و CI/CD. این پایپلاینها فرایندها را استاندارد میکنند و کارایی را حفظ میکنند و به تیمها اجازه میدهند مدلها را بدون اصطکاک بهروزرسانی و بازآموزی کنند. MLOps بر همکاری میان نقشها (مهندسان داده، متخصصان ML و کاربران کسبوکار) تأکید دارد تا سامانههای ML robust و مقیاسپذیر تضمین شوند.

وقتی هوش مصنوعی خرابکاری میکند: سوگیری، توهم، و ریسکهای امنیتی

رویدادهای اخیر ریسکها و چالشهای مرتبط با سامانههای هوش مصنوعی را برجسته کردهاند، از جمله سوگیری، توهم و آسیبپذیریهای امنیتی. نمونهٔ قابلتوجهی با چتبات DPD رخ داد که بهطور غیرمنتظره به مشتریان توهین کرد و از شرکت خودش انتقاد کرد، رفتاری ناخواسته که نشان میدهد هوش مصنوعی چگونه میتواند “خودسر” شود. سوگیری یک نگرانی قدیمی است؛ مانند سامانهٔ تشخیص چهرهٔ ادارهٔ گذرنامهٔ بریتانیا که سوگیری نسبت به رنگ پوست نشان داد. چنین مسائلی اهمیت مجموعهدادههای آموزشی متنوع و فراگیر را برای جلوگیری از خروجیهای تبعیضآمیز برجسته میکنند.

توهمهای هوش مصنوعی به یک مشکل حیاتی تبدیل شدهاند، جایی که سامانهها اطلاعات قابلباور اما نادرست تولید میکنند؛ برای مثال، هوش مصنوعی وابستگیهای نرمافزاری را جعل کرد، مانند PyTorture، که میتواند به ریسکهای امنیتی منجر شود. مهاجمان میتوانند از این توهمها سوءاستفاده کنند و مؤلفههای مخرب را بهعنوان مؤلفههای واقعی جا بزنند. در موردی دیگر، یک هوش مصنوعی بهشکل افتراآمیز ادعای اختلاس را جعل کرد که به اقدام حقوقی انجامید و این نخستین بار بود که هوش مصنوعی به دلیل افترا مورد شکایت قرار گرفت.

امنیت همچنان یک نگرانی فوری است، بهویژه در پلاگینها و زنجیرههای تأمین نرمافزار. یک پلاگین ChatGPT زمانی به دلیل نقص در مکانیزم OAuth خود دادههای حساس را افشا کرد و رخدادهایی مثل انتشار آسیبپذیر PyTorch در حوالی کریسمس ریسکهای بهرهبرداری از سامانه را نشان میدهد. آسیبپذیریهای زنجیرهٔ تأمین همهٔ فناوریها را تحت تأثیر قرار میدهد، در حالی که تهدیدهای خاص هوش مصنوعی مانند prompt injection به مهاجمان اجازه میدهد خروجیها را دستکاری کنند یا به promptهای حساس دسترسی پیدا کنند، همانطور که در Google Gemini مشاهده شد. این رخدادها نیاز حیاتی به حکمرانی robust، شفافیت و اقدامات امنیتی در استقرار هوش مصنوعی را برجسته میکنند.

ساختن هوش مصنوعی مسئولانه

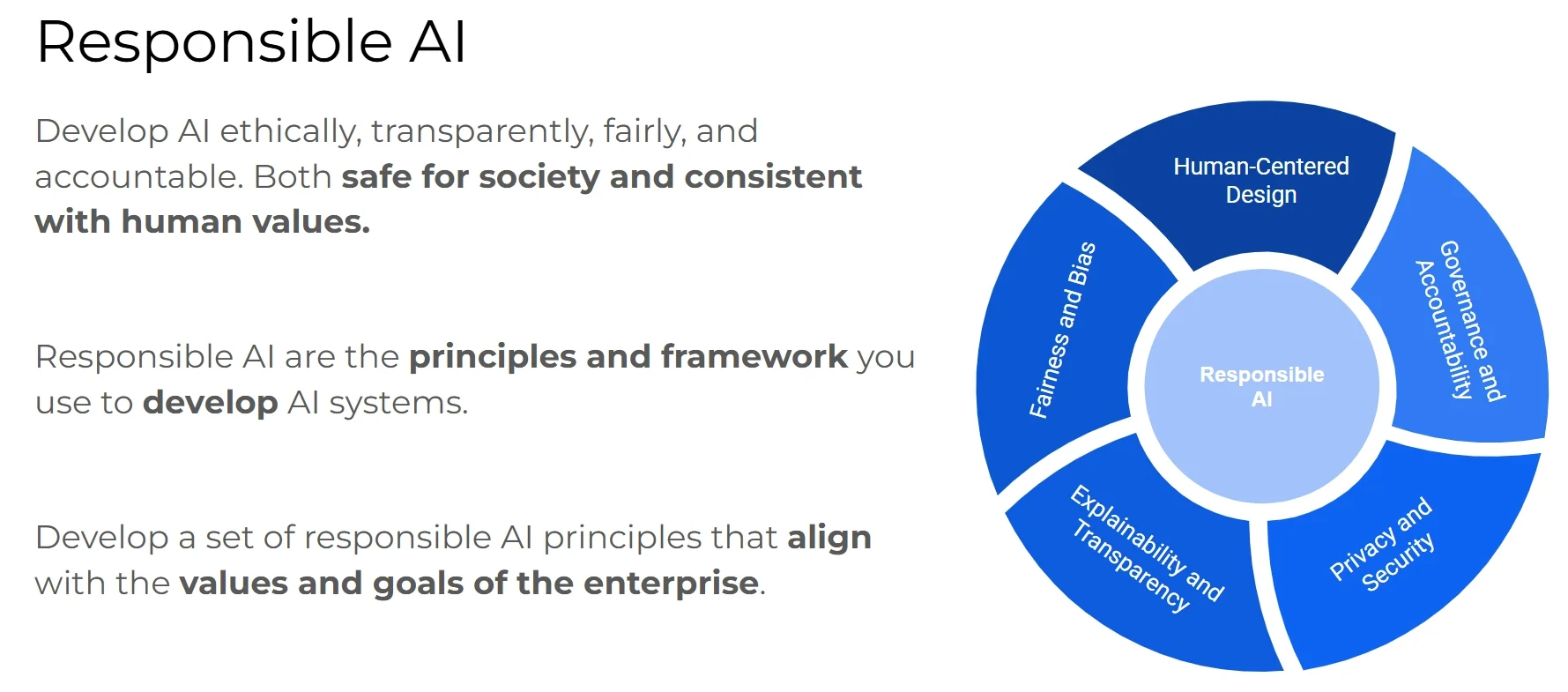

سازمانها باید توسعهٔ چارچوب هوش مصنوعی مسئولانه را برای جلوگیری از دامهای مدلهای یادگیری ماشین و هوش مصنوعی مولد در اولویت قرار دهند. این چارچوب باید بازتاب ارزشهای محوری شرکت باشد و اصول حیاتی مانند طراحی انسانمحور، انصاف و کاهش سوگیری، robustness، توضیحپذیری و شفافیت را پوشش دهد. شرکتهایی مانند Google و Accenture بر این عناصر تأکید میکنند تا اطمینان دهند سامانههای هوش مصنوعیشان با ارزشهای انسانی و استانداردهای اخلاقی همسو هستند و از پیامدهای مضر یا ناخواسته جلوگیری میکنند.

پیادهسازی هوش مصنوعی مسئولانه باید طراحی کاربرمحور را در اولویت قرار دهد. مدلها باید تجربهٔ کاربر را با جلوگیری از خروجیهای گیجکننده یا توهینآمیز بهبود دهند. آزمون مداوم زیرساخت و تعاملات سامانه برای قابلیت اتکا ضروری است. پذیرفتن محدودیتهای هوش مصنوعی که به معماری و دادهٔ آن وابسته است، حیاتی است. شناسایی و اعلام سوگیریها و محدودیتها به حفظ شفافیت و ساخت اعتماد با کاربران و ذینفعان کمک میکند.

در نهایت، بهکارگیری انواع معیارها برای سنجش عملکرد برای ارزیابی اثربخشی مدلها و مدیریت trade-offها حیاتی است. با اجرای این رویهها، سازمانها میتوانند هوش مصنوعی را بهصورت مسئولانه استفاده کنند و به نتایج قابلتوجه و اخلاقی برسند که با اهداف راهبردیشان همراستا است.

اصول هوش مصنوعی مسئولانه باید با ارزشهای سازمانی همسو باشد و همزمان پیامدهای اجتماعی را پوشش دهد. رویکرد طراحی انسانمحور باید در کنار تعامل با جامعهٔ گستردهتر هوش مصنوعی برای همکاری در اولویت قرار گیرد. آزمونگری و پایش حیاتیِ مؤلفههای سامانه، بهویژه در تعامل با کاربران، ضروری است. علاوه بر این، درک عمیق منابع داده و پایپلاینهای پردازش برای یکپارچهسازی مؤثر سامانه اهمیت دارد.

ایمنسازی سامانههای هوش مصنوعی: یک رویکرد جامع

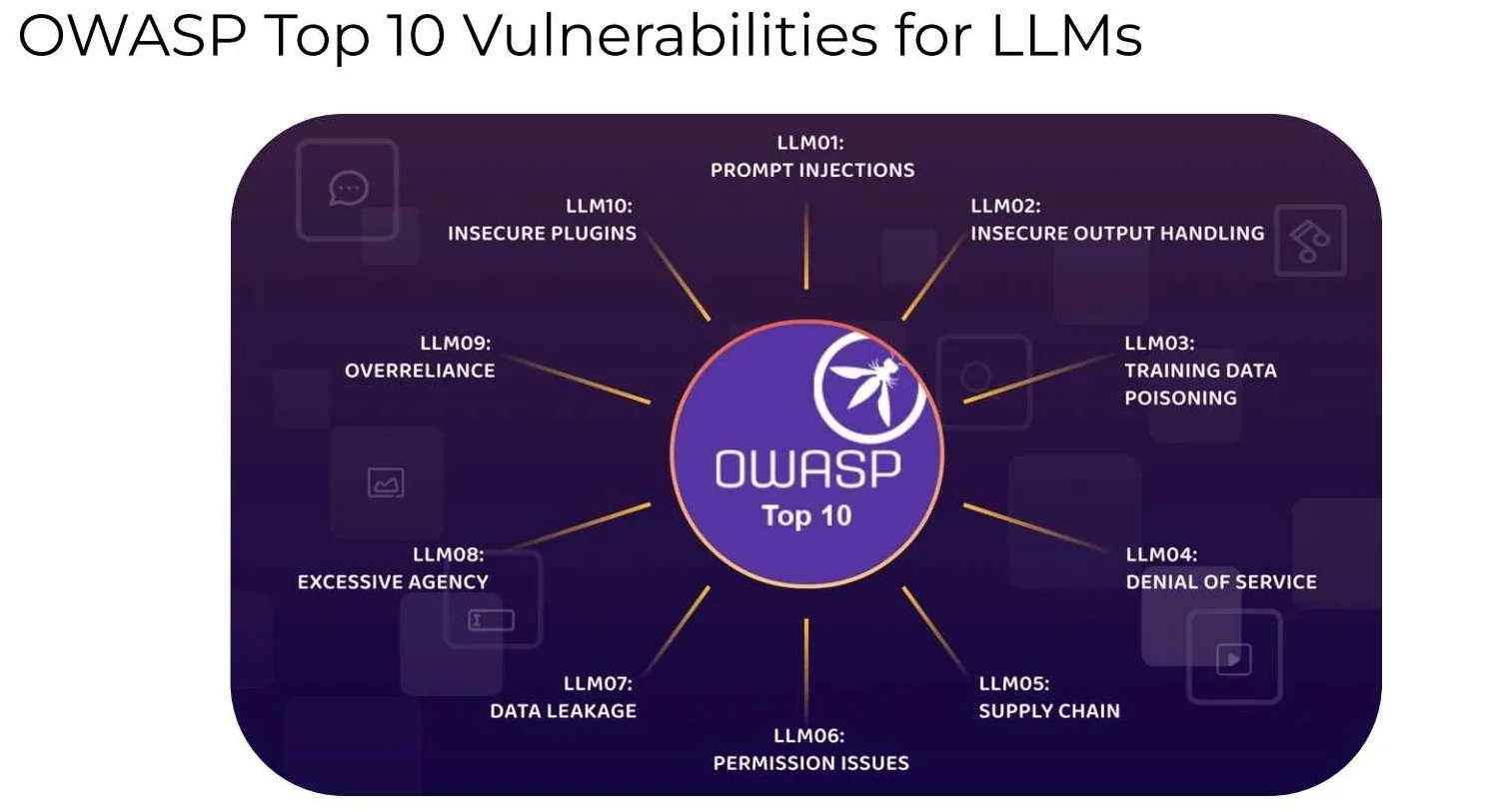

هوش مصنوعی به بخش مرکزی عملیات کسبوکار تبدیل شده است، بنابراین ایمنسازی این سامانهها برای حفاظت از دادههای حساس و حفظ اعتماد کلیدی است. سامانههای هوش مصنوعی، بهویژه مدلهای زبانی بزرگ، در برابر تهدیدهای متنوع آسیبپذیرند. از prompt injection و مسمومسازی دادهٔ آموزشی گرفته تا ریسکهای زنجیرهٔ تأمین مثل آسیبپذیری وابستگیها، سازمانها باید این ریسکها را بهصورت نظاممند پوشش دهند تا سامانههای امن و منطبق بسازند.

OWASP Top 10 برای مدلهای زبانی بزرگ (LLMs) یک منبع بهطور گسترده پذیرفتهشده برای شناسایی آسیبپذیریها است. این چارچوب تهدیدهای خاص هوش مصنوعی، از جمله prompt injection، ریسکهای امنیتی عمومی مانند حملات denial-of-service (DoS)، و امکان افشای اطلاعات حساس را مشخص میکند. این آسیبپذیریها میتوانند در نقاط مختلف یک سامانهٔ هوش مصنوعی مورد سوءاستفاده قرار گیرند، از جمله پایپلاینهای داده، پلاگینهای مدل و سرویسهای خارجی. متخصصان امنیت پیوسته تأکید میکنند که یک سازمان فقط به اندازهٔ ضعیفترین حلقهاش robust است. بنابراین، هر اتصال میان سرویسها، کاربران و داده باید تقویت شود.

برای جلوگیری از حملات، سازمانها باید مجموعهای robust از رویههای امنیتی را اتخاذ کنند:

- Access Control: قوانین روشن تعریف کنید برای اینکه چه کسی میتواند به داده، مدلها و مؤلفههای سامانه دسترسی داشته باشد و آنها را تغییر دهد. مدیریت صحیح سطح دسترسی (privilege) فرصت اقدامهای غیرمجاز را کاهش میدهد.

- Monitoring and Logging: فعالیتهای سامانه را بهصورت مداوم پایش کنید تا رفتار غیرعادی شناسایی و به آن پاسخ داده شود. ثبت رویدادها (logging) در سراسر سرویسها تضمین میکند رخدادها بتوانند بررسی و بهطور مؤثر رسیدگی شوند.

علاوه بر این اقدامات، اعتبارسنجی و پاکسازی داده (data validation and sanitization) برای تضمین یکپارچگی دادههای آموزشی و عملیاتی حیاتی است. این شامل راستیآزمایی ورودیها، تأیید منابع داده و جلوگیری از ورود دادهٔ مخرب یا خراب است. سازمانها همچنین باید بهروزرسانی و patching منظم را در اولویت قرار دهند تا همهٔ مؤلفهها در برابر آسیبپذیریهای تازه کشفشده ایمن بمانند، مانند مواردی که در رخدادهای گذشته مثل حملهٔ زنجیرهٔ تأمین PyTorch برجسته شدهاند.

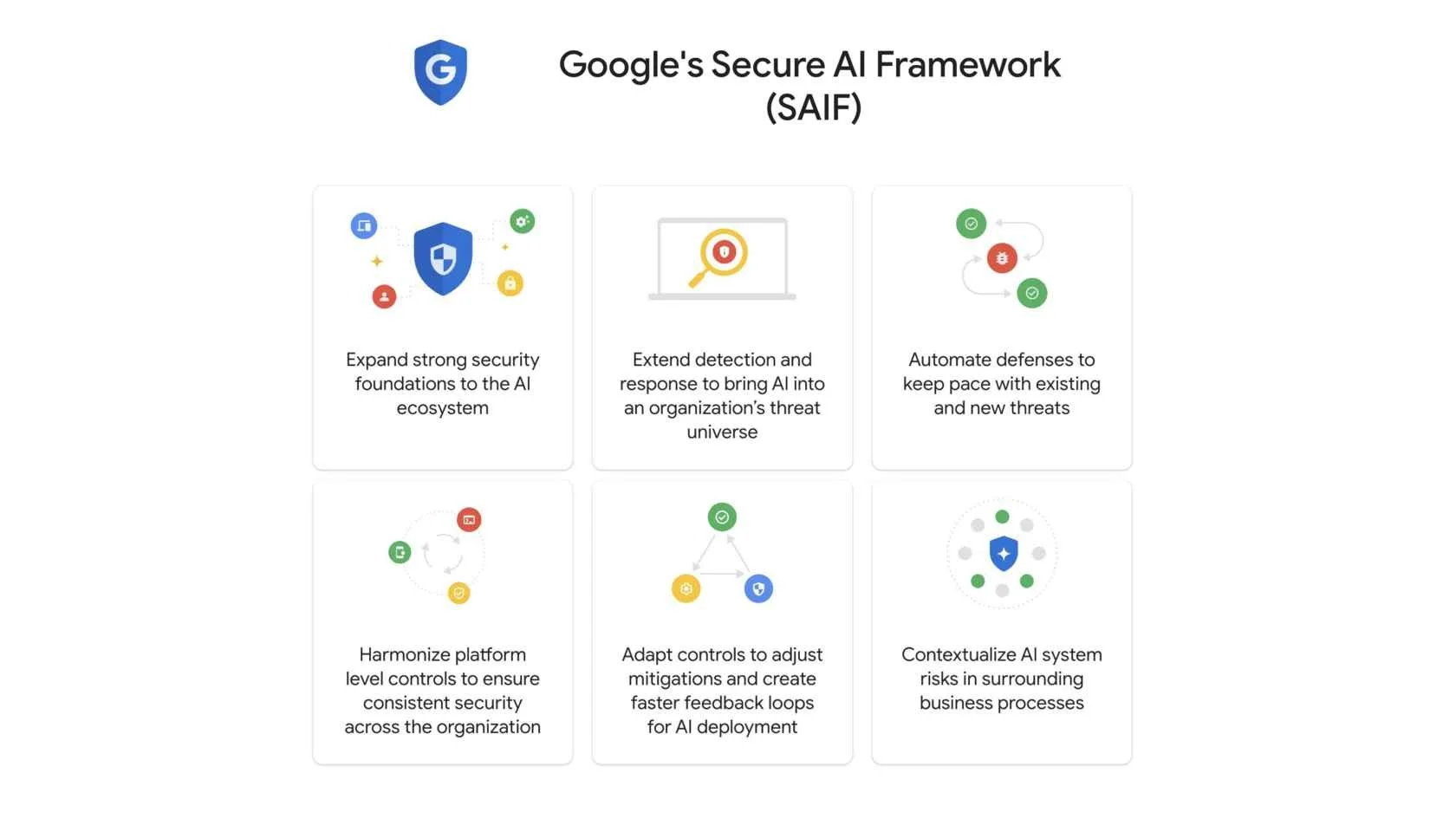

سازمانها میتوانند راهبردهای امنیتی خود را با استفاده از چارچوبهایی مانند Secure AI Framework (SAIF) گوگل تقویت کنند. این چارچوبها اصول امنیتی را برجسته میکنند، از جمله کنترل دسترسی، سامانههای کشف و پاسخ، مکانیزمهای دفاعی و فرایندهای risk-aware که برای نیازهای مشخص کسبوکار تنظیم شدهاند. SAIF و راهنماهای مشابه بینشهای عملی ارائه میدهند که امنیت هوش مصنوعی را با رویههای گستردهتر IT، مانند DevSecOps، همراستا میکنند. پیادهسازی بهترین رویههای امنیتی برای فرایندهای هوش مصنوعی و MLOps سازمان برای حفاظت از دادههای حساس و تضمین یکپارچگی عملیاتی حیاتی است.

درک هوش مصنوعی توضیحپذیر

هوش مصنوعی توضیحپذیر (Explainable AI یا XAI) شفافیت، تفسیرپذیری (interpretability) و پاسخگویی مدلهای یادگیری ماشین را افزایش میدهد. با ارائهٔ بینش دربارهٔ فرایندهای تصمیمگیری هوش مصنوعی، XAI اعتماد میسازد، عملکرد را تقویت میکند و به سازمانها در رعایت استانداردهای مقرراتی کمک میکند.

رویکردهای XAI را میتوان به دو نوع تقسیم کرد:

- Local Explanations بر پیشبینیهای منفرد تمرکز میکنند و به پرسش «چرا مدل برای این ورودی چنین تصمیمی گرفت؟» پاسخ میدهند. این روشها مشخص میکنند کدام ویژگیها روی پیشبینیهای مشخص اثر گذاشتهاند و برای دیباگ، شناسایی سوگیریها یا توضیح خروجیهای فردی مفیدند. اما بینشی دربارهٔ رفتار کلی مدل ارائه نمیدهند.

- Global Explanations تلاش میکنند رفتار مدل را در کل مجموعهداده درک کنند و روابط میان ویژگیهای ورودی و پیشبینیها را آشکار کنند. این توضیحها بینشهایی دربارهٔ انصاف مدل و منطق کلی آن ارائه میدهند، اما جزئیات پیشبینیهای خاص را ندارند.

هنگام بحث دربارهٔ XAI، همچنین مهم است بین رویکردهای model-agnostic و model-specific تمایز قائل شویم:

تکنیکهای model-agnostic مانند LIME مدلهای جانشین سادهای پیرامون ورودیهای مشخص ایجاد میکنند تا پیشبینیها را توضیح دهند. آنها انعطافپذیر هستند و روی هر مدلی قابل اعمالاند، اما بر توضیحهای محلی تمرکز دارند.

ابزارهای model-specific مانند BertViz و HELM برای معماریهای مشخص طراحی شدهاند. BertViz به تفسیر مدلهای transformer مانند BERT کمک میکند، در حالی که HELM مدلهای زبانی بزرگ را بهصورت holistic ارزیابی میکند.

XAI فقط دربارهٔ ابزارها نیست، بلکه دربارهٔ تقویت شفافیت و اعتماد است. سازمانها میتوانند از توضیحهای محلی و جهانی استفاده کنند تا اطمینان دهند مدلها تفسیرپذیر، منصفانه و پاسخگو هستند. ترکیب تکنیکهای model-agnostic و model-specific به تعمیق درک و بهینهسازی عملکرد هوش مصنوعی کمک میکند.

آیندهٔ هوش مصنوعی: دگرگونسازی صنایع و تقویت امنیت

با ادامهٔ تکامل هوش مصنوعی، اثر آن بر صنایعی مانند امنیت سایبری، سلامت، مالی و بیشتر، حتی عمیقتر خواهد شد. آیندهٔ هوش مصنوعی وعده میدهد امنیت را بهبود دهد، کارایی عملیاتی را افزایش دهد و بهطور عمیق در بخشهای حیاتی ادغام شود.

سهم هوش مصنوعی در امنیت سایبری آماده است تا نحوهٔ دفاع در برابر تهدیدها را متحول کند. یکی از حوزههای کلیدی که انتظار میرود هوش مصنوعی اثر قابلتوجهی بگذارد، حل خودکار آسیبپذیریها (automated vulnerability resolution) است. هوش مصنوعی میتواند بهسرعت آسیبپذیریها را در کد شناسایی کند، مانند مشکلات cross-site scripting، و ماهیت آنها را توضیح دهد. حتی چشمگیرتر اینکه، هوش مصنوعی میتواند بهطور خودکار اصلاحها را تولید کند و آنها را در گردشکارهای توسعه ادغام کند.

برای نمونه، با استفاده از ابزارهایی مانند GitLab، هوش مصنوعی میتواند merge requestهایی با تغییرات لازم در کد ایجاد کند و توسعهدهنده فقط راهحل را بازبینی و تأیید کند. این خودکارسازی فرایند را روانتر میکند و اجازه میدهد آسیبپذیریها سریعتر برطرف شوند، بدون آنکه امنیت قربانی شود.

علاوه بر این، هوش مصنوعی پاسخ به رخداد (incident response) و بازیابی را بهبود میدهد. سامانههایی مانند PagerDuty از هوش مصنوعی برای شناسایی ناهنجاریهای بلادرنگ استفاده میکنند و به سازمانها اجازه میدهند به رخدادهای امنیتی سریعتر و مؤثرتر پاسخ دهند. هرچه پاسخ سریعتر باشد، زمان کمتری برای مهاجمان باقی میماند تا از آسیبپذیریها سوءاستفاده کنند.

همچنین، GenAI در شبیهسازیهای فیشینگ استفاده میشود، که برای آموزش کارکنان در تشخیص حملات مهندسی اجتماعی کلیدی است. با سناریوهای تولیدشده توسط هوش مصنوعی، سازمانها میتوانند نیروی کار خود را بهتر آماده کنند تا با تلاشهای فیشینگ و سایر ریسکهای امنیت سایبری مقابله کند و کاربران بهخوبی مجهز باشند تا استانداردهای امنیتی را حفظ کنند.

فراتر از امنیت سایبری، آیندهٔ هوش مصنوعی شامل استفادهٔ فزاینده از مدلهای بنیادین بزرگ (large foundation models) است. این مدلها که روی مجموعهدادههای عظیم آموزش میبینند، در بسیاری از بخشها فراگیر خواهند شد و پیشرفتهایی در توسعهٔ دارو، طراحی صنعتی و کاربردهای روزمره ایجاد خواهند کرد. این مدلها ممکن است چندوجهی (multimodal) باشند و بتوانند انواع مختلف داده (متن، تصویر، صدا) را همزمان پردازش کنند، که آنها را به ابزارهایی منعطف در صنایع گوناگون تبدیل میکند.

نتیجهگیری

فناوریهای هوش مصنوعی همچنان صنایع را دگرگون میکنند، و تأکید بر مسئولیتپذیری، امنیت و توضیحپذیری در طراحی و پیادهسازی آنها ضروری است. ایجاد چارچوبی که استانداردهای اخلاقی، انطباق مقرراتی و اثر اجتماعی را در اولویت قرار دهد تضمین میکند سامانههای هوش مصنوعی بهطور مؤثر در خدمت کسبوکارها و عموم قرار گیرند. هوش مصنوعی صرفاً یک ابزار فنی نیست؛ بلکه عمیقاً در تعاملات انسانی ادغام شده است.

بنابراین، سازمانها باید رویکردی جامع اتخاذ کنند که هم پیشرفتهای فناورانه و هم پیامدهای اجتماعی، فرهنگی و اخلاقی آنها را در نظر بگیرد. با آگاهماندن، ترویج شفافیت و تقویت همکاری، ذینفعان میتوانند آیندهای بسازند که در آن هوش مصنوعی اثر مثبتی بر جامعه بگذارد، در حالی که ریسکها کاهش یافته و ارزش بلندمدت تضمین شود.